- Startseite

- AI APIs

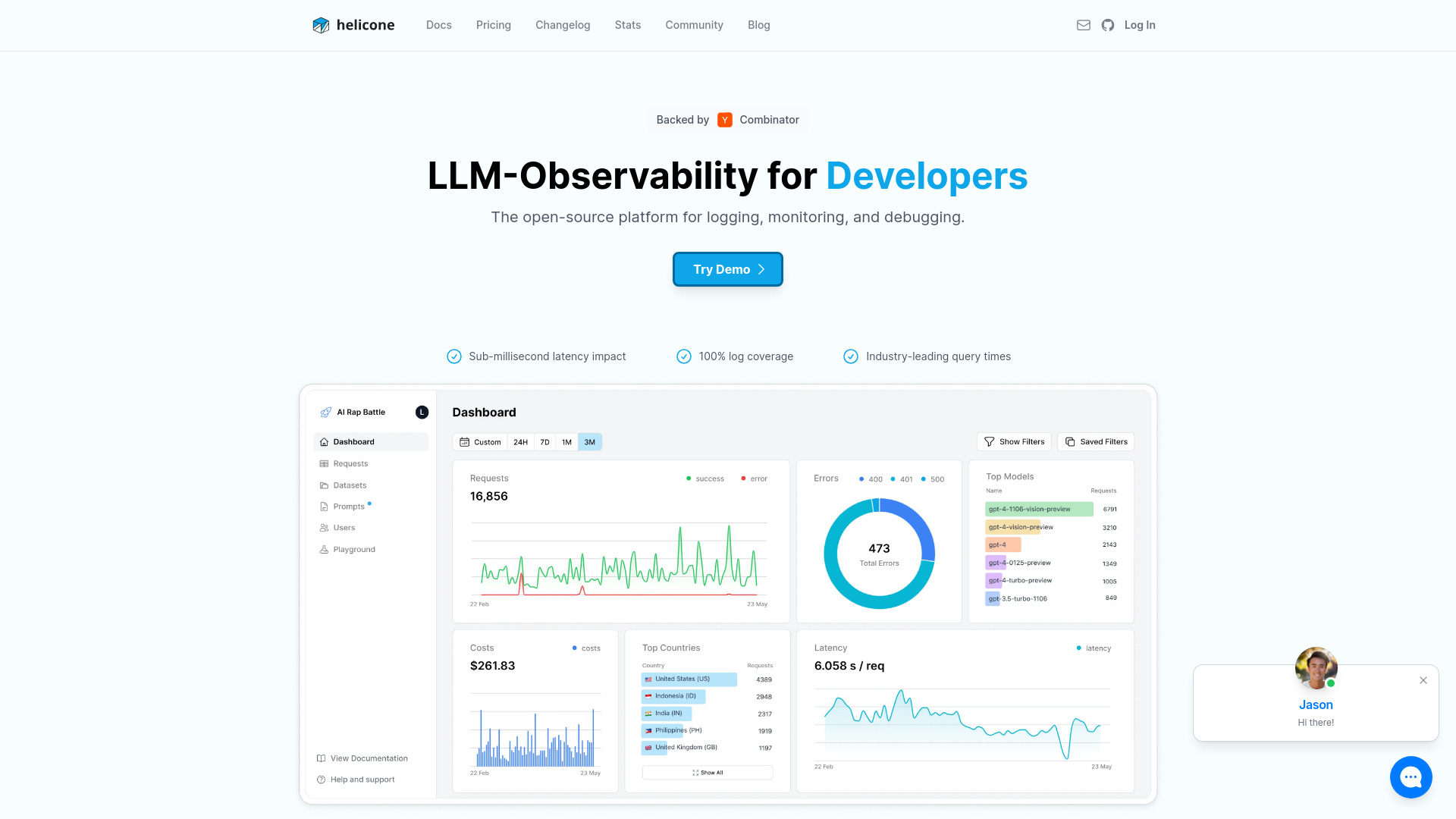

- Helicone

Helicone

Website öffnen-

Tool-Einführung:Open-Source LLM-Observability: Monitoring, Debugging, Tracing; 1‑Zeilen‑Setup.

-

Aufnahmedatum:2025-10-31

-

Soziale Medien & E-Mail:

Tool-Informationen

Was ist Helicone AI

Helicone AI ist eine Open-Source Plattform für LLM‑Observability, die das Monitoring, Debugging und Optimieren produktiver KI‑Anwendungen vereint. Über eine 1‑Zeilen‑Integration werden Aufrufe an Sprachmodelle transparent erfasst, sodass Teams Kosten nachverfolgen, Agent Tracing durchführen und Prompts verwalten können. Intuitive Dashboards, strukturierte Logs und Metriken machen Performance, Latenz und Fehlerraten sichtbar – für mehr Zuverlässigkeit und schnellere Iteration von LLM‑Features in der Produktion.

Hauptfunktionen von Helicone AI

- LLM‑Observability: Zentrale Logs, Metriken und Dashboards für alle Modellaufrufe – von der Anfrage bis zur Antwort.

- Kosten‑Tracking: Transparente Auswertung von Token‑ und Anfragekosten nach Modell, Feature oder Nutzer.

- Agent Tracing: Nachvollziehbare Traces für Ketten, Schritte und Agenten, um Engpässe und Fehlerquellen zu finden.

- Prompt‑Management: Strukturierte Organisation und Vergleich von Prompts inklusive Kontext und Parametern.

- Fehler- und Qualitätsmonitoring: Überblick über Fehlerraten, Ausreißer, Retries und Antwortqualität.

- Leistungsanalyse: Kennzahlen zu Latenz, Durchsatz, Nutzungstrends und Stabilität in der Produktion.

- Einfache Integration: 1‑Zeilen‑Integration mit minimalen Codeänderungen für schnellen Start.

- Flexible Nutzung: Open‑Source‑Ansatz für Self‑Hosting oder Einsatz in verwalteten Umgebungen.

Für wen ist Helicone AI geeignet

Helicone AI richtet sich an Software‑Entwickler, ML‑/AI‑Ingenieure, Produkt‑ und Data‑Teams, die LLM‑Features in Anwendungen betreiben. Ideal für Startups und Unternehmen, die Produktions‑Monitoring, Kostenkontrolle und Fehleranalyse benötigen – etwa bei Chatbots, Assistenzsystemen, Content‑Tools oder Retrieval‑Anwendungen.

Wie man Helicone AI verwendet

- Umgebung einrichten: Helicone AI bereitstellen (Self‑Hosting) oder einen verwalteten Zugang nutzen.

- 1‑Zeilen‑Integration: Den Proxy/Client in den LLM‑API‑Aufrufen konfigurieren, um Requests zu erfassen.

- Metadaten setzen: Relevante Tags wie Nutzer, Feature, Umgebung und Version mitschicken.

- Prompts organisieren: Prompts strukturieren und Parameter konsistent verwalten.

- Daten beobachten: Logs, Traces und Metriken in Dashboards analysieren.

- Optimieren: Engpässe beheben, Kosten senken, Prompts anpassen und Qualität iterativ verbessern.

Branchenspezifische Anwendungsfälle von Helicone AI

In E‑Commerce hilft Helicone AI, Chat‑Assistenten zu überwachen, Antwortzeiten zu reduzieren und Kosten pro Anfrage zu steuern. SaaS‑Anbieter analysieren Nutzungs‑Spitzen, Fehlerraten und Prompt‑Varianten, um Features stabil auszurollen. Im Kundensupport macht Agent Tracing komplexe Ketten nachvollziehbar. In Bildung und internen Wissens‑Assistenten sorgt LLM‑Observability für verlässliche Performance und bessere Governance.

Preismodell von Helicone AI

Open‑Source: Der Code ist offen zugänglich und ermöglicht Self‑Hosting. Für eventuelle Cloud‑/Managed‑Angebote und deren Preise sollten die offiziellen Informationen des Anbieters herangezogen werden.

Vorteile und Nachteile von Helicone AI

Vorteile:

- Open‑Source: Transparenz, Erweiterbarkeit und optionale Selbst‑Bereitstellung.

- Schnelle Integration: 1‑Zeilen‑Integration reduziert Implementierungsaufwand.

- Umfassende Sichtbarkeit: Zentralisiertes Monitoring von Kosten, Latenz, Fehlern und Nutzung.

- Bessere Fehlersuche: Agent Tracing macht komplexe LLM‑Ketten nachvollziehbar.

- Strukturiertes Prompt‑Management: Konsistente Verwaltung und Analyse von Prompts.

Nachteile:

- Instrumentierungsaufwand: Für aussagekräftige Metriken müssen Requests konsistent annotiert werden.

- Zusätzliche Komplexität: Ein Proxy‑Layer kann Betriebs‑ und Wartungsaufwände erhöhen.

- Datenhandhabung: Anforderungen an Datenschutz und Governance müssen je nach Einsatz geklärt werden.

Häufige Fragen zu Helicone AI

-

Ist Helicone AI Open Source?

Ja. Helicone AI ist als Open‑Source Projekt verfügbar und kann selbst gehostet werden.

-

Wie funktioniert die 1‑Zeilen‑Integration?

Die LLM‑Aufrufe werden über einen konfigurierten Proxy/Client geleitet. Eine kleine Änderung in der API‑Konfiguration reicht, um Logs, Traces und Metriken zu erfassen.

-

Unterstützt Helicone AI mehrere LLM‑Anbieter?

Helicone AI ist für gängige LLM‑APIs konzipiert. Details zur Anbindung einzelner Anbieter sollten in der jeweiligen Dokumentation geprüft werden.

-

Welche Daten werden erfasst?

Erfasst werden typischerweise Metriken, Logs und Traces der LLM‑Aufrufe. Umfang und Aufbewahrung lassen sich je nach Konfiguration und Hosting‑Modell steuern.

-

Worin unterscheidet sich Helicone AI von klassischem APM?

Im Fokus stehen LLM‑spezifische Signale wie Kosten, Token‑Nutzung, Prompt‑Kontext und Agent Tracing – also Observability für KI‑Workloads statt generischer App‑Metriken.