Helicone

Abrir Site-

Ferramenta Introdução:Observabilidade LLM de código aberto: monitore, depure e rastreie com 1 linha

-

Data de Inclusão:2025-10-31

-

Social Media e E-mail:

Informações da ferramenta

O que é Helicone AI

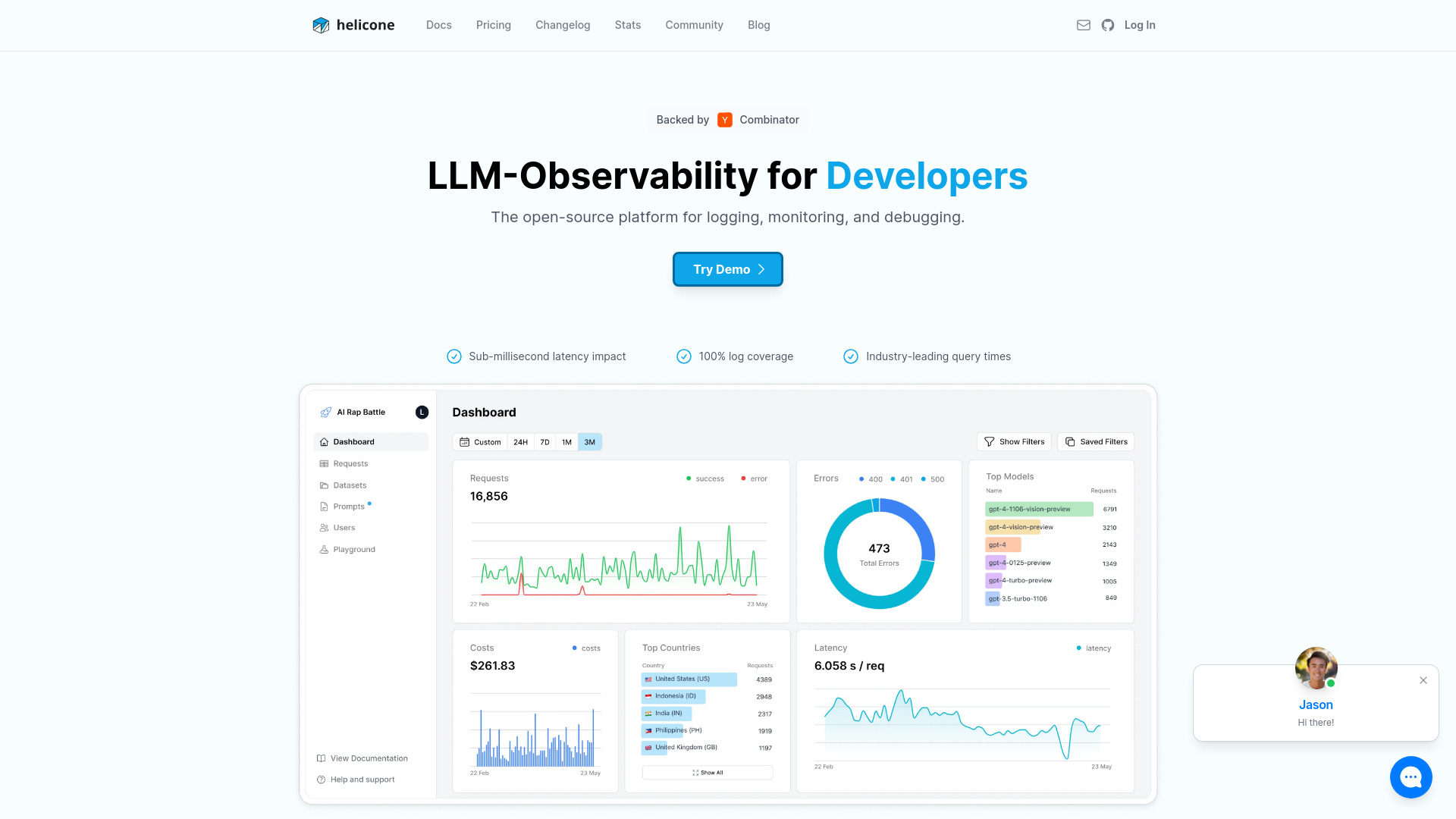

Helicone AI é uma plataforma open-source de observabilidade para LLMs criada para monitorar, depurar e aprimorar aplicações de IA em produção. Com integração de “uma linha”, reúne em um só lugar rastreamento de agentes, gestão de prompts e acompanhamento de custos por chamada e por usuário. Ao centralizar logs, métricas e o contexto de cada requisição, o Helicone ajuda equipes a entender o comportamento dos modelos, detectar falhas com rapidez e otimizar qualidade, latência e gasto, acelerando o ciclo de iteração de produtos com LLM.

Principais funcionalidades de Helicone AI

- Observabilidade unificada de LLM: consolida logs, métricas e contexto para cada requisição em um painel único.

- Rastreamento de agentes: visualiza a cadeia de chamadas e passos de agentes, facilitando o diagnóstico ponta a ponta.

- Gestão de prompts: organiza e compara variações de prompts, com histórico e contexto para melhoria contínua.

- Acompanhamento de custos: monitora gasto por token, por usuário e por feature, apoiando otimização de orçamento.

- Integração de 1 linha: adiciona observabilidade redirecionando chamadas para um proxy compatível com provedores de LLM.

- Depuração eficiente: filtros e busca por erros, outliers de latência e respostas problemáticas.

- Dashboards operacionais: visão de uso, desempenho e falhas para tomada de decisão rápida.

- Open-source: transparência e flexibilidade para adaptar o stack de observabilidade às necessidades do time.

Para quem é Helicone AI

Ideal para desenvolvedores, engenheiros de machine learning, equipes de produto e SRE que operam aplicações com LLMs em produção. Atende startups e empresas que precisam monitorar custo, latência e qualidade de respostas em chatbots, agentes autônomos, soluções de RAG, assistentes de suporte e outras experiências baseadas em modelos de linguagem.

Como usar Helicone AI

- Crie uma conta ou configure a versão open-source conforme a sua infraestrutura.

- Implemente a integração de “uma linha”, redirecionando as chamadas ao LLM através do proxy do Helicone.

- Defina as credenciais e variáveis necessárias no ambiente de execução do seu app.

- Envie a primeira requisição e verifique logs, métricas e contexto no dashboard.

- Habilite o rastreamento de agentes (quando aplicável) para acompanhar cada etapa do fluxo.

- Organize seus prompts, registre alterações e observe impacto em desempenho e custo.

- Monitore custos, latência e erros; ajuste prompts e parâmetros do modelo conforme os insights.

Casos de uso de Helicone AI no setor

Em suporte ao cliente, equipes acompanham bots conversacionais para reduzir falhas e quedas de qualidade. No e-commerce, times monitoram o desempenho de recomendações e assistentes de compra, equilibrando custo e tempo de resposta. Em fintechs, o rastreamento de agentes ajuda a auditar cadeias de decisão com transparência. Em edtechs, a gestão de prompts melhora tutores de estudo. Em produtos SaaS, o Helicone sustenta a observabilidade de experiências de busca e geração de conteúdo baseadas em LLM.

Vantagens e desvantagens de Helicone AI

Vantagens:

- Observabilidade completa de LLMs em um só lugar.

- Integração rápida com mínima alteração no código.

- Rastreamento de agentes e gestão de prompts integrados ao fluxo.

- Acompanhamento granular de custos para otimização contínua.

- Projeto open-source, com transparência e possibilidade de adaptação.

Desvantagens:

- Pode exigir instrumentação adicional para cenários complexos.

- Uso de proxy pode adicionar pequena sobrecarga ao tráfego.

- Curva de aprendizado inicial para equipes sem práticas de observabilidade.

Perguntas frequentes sobre Helicone AI

-

O que o Helicone AI monitora exatamente?

Ele centraliza logs, métricas, contexto de requisições e dados de custos, além de permitir rastrear cadeias de agentes e organizar prompts.

-

Como funciona a integração de “uma linha”?

As chamadas ao seu provedor de LLM são direcionadas por um proxy do Helicone, adicionando observabilidade sem reescrever sua aplicação.

-

O Helicone AI é open-source?

Sim. Por ser open-source, pode ser avaliado e adaptado conforme as necessidades do seu time ou ambiente.

-

Ele ajuda a reduzir custos com LLM?

Sim. O acompanhamento de custos por chamada, usuário e recurso permite identificar desperdícios e otimizar prompts e parâmetros.

-

Serve para agentes e pipelines complexos?

Sim. O rastreamento de agentes facilita visualizar etapas, dependências e o contexto de cada passo do fluxo.