- Startseite

- Prompt Engineering

- Portkey

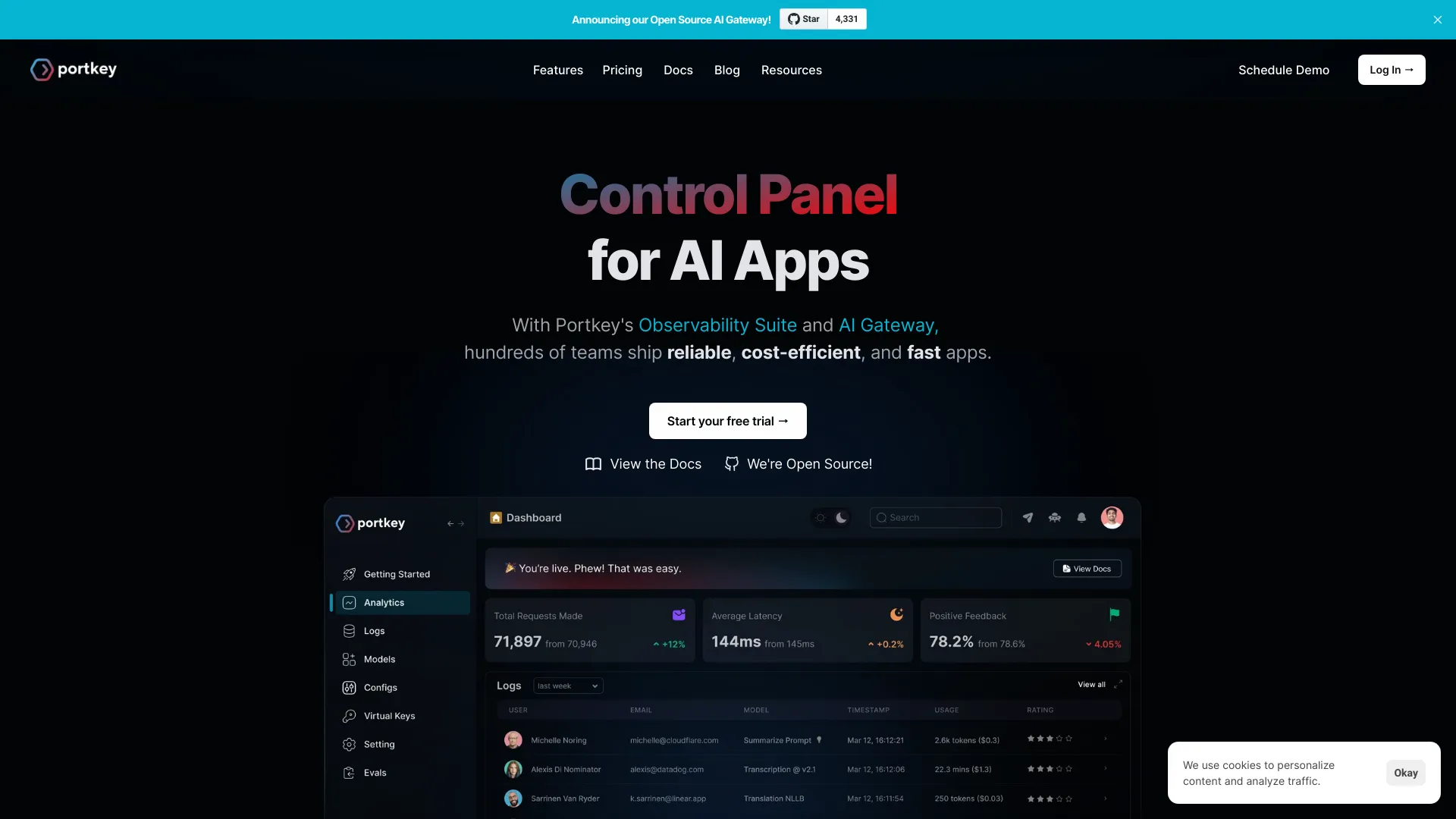

Portkey

Website öffnen-

Tool-Einführung:AI-Gateway in 3 Zeilen: Guardrails, Observability, produktionsreife Agenten.

-

Aufnahmedatum:2025-11-01

-

Soziale Medien & E-Mail:

Tool-Informationen

Was ist Portkey AI

Portkey AI ist eine Plattform, mit der KI‑Teams ihre Anwendungen unternehmensweit beobachten, steuern und optimieren. Mit nur drei Zeilen Code bindet man ein zentrales AI‑Gateway ein, das Prompts, Guardrails und eine umfassende Observability‑Suite vereint. So lassen sich verlässliche, kosteneffiziente und schnelle KI‑Apps bereitstellen. Portkey integriert sich in LangChain, CrewAI, AutoGen und weitere Agent‑Frameworks und macht Agent‑Workflows produktionsreif. Ein MCP‑Client verschafft Agenten Zugriff auf reale Tools und Datenquellen.

Hauptfunktionen von Portkey AI

- AI‑Gateway: Anbieterunabhängiges Routing zwischen Modellen, Schlüsselverwaltung, Rate Limiting, Caching sowie automatische Retries und Fallbacks zur Stabilisierung von LLM‑Anwendungen.

- Prompt‑Management: Versionierung, Vorlagen mit Variablen, Vergleichstests (A/B) und strukturierte Ausgaben zur konsistenten Prompt‑Optimierung.

- Guardrails: Richtlinien, Inhaltsfilter und PII‑Redaktion; Validierung von Antworten (z. B. JSON‑Schema) für sichere, regelkonforme Ergebnisse.

- Observability‑Suite: Tracing, Logs und Metriken für Token, Kosten und Latenz; Dashboards und Alerts zur laufenden Qualitätssicherung.

- Governance: Richtliniensteuerung und nachvollziehbare Auditability, um Zugriffe und Änderungen transparent zu halten.

- Integrationen: Nahtlose Anbindung an LangChain, CrewAI, Autogen und weitere Agent‑Frameworks für produktionsreife Workflows.

- MCP‑Client: Zugriff auf reale Tools und Daten über das Model Context Protocol, damit Agenten Aktionen in der Außenwelt ausführen können.

- Optimierung: Kosten‑/Latenz‑Optimierung durch Caching, intelligentes Routing und kontinuierliche Auswertung von Prompt‑Varianten.

Für wen ist Portkey AI geeignet

Portkey AI eignet sich für AI/ML‑Teams, Plattform‑ und Produkt‑Engineering sowie Data‑Science‑Abteilungen, die LLM‑Apps oder Agenten zuverlässig in Produktion betreiben möchten. Besonders wertvoll ist es für Unternehmen mit mehreren Modellen/Anbietern, anspruchsvollen Compliance‑Vorgaben oder klaren Kosten‑ und Performance‑Zielen. Auch Start‑ups profitieren, um schneller von Prototypen zu stabilen, skalierbaren Anwendungen zu gelangen.

Wie man Portkey AI verwendet

- SDK installieren oder das AI‑Gateway als Proxy in die bestehende Architektur einbinden.

- Modelle und Anbieter verbinden, API‑Schlüssel sicher hinterlegen und Routing/Fallbacks konfigurieren.

- Prompts definieren und versionieren; strukturierte Ausgaben und Variablen festlegen.

- Guardrails aktivieren: Moderation, PII‑Redaktion und Validierung nach Bedarf einstellen.

- Observability einschalten: Tracing, Kosten‑/Token‑Metriken und Alerts für Monitoring aktivieren.

- Agent‑Frameworks wie LangChain, CrewAI oder Autogen anbinden und Workflows orchestrieren.

- Tests und A/B‑Experimente durchführen, Ergebnisse auswerten und Prompts/Policies iterativ verbessern.

- In Produktion ausrollen, Dashboards überwachen und Optimierungen kontinuierlich fortsetzen.

Branchenspezifische Anwendungsfälle von Portkey AI

Im Kundenservice ermöglichen Guardrails sichere Antworten und das Gateway reduziert Kosten durch Caching. In der Finanzbranche hilft PII‑Redaktion bei KYC‑Assistenz und regelkonformer Dokumentenverarbeitung. E‑Commerce nutzt Agenten für Produktsuche und Beratung mit geringer Latenz. Im Gesundheitswesen unterstützen Observability und Audit‑Trails die Nachvollziehbarkeit. SaaS‑Produkte integrieren In‑App‑Copilots, während DevOps‑Teams über den MCP‑Client Automationen und Runbooks ansteuern.

Vorteile und Nachteile von Portkey AI

Vorteile:

- Einheitliches AI‑Gateway für Routing, Fallbacks und Schlüsselverwaltung.

- Umfassende Observability mit Kosten‑, Token‑ und Latenzmetriken.

- Guardrails für Sicherheit, Qualität und Compliance.

- Schnelle Integration mit wenigen Zeilen Code und klarer Migrationspfad in Produktion.

- Breite Unterstützung gängiger Agent‑Frameworks und produktionsreifer Workflows.

- MCP‑Client für den Zugriff auf reale Tools und Systeme.

Nachteile:

- Zusätzliche Abhängigkeit von einer externen Plattform (möglicher Vendor‑Lock‑in).

- Einarbeitung und Instrumentierung erforderlich, insbesondere bei bestehenden Systemen.

- Leichte Zusatzlatenz durch den Gateway‑Layer.

- Für sehr kleine Projekte unter Umständen überdimensioniert.

- Potenzielle Mehrkosten bei hohem Durchsatz trotz Optimierungen.

Häufige Fragen zu Portkey AI

-

Was ist ein AI‑Gateway und wofür brauche ich es?

Ein AI‑Gateway bündelt Zugriffe auf verschiedene Modelle/Anbieter, übernimmt Routing, Caching, Rate Limiting und Fallbacks und bietet zentrale Observability. So werden KI‑Apps stabiler, schneller und besser kontrollierbar.

-

Unterstützt Portkey LangChain, CrewAI und Autogen?

Ja. Portkey integriert sich in LangChain, CrewAI, Autogen und weitere Agent‑Frameworks, um Workflows schneller produktionsreif zu machen.

-

Wie hilft Portkey beim Kostenmanagement?

Durch Caching, intelligentes Routing, Transparenz über Token/Kosten sowie A/B‑Tests zur Ermittlung effizienter Prompts und Modelle.

-

Ist Portkey für regulierte Umgebungen geeignet?

Guardrails, Richtlinien und Auditing unterstützen Compliance‑Vorgaben. Die Verantwortung für Datenhaltung und regulatorische Anforderungen bleibt beim Betreiber.

-

Was ist der MCP‑Client in Portkey?

Der MCP‑Client (Model Context Protocol) verbindet Agenten mit realen Tools und Datenquellen, damit diese Aktionen außerhalb des Modells ausführen können.

-

Muss ich meinen Code stark umbauen?

In der Regel nicht: Die Einbindung erfolgt mit wenigen Zeilen Code, da das Gateway als zentraler Layer fungiert und bestehende Aufrufe kapselt.