Helicone

Site web ouvert-

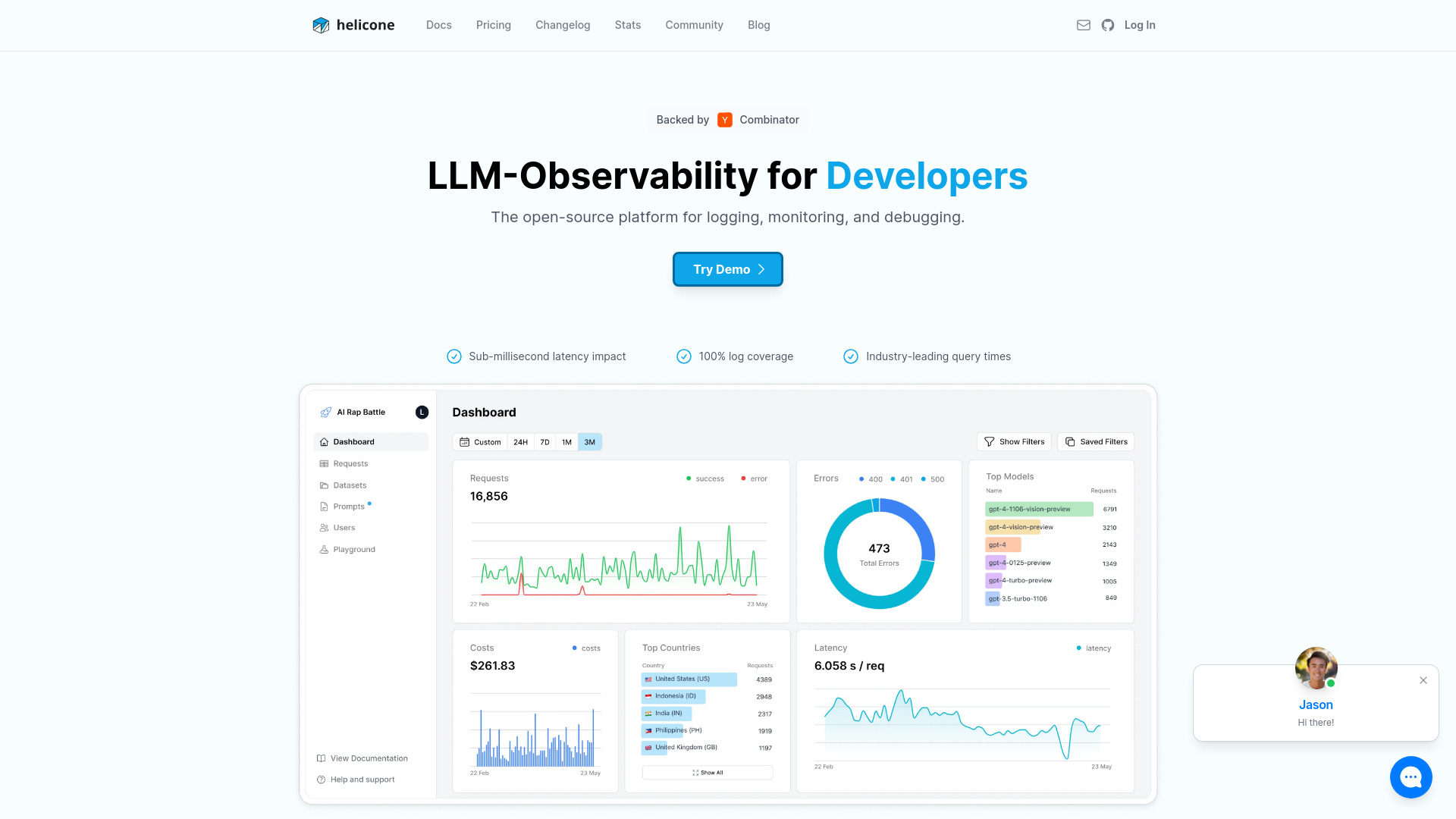

Présentation de l'outil:Observabilité LLM open source: monitoring, débogage, traçage en 1 ligne.

-

Date d'inclusion:2025-10-31

-

Réseaux sociaux et e-mails:

Informations sur l'outil

Qu’est-ce que Helicone AI

Helicone AI est une plateforme d’observabilité pour modèles de langage (LLM) conçue pour le monitoring, le débogage et l’optimisation des applications d’IA en production. Grâce à une intégration en une ligne, elle centralise les journaux d’exécution, le suivi des coûts, la traçabilité des agents et la gestion des invites, afin d’aider les équipes à diagnostiquer les problèmes plus vite et à améliorer la qualité des réponses. Open source, Helicone AI offre une vue d’ensemble fiable pour piloter la performance et la stabilité des applications IA.

Fonctionnalités principales de Helicone AI

- Observabilité complète des LLM : centralisation des requêtes, réponses et métadonnées pour analyser la performance et la fiabilité.

- Suivi des coûts : visibilité sur le coût par requête, par fonctionnalité ou par environnement pour maîtriser le budget.

- Traçage d’agents : visualisation des chaînes d’appels et des étapes d’agent afin de comprendre le comportement et repérer les goulots d’étranglement.

- Gestion des invites : versionnage et comparaison d’invites pour améliorer la qualité des sorties et réduire les itérations.

- Intégration en une ligne : mise en place rapide sans refonte du code, pour capter immédiatement les métriques essentielles.

- Débogage accéléré : inspection des erreurs, latences et dérives pour corriger plus vite en phase de test comme en production.

- Tableaux de bord : vues synthétiques des performances et tendances pour suivre l’impact des changements au fil du temps.

À qui s’adresse Helicone AI

Helicone AI s’adresse aux développeurs, équipes produit, ingénieurs MLOps et data scientists qui déploient des applications d’IA générative en production. Il convient aux startups souhaitant itérer rapidement, aux équipes d’entreprise ayant des exigences de contrôle des coûts et de qualité, ainsi qu’aux organisations qui utilisent des agents ou des chaînes d’appels nécessitant une traçabilité fine.

Comment utiliser Helicone AI

- Installer ou connecter Helicone AI selon la méthode recommandée, puis effectuer l’intégration en une ligne dans votre code.

- Configurer les clés et variables nécessaires, définir les projets et environnements (test, préproduction, production).

- Activer la collecte des requêtes et des réponses pour commencer à alimenter les tableaux de bord.

- Mettre en place le traçage d’agents et la gestion des invites afin de suivre chaque étape critique.

- Analyser les métriques de performance, coûts et erreurs, puis itérer sur les invites et la logique d’agent.

- Suivre l’évolution après déploiement pour vérifier la stabilité et l’impact des optimisations.

Cas d’utilisation de Helicone AI

Dans le service client, Helicone AI mesure la qualité des réponses et le coût par conversation afin d’optimiser la pertinence et la marge. En recherche documentaire, il aide à diagnostiquer les latences et erreurs des chaînes d’enrichissement. Pour des agents autonomes, il cartographie les étapes critiques et isole les invites à améliorer. En contexte analytique, il permet de comparer des variantes d’invite et de piloter les coûts à l’échelle d’un produit.

Tarification de Helicone AI

Helicone AI est un projet open source et peut être auto-hébergé. Les informations détaillées sur d’éventuelles offres hébergées et leurs tarifs ne sont pas précisées ici ; veuillez consulter les ressources officielles du projet pour les modalités les plus récentes.

Avantages et inconvénients de Helicone AI

Avantages :

- Observabilité unifiée des applications d’IA, du coût à la performance.

- Intégration rapide en une ligne, limitant l’effort d’adoption.

- Traçage d’agents et gestion des invites pour une optimisation continue.

- Approche open source offrant flexibilité et contrôle.

Inconvénients :

- Nécessite la collecte de journaux, impliquant une attention particulière à la confidentialité.

- Peut ajouter une légère complexité opérationnelle selon l’architecture existante.

- Courbe d’apprentissage pour tirer pleinement parti des tableaux de bord et du traçage.

Questions fréquentes sur Helicone AI

-

Helicone AI peut-il être auto-hébergé ?

Oui, le projet est open source et peut être déployé dans votre propre environnement selon la documentation fournie.

-

Quel est l’impact sur la latence ?

L’intégration est conçue pour être légère ; l’impact dépend toutefois de votre configuration et du volume de trafic.

-

Quelles données sont collectées ?

Les requêtes, réponses et métadonnées utiles à l’observabilité peuvent être enregistrées. La portée exacte dépend de vos paramètres.

-

Le suivi des coûts est-il inclus ?

Oui, Helicone AI fournit des indicateurs de coûts afin de mesurer le coût par requête et d’identifier les postes les plus onéreux.

-

Puis-je gérer et comparer mes invites ?

Oui, la gestion des invites permet de versionner et d’évaluer différentes variantes pour améliorer la qualité des résultats.