Helicone

打開網站-

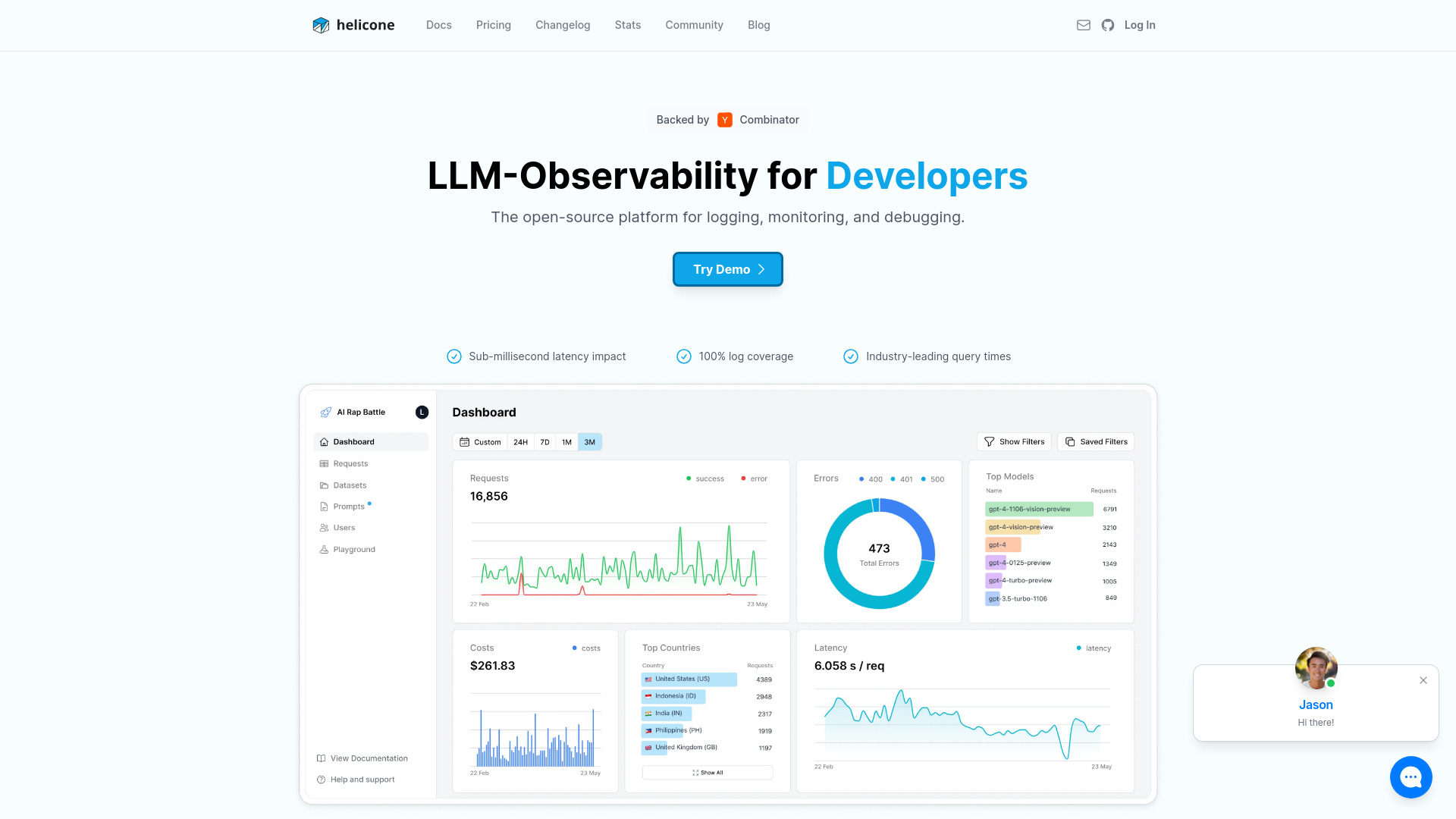

工具介紹:開源LLM可觀測平台:監控、偵錯、全鏈路追蹤與成本分析,內建提示詞管理,1行整合,穩定上線,便於持續優化迭代。

-

收錄時間:2025-10-31

-

社群媒體&信箱:

工具資訊

什麼是 Helicone AI

Helicone AI 是一個以開源為核心的 LLM 可觀測性與運維平台,專為監控、除錯與優化生成式 AI 應用而生。它透過輕量的一行式整合,將模型請求與回應完整記錄,並提供即時的效能指標、成本統計與錯誤診斷,協助團隊在開發與上線階段快速定位問題、量化品質、持續改進。對於使用多家模型供應商或多環境佈署的產品團隊,Helicone AI 能統一彙整分散的日誌與追蹤資料,讓延遲、成功率、Token 使用量、花費走向一目了然。平台同時支援代理/智能體的樹狀追蹤、提示詞管理與版本控管,便於還原每次生成的上下文,對比不同提示與參數的影響,並以資料驅動的方式迭代體驗。此外,Helicone AI 提供標籤、搜尋、警報、資料脫敏與權限控管等治理能力,可配合團隊流程與合規需求,靈活選擇自建或雲端託管。透過這套一站式可觀測性方案,開發者能以更高信心交付可維運、可度量且可持續優化的 LLM 應用。

Helicone AI 主要功能

- 請求/回應日誌與索引:結構化紀錄每次 API 互動,支援條件過濾與全文搜尋,快速回放與重現問題。

- 成本與 Token 追蹤:按模型、環境、專案與標籤彙整用量與費用,掌握單功能與單用戶成本。

- 端到端追蹤與代理視覺化:以樹狀/時間線檢視鏈式調用與智能體步驟,定位瓶頸與錯誤來源。

- 提示詞管理與版本控管:集中管理模板、變數與版本,比較不同提示的品質與效能並支援回滾。

- 效能監控儀表板:即時監看延遲、成功率、吞吐、錯誤碼分佈等關鍵指標。

- 警報與通知:閾值或異常偵測後觸發提醒,避免問題擴大影響。

- 資料保護與治理:支援遮罩/脫敏、存取權限、資料保留政策,降低隱私與合規風險。

- 簡易整合:透過代理端點或 SDK 一行接入,最小改動即能開始收集遙測。

- 標記與評估:以標籤、註解與評分將商業語境連結到請求,用於比較與持續改進。

- 資料匯出與 API:以 API 匯出原始日誌與彙總結果,串接自有數據倉儲與 BI 報表。

Helicone AI 適用人群

Helicone AI 適合負責 LLM 應用的工程與產品團隊,包括後端工程師、機器學習工程師、資料科學家、AIOps/平台工程、產品經理與技術支援人員。特別適用於需要追蹤多模型供應商、多環境版本、快速定位生產問題、精準管理成本與確保合規的團隊;亦適合新創在有限資源下建立可量化的迭代流程,或企業在大規模導入生成式 AI 時建立統一的觀測與治理層。

Helicone AI 使用步驟

- 建立專案:註冊雲端帳號或部署自建版本,啟用工作空間與成員權限。

- 整合 SDK/代理:在現有 LLM 客戶端設定代理端點或加入 SDK,一行設定即可開始收集資料。

- 設定環境與標籤:為開發/測試/生產環境與關鍵路徑加上標籤,方便後續分群分析。

- 觸發請求並驗證:發送測試請求,於儀表板確認日誌、延遲、Token 與成本是否正確記錄。

- 建立儀表板與警報:挑選核心指標(如成功率、P95 延遲、每用戶成本)設置視圖與告警閾值。

- 管理提示與實驗:集中管理提示版本,對比不同模板/參數,評估品質與成本差異。

- 日常運維與優化:以追蹤與日誌回放定位錯誤,結合標籤與報表持續降低成本並提升穩定性。

Helicone AI 行業案例

在客戶服務領域,團隊以 Helicone AI 追蹤多輪對話機器人的延遲與解決率,快速定位影響體驗的提示版本並回滾;在內容生成工作流中,產品團隊以標籤區分不同主題管線,衡量每千字成本與拒絕率,據此調整模型與溫度參數;在金融與法遵場景,企業以資料脫敏與權限管控保護敏感資訊,並保留可稽核的請求軌跡;在內部知識助理中,工程團隊利用代理追蹤檢視檢索、重排序與生成各步驟的耗時與錯誤,將 P95 延遲顯著下降並降低雲端費用。

Helicone AI 收費模式

Helicone AI 採開源授權,支援自建部署以取得更高的資料控制權;同時提供雲端託管服務,通常會提供入門的免費額度與進階付費方案。常見的計價面向包含事件用量、功能套件(如進階治理/長期保留/單點登入)、團隊席次與支援等級。詳細方案與是否提供試用可依官方公告為準,團隊可依合規與成本需求在自建與雲端間彈性選擇。

Helicone AI 優點與缺點

優點:

- 開源且可自建,資料掌控度高,易於與既有基礎設施整合。

- 一行式整合,對既有程式碼影響小,快速取得可觀測性。

- 端到端追蹤與視覺化,利於定位瓶頸與回放問題。

- 完善的成本與 Token 可視化,支援精細化成本管理。

- 提示詞集中管理與版本控管,推動資料驅動的模型與體驗迭代。

- 警報、權限與資料脫敏等治理能力,協助因應合規要求。

- API 與匯出能力,方便串接數據倉儲與內部報表。

缺點:

- 經由代理收集遙測可能帶來極小的額外延遲,需評估對關鍵路徑的影響。

- 對少見或自訓模型場景可能需要自訂整合與事件結構。

- 雲端託管在嚴格資料主權要求下需進一步評估與設定脫敏策略。

- 功能面向廣,首次導入需花時間制定標籤規範與儀表板設計。

- 免費層通常有資料保留與功能限制,成長期團隊可能需升級。

Helicone AI 熱門問題

問:Helicone AI 是否支援多家 LLM 供應商與多環境?

答:支援對主流供應商與多環境的統一觀測,可用標籤與專案維度分流分析與權限定義。

問:導入後會影響延遲嗎?

答:整合以輕量代理/SDK 為主,通常只帶來極小額外延遲;對低延遲場景可透過分流或白名單路徑控制。

問:如何保護敏感資料?

答:可設定欄位遮罩與脫敏、權限控管與資料保留政策,並可選擇自建部署以加強資料主權。

問:能否自建部署於私有環境?

答:可以,作為開源方案,可在私有雲或本地環境部署,以符合內部合規與網路邊界需求。

問:如何進行成本與 Token 統計?

答:平台會自動彙整每次請求的 Token 與費用,並可按模型、功能模組或使用者群組出報表。

問:是否能匯出原始日誌做進一步分析?

答:可透過 API 或批次匯出取得原始與彙總資料,串接既有數據管線與 BI 工具。

問:一行式整合如何進行?

答:通常透過替換 LLM 客戶端的端點或加入最小設定的 SDK,即可開始自動蒐集請求與回應的觀測資料。