- Startseite

- KI Entwickler Tools

- Confident AI

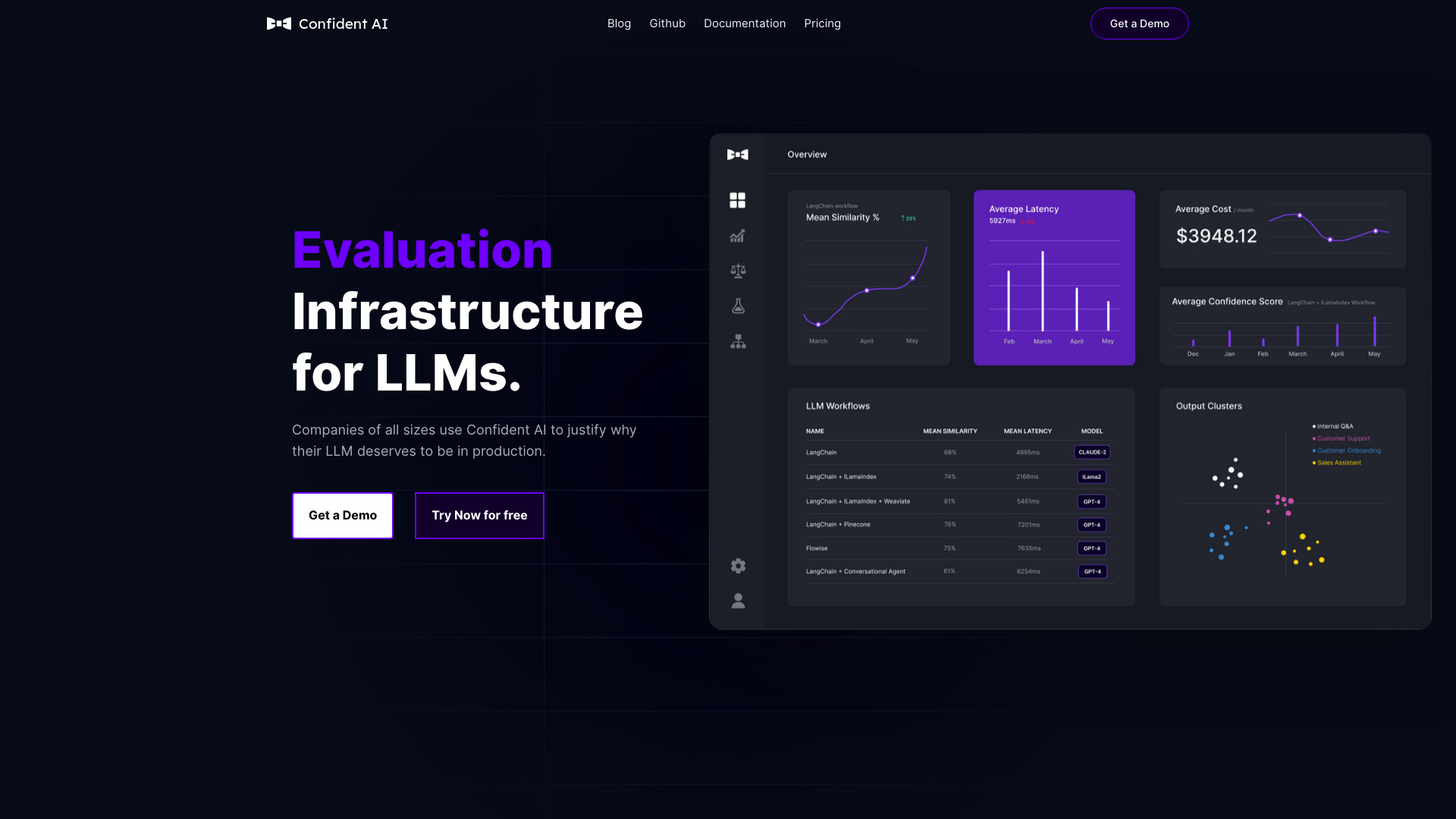

Confident AI

Website öffnen-

Tool-Einführung:LLM-Bewertung mit 14+ Metriken, Tracing und Datensätzen; Human Feedback.

-

Aufnahmedatum:2025-11-06

-

Soziale Medien & E-Mail:

Tool-Informationen

Was ist Confident AI

Confident AI ist eine All-in-One-Plattform zur LLM-Evaluierung, entwickelt von den Machern von DeepEval. Sie bietet 14+ Metriken, um LLM-Experimente durchzuführen, Datensätze zu kuratieren, die Performance zu überwachen und menschliches Feedback zu integrieren, damit sich Anwendungen automatisch verbessern. In Verbindung mit dem Open-Source-Framework DeepEval unterstützt Confident AI beliebige Anwendungsfälle. Engineering-Teams nutzen die Plattform, um LLMs mit Best-in-Class-Metriken und Tracing zu benchmarken, abzusichern und kontinuierlich zu optimieren – schneller, kosteneffizienter und überzeugend für Stakeholder.

Hauptfunktionen von Confident AI

- Umfassende Metrikbibliothek (14+): Bewertung von LLM-Ausgaben anhand vielfältiger Qualitätskriterien wie Genauigkeit, Relevanz und Robustheit.

- LLM-Experimente: Systematisches Benchmarking und A/B-Tests, um Modelle, Prompts und Konfigurationen vergleichbar zu machen.

- Datensatz-Management: Kuratieren, Versionieren und Ausrichten von Datensätzen an klar definierten Metriken.

- Tracing & Monitoring: Nachvollziehbarkeit von Runs und kontinuierliche Performance-Überwachung über Zeit und Releases.

- Human-in-the-Loop: Integration von menschlichem Feedback, um Bewertungen zu verfeinern und Modelle zielgerichtet zu verbessern.

- Automatisiertes LLM-Testing: Meinungsstarke Workflows, die Tests mit Tracing automatisieren und Iterationszyklen verkürzen.

- DeepEval-Integration: Nahtlose Zusammenarbeit mit dem Open-Source-Framework für flexible, reproduzierbare Experimente.

- Kosten- und Zeitersparnis: Schlankere Evaluierungsprozesse helfen, Inference-Kosten zu senken und Stakeholder von Fortschritten zu überzeugen.

Für wen ist Confident AI geeignet

Ideal für Engineering-Teams, Machine-Learning- und Data-Science-Teams, Produktmanager und Qualitätssicherung, die LLM-Anwendungen entwickeln, benchmarken und absichern möchten. Besonders geeignet bei komplexen Evaluierungen, der Verwaltung größerer Datensätze, dem Bedarf an Tracing sowie dem Nachweis messbarer Verbesserungen gegenüber Stakeholdern.

Wie man Confident AI verwendet

- Projekt einrichten: Ziel definieren (z. B. Halluzinationen reduzieren, Relevanz steigern) und Datenquellen festlegen.

- Datensätze kuratieren: Beispiele sammeln, labeln und strukturiert in Confident AI verwalten.

- Metriken wählen: Passende Qualitätsmetriken (z. B. Genauigkeit, Konsistenz, Robustheit) zuordnen und gewichten.

- Experimente aufsetzen: Modelle/Prompts konfigurieren, Runs planen und Varianten vergleichen.

- Tracing aktivieren: Ausgaben, Token-Nutzung und Fehlerpfade nachvollziehen, um Ursachen zu identifizieren.

- Human Feedback integrieren: Bewertungen erfassen, Aggregation mit automatischen Scores kombinieren.

- Ergebnisse auswerten: Benchmarks analysieren, Verbesserungen dokumentieren und Iterationen priorisieren.

- Automatisieren: Wiederkehrende Tests und Monitoring etablieren, um Releases abzusichern.

Branchenspezifische Anwendungsfälle von Confident AI

In E‑Commerce für die Bewertung von Produkt-Chatbots und semantischer Suche; im Kundensupport zur Qualitätssicherung von Antwortgeneratoren; in Fintech zur Prüfung von Regelkonformität und Risikohinweisen; im Gesundheitswesen zur Evaluierung von Zusammenfassungen medizinischer Dokumente; in Medien & Verlagen für Faktenkonsistenz bei Content-Generierung; in Bildung zur Messung der Relevanz und Genauigkeit von Tutor-Assistenzsystemen.

Vorteile und Nachteile von Confident AI

Vorteile:

- Best-in-Class-Metriken und Tracing für belastbare Benchmarks.

- Nahtlose DeepEval-Integration und flexible Anwendungsfälle.

- Human-in-the-Loop zur praxisnahen Qualitätsbeurteilung.

- Strukturierte Datensatzkurierung und metrikbasiertes Alignment.

- Automatisiertes Testing spart Zeit und senkt Inference-Kosten.

- Transparente Ergebnisse, die Stakeholder überzeugen.

Nachteile:

- Erfordert initiales Metrik-Design und kuratierte Datensätze.

- Lernkurve bei der Interpretation und Gewichtung mehrerer Metriken.

- Integration in bestehende Pipelines kann Engineering-Aufwand bedeuten.

- Nicht jede Metrik bildet subjektive Nutzerzufriedenheit vollständig ab.

Häufige Fragen zu Confident AI

Unterstützt Confident AI DeepEval?

Ja. Confident AI arbeitet mit dem Open-Source-Framework DeepEval zusammen und ermöglicht reproduzierbare LLM-Experimente.

Welche Arten von Metriken sind verfügbar?

Die Plattform bietet über 14 Metriken für Qualitätsbewertung, darunter Kriterien wie Genauigkeit, Relevanz und Robustheit.

Kann menschliches Feedback eingebunden werden?

Ja. Human-in-the-Loop ist integriert, um automatische Scores mit Expertenbewertungen zu kombinieren.

Für welche Anwendungsfälle eignet sich Confident AI?

Für beliebige LLM-Anwendungen – von Chatbots über RAG-Szenarien bis hin zu Content-Generierung und Support-Automatisierung.