Helicone

ウェブサイトを開く-

ツール紹介:オープンソースのLLM可観測性。監視・デバッグ・トレースとコスト/プロンプト管理を1行導入で、本番運用最適化。

-

登録日:2025-10-31

-

ソーシャルメディアとメール:

ツール情報

Helicone AIとは?

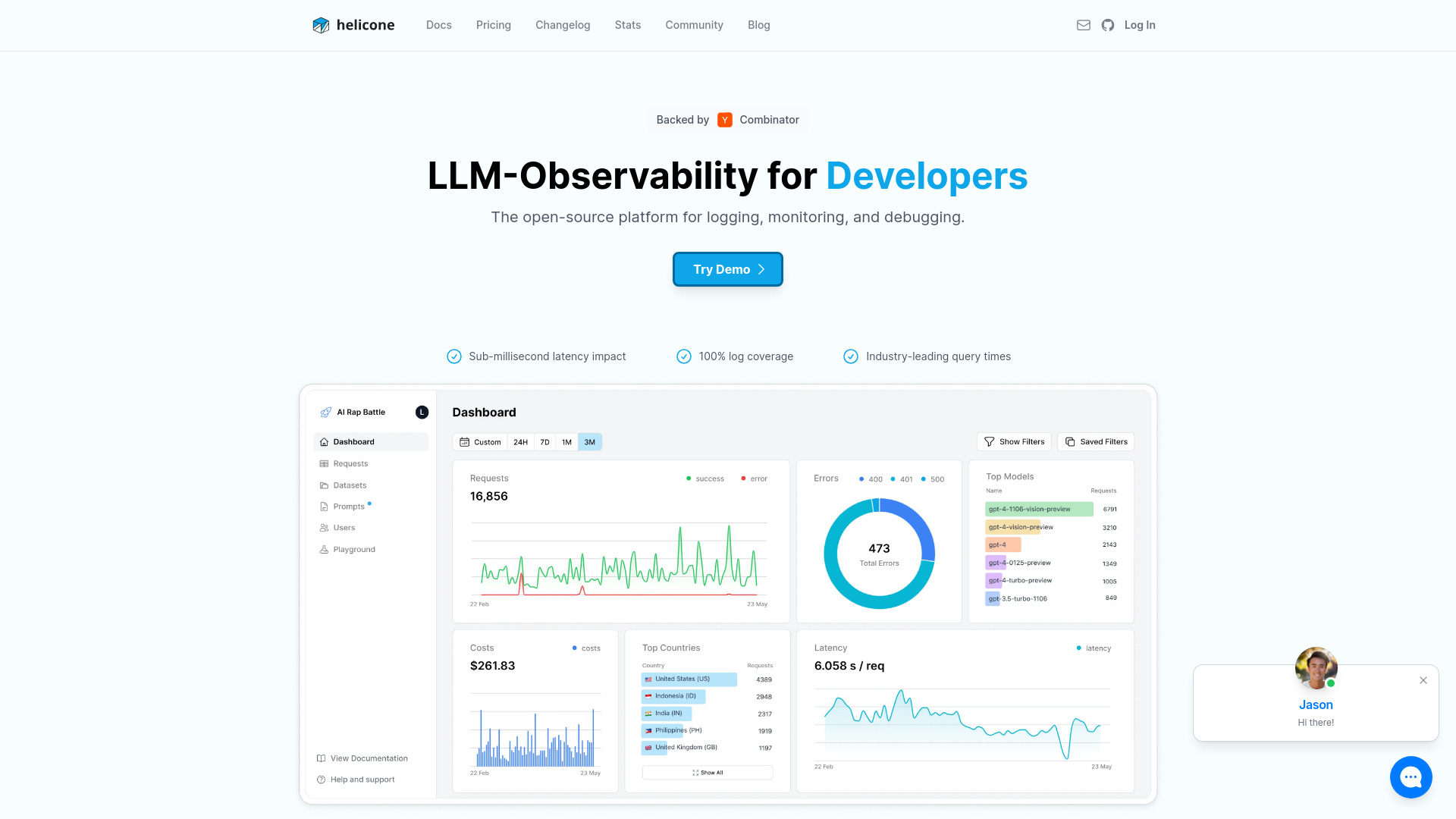

Helicone AIは、LLM(大規模言語モデル)を用いたアプリケーションの動作を可視化し、安定した本番運用を支えるためのオープンソースの可観測性プラットフォームです。開発者はわずか1行の統合で計測を開始でき、リクエストの挙動や品質、コストを横断的に把握できます。主な機能は、コストトラッキング、エージェントのトレーシング、プロンプト管理などで、モデル呼び出しのメトリクスを整理し、ボトルネックの発見や改善サイクルの短縮に役立ちます。開発・検証・本番の各フェーズを同じ視点でモニタリングできるため、予期せぬ振る舞いや劣化を早期に検知しつつ、運用コストを管理。これにより、AI機能を搭載したプロダクトを自信を持ってリリース・改善し続けるための土台を提供します。

Helicone AIの主な機能

- コストトラッキング:トークン消費や請求額の推移を可視化し、モデルやユースケース別のコスト最適化を支援。

- エージェントトレーシング:マルチステップの推論やツール呼び出しを追跡し、どの工程で時間やエラーが発生しているかを把握。

- プロンプト管理:プロンプトのバージョンを整理し、改善の履歴や効果を比較検証しやすくする運用基盤。

- モニタリングとデバッグ:リクエスト単位の挙動やメトリクスを俯瞰し、失敗原因の切り分けや再現性の確保をサポート。

- シンプルな導入:既存コードに最小限の変更で、1行の統合から観測・収集を開始可能。

- オープンソース基盤:自社要件に合わせた拡張やセルフホスト運用に適した柔軟性。

Helicone AIの対象ユーザー

Helicone AIは、LLMを活用するアプリケーションを本番運用する開発チームに適しています。具体的には、AIプロダクトの開発者やMLエンジニア、プロンプトエンジニア、プロダクトマネージャー、運用・品質管理担当、スタートアップからエンタープライズまでのAIチームが想定ユーザーです。プロトタイプから本番移行、そして継続的な改善までを一貫して見渡したい場面や、コストの見える化と安定性の両立が必要なユースケースに有効です。エージェント型のワークフローや複雑なチェーン構成の挙動を把握したい場合にも導入効果が見込めます。

Helicone AIの使い方

- 環境準備:Helicone AIのセットアップを行い、利用環境(ホスト/セルフホスト)を決定します。

- 1行の統合:ガイドに従い、SDKやプロキシ設定など最小の変更でLLM呼び出しに計測を組み込みます。

- 認証設定:必要なAPIキーや環境変数を安全に設定し、ログの収集を開始します。

- タグとコンテキスト:リクエストにタグやメタデータを付与して、ユースケース・モデル・バージョンごとに分析しやすくします。

- ダッシュボード確認:レイテンシ、成功率、トークン使用量などのメトリクスを可視化し、異常や劣化を早期に発見します。

- コスト最適化:コストトラッキング結果をもとに、モデル選定・パラメータ・キャッシュ戦略などを見直します。

- トレーシングで深掘り:エージェントやチェーンの各ステップを追跡し、ボトルネックやエラー原因を特定します。

- プロンプト管理:バージョンを整理し、A/B的な比較やロールバック方針を定めて改善を継続します。

Helicone AIの業界での活用事例

顧客対応のチャット支援では、問い合わせのピーク時にレイテンシや失敗率を監視し、プロンプト改善とコスト抑制を同時に実現します。ECの検索・レコメンド支援では、プロダクトカタログに合わせたプロンプトのバージョン管理と、各モデルのコスト効果を比較。生成支援ツールや社内コパイロットでは、マルチステップのエージェント動作をトレースして、問題箇所を迅速にデバッグします。コンテンツ生成やレビュー工程でも、品質指標とコストメトリクスを並行して把握することで、リリース後の改善サイクルを短縮し、安定した本番運用に寄与します。

Helicone AIの料金プラン

Helicone AIはオープンソースとして提供されており、セルフホストでの運用が可能です。導入形態やサポート体制によって選択肢が異なるため、最新の提供形態や利用条件は公式情報をご確認ください。

Helicone AIのメリットとデメリット

メリット:

- オープンソース基盤で拡張性と導入の柔軟性が高い。

- 1行の統合で既存アプリに最小変更で計測を追加可能。

- コストトラッキングにより、モデル運用費の見える化と最適化が進む。

- エージェントトレーシングで複雑なチェーンの問題を特定しやすい。

- プロンプト管理により、改善履歴の整理と検証がスムーズ。

- 開発〜本番まで一貫したモニタリングとデバッグが可能。

デメリット:

- 計測設計やタグ運用など、導入初期にワークフロー整備が必要。

- ログの取り扱いにおいて、データ保持やプライバシー配慮の運用設計が求められる。

- LLMプロバイダ固有機能との使い分けや相性を検討する必要がある。

- チーム全体に可観測性の文化を浸透させるための運用負荷が発生しうる。

Helicone AIに関するよくある質問

-

質問:Helicone AIは何を解決しますか?

LLMアプリのモニタリング、デバッグ、改善を一元化し、品質・コスト・信頼性を継続的に高めるための可観測性を提供します。

-

質問:「1行の統合」とはどのようなものですか?

ガイドに沿って最小限のコード変更または設定を加えるだけで、LLMリクエストの収集と可視化を開始できる導入方式を指します。

-

質問:どのようなデータが記録されますか?

リクエストのメタデータ、処理時間、結果の成否、トークン消費量など、運用上の判断に必要な指標を中心に可視化します。

-

質問:プロンプト管理では何ができますか?

プロンプトのバージョンを整理し、変更前後の挙動やコストへの影響を比較しながら改善を進められます。

-

質問:セルフホストは可能ですか?

はい。オープンソースのため、要件に合わせてセルフホスト運用が可能です。

-

質問:本番でのオーバーヘッドはありますか?

一般的に計測には最小限のオーバーヘッドが伴います。導入時に必要な範囲に絞って収集項目を設計することで、影響を抑えられます。