Helicone

Mở trang web-

Giới thiệu công cụ:Quan sát LLM mã nguồn mở: giám sát, gỡ lỗi, truy vết; tích hợp 1 dòng.

-

Ngày thêm:2025-10-31

-

Mạng xã hội & Email:

Thông tin công cụ

Helicone AI là gì?

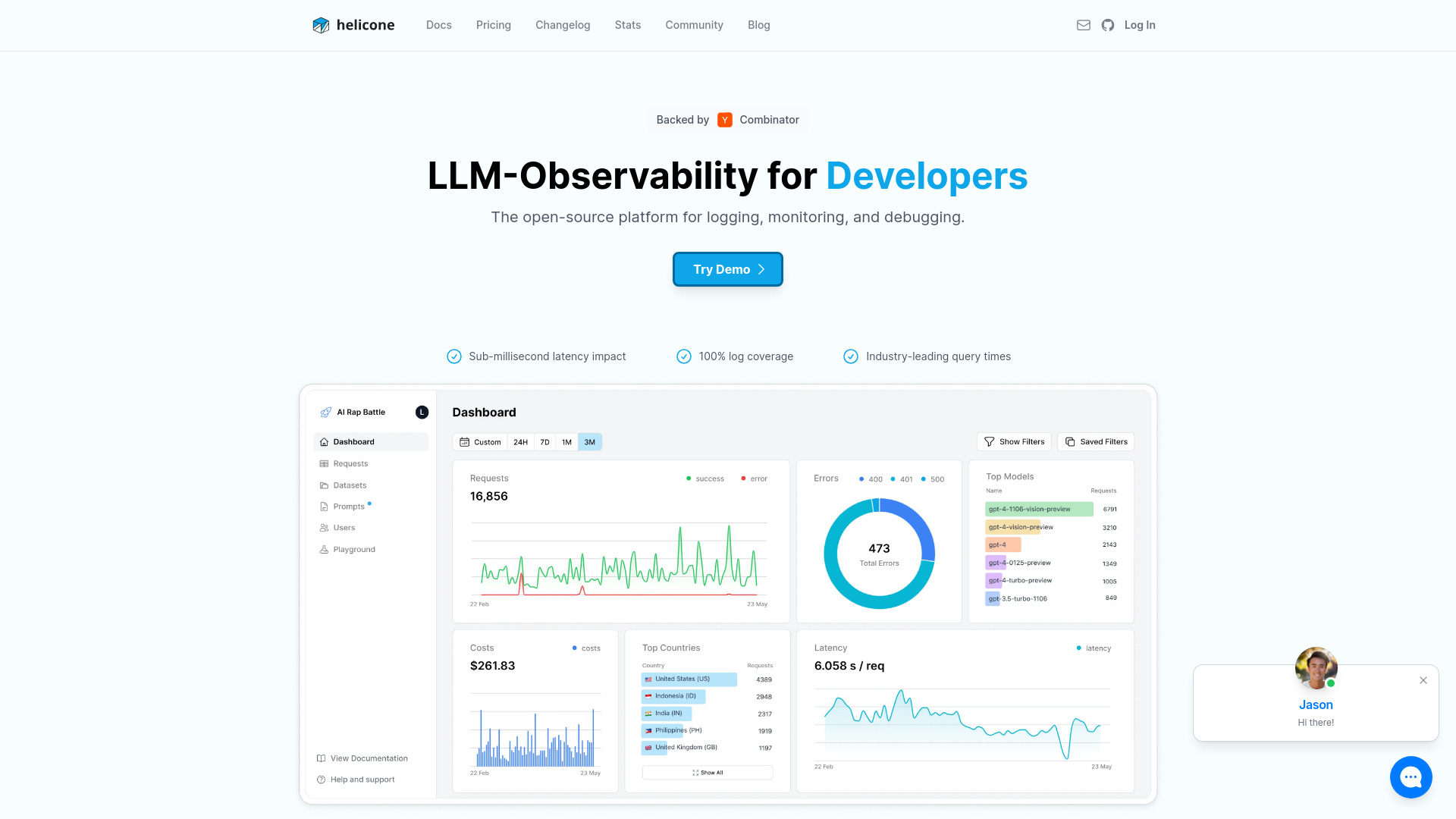

Helicone AI là nền tảng LLM observability mã nguồn mở giúp đội ngũ phát triển giám sát, gỡ lỗi và tối ưu hóa ứng dụng AI trong môi trường sản xuất. Chỉ với “1 dòng” tích hợp qua proxy/SDK, Helicone thu thập nhật ký lời gọi mô hình, đo độ trễ, theo dõi chi phí, tỉ lệ lỗi và truy vết hành trình của agent/chain. Công cụ còn hỗ trợ quản lý phiên bản prompt, A/B testing và thiết lập cảnh báo để phát hiện sớm bất thường. Nhờ cái nhìn toàn diện về hiệu năng, chất lượng và chi phí, Helicone giúp bạn triển khai và cải tiến ứng dụng LLM một cách tự tin, bền vững và tối ưu chi phí vận hành.

Các tính năng chính của Helicone AI

- Tích hợp “1 dòng”: thay đổi base URL hoặc thêm middleware/SDK để bắt đầu ghi nhận lời gọi LLM.

- Dashboard thời gian thực: theo dõi thông lượng, độ trễ, tỉ lệ lỗi, token in/out và xu hướng sử dụng.

- Phân tích chi phí và mức sử dụng: quy chiếu theo người dùng, tính năng, mô hình hoặc môi trường (dev/staging/prod).

- Tracing agent/chain: trực quan hóa các bước suy luận, tool calls, context RAG và luồng yêu cầu-phản hồi.

- Quản lý prompt: phiên bản hóa, so sánh và A/B test để cải thiện chất lượng đầu ra.

- Ghi log có cấu trúc và gắn thẻ: thêm metadata, bộ lọc nâng cao, tìm kiếm nhanh các phiên bất thường.

- Cảnh báo và SLO: đặt ngưỡng cho độ trễ, lỗi, chi phí; gửi cảnh báo qua kênh tích hợp hoặc webhook.

- Tùy chọn triển khai linh hoạt: mã nguồn mở/self-host hoặc dùng dịch vụ đám mây; hỗ trợ ẩn/ghi đè dữ liệu nhạy cảm.

- Tương thích đa nhà cung cấp LLM: hoạt động với nhiều API mô hình phổ biến, giảm khóa chặt nhà cung cấp.

- API/SDK mở: truy xuất dữ liệu, tích hợp pipeline hiện có, xuất số liệu phục vụ BI và báo cáo.

Đối tượng phù hợp với Helicone AI

Helicone AI phù hợp với đội ngũ phát triển ứng dụng AI/LLM cần giám sát sản phẩm ở quy mô sản xuất: startup xây chatbot/assistant, doanh nghiệp triển khai RAG, nhóm MLOps/Platform cần quan sát chi phí-hiệu năng, nhà khoa học dữ liệu và PM muốn đo lường chất lượng đầu ra, cũng như tổ chức đa tenant cần tách bạch chi phí theo khách hàng/tính năng để tối ưu ngân sách.

Cách sử dụng Helicone AI

- Chọn Helicone Cloud hoặc tự triển khai bản mã nguồn mở trong hạ tầng của bạn.

- Tạo API key và cấu hình proxy/SDK: thay baseURL của nhà cung cấp LLM sang Helicone hoặc cài middleware tương ứng.

- Gắn metadata (user_id, feature, tenant, environment) để phân tích chi tiết theo ngữ cảnh sử dụng.

- Bật quản lý prompt, tạo phiên bản và (nếu cần) thiết lập A/B test cho các biến thể prompt/model.

- Gửi yêu cầu LLM như thường lệ; kiểm tra dashboard, truy vết agent/chain và lọc log các phiên quan trọng.

- Đặt cảnh báo/SLO cho độ trễ, lỗi, chi phí; nhận thông báo khi vượt ngưỡng để xử lý kịp thời.

- Định kỳ xem báo cáo, tìm nút thắt cổ chai và tối ưu prompt/cấu hình model để cải thiện chất lượng và chi phí.

Trường hợp ứng dụng thực tế của Helicone AI

Doanh nghiệp hỗ trợ khách hàng bằng chatbot có thể theo dõi tỉ lệ giải quyết tự động, lỗi và chi phí theo kênh; sản phẩm RAG giám sát độ trễ từng chặng (retrieval, rerank, sinh đáp án) để tối ưu pipeline; hệ thống agent theo dõi tool calls và fallback nhằm phát hiện bước suy luận gây tốn kém; ứng dụng SaaS đa tenant phân bổ chi phí theo khách hàng và thực hiện A/B test prompt để nâng chất lượng mà vẫn kiểm soát ngân sách.

Gói cước và mô hình giá của Helicone AI

Helicone cung cấp bản mã nguồn mở để tự triển khai, phù hợp với đội ngũ ưu tiên quyền kiểm soát dữ liệu và chi phí. Bên cạnh đó, dịch vụ đám mây thường có các gói từ miễn phí giới hạn đến trả phí nâng cao (mở rộng giới hạn sự kiện, thời gian lưu trữ log, tính năng doanh nghiệp như SSO/SLA/hỗ trợ). Chính sách giá và tính năng theo gói có thể thay đổi theo thời điểm; bạn nên tham khảo trực tiếp trang chủ để cập nhật chi tiết mới nhất.

Ưu điểm và nhược điểm của Helicone AI

Ưu điểm:

- Mã nguồn mở, linh hoạt self-host hoặc dùng cloud.

- Tích hợp nhanh với chi phí thay đổi thấp cho nhóm phát triển.

- Quan sát toàn diện: hiệu năng, chất lượng, chi phí và truy vết agent/chain.

- Quản lý prompt và A/B test giúp cải thiện đầu ra có cơ sở dữ liệu.

- Giảm rủi ro khóa chặt nhà cung cấp, hỗ trợ nhiều API mô hình.

Nhược điểm:

- Thêm một bước proxy có thể tạo độ trễ nhỏ và yêu cầu quản trị hạ tầng.

- Hiệu quả tracing phụ thuộc mức độ gắn metadata/instrumentation từ ứng dụng.

- Cần thời gian làm quen để thiết lập SLO, cảnh báo và quy chuẩn hóa log.

Các câu hỏi thường gặp về Helicone AI

-

Câu hỏi: Helicone AI khác gì so với công cụ giám sát truyền thống?

Trả lời: Helicone tập trung vào đặc thù LLM: token, prompt, tracing agent/chain, chi phí theo mô hình và A/B test, cung cấp ngữ cảnh phù hợp để tối ưu ứng dụng AI.

-

Câu hỏi: Tích hợp Helicone mất bao lâu?

Trả lời: Thông thường chỉ vài phút với “1 dòng” thay baseURL hoặc thêm SDK/middleware, không cần thay đổi kiến trúc lớn.

-

Câu hỏi: Helicone có ảnh hưởng hiệu năng không?

Trả lời: Có thể phát sinh một độ trễ nhỏ do lớp proxy/thu thập log, thường bù lại bằng khả năng quan sát và tối ưu chi phí-hiệu năng.

-

Câu hỏi: Dữ liệu có an toàn không?

Trả lời: Bạn có thể self-host để kiểm soát dữ liệu; hỗ trợ che/ẩn trường nhạy cảm và tùy biến thời gian lưu trữ log theo chính sách nội bộ.

-

Câu hỏi: Helicone hỗ trợ những nhà cung cấp LLM nào?

Trả lời: Hoạt động với nhiều API mô hình phổ biến và có thể tích hợp thông qua proxy/SDK tiêu chuẩn, giúp linh hoạt lựa chọn nhà cung cấp.

-

Câu hỏi: Có thể theo dõi đa tenant hoặc theo tính năng?

Trả lời: Có. Gắn metadata như tenant, feature, môi trường để phân tích chi tiết chi phí, hiệu năng và chất lượng theo từng lát cắt.

-

Câu hỏi: Helicone có hỗ trợ A/B test prompt?

Trả lời: Có, bạn có thể phiên bản hóa prompt và so sánh biến thể để chọn cấu hình hiệu quả nhất dựa trên số liệu.