- Startseite

- AI Code Assistent

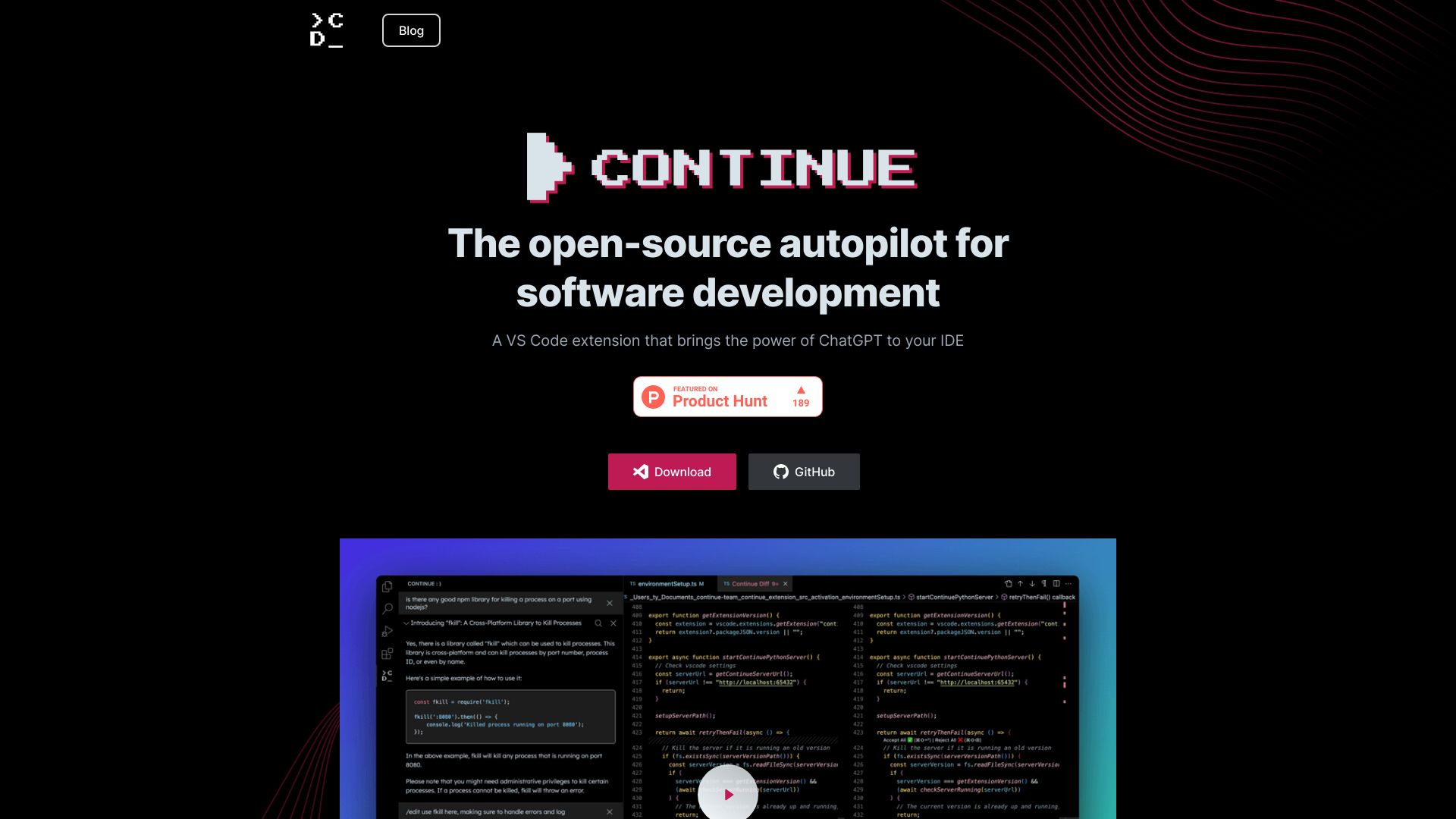

- Continue

Continue

Website öffnen-

Tool-Einführung:KI-Storytelling und Anime-Bilder für maximale kreative Freiheit.

-

Aufnahmedatum:2025-10-21

-

Soziale Medien & E-Mail:

Tool-Informationen

Was ist Continue AI

Continue AI ist ein Open-Source-Autopilot für Softwareentwicklung als VS Code-Erweiterung. Das Tool bringt die Leistungsfähigkeit von ChatGPT und anderen Modellen direkt in die IDE, um Code schneller zu schreiben, zu verstehen und zu verbessern. Sie können beliebige Sprachmodelle und Kontextquellen anbinden – vom Repository bis zur Doku – und so maßgeschneiderte Autovervollständigung und Chat-Workflows erstellen. Continue AI lässt sich tiefgreifend konfigurieren und lernt fortlaufend aus Entwicklungsdaten, um immer relevantere Vorschläge und Automatisierungen bereitzustellen.

Hauptfunktionen von Continue AI

- Modell-agnostisch: Verbinden Sie verschiedene LLMs (Cloud oder lokal) und wählen Sie pro Aufgabe das passende Modell.

- Anpassbare Autovervollständigung: Feintuning der Codevorschläge nach Projektstil, Frameworks und Team-Konventionen.

- In-IDE-Chat: Kontextsensitiver Chat in VS Code zum Erklären, Generieren und Refaktorieren von Code – ohne die IDE zu verlassen.

- Kontext-Integration: Einbindung von Repository-, Datei- und Doku-Kontext für präzisere Antworten.

- Aufgaben-Autopilot: Wiederkehrende Aufgaben wie Tests erzeugen, Boilerplate schreiben oder Migrationsskizzen erstellen.

- Lernen aus Entwicklungsdaten: Kontinuierliche Verbesserung der Relevanz durch Projekt- und Historienkontext.

- Open Source & erweiterbar: Offener Stack, konfigurierbare Prompts, eigene Befehle und Workflows.

- Datensouveränität: Nutzung lokaler oder selbst gehosteter Modelle für erhöhte Privatsphäre.

Für wen ist Continue AI geeignet

Ideal für Softwareentwickler und Engineering-Teams, die in VS Code arbeiten und eine flexibel anpassbare, modell-unabhängige KI-Hilfe suchen. Geeignet für Start-ups mit schnellem Iterationstempo, produktgetriebene Teams mit Fokus auf Qualität sowie Organisationen mit Compliance-Anforderungen, die Code und Kontext bevorzugt lokal halten möchten.

Wie man Continue AI verwendet

- VS Code öffnen und die Continue AI-Erweiterung aus dem Marketplace installieren.

- Ein gewünschtes Sprachmodell verbinden (API-Schlüssel oder Endpoint für Cloud- bzw. lokal gehostete Modelle hinterlegen).

- Kontexte konfigurieren: relevante Ordner, Repos, Dokumentation oder Wissensquellen definieren.

- Prompts, Befehle und Autovervollständigungs-Regeln an die Team-Standards anpassen.

- Im Chat Fragen stellen, Code generieren/erklären lassen oder Inline-Vorschläge in Dateien annehmen.

- Änderungen prüfen, Tests ausführen und wie gewohnt committen – optional mit KI-gestützten Commit-Messages.

Branchenspezifische Anwendungsfälle von Continue AI

In SaaS beschleunigt Continue AI Feature-Implementierungen und reduziert Boilerplate. In FinTech unterstützt es beim sicheren Refactoring mit nachvollziehbaren Änderungen. E-Commerce-Teams modernisieren Legacy-Code und verbessern Testabdeckung. In Industrie/Embedded hilft es beim Generieren von Unit-Tests und beim Dokumentieren von Schnittstellen. Agenturen und Beratungen profitieren von schnellerem Onboarding durch kontextsensitives Codeverständnis direkt in der IDE.

Preismodell von Continue AI

Open Source und in der Regel kostenlos nutzbar. Es können Kosten bei den angebundenen Sprachmodellen entstehen (z. B. API-Verbrauch der jeweiligen Anbieter). Prüfen Sie die Konditionen der genutzten Modelle separat.

Vorteile und Nachteile von Continue AI

Vorteile:

- Open-Source, transparent und erweiterbar.

- Modell-unabhängig – frei wählbare LLMs, auch lokal.

- Tiefer Kontextbezug für präzisere Antworten in realen Projekten.

- Nahtlose VS Code-Integration mit Chat und Autovervollständigung.

- Verbesserte Produktivität bei wiederkehrenden Aufgaben und Refactorings.

Nachteile:

- Erstkonfiguration und Kontextpflege können Aufwand bedeuten.

- Qualität der Ergebnisse hängt stark vom gewählten Modell und bereitgestelltem Kontext ab.

- Mögliche API-Kosten bei Cloud-Modellen.

- Primär für VS Code ausgelegt – andere IDEs ggf. nicht abgedeckt.

- Teamweite Standards erfordern disziplinierte Konfiguration.

Häufige Fragen zu Continue AI

-

Unterstützt Continue AI mehrere Sprachmodelle?

Ja, es ist modell-agnostisch und kann mit verschiedenen Cloud- und lokal gehosteten LLMs verbunden werden.

-

Bleibt mein Code lokal?

Sie können lokale oder selbst gehostete Modelle nutzen, sodass sensibler Code die eigene Umgebung nicht verlassen muss.

-

Funktioniert es nur mit JavaScript/TypeScript?

Continue AI ist sprachübergreifend nutzbar; die Qualität der Vorschläge variiert je nach Modell und Projektkontext.

-

Kann ich eigene Befehle und Prompts definieren?

Ja, Workflows, Prompts und Regeln lassen sich an Team-Standards anpassen und erweitern.

-

Benötige ich eine Internetverbindung?

Für Cloud-Modelle ja; bei lokal gehosteten Modellen kann die Arbeit weitgehend offline erfolgen.