- Startseite

- KI-Textgenerator

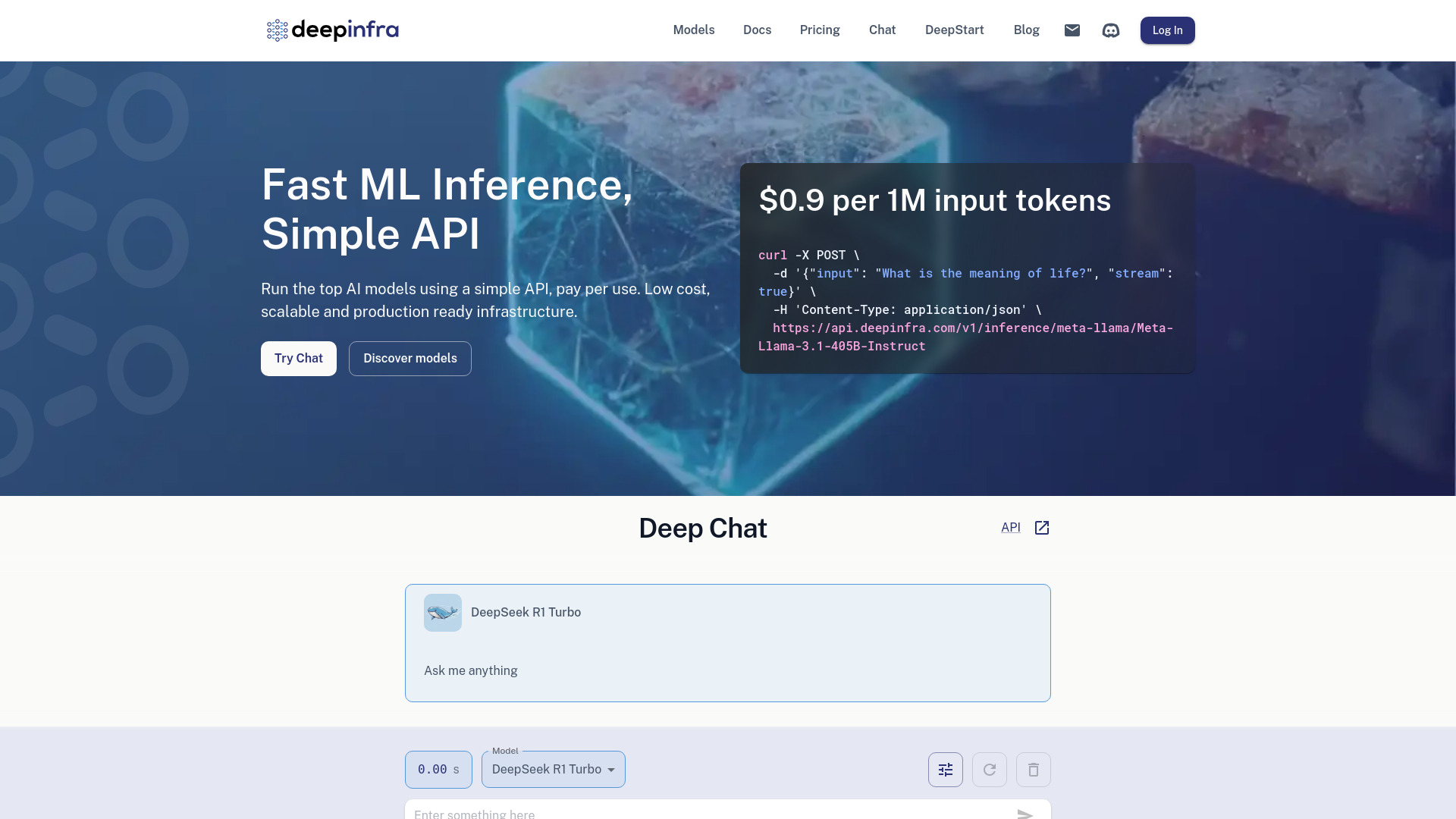

- Deep Infra

Deep Infra

Website öffnen-

Tool-Einführung:Top-KI per einfacher API: nutzungsbasiert, geringe Latenz, eigene LLMs.

-

Aufnahmedatum:2025-10-21

-

Soziale Medien & E-Mail:

Tool-Informationen

Was ist Deep Infra AI

Deep Infra AI ist eine Inferenz-Plattform für produktive KI-Anwendungen. Sie stellt skalierbare, niedrig-latente Endpunkte für Top-KI-Modelle bereit und ermöglicht über eine einfache API Textgenerierung, Text-to-Speech, Text-to-Image und Automatic Speech Recognition. Teams können eigene LLMs auf dedizierten GPUs bereitstellen oder sofort verfügbare Modelle nutzen. Das Pay-per-Use-Modell senkt Einstiegshürden, während automatische Skalierung, Monitoring und zuverlässige Bereitstellung den Produktionsbetrieb vereinfachen.

Hauptfunktionen von Deep Infra AI

- Einfache API: Einheitliche Endpunkte für verschiedene Modelle und Aufgaben – von LLMs bis TTS, TTI und ASR.

- Niedrige Latenz: Optimierte Inferenzpfade für schnelle Antworten in Echtzeit-Anwendungen.

- Skalierbarkeit: Automatisches Hoch- und Herunterskalieren je nach Traffic ohne Infrastrukturpflege.

- Dedizierte GPUs: Isolierte Deployments für benutzerdefinierte LLMs mit konsistenter Performance.

- Modellvielfalt: Zugriff auf führende Open-Source- und Foundation-Modelle für Text, Sprache und Bilder.

- Streaming & Steuerung: Token-Streaming und Parameter wie Temperatur, Top-p oder Max-Tokens für feinjustierte Ergebnisse.

- Monitoring & Nutzungsübersicht: Transparente Metriken zur Qualitätssicherung und Kostenkontrolle.

- Produktionsreife: Hohe Verfügbarkeit, stabile Endpunkte und Best Practices für den Live-Betrieb.

Für wen ist Deep Infra AI geeignet

Ideal für Entwickler und Produktteams, die KI-Funktionen schnell integrieren möchten, für Start-ups mit Pay-per-Use-Fokus, für Data-Science-Teams, die Prototypen in Produktionsreife überführen, sowie für Unternehmen, die dedizierte GPU-Ressourcen für eigene Modelle benötigen. Auch Forschung, Medien, E‑Commerce und Kundenservice profitieren von niedriger Latenz und flexibler Skalierung.

Wie man Deep Infra AI verwendet

- Konto anlegen und API-Schlüssel generieren.

- Passendes Modell auswählen (z. B. LLM, TTS, TTI, ASR) anhand Anwendungsfall und Qualitätsanforderungen.

- Anfrage strukturieren: Prompt/Inputs definieren und Parameter wie Temperatur, Top-p, Max-Tokens setzen.

- Erste Tests durchführen und Streaming oder Batch-Verarbeitung je nach Bedarf aktivieren.

- In die Anwendung integrieren (Backend-Service, Edge-Worker oder Microservice).

- Monitoring und Logging aufsetzen, Output-Qualität und Latenz prüfen.

- Bei höherem Traffic auf dedizierte GPUs migrieren, um Performance und Isolation zu sichern.

- Nutzung und Kosten regelmäßig auswerten und Parameter optimieren.

Branchenspezifische Anwendungsfälle von Deep Infra AI

E‑Commerce: Produktassistenten, personalisierte Empfehlungen, semantische Suche. Medien & Marketing: Textgenerierung, Voice-Over (TTS), Bildkreation für Kampagnen. Kundenservice: ASR zur Transkription von Anrufen, Antwortvorschläge in Echtzeit. Bildung & Wissen: Tutor-Chatbots, Zusammenfassungen. Software & IT: Code-Assistenz, Log-Analyse. Gesundheitswesen: interne Dokumentationshilfe (mit beachteten Compliance-Vorgaben).

Preismodell von Deep Infra AI

Deep Infra AI setzt auf ein Pay-per-Use-Modell mit verbrauchsabhängiger Abrechnung der Inferenz. Für dedizierte GPUs gelten separate, nutzungsbasierte Tarife. Details zu Preisen, Limits und eventuellen Testmöglichkeiten stellt der Anbieter auf seiner Website bereit.

Vorteile und Nachteile von Deep Infra AI

Vorteile:

- Schnelle Integration über eine klare, einheitliche API.

- Niedrige Latenz und zuverlässige Produktionsreife.

- Skalierbarkeit vom Prototyp bis zu hohem Traffic.

- Modellvielfalt für Text, Sprache und Bilder.

- Dedizierte GPUs für eigene LLMs und konstante Performance.

- Transparente Nutzung und Kostenkontrolle durch Pay-per-Use.

Nachteile:

- Abhängigkeit von einem externen Inferenzanbieter.

- Kosten können bei sehr hohem Volumen spürbar steigen.

- Modellverfügbarkeit und -versionen können variieren.

- Begrenzte Low-Level-Kontrolle im geteilten Umfeld im Vergleich zum Eigenbetrieb.

Häufige Fragen zu Deep Infra AI

-

Welche Aufgaben unterstützt Deep Infra AI?

Textgenerierung, Text-to-Speech, Text-to-Image und automatische Spracherkennung über eine einheitliche API.

-

Kann ich eigene LLMs bereitstellen?

Ja, benutzerdefinierte Modelle können auf dedizierten GPUs mit isolierten Ressourcen deployt werden.

-

Wie integriere ich die API?

API-Schlüssel erstellen, Modell wählen, Anfrage mit Prompt/Parametern senden und Ergebnisse per Streaming oder synchron verarbeiten.

-

Ist die Latenz für Echtzeit geeignet?

Die Plattform ist auf niedrige Latenz optimiert und unterstützt Echtzeit-Anwendungsfälle, abhängig von Modell und Konfiguration.