- Inicio

- Generador de Texto AI

- Deep Infra

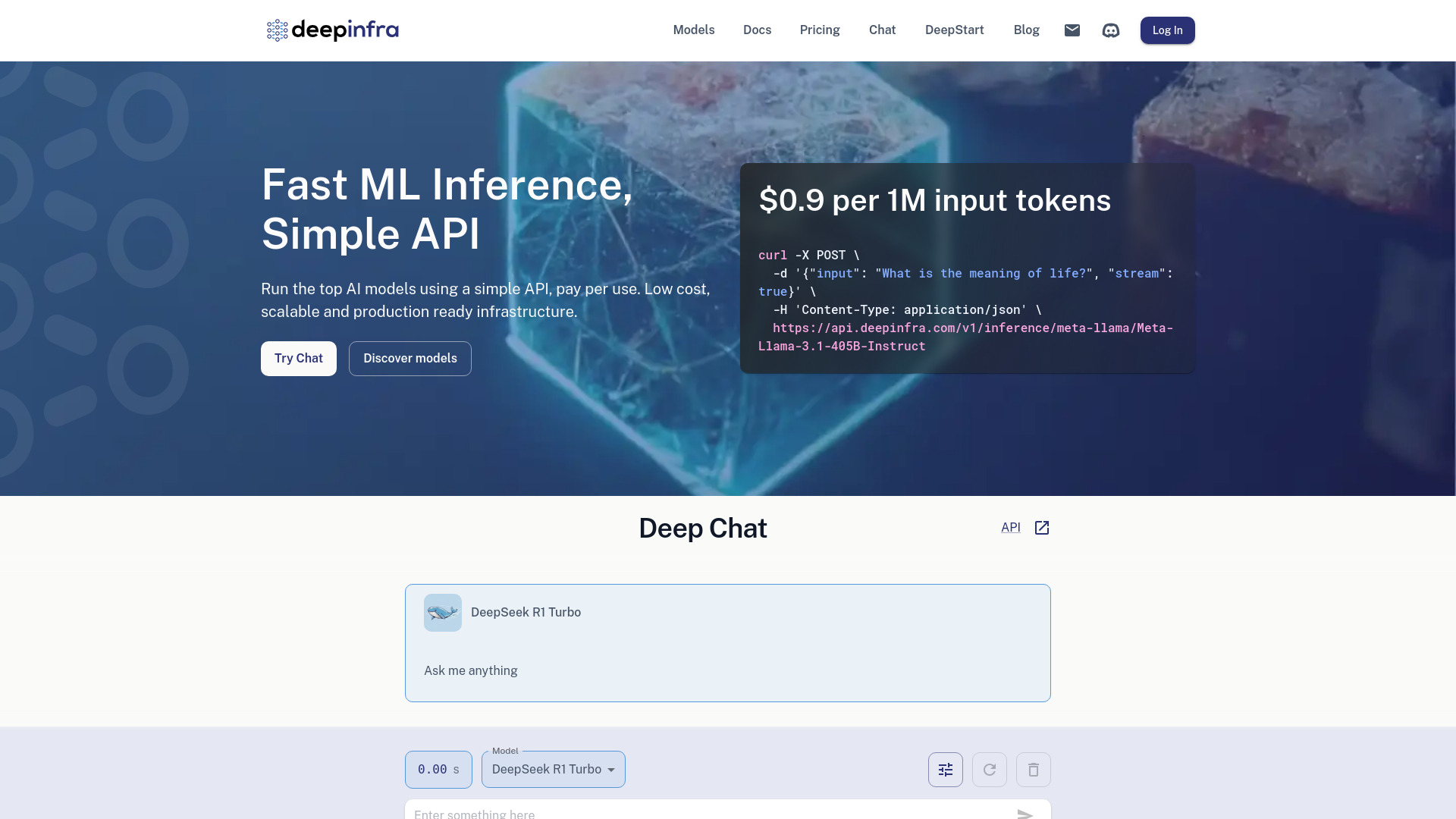

Deep Infra

Abrir sitio web-

Introducción de la herramienta:Modelos IA por API simple: pago por uso, baja latencia, LLM propios.

-

Fecha de inclusión:2025-10-21

-

Redes sociales y correo electrónico:

Información de la herramienta

¿Qué es Deep Infra AI?

Deep Infra AI es una plataforma de infraestructura y modelos de aprendizaje automático lista para producción que permite ejecutar modelos de IA de primer nivel mediante una API simple. Ofrece inferencia de baja latencia, escalado automático y un enfoque rentable con pago por uso. Los usuarios pueden desplegar LLMs personalizados en GPUs dedicadas y acceder a capacidades de generación de texto, texto a voz, texto a imagen y reconocimiento automático del habla. Su propósito es simplificar el despliegue, reducir costes y acelerar la integración de IA en productos reales.

Principales características de Deep Infra AI

- API unificada y sencilla: integra modelos de IA líderes con endpoints claros y autenticación por token para una implementación rápida.

- Inferencia de baja latencia: respuestas ágiles optimizadas para aplicaciones en tiempo real y cargas de producción.

- Escalado automático: capacidad para absorber picos de demanda sin gestionar infraestructura compleja.

- GPUs dedicadas para LLMs propios: despliegue de modelos personalizados con aislamiento y control de recursos.

- Multimodalidad: soporte para generación de texto, texto a voz (TTS), texto a imagen y reconocimiento automático del habla (ASR).

- Modelo de pago por uso: control de costes alineado al consumo real, ideal para pruebas, pilotos y producción.

- Listo para producción: alta disponibilidad práctica, observabilidad y buenas prácticas de despliegue.

- Compatibilidad flexible: integración en backends, microservicios y pipelines de datos con librerías y herramientas estándar.

¿Para quién es Deep Infra AI?

Ideal para desarrolladores y equipos de producto que necesitan añadir IA a sus aplicaciones sin gestionar clusters de GPU; para startups que buscan acelerar su salida al mercado con costes predecibles; para empresas que requieren inferencia en producción y escalabilidad; y para científicos de datos e investigadores que desean probar y desplegar LLMs personalizados con un flujo de trabajo simplificado.

Cómo usar Deep Infra AI

- Crea una cuenta: regístrate en la plataforma y configura tu espacio de trabajo.

- Obtén tu clave API: genera y guarda el token de acceso para autenticar tus solicitudes.

- Elige un modelo: selecciona entre modelos de texto, TTS, texto a imagen o ASR según tu caso de uso.

- Invoca la API: realiza una petición HTTP al endpoint del modelo con los parámetros de entrada y ajusta temperatura, longitud u opciones disponibles.

- Despliega un LLM propio (opcional): prepara tu modelo, aprovisiona GPUs dedicadas y expón un endpoint privado para producción.

- Monitorea y optimiza: revisa métricas de uso, latencia y coste para iterar sobre prompts y configuraciones.

Casos de uso de Deep Infra AI en la industria

En atención al cliente, potencia chatbots y asistentes con generación de texto de alta calidad. En comercio electrónico, crea descripciones de producto y genera imágenes de catálogo. En medios y entretenimiento, usa TTS para locuciones y ASR para subtitulado. En educación, construye tutores conversacionales y herramientas de estudio. En operaciones, transcribe reuniones, resume documentos y automatiza flujos de conocimiento con inferencia de baja latencia.

Modelo de precios de Deep Infra AI

Deep Infra AI opera con un modelo de pago por uso, facturando según el consumo de inferencia y/o los recursos de cómputo empleados. Para GPUs dedicadas y despliegues de LLMs personalizados, los costes se asocian al tiempo de uso de los recursos reservados. Pueden existir opciones de precios por volumen o empresariales bajo solicitud. Para detalles y actualizaciones, consulta la documentación oficial de la plataforma.

Ventajas y desventajas de Deep Infra AI

Ventajas:

- Baja latencia y rendimiento consistente en producción.

- Escalabilidad sin gestionar infraestructura propia de GPU.

- Pago por uso que ayuda a optimizar el coste total.

- Multimodalidad (texto, voz, imagen, habla) en una sola plataforma.

- Despliegue de LLMs propios en GPUs dedicadas con mayor control.

- Integración sencilla mediante API y flujos de CI/CD.

Desventajas:

- Dependencia de un tercero para disponibilidad y roadmap.

- Costes variables según tráfico y complejidad de los modelos.

- Límites de tasa o cuotas que pueden requerir ajuste de arquitectura.

- Latencia de red respecto a despliegues on-premise en entornos altamente sensibles.

- Personalización potencialmente menor que un stack completamente autogestionado.

Preguntas frecuentes sobre Deep Infra AI

-

¿Qué tipos de modelos puedo ejecutar con Deep Infra AI?

La plataforma admite modelos líderes para generación de texto, texto a voz, texto a imagen y reconocimiento automático del habla, además de LLMs personalizados en GPUs dedicadas.

-

¿Necesito gestionar servidores o clusters de GPU?

No. La infraestructura es administrada; puedes consumir los modelos vía API o aprovisionar GPUs dedicadas sin mantener hardware propio.

-

¿Puedo desplegar mi propio LLM?

Sí. Es posible cargar y ejecutar modelos personalizados en recursos dedicados, exponiendo un endpoint para pruebas o producción.

-

¿Cómo se controla el coste?

El pago por uso permite pagar solo por las peticiones y recursos consumidos. Se recomienda monitorizar métricas y ajustar parámetros para optimizar gasto y rendimiento.

-

¿Qué latencia puedo esperar?

La latencia varía según el modelo y la carga, pero la plataforma está optimizada para inferencia de baja latencia adecuada para casos de uso en tiempo real.