Deep Infra

ウェブサイトを開く-

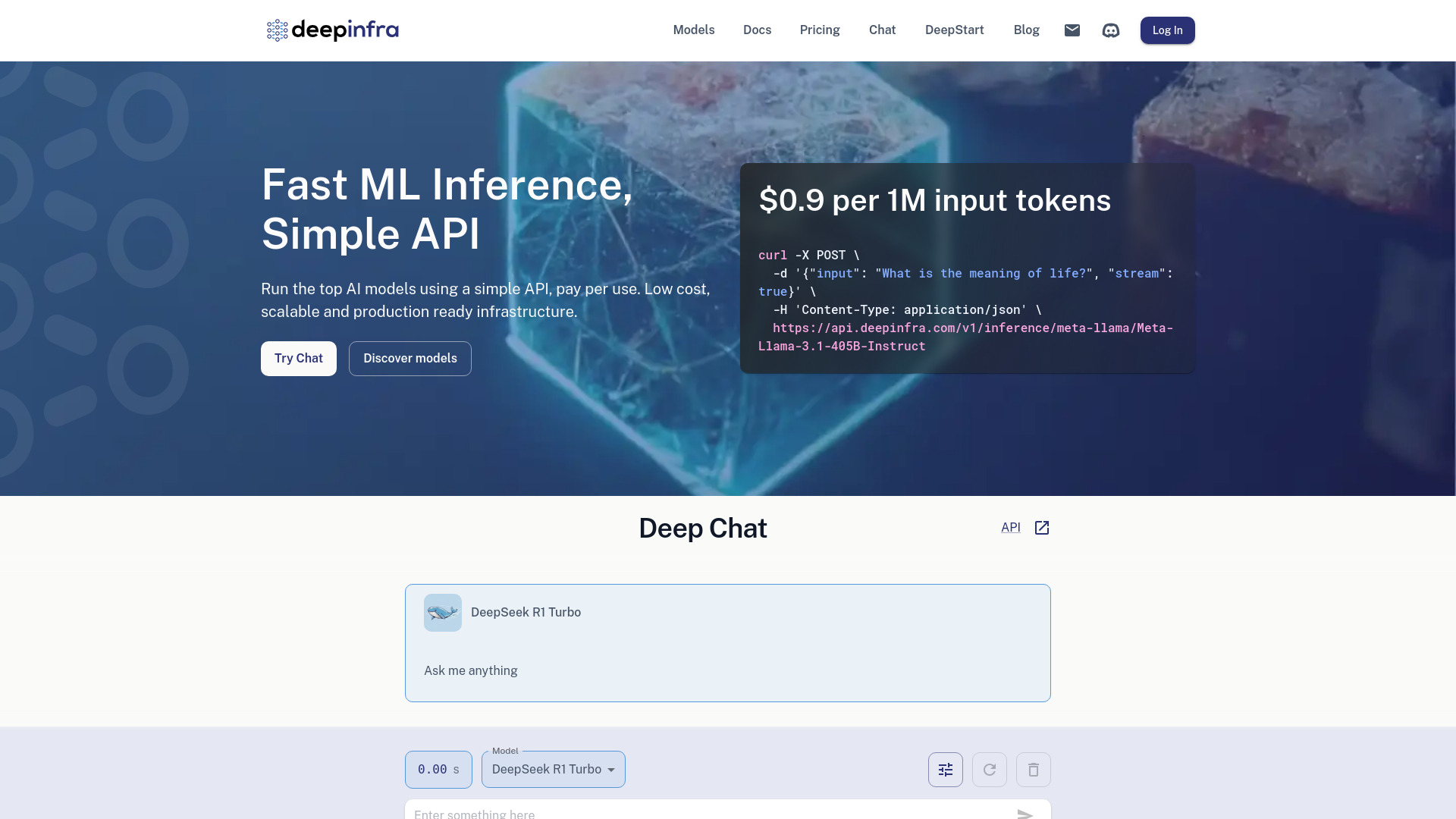

ツール紹介:シンプルなAPIで主要AIを実行。従量課金、低遅延、専用GPUでLLM運用。テキスト生成やTTS・画像生成・音声認識に対応。

-

登録日:2025-10-21

-

ソーシャルメディアとメール:

ツール情報

Deep Infra AIとは?

Deep Infra AIは、ディープラーニング向けの推論基盤と機械学習モデルを一体で提供するプラットフォームです。シンプルなAPIでトップクラスのAIモデルを即時に呼び出せるため、実装から本番運用までのハードルを大きく下げます。特徴は、低レイテンシな推論と従量課金によるコスト最適化、そして需要に応じて伸縮するスケーラブルなインフラ。テキスト生成、テキスト読み上げ(TTS)、テキストから画像生成、音声認識(ASR)など幅広いモデルにアクセスでき、用途に合わせて選択可能です。さらに、専用GPU上でのカスタムLLMデプロイにも対応し、プライベートな環境で高性能な推論を実現します。インフラ運用の負担を最小限に抑えつつ、プロトタイプから本番まで同じAPIで統一運用できる点が価値で、開発スピードと信頼性の両立を後押しします。

Deep Infra AIの主な機能

- シンプルなAPIで多様なAIモデル(テキスト生成、TTS、画像生成、ASR)を即時利用

- 低レイテンシ推論に最適化されたインフラで本番運用に耐える応答性能

- 従量課金の料金体系により初期費用を抑え、使用量に応じてコスト最適化

- 需要に合わせた自動スケーリングでピーク時も安定稼働

- 専用GPUでのカスタムLLMデプロイに対応し、プライベートかつ高性能な推論を実現

- テキストから画像、音声からテキストなど、複数モーダルのユースケースをカバー

- モデル選択・切替が容易で、要件に合う精度・速度・コストのバランスを取りやすい

- 開発者向けに統一されたリクエスト/レスポンス設計で実装負荷を軽減

Deep Infra AIの対象ユーザー

スケーラブルなAI推論を短期間で導入したいエンジニアリングチーム、生成AI機能を自社プロダクトに組み込みたいスタートアップからエンタープライズ、研究開発部門、PoCを素早く回したいプロダクトマネージャー、そしてインフラ運用コストを抑えたい機械学習エンジニアに適しています。テキスト生成による自動応答、TTS/ASRによる音声UX、画像生成によるクリエイティブ強化など、幅広い利用シーンで活用しやすい設計です。

Deep Infra AIの使い方

- アカウントを作成し、ダッシュボードからAPIキーを取得します。

- 目的(テキスト生成、TTS、画像生成、ASR)に合わせて利用するモデルを選定します。

- ドキュメントに沿ってHTTPリクエストを準備し、ヘッダーにAPIキーを設定します。

- プロンプトや音声/画像入力など必要なパラメータを指定してAPIを呼び出します。

- レスポンスで返る生成テキスト、音声データ、画像、または文字起こし結果を取得し、アプリに統合します。

- 本番運用ではタイムアウト、再試行、レート制御、ログ収集などの実装で信頼性を確保します。

- カスタムLLMを使う場合は、専用GPUを割り当ててモデルをデプロイし、プライベートエンドポイントから推論します。

Deep Infra AIの業界での活用事例

カスタマーサポートでは、テキスト生成モデルを用いたFAQ応答やチャットボットで応答時間を短縮。メディア・広告では、テキストから画像生成でクリエイティブ制作を高速化し、A/Bテストを効率化します。コンテンツ配信・エデュテックでは、TTSにより記事や教材を音声化し、アクセシビリティを向上。コールセンターやボイスアプリでは、ASRで通話内容を自動文字起こしし、要約・分析を自動化。プロダクト開発では、専用GPU上のカスタムLLMを用いて自社ドメイン知識を取り込んだ回答精度の高いアシスタントを本番運用できます。

Deep Infra AIの料金プラン

中心は従量課金で、利用した推論リソースやモデル呼び出し回数に応じて課金されます。用途に応じて、共有インフラによるサーバレス実行と、ワークロードを分離できる専用GPUの利用を選択できます。詳細な単価や割引、専用リソースの料金は、公式の価格情報での確認が推奨されます。

Deep Infra AIのメリットとデメリット

メリット:

- 低レイテンシ推論とスケーラブルな基盤で本番運用に適する

- 従量課金で初期費用を抑えつつ需要に応じてコスト最適化

- テキスト生成、TTS、画像生成、ASRなど複数モーダルを単一APIで扱える

- 専用GPUによりカスタムLLMをプライベートに高性能運用可能

- モデル切替が容易で要件に合わせた最適解を選びやすい

デメリット:

- 外部プラットフォームへの依存が発生し、ベンダーロックインの懸念がある

- 利用量増加時にコストが上振れしやすく、モニタリングとコスト管理が必須

- 厳格なデータガバナンス要件では、専用GPUなど環境分離の設計が前提になる

- カスタムモデル運用では、モデル最適化やリソース選定の知見が求められる

- 一部モデルの提供・性能は更新により変動する可能性がある

Deep Infra AIに関するよくある質問

-

質問:どのようなタスクに対応していますか?

テキスト生成、テキスト読み上げ(TTS)、テキストから画像生成、音声認識(ASR)など、主要な生成AI/推論タスクをカバーします。

-

質問:本番運用に向いていますか?

低レイテンシな推論基盤とスケーラブルなインフラを備えており、本番ワークロードでも利用しやすい設計です。

-

質問:カスタムLLMをデプロイできますか?

専用GPUを利用してカスタムLLMをデプロイし、プライベートなエンドポイントから推論できます。

-

質問:どのように統合すればよいですか?

APIキーを取得し、HTTPベースのAPIを通じてリクエストを送信します。用途に応じてモデルやパラメータを選択し、レスポンスをアプリケーションに組み込みます。

-

質問:料金はどのように計算されますか?

基本は従量課金で、使用した推論リソースに応じて課金されます。専用GPUの利用は別途料金体系となる場合があります。