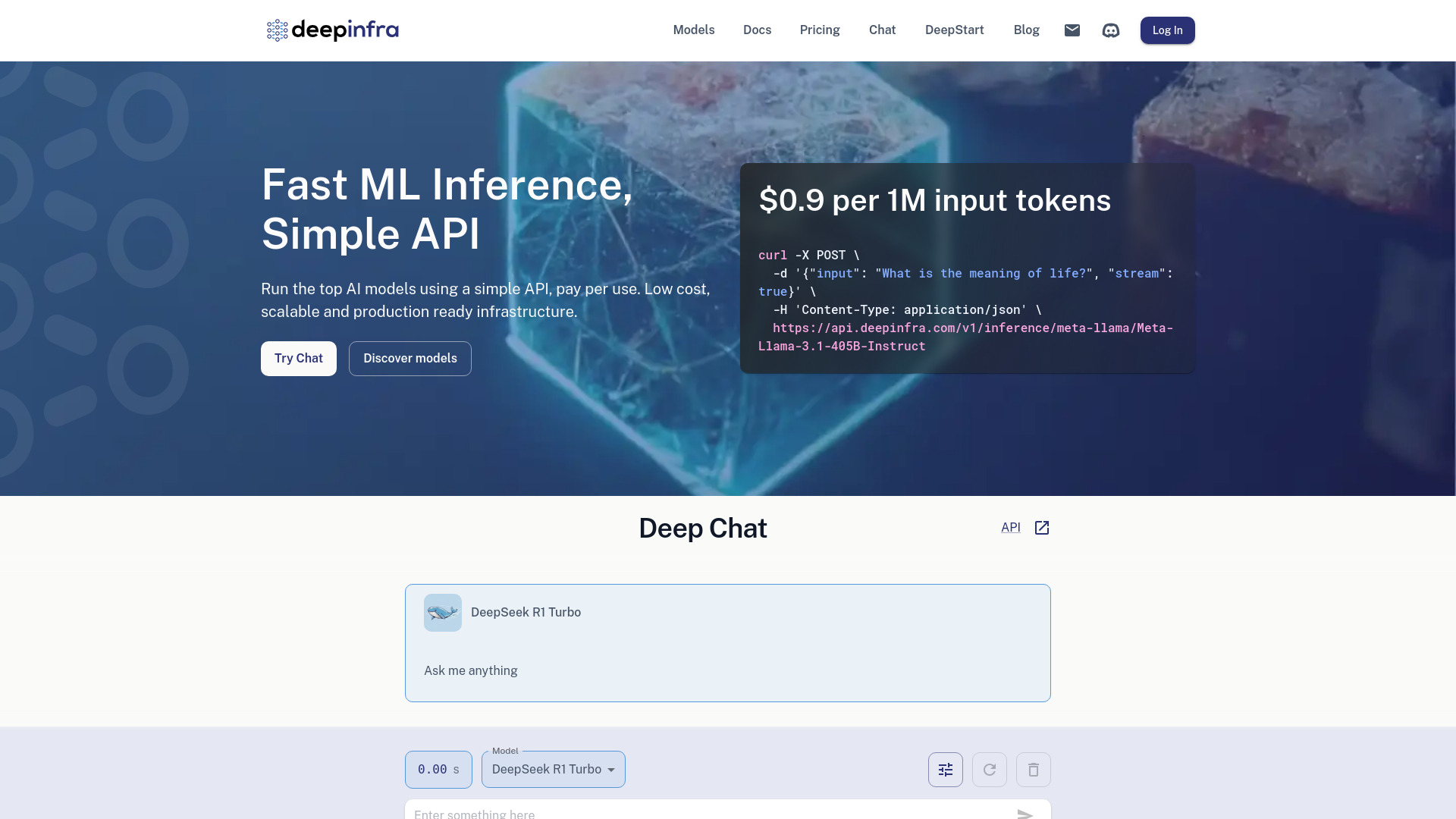

Deep Infra

打開網站-

工具介紹:以簡單API執行頂尖模型:按用量計費、低延遲。專用GPU可佈署自研LLM,涵蓋文字生成、語音合成與辨識、影像生成。

-

收錄時間:2025-10-21

-

社群媒體&信箱:

工具資訊

什麼是 Deep Infra AI

Deep Infra AI 是面向生產環境的雲端推理平台,提供具成本效益、可擴展且易於部署的深度學習模型與基礎設施。透過簡潔的 API,開發者可在同一平台上存取多種頂尖生成式與感知式模型,涵蓋文字生成、文字轉語音、文字轉影像與自動語音辨識等任務,並獲得低延遲的即時推理體驗。其核心價值在於以按量計費的方式,將模型托管、硬體調度與彈性伸縮抽象化,免去自建叢集與繁瑣維運;同時支援將自訂的大型語言模型部署至專用 GPU,以獲得資源隔離、穩定吞吐與可預測的效能。平台亦提供模型版本管理、參數調校、流式輸出與批次處理,並透過使用統計與日誌協助追蹤延遲、成功率與成本。對於需要快速從 PoC 擴展到大規模生產的團隊,Deep Infra AI 以標準化端點與良好觀測性加速整合,從共享資源平滑升級到專屬部署,讓團隊專注在產品與應用創新。

Deep Infra AI 主要功能

- 單一 API 聚合多模型:以一致的介面呼叫文字生成、TTS、T2I、ASR 等任務,降低整合成本。

- 低延遲推理:為互動式應用提供即時回應,支援流式輸出以縮短首字節時間。

- 按量計費:依實際使用量付費,無需前期硬體投入,便於成本控管。

- 專用 GPU 部署自訂 LLM:將自家模型上架至專屬資源,確保效能與隔離性。

- 彈性伸縮:自動調度運算資源,應對高併發與峰值流量。

- 模型版本與參數管理:支援版本切換、溫度、最大輸出長度等推理參數調校。

- 流式與批次模式:同時滿足即時互動與離線大批量處理需求。

- 監控與用量統計:提供延遲、成功率與成本指標,便於優化與預算管理。

- API 金鑰與配額控管:以金鑰驗證與速率限制保護服務穩定性與安全性。

Deep Infra AI 適用人群

適合需要快速上線與穩定擴展的團隊與個人,包括:希望以 API 快速整合模型的全端與後端工程師、需要可靠推理基礎設施的資料科學家與 MLOps 團隊、對成本敏感的初創公司、需要專用資源承載生產流量的企業級研發部門,以及構建聊天助理、語音助理、內容生成與多媒體應用的產品團隊。

Deep Infra AI 使用步驟

- 建立帳號並取得 API 金鑰,在環境變數中安全保存。

- 瀏覽模型目錄與文件,選擇任務類型與合適的模型版本。

- 設定請求參數(如溫度、最大輸出長度、語音/影像選項等,依模型而定)。

- 以 HTTP 請求呼叫推理端點,在開發環境驗證延遲、輸出品質與錯誤處理。

- 需要即時互動時啟用流式回傳;批量任務可規劃重試與併發策略。

- 監控用量、延遲與成功率,調整參數與併發上限以優化成本/效能。

- 若有穩定高負載或資料隔離需求,將自訂 LLM 部署至專用 GPU 並配置擴縮策略。

- 在 CI/CD 中管理金鑰與設定檔,完成灰度發布與生產環境監控。

Deep Infra AI 行業案例

客服與金融:以文字生成結合 ASR 與 TTS 打造智慧助理,支援多語查詢與交易引導。媒體與行銷:運用文字生成與文字轉影像快速產出腳本、標題與視覺素材。教育與培訓:以語音轉文字自動產出課程字幕,並生成練習題與講解。電商與零售:批量生成商品標題、描述與廣告文案,並提供搜尋與聊天導購。遊戲與娛樂:利用 LLM 設計動態任務與 NPC 對話,配合語音合成提升沉浸感。

Deep Infra AI 收費模式

採用按使用量計費,費用會依模型類別與運算資源而異,常見計價維度包含請求量、輸出長度或推理時間等。當部署自訂 LLM 至專用 GPU 時,資源以實際占用時段計費,有助於在穩定負載下取得可預測成本。平台通常提供用量統計與預算控管功能,方便設定上限與預警以避免超支。具體費率與折扣以官方公佈為準。

Deep Infra AI 優點和缺點

優點:

- 低延遲推理與彈性伸縮,適合互動式與生產級工作負載。

- 按量計費與集中化管理,降低自建與維運成本。

- 支援文字、語音與影像等多任務,一站式整合。

- 可將自訂 LLM 部署於專用 GPU,兼顧效能與資源隔離。

- 流式與批次處理並行,滿足多元應用場景。

- 提供使用統計與日誌,便於優化與治理。

缺點:

- 對雲端供應商的依賴可能帶來遷移與鎖定風險。

- 跨區存取可能增加網路延遲,需要部署策略規劃。

- 成本會隨流量與模型規模波動,需持續優化參數與併發。

- API 速率限制與配額可能影響尖峰時段的吞吐。

- 相較自建環境,對部分模型底層細節的可控度較低。

Deep Infra AI 熱門問題

-

問題 1: 支援哪些任務與模型類型?

平台涵蓋文字生成、文字轉語音、文字轉影像與自動語音辨識等常見任務,並聚合多款頂尖模型以供選擇。

-

問題 2: 能否部署自訂的大型語言模型?

可以,支援將自訂 LLM 部署至專用 GPU,以獲得隔離資源與可預測效能;具體上傳格式與設定需依官方文件準備。

-

問題 3: 是否支援流式回傳以提升互動體驗?

支援流式輸出,可在產生過程分段傳回結果,降低首字節延遲,適用於聊天與即時應用。

-

問題 4: 計費如何估算與控管?

費用通常與請求量、輸出長度或推理時間相關,且依模型與資源不同而異。建議設定用量上限與預算警示,並定期檢視用量報表。

-

問題 5: 如何最佳化延遲與穩定性?

使用流式回傳、重用連線、調整併發與重試策略,並選擇合適的模型與資源配額;對穩定高負載場景可考慮專用 GPU。

-

問題 6: 資料傳輸是否安全?

以 API 金鑰進行身份驗證並透過加密通道傳輸;建議在應用端實施金鑰保護與最小權限管理。