- Trang chủ

- Trình tạo văn bản AI

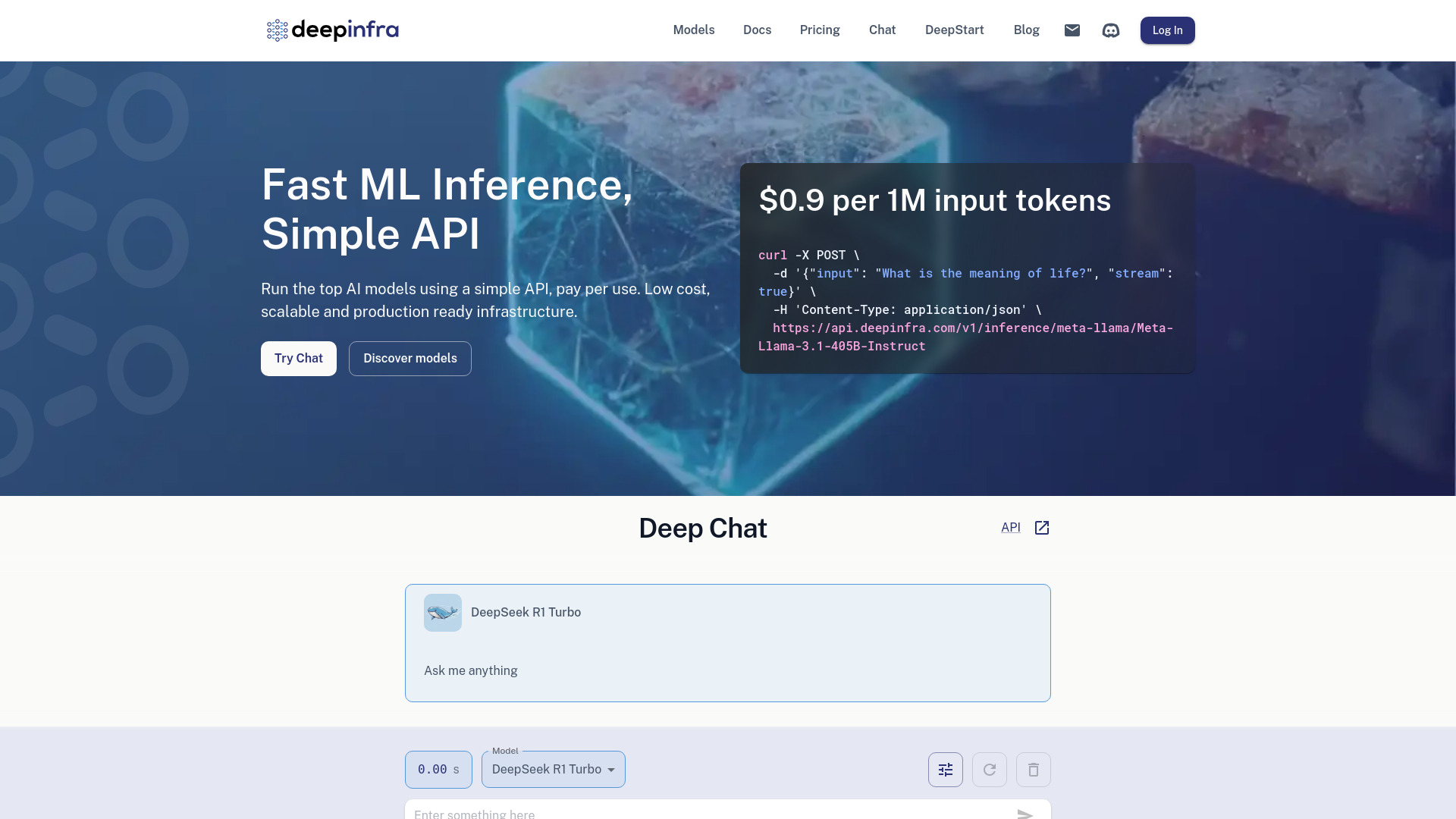

- Deep Infra

Deep Infra

Mở trang web-

Giới thiệu công cụ:Chạy AI qua API đơn giản: trả theo dùng, độ trễ thấp, LLM riêng trên GPU.

-

Ngày thêm:2025-10-21

-

Mạng xã hội & Email:

Thông tin công cụ

Deep Infra AI là gì?

Deep Infra AI là nền tảng hạ tầng AI-as-a-Service giúp doanh nghiệp và nhà phát triển chạy các mô hình học sâu hàng đầu thông qua API đơn giản, với độ trễ thấp và khả năng mở rộng linh hoạt. Công cụ tập trung vào triển khai mô hình sẵn sàng cho sản xuất, tối ưu chi phí theo mức sử dụng, phù hợp cho cả thử nghiệm nhanh lẫn khối lượng truy cập lớn. Người dùng có thể truy cập đa dạng mô hình cho tạo văn bản (LLM), chuyển văn bản thành giọng nói (TTS), tạo ảnh từ văn bản (text-to-image) và nhận dạng giọng nói tự động (ASR), đồng thời triển khai LLM tùy chỉnh trên GPU chuyên dụng để đảm bảo hiệu năng ổn định.

Các tính năng chính của Deep Infra AI

- API đơn giản, dễ tích hợp: Gửi yêu cầu suy luận chỉ với vài dòng code, hỗ trợ thông số linh hoạt cho LLM, TTS, ASR và tạo ảnh.

- Độ trễ thấp, tự động mở rộng: Hệ thống tối ưu hạ tầng giúp phản hồi nhanh, tự scale theo tải thực tế.

- Trả tiền theo mức sử dụng: Tối ưu chi phí theo token, thời lượng âm thanh hoặc lượt suy luận; có tùy chọn GPU chuyên dụng.

- Triển khai LLM tùy chỉnh: Chạy mô hình riêng trên GPU dành riêng để đảm bảo hiệu năng, kiểm soát thông số và tính ổn định.

- Kho mô hình đa dạng: Hỗ trợ các tác vụ sinh văn bản, tóm tắt, đối thoại, tổng hợp giọng nói, chuyển giọng, nhận dạng tiếng nói và tạo ảnh.

- Streaming và batch: Lấy kết quả theo luồng cho ứng dụng thời gian thực hoặc xử lý lô khối lượng lớn.

- Giám sát và nhật ký: Theo dõi sử dụng, thông số và hiệu năng để tối ưu chi phí và chất lượng đầu ra.

Đối tượng phù hợp với Deep Infra AI

Deep Infra AI phù hợp với startup, đội ngũ sản phẩm, kỹ sư phần mềm, data scientist và ML engineer muốn tích hợp nhanh tính năng AI vào ứng dụng mà không phải tự vận hành hạ tầng. Các doanh nghiệp cần chatbot, trợ lý ảo, tổng hợp giọng nói, chuyển giọng nói thành văn bản, hay tạo nội dung hình ảnh cũng hưởng lợi nhờ chi phí linh hoạt và độ trễ thấp. Đặc biệt hữu ích khi cần POC nhanh, chạy thử mô hình mới hoặc vận hành ổn định ở môi trường sản xuất.

Cách sử dụng Deep Infra AI

- Đăng ký tài khoản và tạo API key trong bảng điều khiển.

- Chọn mô hình phù hợp (LLM, TTS, ASR, text-to-image) và đọc hướng dẫn tham số.

- Tích hợp API vào ứng dụng (REST/HTTP), cấu hình tham số như temperature, max tokens, tốc độ nói, ngôn ngữ…

- Kiểm thử với dữ liệu mẫu, bật streaming nếu cần phản hồi thời gian thực.

- Giám sát log và chỉ số sử dụng để tối ưu chi phí và chất lượng.

- Khi lưu lượng tăng, chuyển sang endpoint GPU chuyên dụng hoặc triển khai LLM tùy chỉnh.

- Thiết lập kiểm soát lỗi, retry và giới hạn tốc độ để đảm bảo độ tin cậy.

Trường hợp ứng dụng thực tế của Deep Infra AI

Doanh nghiệp thương mại điện tử dùng LLM để tư vấn mua sắm và tóm tắt đánh giá sản phẩm; trung tâm liên hệ dùng ASR để chuyển lời nói thành văn bản và TTS để phản hồi tự động; nền tảng nội dung dùng tạo ảnh từ văn bản cho banner, thumbnail; ứng dụng học tập dùng TTS đa giọng để tạo bài giảng; công cụ năng suất tích hợp tóm tắt tài liệu, viết email, tạo báo cáo; sản phẩm di động kích hoạt chat AI streaming với độ trễ thấp.

Gói cước và mô hình giá của Deep Infra AI

Deep Infra AI áp dụng mô hình tính phí theo mức sử dụng, thường dựa trên số token sinh/nhận (LLM), thời lượng âm thanh xử lý (ASR/TTS) hoặc số lượt/tài nguyên cho tạo ảnh. Với nhu cầu ổn định và hiệu năng cao, người dùng có thể chọn endpoint GPU chuyên dụng tính phí theo thời gian sử dụng. Mô hình giá linh hoạt giúp bắt đầu nhanh mà không cần đầu tư hạ tầng trước, đồng thời hỗ trợ mở rộng khi lưu lượng tăng.

Ưu điểm và nhược điểm của Deep Infra AI

Ưu điểm:

- Độ trễ thấp, triển khai nhanh, sẵn sàng cho môi trường sản xuất.

- Chi phí linh hoạt theo mức sử dụng, dễ kiểm soát ngân sách.

- Hỗ trợ nhiều tác vụ: LLM, TTS, ASR, tạo ảnh trên cùng một nền tảng.

- Khả năng mở rộng tự động và tùy chọn GPU chuyên dụng cho mô hình riêng.

- API đơn giản, hỗ trợ streaming và giám sát sử dụng.

Nhược điểm:

- Phụ thuộc kết nối mạng và hạ tầng đám mây, có thể phát sinh độ trễ theo vùng.

- Chi phí có thể tăng nhanh với khối lượng suy luận lớn nếu không tối ưu.

- Mức độ tùy biến hạ tầng hạn chế hơn so với tự vận hành toàn bộ stack.

- Cần tuân thủ chính sách dữ liệu của nền tảng khi xử lý thông tin nhạy cảm.

Các câu hỏi thường gặp về Deep Infra AI

-

Câu hỏi: Deep Infra AI hỗ trợ những loại mô hình nào?

Trả lời: Nền tảng hỗ trợ mô hình tạo văn bản (LLM), chuyển văn bản thành giọng nói (TTS), nhận dạng giọng nói (ASR) và tạo ảnh từ văn bản.

-

Câu hỏi: Tôi có thể triển khai LLM tùy chỉnh không?

Trả lời: Có. Bạn có thể triển khai mô hình tùy chỉnh trên GPU chuyên dụng để đảm bảo hiệu năng và kiểm soát cấu hình.

-

Câu hỏi: Mô hình giá được tính như thế nào?

Trả lời: Tính phí theo mức sử dụng, thường dựa trên token (LLM), thời lượng âm thanh (ASR/TTS) hoặc lượt/tài nguyên cho tạo ảnh; GPU chuyên dụng tính theo thời gian.

-

Câu hỏi: Có hỗ trợ phản hồi theo luồng (streaming) không?

Trả lời: Có. Streaming giúp ứng dụng chat và thời gian thực nhận kết quả nhanh, cải thiện trải nghiệm người dùng.

-

Câu hỏi: Làm sao để tối ưu chi phí khi lưu lượng tăng?

Trả lời: Sử dụng tham số phù hợp (max tokens, nbest, sampling), bật streaming, gộp request theo batch khi khả thi và theo dõi bảng điều khiển để tối ưu.

-

Câu hỏi: Dữ liệu suy luận có được lưu trữ không?

Trả lời: Việc xử lý và lưu trữ tuân theo chính sách của nền tảng. Bạn nên xem tài liệu và bật các tùy chọn bảo mật/phân quyền phù hợp với yêu cầu tuân thủ.