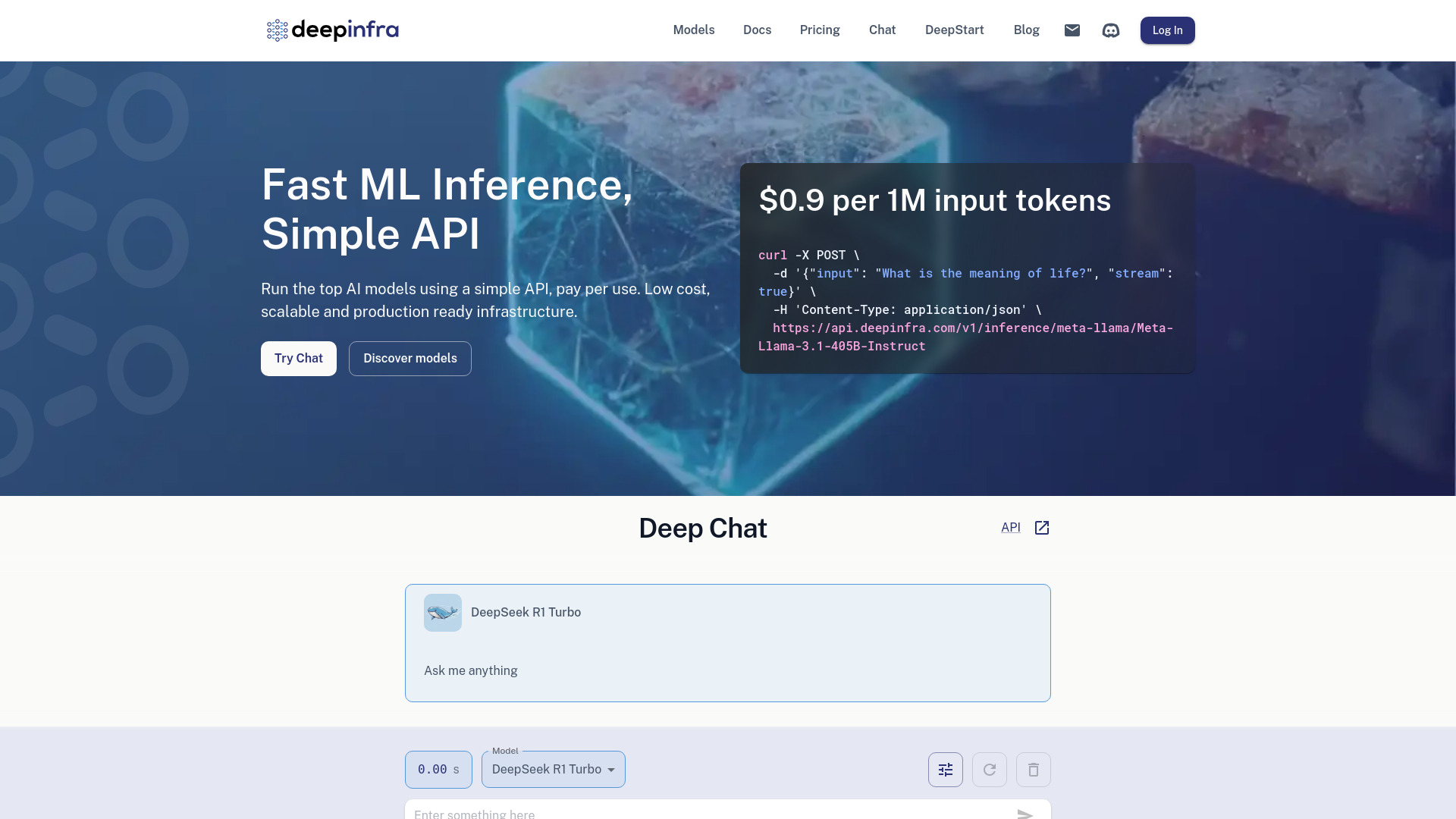

Deep Infra

打开网站-

工具介绍:用简单API运行主流AI:按量计费、低延迟。专用GPU部署自定义LLM,支持文本生成、语音合成与识别、图像生成。

-

收录时间:2025-10-21

-

社交媒体&邮箱:

工具信息

什么是 Deep Infra AI

Deep Infra AI 是面向开发者与企业的云端推理平台,提供成本友好、可扩展、易部署且可直接用于生产环境的深度学习基础设施。通过统一且简单的 API,用户可在同一平台上调用主流 AI 模型,覆盖大语言模型文本生成、文本转语音(TTS)、文本生成图像(TTI)与自动语音识别(ASR)等多种任务。平台强调低延迟在线推理与弹性扩容,既可快速验证原型,也能稳定承载生产流量。用户可将自定义 LLM 部署到专用 GPU 上,获得独享算力与更可控的性能,或直接选用平台提供的热门模型快速集成,缩短研发周期。配合按量计费、基本监控与调用配额管理,团队可在保证服务质量的同时优化成本结构,加速从开发到上线的全流程。

Deep Infra AI主要功能

- 统一 API 调用主流模型:一处接入,覆盖文本生成、语音合成、图片生成与语音识别等常见任务,降低多模型集成成本。

- 低延迟推理与弹性扩容:为交互式应用优化响应时间,并随业务峰谷自动伸缩,提高可用性与稳定性。

- 专用 GPU 部署自定义 LLM:支持将自研或微调后的大语言模型部署到独享算力,获得更稳定的性能与隔离性。

- 多模型目录与版本管理:可在多种开源与商用模型间快速切换,便于 A/B 测试与持续优化。

- 按量计费与成本可视化:基于调用量与推理时长付费,结合基础监控与配额控制,便于成本核算与预算管理。

- 生产级运行特性:面向线上环境的可观测性、速率限制与队列管理,帮助保障服务质量。

- 简化集成与上线:通过标准化接口减少基础设施运维负担,缩短从原型到生产的交付周期。

Deep Infra AI适用人群

适合需要快速构建与上线 AI 功能的团队与个人:如打造智能客服、内容生成、语音助手、语音转写、图像生成等场景的开发者与初创企业;在多产品线中验证与部署生成式 AI 能力的中大型企业;关注交付效率、希望以较低门槛使用主流模型并控制基础设施成本的产品经理、数据科学家与机器学习工程师。

Deep Infra AI使用步骤

- 创建账户并完成基础设置,获取用于调用的 API 密钥与访问凭据。

- 在模型目录中选择所需任务(如文本生成、TTS、TTI、ASR)及合适的模型与参数。

- 根据业务需求配置推理选项(如温度、最大输出长度、采样策略或语音/图像相关参数)。

- 将 API 集成到后端服务或应用中,设置重试、超时与并发策略,确保稳定性与可控成本。

- 如需更高与更稳性能,部署自定义 LLM 至专用 GPU,进行负载与资源配额调整。

- 通过监控与日志观察延迟、吞吐与错误率,结合配额与限流优化服务质量与成本。

- 在灰度/分阶段上线中进行 A/B 测试,持续迭代提示词、模型与参数配置。

Deep Infra AI行业案例

电商与客服:以大语言模型构建多轮对话助手,结合 FAQ 与订单信息,提供低延迟咨询回复。媒体与内容:用文本生成与语音合成批量制作产品描述、脚本与播报音频,提升内容生产效率。教育培训:将语音识别用于课堂转写与字幕生成,并用 TTS 输出多语音风格的教学音频。游戏与创意:通过文本生成图像快速产出原画草图与概念设计,配合 LLM 完成剧情与文案迭代。运营与生产力:在内部工具中集成摘要、改写与信息抽取,压缩人工处理时间。

Deep Infra AI收费模式

采用按使用量计费的方式,常见维度包含模型推理调用量与资源占用时长;对于专用 GPU 部署,自定义模型可按需分配独享算力并据实计费。支持基于实际消耗的结算策略,便于按项目或产品线进行成本核算与预算控制。具体价格与优惠政策以官方公布为准。

Deep Infra AI优点和缺点

优点:

- 统一 API 调用多任务与多模型,集成门槛低,缩短交付周期。

- 低延迟与弹性扩容,更适合交互式与生产级负载。

- 支持专用 GPU 部署自定义 LLM,性能与隔离性更可控。

- 按量计费与基础监控,便于精细化成本管理与容量规划。

- 可在模型间快速切换与对比,便于持续优化与 A/B 测试。

缺点:

- 对云端网络与服务可用性存在依赖,离线或边缘场景适配度有限。

- 深度定制受 API 形态与上游模型能力约束,个别需求可能需要自建方案。

- 成本随流量与调用复杂度波动,需结合限流与缓存策略控制峰值开销。

- 数据合规与隐私需按行业要求评估与配置,涉及敏感数据时需审慎处理。

Deep Infra AI热门问题

问题 1: 能否部署自定义大语言模型?

可以,将自研或微调后的 LLM 部署到专用 GPU 上运行,以获得更稳定的性能与资源隔离。

问题 2: 支持哪些常见任务?

覆盖文本生成、文本转语音(TTS)、文本生成图像(TTI)与自动语音识别(ASR)等主流生成式 AI 任务。

问题 3: 如何降低延迟并提升吞吐?

合理设置并发与批处理、使用专用 GPU、优化请求参数与响应长度,并结合限流与重试策略提升稳定性。

问题 4: 费用如何控制?

启用配额与速率限制,监控调用量与时长;对高并发或长输出场景使用专用 GPU 并结合缓存与截断策略。

问题 5: 数据安全如何保障?

通过访问密钥管理、最小化数据传输与保留、权限分级与日志审计等方式降低风险,敏感数据应按合规要求处理。