- Home

- Gerador de Texto AI

- Deep Infra

Deep Infra

Abrir Site-

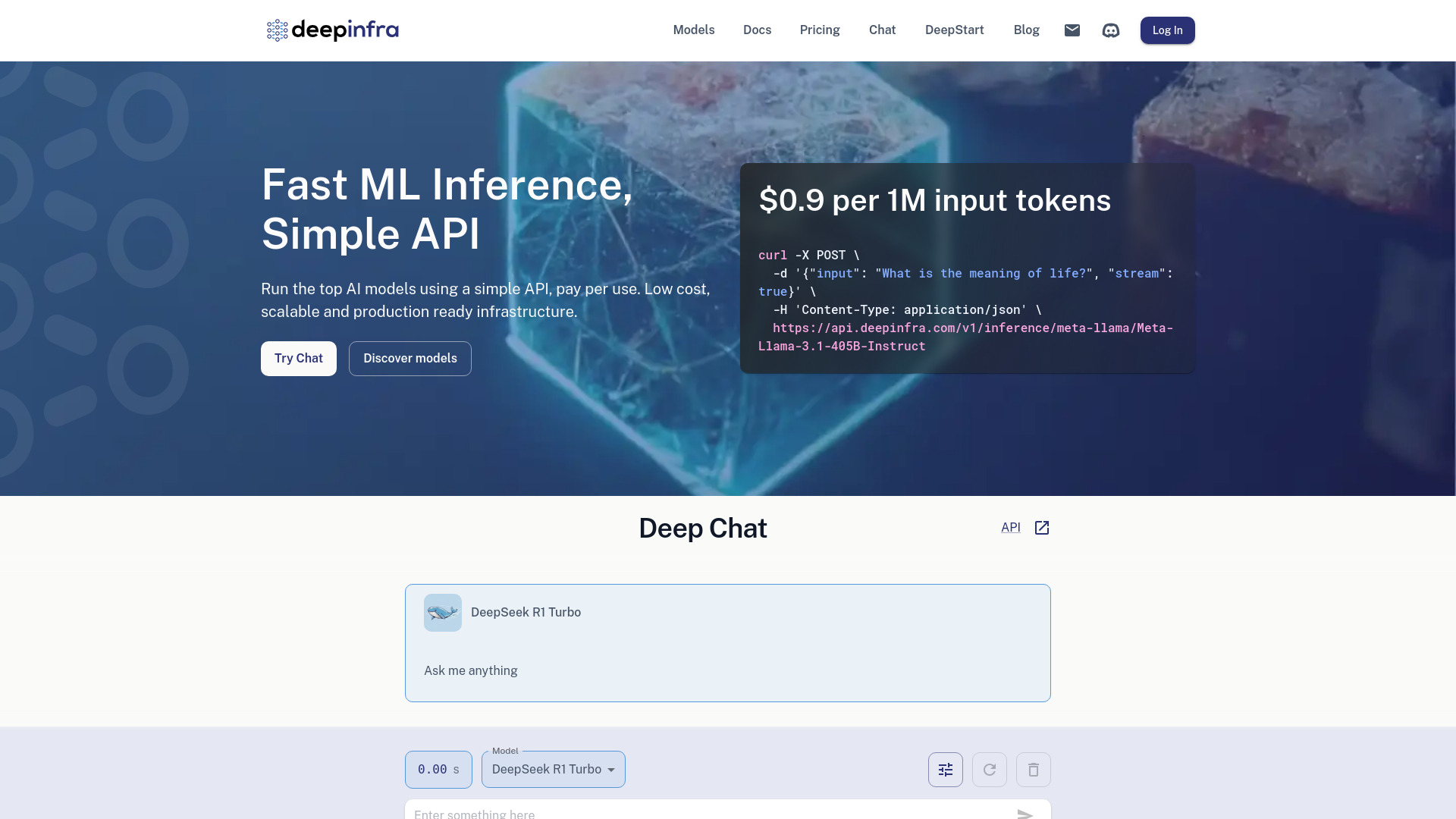

Ferramenta Introdução:IA via API simples: cobrança por uso, baixa latência, LLMs em GPU.

-

Data de Inclusão:2025-10-21

-

Social Media e E-mail:

Informações da ferramenta

O que é Deep Infra AI

Deep Infra AI é uma plataforma de infraestrutura de IA que disponibiliza modelos de ponta prontos para produção com inferência de baixa latência. Por meio de uma API simples, é possível executar geração de texto, texto para fala (TTS), texto para imagem e reconhecimento automático de fala (ASR) sem gerenciar servidores. Focada em custo-benefício e escalabilidade, adota cobrança por uso. Para demandas dedicadas, permite implantar LLMs personalizados em GPUs exclusivas, garantindo performance consistente e maior controle de recursos — ideal para levar modelos de deep learning do protótipo à produção com rapidez.

Principais funcionalidades de Deep Infra AI

- Catálogo de modelos líderes: acesso a modelos populares para geração de texto, texto para fala, texto para imagem e ASR.

- API unificada e fácil de integrar: padroniza chamadas para diferentes modelos e tarefas, acelerando o desenvolvimento.

- Inferência de baixa latência: respostas rápidas adequadas a aplicações em tempo real.

- Implantação de LLMs personalizados: execução em GPUs dedicadas para workloads exclusivos e desempenho previsível.

- Escalabilidade pronta para produção: infraestrutura gerenciada que acompanha picos de demanda sem esforço operacional.

- Modelo pay-per-use: paga somente pelo consumo, sem necessidade de manter servidores ociosos.

- Ambiente focado em produção: simplifica o caminho entre protótipo e operação com endpoints estáveis.

Para quem é Deep Infra AI

Indicada para desenvolvedores, equipes de produto e engenharia de ML que desejam integrar IA generativa e de fala via API, além de startups e PMEs que buscam escalar sem investir em infraestrutura própria. Útil para empresas de software, e-commerce, mídia, educação e atendimento ao cliente que precisam de inferência de baixa latência, cobrança por uso e a opção de implantar LLMs personalizados em GPUs dedicadas.

Como usar Deep Infra AI

- Crie uma conta na plataforma e gere sua chave de API.

- Escolha o modelo conforme a tarefa (texto, TTS, texto para imagem ou ASR).

- Configure o endpoint e parâmetros (por exemplo, prompt, temperatura, idioma, formato de saída).

- Envie requisições HTTP à API com sua chave e o payload da tarefa.

- Trate a resposta (texto gerado, áudio sintetizado, imagem criada ou transcrição) e integre no app.

- Para LLMs personalizados: prepare o modelo e dependências e solicite a implantação em GPU dedicada.

- Monitore uso e custos e ajuste parâmetros para otimizar latência e qualidade.

Casos de uso de Deep Infra AI no setor

No atendimento ao cliente, chatbots e voicebots combinam geração de texto, ASR e TTS para suporte em tempo real. Em marketing, criação de copys e imagens para campanhas. Em mídia e entretenimento, dublagem com TTS e geração de assets visuais. No e-commerce, descrição de produtos e busca conversacional. Em educação, transcrição de aulas e síntese de conteúdo. Em produtos SaaS, assistentes dentro do aplicativo com inferência de baixa latência. Em operações, resumos de reuniões e análise de chamadas.

Modelo de preços de Deep Infra AI

A plataforma adota cobrança por uso (pay-as-you-go), em que você paga somente pelos recursos de inferência consumidos. Não é necessário provisionar servidores, e a escala acompanha a demanda. A implantação de LLMs em GPUs dedicadas segue um custo associado aos recursos reservados. Para valores e faixas de consumo, consulte a página oficial de preços da ferramenta.

Vantagens e desvantagens de Deep Infra AI

Vantagens:

- Baixa latência adequada a aplicações em tempo real.

- Pay-per-use com foco em custo-benefício e sem gestão de servidores.

- API simples e unificada para múltiplas tarefas de IA.

- Implantação de LLMs personalizados em GPUs dedicadas para workloads exclusivos.

- Pronto para produção, acelerando o time-to-market.

- Variedade de modelos para texto, voz, imagem e fala.

Desvantagens:

- Custo variável pode se tornar imprevisível em alto volume.

- Dependência de provedor e possíveis limites de uso da API.

- Curva de integração para quem não está habituado a consumo de APIs de IA.

- Disponibilidade de modelos e regiões pode variar conforme a plataforma.

- Personalizações avançadas podem exigir suporte adicional.

Perguntas frequentes sobre Deep Infra AI

-

Quais tarefas a plataforma suporta?

Geração de texto, texto para fala (TTS), texto para imagem e reconhecimento automático de fala (ASR), acessíveis via API.

-

Posso implantar meu próprio LLM?

Sim. É possível implantar LLMs personalizados em GPUs dedicadas, fornecendo os artefatos e configurações necessárias conforme a documentação.

-

Como é a latência das requisições?

A plataforma é projetada para baixa latência, variando de acordo com o modelo escolhido e a carga de trabalho.

-

Qual é o modelo de cobrança?

Pay-per-use: paga-se apenas pelo consumo de inferência; GPUs dedicadas têm custo associado aos recursos reservados.

-

Como integro no meu aplicativo?

Por meio de chamadas HTTP à API da plataforma, usando sua chave de API e os parâmetros do modelo escolhido.

-

Como os dados são tratados?

As práticas de privacidade e retenção dependem da configuração e do modelo. Consulte a política oficial da plataforma para detalhes.