- Accueil

- Outils pour développeurs AI

- Confident AI

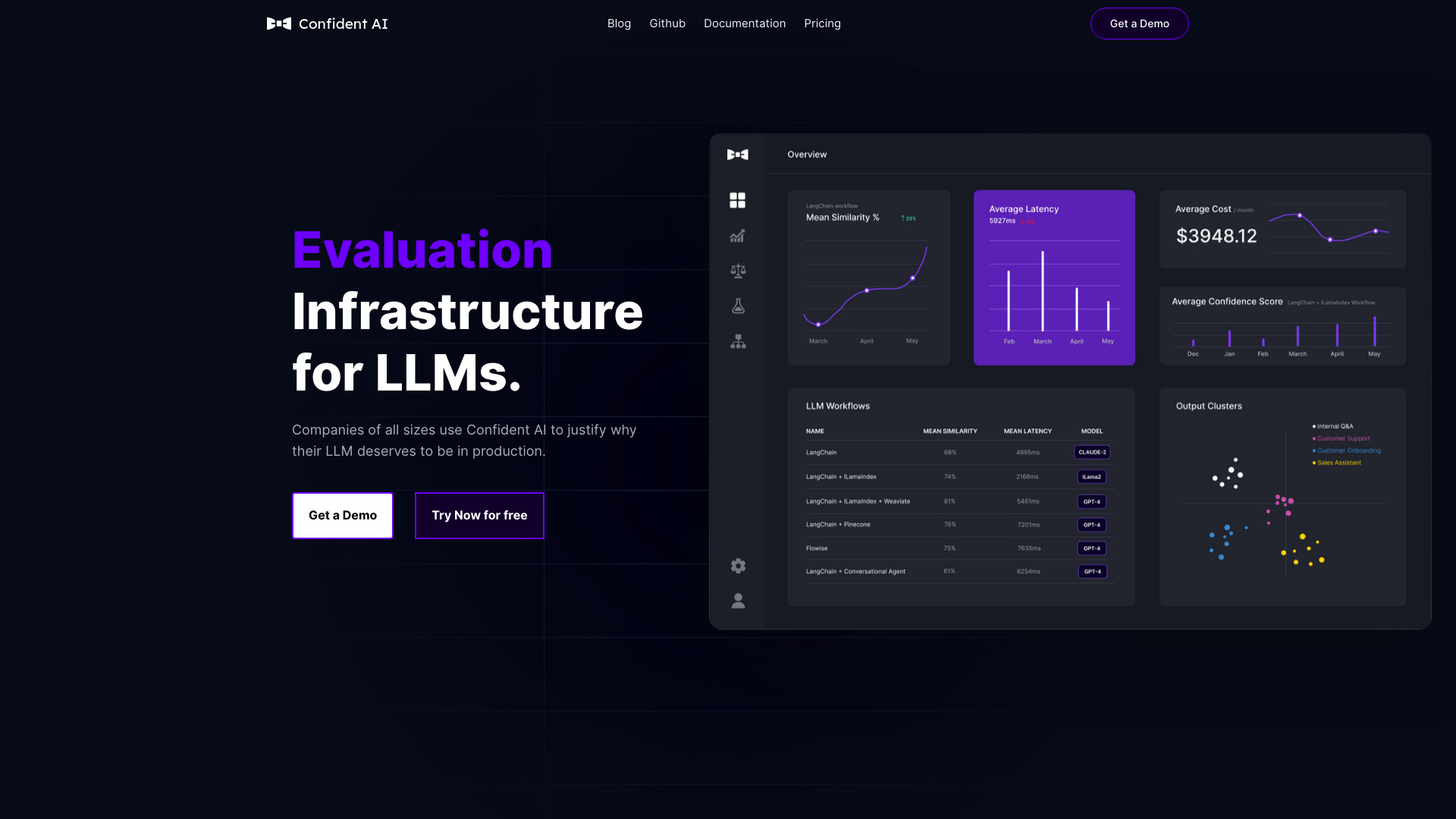

Confident AI

Site web ouvert-

Présentation de l'outil:Plateforme d’évaluation LLM: 14+ métriques, traçage et jeux de données.

-

Date d'inclusion:2025-11-06

-

Réseaux sociaux et e-mails:

Informations sur l'outil

Qu’est-ce que Confident AI

Confident AI est une plateforme tout-en-un d’évaluation de LLM (modèles de langage) créée par les auteurs de DeepEval. Elle centralise l’exécution d’expériences, la gestion de jeux de données, le suivi de performances et l’intégration de retours humains afin d’améliorer automatiquement les applications basées sur des LLM. Avec plus de 14 métriques et un traçage précis, Confident AI aide les équipes à comparer, sécuriser et optimiser leurs systèmes, en alignant métriques et données pour gagner du temps, réduire les coûts d’inférence et démontrer les progrès aux parties prenantes.

Fonctionnalités principales de Confident AI

- Évaluation multi-métriques : plus de 14 métriques prêtes à l’emploi pour mesurer la qualité et la performance des sorties LLM.

- Expérimentation structurée : conception et exécution d’expériences pour comparer prompts, modèles et paramètres.

- Gestion et curation de jeux de données : création, organisation et enrichissement de jeux de test pertinents.

- Traçage de bout en bout : visibilité détaillée sur chaque étape pour diagnostiquer erreurs, dérives et régressions.

- Intégration du retour humain : collecte et prise en compte d’avis humains pour affiner et automatiser les améliorations.

- Monitoring continu : suivi de la performance dans le temps pour détecter les dégradations et agir vite.

- Automatisation des tests : tests de régression et validations automatiques alignés sur des métriques explicites.

- Compatibilité avec DeepEval : fonctionnement fluide avec le framework open source DeepEval pour les évaluations.

- Approche guidée : bonnes pratiques intégrées pour aligner métriques, données et objectifs métier.

- Réduction des coûts : optimisation des choix de modèles et des paramètres pour diminuer les coûts d’inférence.

À qui s’adresse Confident AI

Confident AI s’adresse aux équipes techniques qui conçoivent, évaluent et opèrent des applications fondées sur des LLM : équipes d’ingénierie et de développement, responsables qualité des systèmes IA, data/ML practitioners et chefs de produit impliqués dans la fiabilité des fonctionnalités IA. Il convient aux organisations cherchant à comparer des approches, mettre des garde-fous, améliorer la performance et apporter des preuves mesurables aux parties prenantes.

Comment utiliser Confident AI

- Définir les objectifs d’évaluation et sélectionner les métriques pertinentes.

- Constituer ou importer des jeux de données représentatifs des cas d’usage ciblés.

- Instrumenter l’application et activer le traçage pour capturer entrées, sorties et métadonnées.

- Configurer les expériences (prompts, modèles, paramètres) et lancer les runs.

- Analyser les résultats par métrique, explorer les traces et identifier les régressions.

- Intégrer le retour humain pour affiner les critères et automatiser les améliorations.

- Mettre en place le monitoring continu et les tests de régression pour prévenir les dérives.

Cas d’utilisation de Confident AI

Exemples concrets : amélioration d’un assistant client en comparant prompts et modèles sur des métriques standardisées ; évaluation d’un système de recherche augmentée par la génération (RAG) et détection de régressions ; validation de la qualité de résumés ou de classifications avant mise en production ; mise en place de garde-fous pour limiter des réponses indésirables ; optimisation des coûts d’inférence par sélection de modèles et réglages fondés sur des données mesurées.

Avantages et inconvénients de Confident AI

Avantages :

- Plateforme intégrée d’évaluation, d’expérimentation et de traçage.

- Plus de 14 métriques pour des comparaisons fiables et reproductibles.

- Curation et alignement des jeux de données avec les objectifs métier.

- Intégration du retour humain pour des améliorations ciblées et automatisées.

- Automatisation des tests de régression et monitoring continu.

- Gains de temps, baisse des coûts d’inférence et preuves claires des progrès.

Inconvénients :

- Nécessite une instrumentation initiale et la préparation de jeux de données de qualité.

- Courbe d’apprentissage pour définir des métriques adaptées aux cas d’usage.

- La qualité des résultats dépend du retour humain et de la représentativité des données.

- L’intégration dans les processus de livraison peut demander un effort de mise en place.

Questions fréquentes sur Confident AI

-

Confident AI fonctionne-t-il avec DeepEval ?

Oui. Conçu par les créateurs de DeepEval, l’outil fonctionne avec le framework open source pour configurer des évaluations, exécuter des expériences et exploiter le traçage.

-

Combien de métriques sont disponibles ?

Confident AI propose plus de 14 métriques pour mesurer la performance et la qualité des applications basées sur des LLM.

-

Puis-je intégrer du retour humain dans l’évaluation ?

Oui. La plateforme permet d’intégrer des retours humains et d’utiliser ces évaluations pour guider et automatiser les améliorations.

-

Convient-il à tout type de cas d’usage LLM ?

Oui. La plateforme est conçue pour s’adapter à tout cas d’usage impliquant des LLM, de l’expérimentation initiale au monitoring en production.

-

Peut-on automatiser des tests de régression ?

Oui. Confident AI permet de définir des tests alignés sur des métriques et de surveiller les régressions via le traçage et le suivi de performance.