- Trang chủ

- Công cụ Phát triển AI

- Confident AI

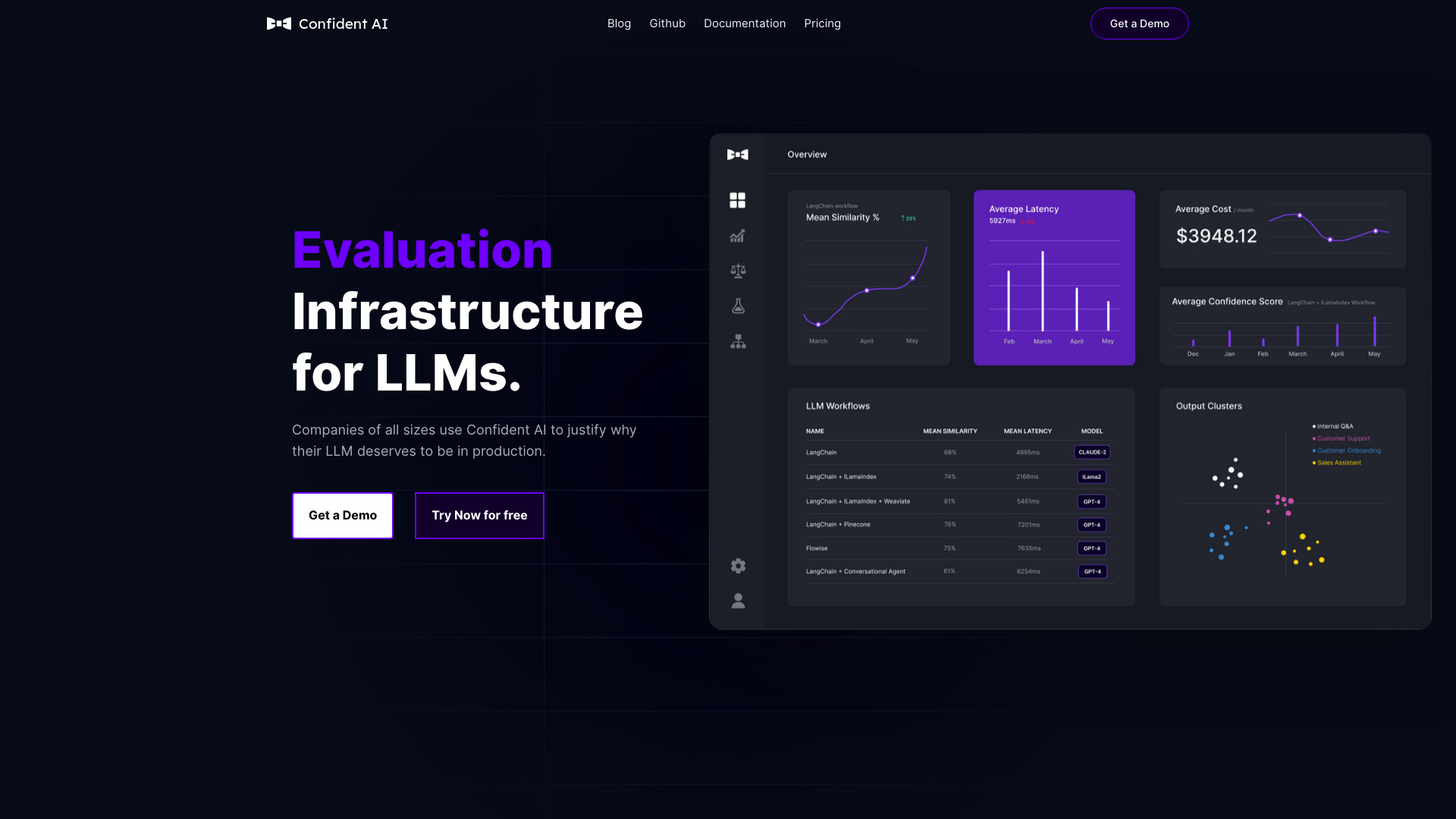

Confident AI

Mở trang web-

Giới thiệu công cụ:Nền tảng đánh giá LLM: 14+ chỉ số, tracing, quản lý dữ liệu, hỗ trợ phản hồi

-

Ngày thêm:2025-11-06

-

Mạng xã hội & Email:

Thông tin công cụ

Confident AI là gì?

Confident AI là nền tảng đánh giá LLM tất cả trong một được xây dựng bởi đội ngũ tạo ra DeepEval. Công cụ này cung cấp hơn 14 chỉ số (metrics) để chạy thí nghiệm LLM, quản lý bộ dữ liệu, giám sát hiệu năng theo thời gian thực và tích hợp phản hồi con người nhằm tự động cải thiện ứng dụng AI. Nhờ kết hợp chặt chẽ với DeepEval (mã nguồn mở) và hệ thống tracing, Confident AI giúp các đội ngũ kỹ thuật benchmark, bảo vệ và tối ưu pipeline LLM với quy trình chuẩn hóa: tuyển chọn dữ liệu, căn chỉnh metrics và tự động hóa kiểm thử. Kết quả là tiết kiệm thời gian, giảm chi phí suy luận, tăng độ tin cậy và dễ dàng thuyết phục stakeholder về các cải tiến chất lượng hệ thống.

Các tính năng chính của Confident AI

- Hơn 14+ metrics đánh giá: độ liên quan, tính đúng đắn/groundedness, tính nhất quán ngữ nghĩa, đầy đủ câu trả lời, độc hại/thiên lệch, khả năng chống jailbreak, chi phí, độ trễ, tỷ lệ thành công, v.v.

- Thí nghiệm có kiểm soát: A/B prompts, so sánh mô hình, theo dõi thay đổi qua phiên bản để tìm cấu hình tối ưu.

- Quản lý và tuyển chọn bộ dữ liệu: gom nhóm kịch bản, gắn nhãn ground truth, cân bằng phân phối dữ liệu để đánh giá công bằng.

- Tracing toàn trình: quan sát chi tiết từng bước suy luận, token, chi phí và nguồn lỗi để gỡ rối nhanh.

- Human-in-the-loop: thu thập phản hồi chuyên gia/khách hàng, gộp vào vòng lặp cải tiến tự động.

- Tự động hóa kiểm thử LLM: regression tests, ngưỡng chất lượng, gating trước khi phát hành.

- Tích hợp DeepEval: tận dụng khung mã nguồn mở, linh hoạt với nhiều nhà cung cấp LLM và ca sử dụng.

- Báo cáo thuyết phục: dashboard KPI, xu hướng theo thời gian giúp chứng minh tác động với stakeholder.

- Bảo vệ và tuân thủ: đo lường độc hại, rủi ro an toàn, tăng độ tin cậy cho ứng dụng sản xuất.

Đối tượng phù hợp với Confident AI

Confident AI phù hợp với đội ngũ kỹ sư ML/AI, MLE, data scientist, QA cho AI, product manager và doanh nghiệp triển khai ứng dụng LLM ở môi trường sản xuất. Công cụ đặc biệt hữu ích khi bạn cần tiêu chuẩn hóa đánh giá đa chiều, thiết lập guardrail an toàn, giảm chi phí suy luận, cũng như chứng minh hiệu quả cải tiến mô hình/prompt với các bên liên quan.

Cách sử dụng Confident AI

- Kết nối dự án LLM và cài đặt SDK DeepEval; bật tracing để thu thập log, token, chi phí và ngữ cảnh.

- Tạo hoặc nhập bộ dữ liệu đánh giá: kịch bản, câu hỏi, ngữ cảnh, ground truth/golden answers.

- Chọn bộ metrics phù hợp (liên quan, đúng đắn, độc hại, chi phí, độ trễ…) và đặt ngưỡng chấp nhận.

- Thiết lập thí nghiệm: A/B prompts, so sánh mô hình/phiên bản, cấu hình RAG hoặc chuỗi công cụ.

- Chạy đánh giá và phân tích trên dashboard: theo dõi outlier, điểm yếu theo nhóm ca kiểm thử.

- Tích hợp phản hồi con người để hiệu chỉnh nhãn, cập nhật dữ liệu và tự động cải tiến.

- Thêm kiểm thử hồi quy vào CI/CD, thiết lập quality gates trước khi phát hành lên sản xuất.

- Lặp lại tối ưu: tinh chỉnh prompt/chain, cắt chi phí và nâng độ tin cậy dựa trên kết quả đo.

Trường hợp ứng dụng thực tế của Confident AI

Đánh giá hệ thống hỗ trợ khách hàng dùng RAG: đo độ liên quan ngữ cảnh, groundedness và tỷ lệ ảo tưởng để giảm sai sót. Kiểm thử trợ lý tóm tắt tài liệu nội bộ: theo dõi độ đầy đủ và chi phí/tác vụ. Gating trước khi phát hành code assistant: so sánh phiên bản mô hình theo latency, pass rate và an toàn. Kiểm soát chất lượng chatbot đa ngôn ngữ: đo độc hại, thiên lệch và độ nhất quán. Báo cáo KPI để chứng minh cải tiến chất lượng qua từng lần cập nhật.

Ưu điểm và nhược điểm của Confident AI

Ưu điểm:

- Bộ metrics phong phú, bao quát cả chất lượng, an toàn và chi phí.

- Tích hợp chặt với DeepEval, linh hoạt cho nhiều nhà cung cấp LLM và ca sử dụng.

- Tracing chi tiết giúp gỡ lỗi, quy trách nhiệm lỗi và tối ưu chi phí.

- Tự động hóa kiểm thử và regression trong quy trình CI/CD.

- Hỗ trợ vòng lặp phản hồi con người để cải thiện liên tục.

- Dashboard rõ ràng giúp thuyết phục stakeholder bằng số liệu.

Nhược điểm:

- Cần thời gian tuyển chọn dữ liệu và định nghĩa ground truth chất lượng.

- Việc chọn/bộ trọng số metrics phù hợp có thể đòi hỏi chuyên môn.

- Chi phí và tài nguyên tăng theo quy mô thử nghiệm và logging/tracing.

- Hiệu quả phụ thuộc vào mức độ tích hợp đầy đủ trong pipeline hiện có.

Các câu hỏi thường gặp về Confident AI

-

Câu hỏi: Confident AI khác gì so với DeepEval?

Trả lời: DeepEval là khung mã nguồn mở để viết và chạy đánh giá; Confident AI là nền tảng đầy đủ tính năng (metrics, tracing, dữ liệu, dashboard, automation) giúp quản trị, tự động hóa và mở rộng đánh giá trong sản xuất.

-

Câu hỏi: Có hỗ trợ đánh giá ứng dụng RAG không?

Trả lời: Có. Bạn có thể đo độ liên quan ngữ cảnh, groundedness, tính đầy đủ câu trả lời, cùng chi phí và độ trễ cho pipeline RAG.

-

Câu hỏi: Tích hợp với mô hình/nhà cung cấp nào?

Trả lời: Thông qua DeepEval và tracing, nền tảng hỗ trợ đánh giá các ứng dụng dùng nhiều mô hình khác nhau, miễn là có thể gọi qua API chuẩn.

-

Câu hỏi: Có thể tự động hóa kiểm thử trong CI/CD chứ?

Trả lời: Có. Bạn thiết lập ngưỡng chất lượng, regression tests và quality gates để ngăn bản phát hành nếu điểm đánh giá không đạt.

-

Câu hỏi: Làm sao giảm chi phí suy luận với Confident AI?

Trả lời: Sử dụng tracing để theo dõi token/chi phí, A/B các chiến lược prompt/mô hình, và ưu tiên cải tiến các kịch bản gây tốn kém nhưng ít đem lại chất lượng.