- Startseite

- AI APIs

- AiHubMix

AiHubMix

Website öffnen-

Tool-Einführung:Ein API-Router im OpenAI-Stil für Gemini, Qwen; unbegrenzte Aufrufe

-

Aufnahmedatum:2025-11-02

-

Soziale Medien & E-Mail:

Tool-Informationen

Was ist AiHubMix

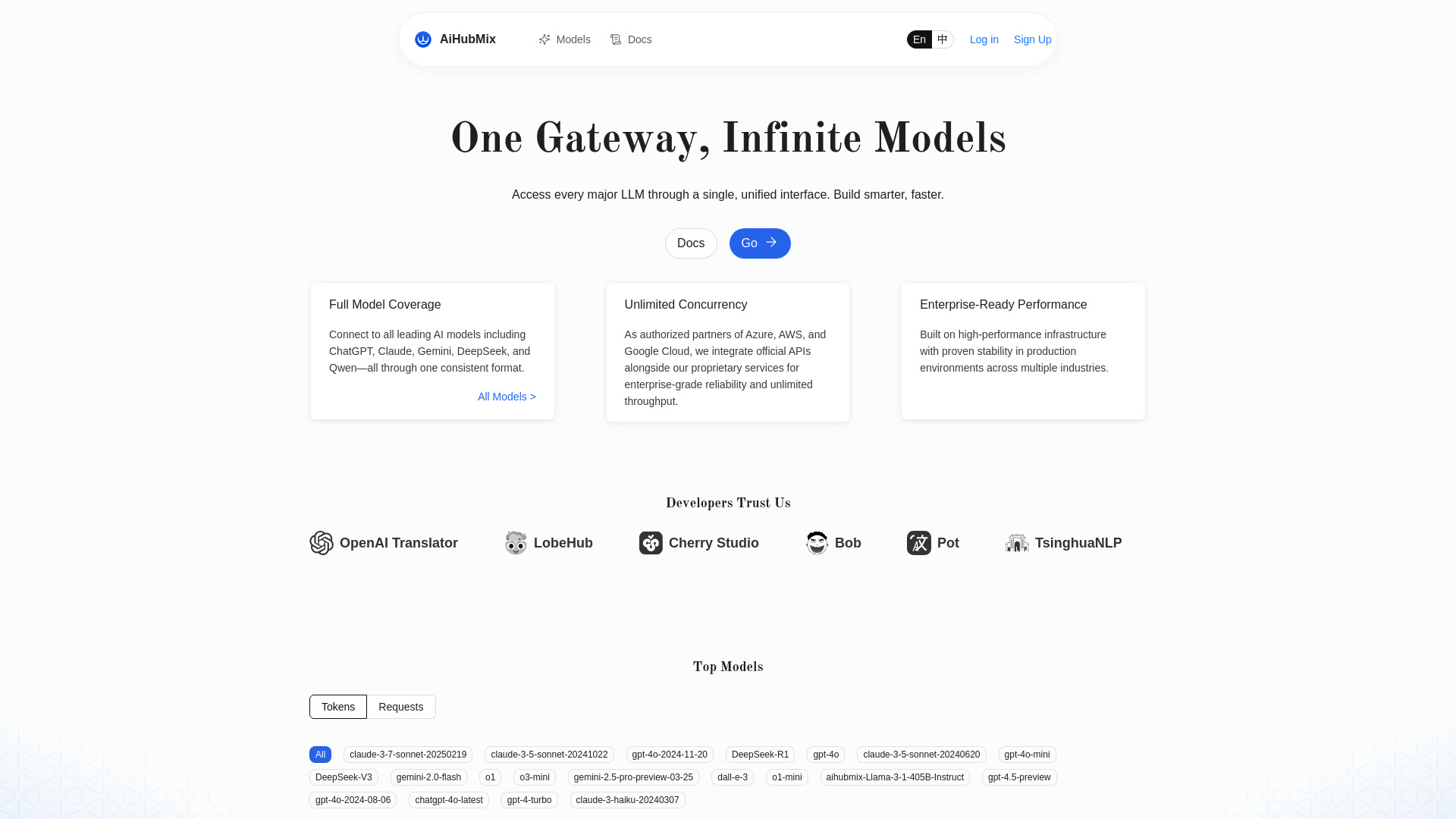

AiHubMix ist ein LLM‑API‑Router und OpenAI‑API‑Proxy, der Modelle wie OpenAI, Google Gemini, DeepSeek, Llama, Alibaba Qwen, Claude, Moonshot und Cohere über eine einheitliche Schnittstelle bündelt. Über einen OpenAI‑kompatiblen Standard lassen sich unterschiedliche Modelle ohne größere Codeänderungen ansprechen. Das Tool unterstützt aktuelle Modelle, skaliert mit unbegrenzter Parallelität und vereinfacht Integration, Orchestrierung und Betrieb von KI‑Funktionen. Ergebnis: schnellere Entwicklung, weniger Integrationsaufwand und flexible Modellwahl je nach Anwendungsfall.

Hauptfunktionen von AiHubMix

- OpenAI‑kompatible API: Einheitliches Request‑/Response‑Schema für verschiedene Sprachmodelle.

- Modell‑Aggregation: Zugriff auf OpenAI, Google Gemini, DeepSeek, Llama, Qwen, Claude, Moonshot und Cohere über eine zentrale Schnittstelle.

- Schneller Modellwechsel: Modelle je nach Qualität, Latenz oder Use Case austauschen, ohne die Architektur neu zu bauen.

- Aktuelle Modellunterstützung: Zügiger Zugang zu neuen und aktualisierten Modellen.

- Unbegrenzte Parallelität: Hohe Lastspitzen und viele gleichzeitige Requests effizient verarbeiten.

- Einfachere Integration: Bestehende Workflows behalten, nur den Endpoint bzw. Modellnamen anpassen.

- Entwicklungsproduktivität: Weniger Integrationsaufwand, schnellere Iteration und Markteinführung.

Für wen ist AiHubMix geeignet

AiHubMix richtet sich an Software‑Entwickler, Produkt‑ und KI‑Teams, Startups und Unternehmen, die mehrere LLM‑Provider nutzen oder flexibel zwischen Modellen wechseln möchten. Ideal für SaaS‑Anbieter, Plattformbetreiber, interne Tools und Agenturen, die eine einheitliche API bevorzugen, Skalierung benötigen und Integrationsaufwand reduzieren wollen.

Wie man AiHubMix verwendet

- Ziel definieren: Anwendungsfall und gewünschte Modelle festlegen.

- Client vorbereiten: Bestehenden OpenAI‑kompatiblen Client oder HTTP‑Client verwenden.

- Konfiguration setzen: AiHubMix als Endpoint nutzen und den Modellnamen passend zum Provider angeben.

- Anfrage senden: Prompt/Parameter übermitteln und Antwort im gewohnten Format verarbeiten.

- Optimieren: Modelle vergleichen, Parallelität erhöhen und je nach Ergebnis den Modellwechsel vornehmen.

Branchenspezifische Anwendungsfälle von AiHubMix

In der Praxis eignet sich AiHubMix für SaaS‑Produkte (Chat‑Assistenten, Content‑Features), E‑Commerce (Produktbeschreibungen, Support‑Bots), Kundenservice (Antwortvorschläge, Zusammenfassungen), Bildung (Lern‑Tutoren, Feedback) sowie Medien & Marketing (Textvarianten, Ideation). Teams können je nach Aufgabe das passende Modell wählen und so Qualität, Geschwindigkeit und Kosten ausbalancieren.

Vorteile und Nachteile von AiHubMix

Vorteile:

- Einheitlicher OpenAI‑Standard für viele Modelle.

- Modellvielfalt durch Aggregation mehrerer Provider.

- Unbegrenzte Parallelität für hohe Last.

- Schneller Modellwechsel ohne große Codeänderungen.

- Weniger Integrationsaufwand und schnellere Iterationen.

- Zukunftssicher dank Unterstützung aktueller Modelle.

Nachteile:

- Abhängigkeit von externen Modell‑Providern und deren Verfügbarkeit.

- Unterschiedliche Modellcharakteristika erfordern Tests und Evaluation.

- Mögliche Änderungen an Modellnamen oder -versionen müssen nachgezogen werden.

- Komplexere Kostenkontrolle, wenn mehrere Provider parallel genutzt werden.

Häufige Fragen zu AiHubMix

Ist AiHubMix OpenAI‑kompatibel?

Ja. AiHubMix stellt einen OpenAI‑kompatiblen Standard bereit, über den verschiedene Modelle einheitlich aufgerufen werden können.

Welche Modelle werden unterstützt?

Unter anderem OpenAI, Google Gemini, DeepSeek, Llama, Alibaba Qwen, Claude, Moonshot und Cohere.

Kann ich zwischen Modellen wechseln, ohne den Code neu zu schreiben?

Ja. Der Wechsel erfolgt innerhalb des OpenAI‑kompatiblen Formats im Wesentlichen über den Modellnamen.

Eignet sich AiHubMix für Lastspitzen?

Ja. Das Tool unterstützt unbegrenzte Parallelität und ist damit für stark schwankende Anfragevolumina ausgelegt.