AiHubMix

打開網站-

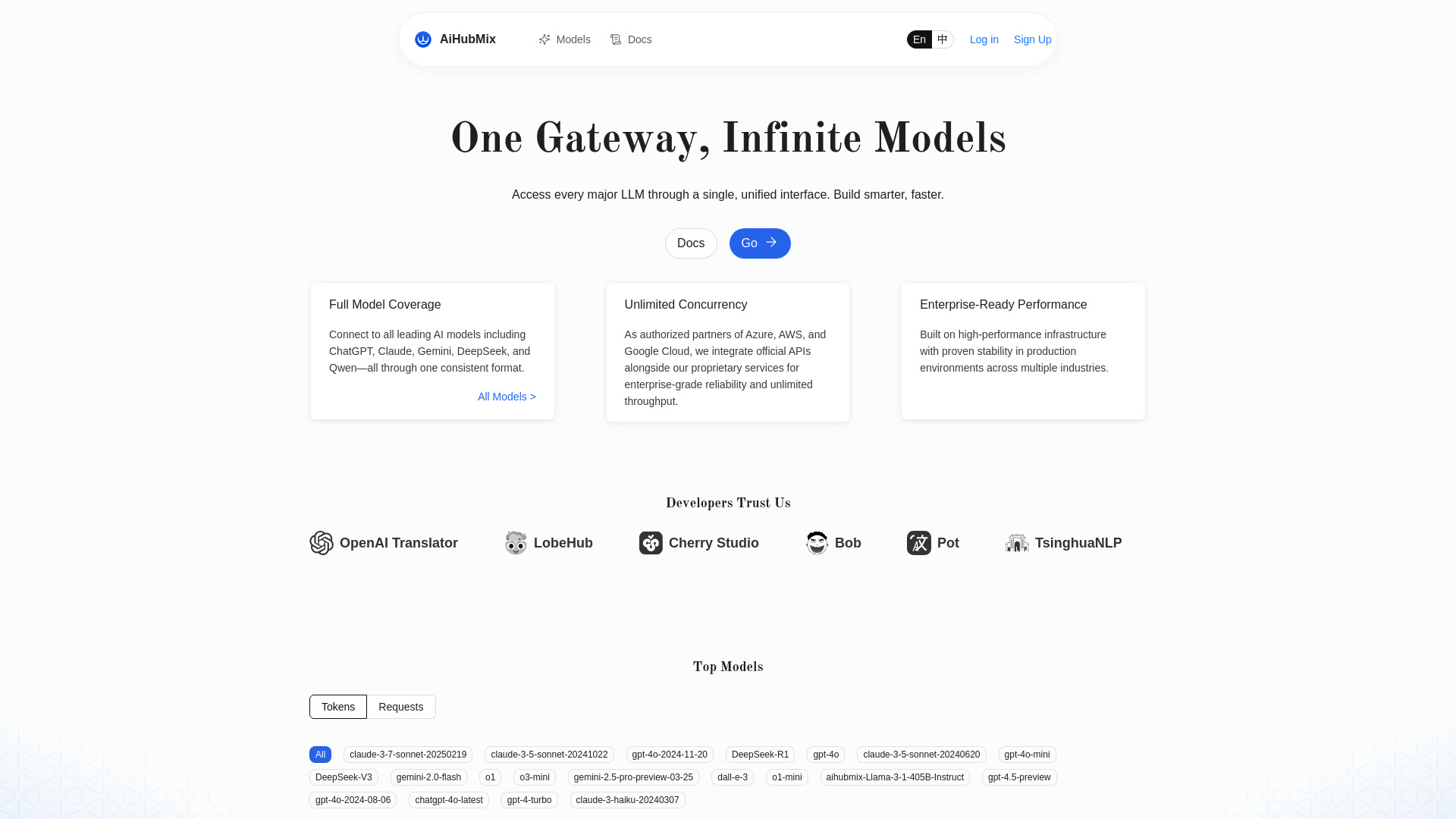

工具介紹:OpenAI風格統一介面,整合Gemini/Claude/Qwen等主流模型;支援最新款,無限併發,加速開發效率

-

收錄時間:2025-11-02

-

社群媒體&信箱:

工具資訊

什麼是 AiHubMix

AiHubMix 是面向開發者與產品團隊的 LLM API 路由器與 OpenAI 相容代理服務,將多家主流大語言模型整合至單一、統一的調用界面。它以與 OpenAI API 規格一致的請求格式與參數設計,讓團隊幾乎不需重寫程式碼即可連接與切換不同供應商的模型,包含 OpenAI、Google Gemini、DeepSeek、Llama、阿里巴巴 Qwen、Anthropic Claude、月之暗面(Moonshot)與 Cohere 等。透過這種模型聚合與標準化的方式,AiHubMix 把各家服務之間在端點、授權、版本與錯誤處理上的差異抽象化,協助開發者專注於應用場景本身,快速完成從原型驗證到生產上線。其核心價值在於提供穩定的高併發調用能力與快速接入最新模型的能力,滿足多變的流量與性能需求,同時降低整合成本與運維負擔。對需要在成本、效能與品質之間靈活權衡的團隊而言,AiHubMix 充當模型選型與路由中樞:一套業務邏輯即可覆蓋多種模型,僅透過配置切換模型名稱或供應商,即可完成升級、降級或 A/B 測試;當流量波動或單一供應商受限時,也能維持服務可用性,讓產品更快迭代、更穩定地服務終端用戶。

AiHubMix 主要功能

- OpenAI 相容接口:採用與 OpenAI API 一致的端點與參數格式,降低學習與接入成本,便於直接沿用現有 SDK 或客戶端。

- 多模型聚合:整合 OpenAI、Google Gemini、DeepSeek、Llama、阿里巴巴 Qwen、Anthropic Claude、月之暗面(Moonshot)、Cohere 等主流模型,單一接口覆蓋多供應商。

- 快速接入最新模型:隨主流供應商更新而同步支援新版本與新能力,縮短模型升級與替換的時間。

- 高併發調用:面向生產級流量的高併發架構,支援大規模請求與彈性擴展,滿足高峰期負載需求。

- 低改動切換:以配置為中心的模型切換機制,僅更換模型名稱或路由設定即可完成供應商與版本切換。

- 一致回應格式:輸出結構與錯誤樣式趨於一致,方便日誌觀測、錯誤處理與下游服務對接。

- 跨供應商彈性:在成本、延遲與品質之間靈活權衡,便於做 A/B 測試、灰度發布與多區域調用策略。

- 開發維運簡化:統一鑑權與接口管理,減少多套 SDK、密鑰與配額分散帶來的維護負擔。

AiHubMix 適用人群

AiHubMix 適合需要同時對接多家大語言模型,並在穩定性、成本與效能之間取得平衡的團隊與個人。例如:希望快速上線聊天助理、內容生成、摘要整理、問答檢索等應用的後端工程師與全端開發者;需要進行模型選型、基準測試與持續優化的資料科學與機器學習工程團隊;在不同市場與場景中需要靈活切換供應商的 SaaS 產品團隊;以及關注交付速度與運維效率的初創企業與中大型組織。

AiHubMix 使用步驟

- 建立帳號並取得 API Key:完成註冊後生成用於請求的金鑰,妥善保存於安全的環境變數或祕密管理工具。

- 設定端點與認證:在應用程式中將基底 URL 指向 AiHubMix,於標頭加入金鑰或依指引設定鑑權。

- 沿用 OpenAI 介面調用:使用既有的 OpenAI 相容客戶端或 HTTP 請求,按慣用的參數格式組裝請求。

- 選擇模型並發送請求:以模型名稱標識對應的供應商與版本,根據任務需要調整溫度、最大輸出長度等生成參數。

- 驗證與觀測:在開發與測試環境驗證回應品質與延遲,紀錄日誌並比對不同模型的表現與成本。

- 部署與擴展:將配置推送到生產環境,根據流量特性擴容並持續監控錯誤率與併發表現,必要時切換模型或路由策略。

AiHubMix 行業案例

在客戶服務場景,企業可使用 AiHubMix 為智慧客服與知識庫問答統一接入層:高峰期以高併發架構維持穩定,並以多模型 A/B 測試提升回覆品質與成本效率;於內容製作平台,編輯與創作者可根據任務切換至更擅長長文生成、程式輔助或結構化摘要的模型,讓文案、腳本與標題產生流程更順暢;在教育與培訓領域,系統可同時評估多家模型對於批改、提示與解題的表現,選擇更合適的組合;對需要全球化佈署的 SaaS,藉由跨供應商的彈性選擇與快速切換,降低單點依賴風險,確保不同區域的服務可用性與一致體驗。

AiHubMix 優點與缺點

優點:

- 統一接口與相容設計,顯著降低學習門檻與整合成本。

- 聚合多家主流模型,能快速接入並持續追蹤最新版本。

- 支援高併發與彈性擴展,適合生產級流量與高峰負載。

- 低改動模型切換,便於做 A/B 測試與灰度發布,縮短迭代週期。

- 一致回應與錯誤處理模式,利於監控、日誌與下游穩定性。

- 降低供應商鎖定風險,在成本、延遲與品質間取得更佳平衡。

缺點:

- 供應商的進階或專屬功能可能無法完全以統一接口呈現。

- 經由路由層轉發可能引入些許網路延遲,需以併發與快取策略彌補。

- 多模型並行帶來的策略與配額管理更複雜,需建立良好治理流程。

- 服務可用性在一定程度上依賴上游供應商與中介層的穩定性。

AiHubMix 熱門問題

-

問:AiHubMix 是否與 OpenAI 的開發方式相容?

答:是。它提供與 OpenAI API 規格一致的接口,通常只需更換基底 URL 與金鑰,即可沿用既有請求參數與客戶端。

-

問:如何在 AiHubMix 中切換到不同供應商或模型?

答:以模型名稱進行標識與切換即可,無需改動主要業務邏輯;可透過配置管理完成升級、降級或 A/B 測試。

-

問:AiHubMix 是否支援最新的大語言模型版本?

答:支援。其設計重點之一是快速對接主流供應商的新模型,使團隊能更快完成升級與驗證。

-

問:併發能力如何,是否能應對高流量場景?

答:採高併發與可擴展架構,可處理大量並行請求;實際吞吐量仍會受上游模型限額與當前流量特性影響。

-

問:將既有服務遷移到 AiHubMix 需要大幅改動嗎?

答:不需要。由於其與 OpenAI API 相容,通常以最小改動即可完成端點與認證切換並開始調用。