工具信息

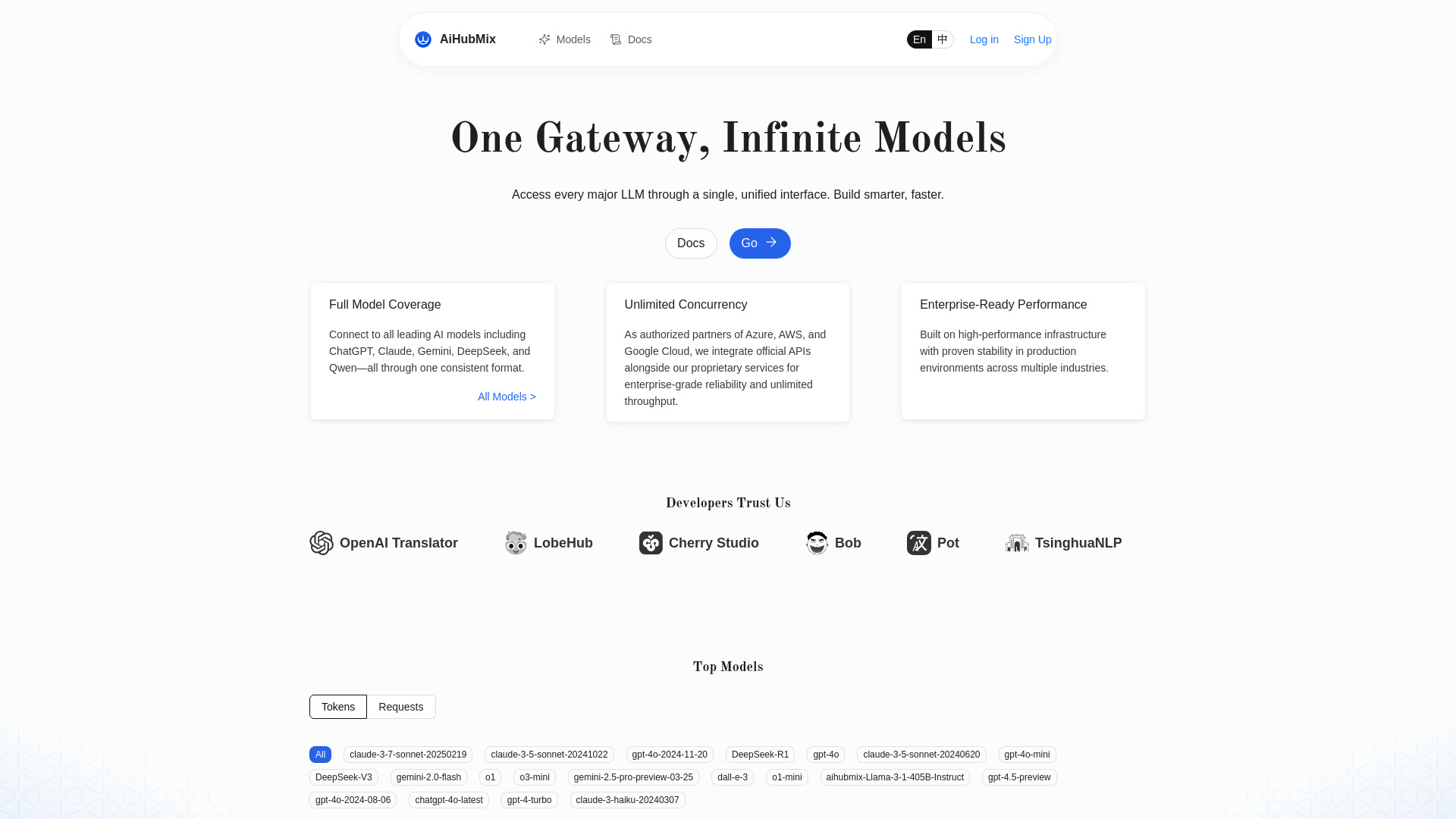

什么是 AiHubMix

AiHubMix 是面向开发与系统集成场景的多模型请求路由与接口代理平台。它将来自多家厂商的通用大语言模型与多模态模型聚合到同一入口,通过统一的调用格式与鉴权,帮助团队以最小改动在不同模型之间快速切换与编排。平台持续跟进最新模型版本,提供不限并发的接入能力,并可结合策略进行故障转移与优先级分发,降低单一供应商波动带来的风险。对既有系统而言,AiHubMix 可作为上游与下游之间的中间层,在保证兼容性的前提下,支持流式输出与函数/工具调用等能力透传,简化对接,缩短交付周期,并在性能、稳定性与成本之间取得更平衡的结果。借助统一的模型命名与别名机制,开发者无需频繁适配各家参数差异;通过灵活的路由配置,可按地域、时延或成功率进行分流与回退,覆盖对话、内容生成、代码辅助、知识问答等主流应用场景,同时便于在测试、预发布与生产环境间复用调用方式,减少重复维护成本。

AiHubMix主要功能

- 统一调用与鉴权:以一致的请求格式与令牌校验对接不同厂商模型,降低适配与维护成本。

- 多模型聚合:汇聚多家主流模型供应商,例如双子座、深度求索、羊驼、通义千问、克劳德、月之暗面等,覆盖多种能力与价位带。

- 模型别名与快速切换:通过别名屏蔽底层差异,可在不改业务代码的情况下切换或扩容目标模型。

- 不限并发接入:提供弹性扩展的接入层,支撑高峰流量与大规模任务调度。

- 智能路由策略:支持优先级、加权分流、重试与故障转移,提升可用性与成功率。

- 能力透传:兼容流式与非流式输出,支持函数/工具调用等常见能力的透传,减少特性丢失。

- 持续跟进新模型:快速适配厂商发布的最新版本与特性,缩短评估与上线周期。

- 低改造成本:对已有调用方式友好,便于在现有服务中平滑接入与替换。

AiHubMix适用人群

适合需要在多家模型间灵活选择与切换的团队或个人,包括后端与全栈开发者、人工智能应用团队、企业架构与平台中台、教育与科研机构、独立开发者与初创公司等。典型使用场景包含对话式客服、内容生成与审核、代码辅助、知识检索问答、多模型对照实验、跨地域冗余与灾备等。

AiHubMix使用步骤

- 创建账户与项目,获得调用凭据,并完成基础安全设置。

- 在平台中配置各模型供应商的密钥与可用模型清单,建立模型与业务别名的映射关系。

- 设定路由策略,如优先级、加权分流、重试与故障转移阈值,以及并发与超时参数。

- 在应用侧将原有的模型调用指向统一入口,保持请求与响应结构一致,进行联调。

- 选择是否启用流式输出与函数/工具调用透传,完成单元与集成测试。

- 上线后监控成功率、时延与错误类型,根据结果微调路由与模型组合。

- 按需升级模型版本或扩展新供应商,在不改业务逻辑的情况下进行灰度与回滚。

AiHubMix行业案例

客户服务中心将问答机器人接入 AiHubMix,通过优先级与故障转移策略保证高峰时段的连续性,并在不同模型间对比回复质量以优化成本。内容生产平台以模型别名管理文案与图文生成任务,在双子座、通义千问与月之暗面之间动态切换,兼顾速度与风格一致性。研发团队在代码助手与知识问答场景中采用多模型编排,利用加权分流与回退减少超时与限流影响。跨境企业将 AiHubMix 作为统一接入层,通过地域就近与弹性并发,提高全球访问稳定性。

AiHubMix收费模式

费用通常与调用量、并发与功能范围相关,常见做法包括按量计费、按项目或团队订阅,以及提供一定额度的试用或免费配额;具体方案与价格以官方公布为准。

AiHubMix优点和缺点

优点:

- 一次接入,多模型可用,显著降低适配与切换成本。

- 不限并发的接入层,便于应对业务高峰与弹性扩容。

- 智能路由与回退策略,提升可用性并降低中断风险。

- 能力透传与低改造成本,兼顾兼容性与新特性落地速度。

- 持续跟进新模型,便于做性能与成本的动态权衡。

缺点:

- 引入额外的接入层,系统架构与运维复杂度有所增加。

- 不同厂商在参数与能力上的差异仍需通过提示与策略细化。

- 代理转发可能带来少量时延,需要在稳定性与时效之间平衡。

- 对于极端定制化功能,统一接口可能无法完全覆盖。

AiHubMix热门问题

-

是否兼容主流接口规范与流式输出?

支持统一的请求与响应结构,并可选择流式或非流式方式返回,便于平滑接入现有服务。

-

如何在不同模型供应商之间快速切换?

通过模型别名与路由策略屏蔽底层差异,可在不改业务逻辑的前提下进行灰度、切换与回退。

-

并发是否有限制?

接入层不限并发,实际可用并发还取决于上游模型的配额与速率限制,建议结合重试与故障转移策略使用。

-

是否支持函数/工具调用等能力透传?

支持常见能力的透传,便于将已有应用迁移到统一入口,减少功能丢失与重复开发。

-

需要做哪些稳定性方面的配置?

建议设置超时、重试次数、优先级与权重,并开启失败回退与地域就近,以提升成功率与时延表现。