AiHubMix

Abrir sitio web-

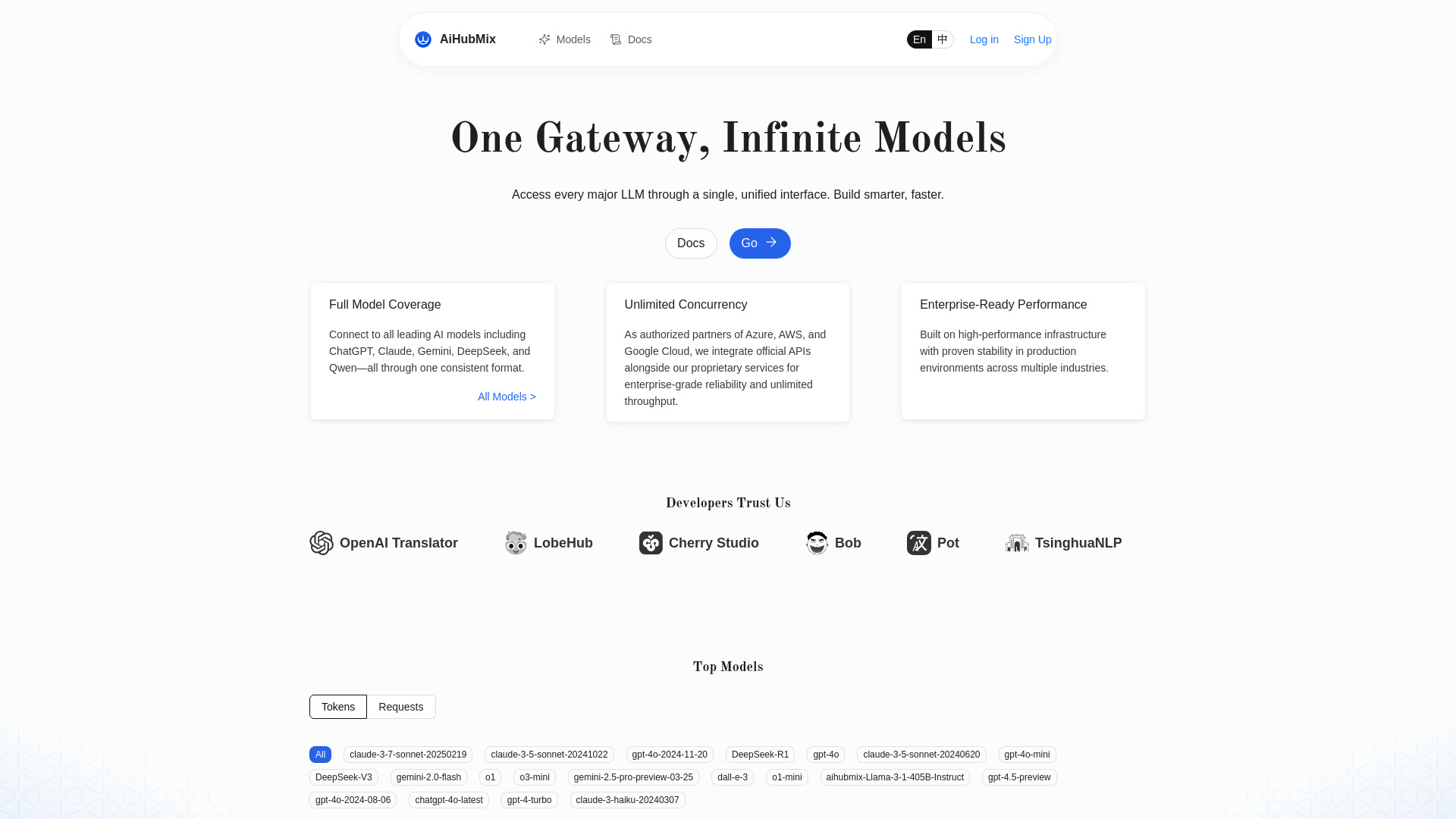

Introducción de la herramienta:API OpenAI unificada para Gemini, Claude y Qwen; concurrencia sin límites.

-

Fecha de inclusión:2025-11-02

-

Redes sociales y correo electrónico:

Información de la herramienta

¿Qué es AiHubMix?

AiHubMix es un router de API para LLM y proxy compatible con la API de OpenAI que unifica el acceso a múltiples modelos de IA en un solo estándar. Actúa como agregador de modelos (OpenAI, Google Gemini, DeepSeek, Llama, Qwen de Alibaba, Claude, Moonshot/「月之暗面」 y Cohere), permitiendo invocar diferentes proveedores con la misma interfaz. Su objetivo es simplificar la integración de modelos, mantener soporte para las versiones más recientes y ofrecer concurrencia ilimitada para flujos de trabajo exigentes, haciendo el desarrollo más ágil, escalable y eficiente.

Principales características de AiHubMix

- API unificada estilo OpenAI: utiliza el mismo formato de solicitudes y respuestas para llamar a modelos de distintos proveedores sin cambiar tu código base.

- Agregación de modelos líderes: integra OpenAI, Google Gemini, DeepSeek, Llama, Qwen (Alibaba), Claude, Moonshot (月之暗面) y Cohere en un solo punto de acceso.

- Compatibilidad con los modelos más recientes: acceso rápido a nuevas versiones de modelos y capacidades emergentes bajo un estándar común.

- Concurrencia ilimitada: admite alto volumen de peticiones en paralelo para aplicaciones críticas y picos de demanda.

- Simplificación del desarrollo: reduce la complejidad de integrar, alternar y escalar múltiples LLM desde una única interfaz.

¿Para quién es AiHubMix?

Ideal para desarrolladores backend, ingenieros de MLOps, startups y equipos de producto que requieren multiproveedor de IA con una API compatible con OpenAI. Útil para empresas que necesitan probar, comparar y desplegar distintos LLM sin mantener integraciones separadas, así como para plataformas SaaS, integradores no-code/low-code y equipos de datos que buscan escalar aplicaciones con concurrencia elevada.

Cómo usar AiHubMix

- Regístrate en AiHubMix y obtén una clave de API para autenticar tus solicitudes.

- Configura en tu aplicación el endpoint compatible con la API de OpenAI proporcionado por AiHubMix.

- Envía tus peticiones usando el mismo esquema de OpenAI (por ejemplo, chat o completions) e indica el modelo objetivo (OpenAI, Gemini, DeepSeek, Llama, Qwen, Claude, Moonshot o Cohere).

- Itera y cambia de proveedor ajustando solo el nombre del modelo, sin modificar la lógica de negocio.

- Escala el tráfico aprovechando la concurrencia ilimitada para pruebas de carga y entornos de producción.

Casos de uso de AiHubMix en la industria

En comercio electrónico, permite probar y desplegar modelos para búsqueda semántica, recomendaciones y asistentes de compra cambiando de LLM según rendimiento. En atención al cliente, impulsa chatbots multilingües que alternan entre modelos para optimizar coste y calidad. En medios y marketing, facilita la generación de contenidos y resúmenes a gran escala con alto paralelismo. En productividad interna, habilita análisis de documentos y extracción de información usando el proveedor más adecuado para cada tipo de dato.

Ventajas y desventajas de AiHubMix

Ventajas:

- Unificación de APIs que reduce tiempo de integración y mantenimiento.

- Multiproveedor con acceso a modelos líderes en un solo punto.

- Actualizado con soporte para modelos recientes bajo un estándar común.

- Escalabilidad gracias a la concurrencia ilimitada para cargas intensivas.

- Agilidad para experimentar, comparar y cambiar de LLM sin reescribir código.

Desventajas:

- Dependencia de un intermediario para enrutar y gestionar las llamadas.

- Diferencias sutiles entre implementaciones del estándar que pueden requerir ajustes.

- Latencia y límites sujetos a cada proveedor subyacente y a su disponibilidad.

- Funciones específicas de algunos modelos pueden no estar totalmente cubiertas por el estándar común.

Preguntas frecuentes sobre AiHubMix

¿AiHubMix es compatible con el formato de la API de OpenAI?

Sí. Ofrece un estándar unificado compatible con OpenAI para invocar múltiples modelos sin cambiar tu estructura de peticiones.

¿Puedo cambiar de modelo sin modificar mi código?

En la mayoría de casos, basta con actualizar el parámetro de modelo, manteniendo el mismo endpoint y payload.

¿Qué modelos soporta actualmente?

OpenAI, Google Gemini, DeepSeek, Llama, Qwen (Alibaba), Claude, Moonshot (月之暗面) y Cohere, entre otros compatibles con el estándar.

¿Admite alta concurrencia?

Sí, AiHubMix está diseñado para ofrecer concurrencia ilimitada y manejar picos de tráfico con estabilidad.