AiHubMix

ウェブサイトを開く-

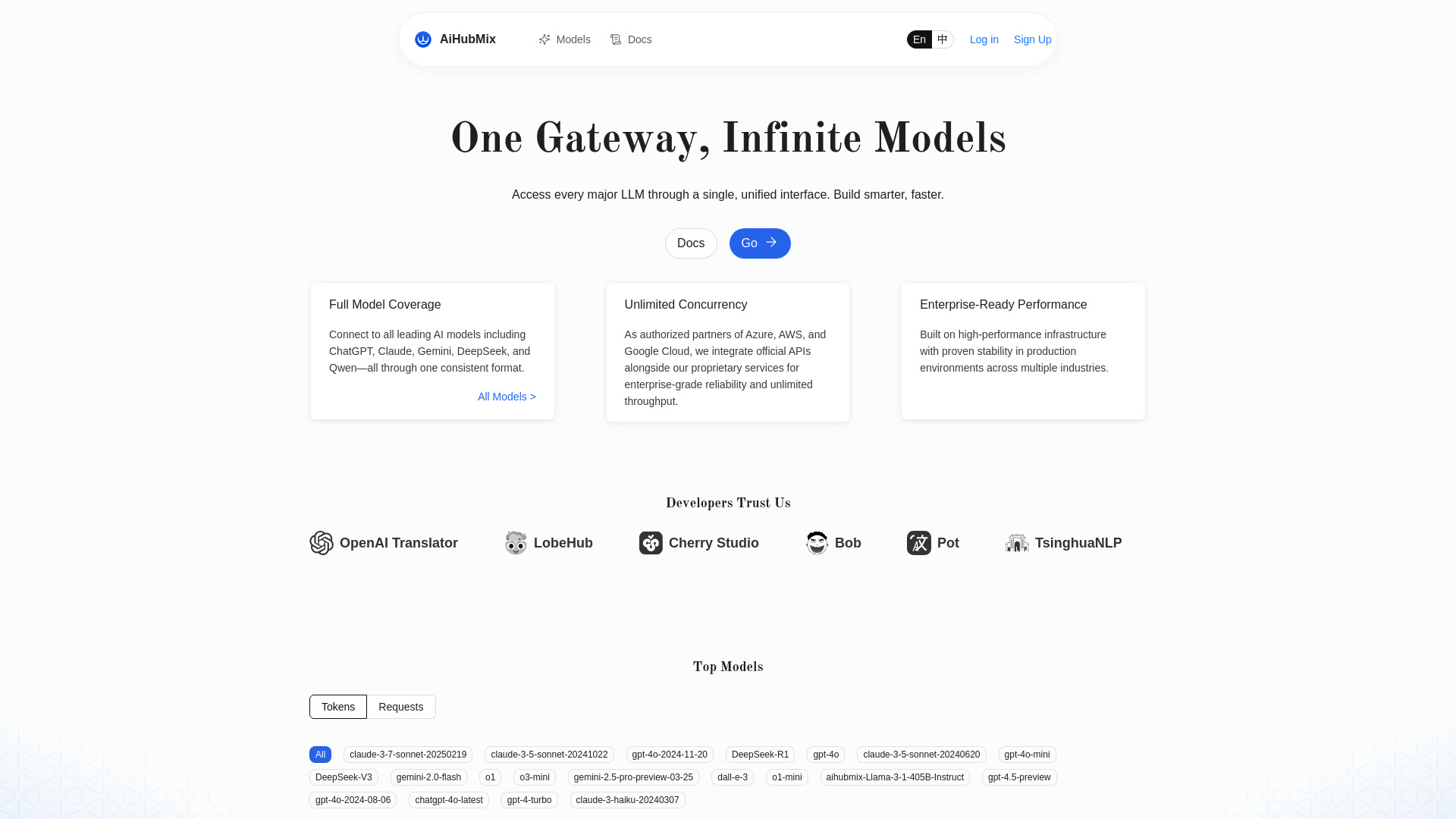

ツール紹介:OpenAI互換APIでGemini・Claude・Qwenを統一呼び出し。最新モデル、無制限並列・高可用性対応

-

登録日:2025-11-02

-

ソーシャルメディアとメール:

ツール情報

AiHubMixとは?

AiHubMixは、LLM APIルーター兼OpenAI APIプロキシとして設計された開発者向けの基盤ツールです。OpenAI、Google Gemini、DeepSeek、Llama、Alibaba Qwen、Anthropic Claude、Moonshot(月之暗面)、Cohereなど多様なモデルを集約し、OpenAI API互換の統一インターフェースで呼び出せるため、プロバイダーをまたいだ実装と保守を大幅に簡素化します。最新モデルへの対応や、無制限の並行実行により、PoCから本番運用までスムーズにスケール可能。モデル切り替えのためのコード差分を最小化し、開発工数・運用コスト・ベンダーロックインのリスクを抑制します。既存のOpenAI向けSDKやクライアントを活かしやすく、チャット補助、テキスト生成、要約、分類、埋め込み生成などのユースケースを一貫したエンドポイントで扱えるのが特長です。チーム開発での環境統一、LLMOpsの標準化にも適しています。

AiHubMixの主な機能

- OpenAI API互換の統一エンドポイントで複数のLLMを横断的に呼び出し

- OpenAI、Gemini、DeepSeek、Llama、Qwen、Claude、Moonshot、Cohereなどのモデル集約

- 最新モデルへの迅速な対応により機能更新をコード最小変更で反映

- 無制限の並行実行により高トラフィック時もスケールしやすい設計

- モデル切り替えが容易で、検証・比較やA/Bテストを進めやすい

- OpenAI向けライブラリやSDKをそのまま流用しやすく、導入がスムーズ

- ベンダー依存を抑え、長期運用における技術選択の自由度を確保

- ユースケース横断の一貫したリクエスト形式で開発・運用を効率化

AiHubMixの対象ユーザー

複数の生成AIを統合して使いたいソフトウェアエンジニア、バックエンド/フロントエンド開発者、MLOps/LLMOps担当、SaaS・B2Bプロダクトチーム、SIer、スタートアップのプロトタイピング担当に適しています。既存のOpenAI API実装を保ちつつ、GeminiやClaudeなどへ迅速に切り替え・拡張したいケース、需要変動に合わせて高い並行実行でスケールしたい本番運用、RAGやワークフロー内でモデルを使い分けたいシナリオで効果を発揮します。

AiHubMixの使い方

- アカウントを作成し、ダッシュボード等からAPIキーを取得します。

- 既存のOpenAI互換クライアント/SDKを用意し、base_url(エンドポイント)をAiHubMixのURLへ設定します。

- 認証ヘッダーに取得したAPIキーを設定し、必要に応じてタイムアウトや再試行回数を指定します。

- 利用したいモデルIDを指定し、チャット/テキスト生成/埋め込みなど用途に合わせてリクエストペイロードを作成します。

- テスト送信でレスポンス形式やストリーミング挙動を確認し、ログ出力やエラーハンドリングを整備します。

- 比較検証ではモデル名のみを切り替えて品質・レイテンシ・コスト観点を評価します。

- 本番運用に向けて並列数やキュー制御を調整し、スロットリングやリトライの設計を行います。

- モデル更新時は指定名を差し替えるだけで最新版へ移行し、依存コードの変更を最小限に保ちます。

AiHubMixの業界での活用事例

カスタマーサポートでは、問い合わせ内容に応じて複数モデルを使い分けるルーティングを実装し、応答品質とコストの最適化を実現します。コンテンツ生成や要約のパイプラインでは、ドラフト作成・校正・スタイル変換をモデルごとに分担し、開発・運用を統一APIで簡素化。データ処理や検索強化(RAG)では、埋め込み生成とテキスト生成を単一のエンドポイントで連携させ、バッチ処理では無制限の並行実行を活かして大量ジョブを短時間で捌く構成が可能です。プロダクト内のA/Bテストや地域・言語別の最適モデル選択にも適しています。

AiHubMixの料金プラン

利用料金は、選択する各モデル提供元の課金体系に影響を受けるケースがあります。AiHubMix側の料金、無料枠やトライアルの有無、および課金方式の詳細は提供元の最新情報を確認してください。PoC開始時は請求上限やクォータ設定、監視体制を整えたうえで運用に入ると安心です。

AiHubMixのメリットとデメリット

メリット:

- OpenAI API互換の統一インターフェースで導入が容易

- 複数プロバイダーのモデルを一元化し、切り替えや比較が簡単

- 最新モデルへの追随が早く、継続的な改善をコード最小変更で反映

- 無制限の並行実行によりスケーラブルな本番運用を支援

- ベンダーロックインを抑制し、技術選定の自由度を確保

デメリット:

- プロキシ経由のためネットワーク経路が増え、レイテンシがわずかに増える可能性

- 各プロバイダー固有の機能や細かな設定が、統一APIでは露出しない場合がある

- 障害時や変更管理の影響範囲が集約されるため、監視とフェイルセーフ設計が重要

- データ取り扱い・ログの保全など、セキュリティ/コンプライアンス要件の事前確認が必要

AiHubMixに関するよくある質問

OpenAIの公式クライアントは使えますか?

base_urlをAiHubMixのエンドポイントに設定し、APIキーを指定することで、OpenAI互換の形式で利用できるよう設計されています。

対応モデルを教えてください。

OpenAI、Google Gemini、DeepSeek、Llama、Alibaba Qwen、Anthropic Claude、Moonshot(月之暗面)、Cohereなどに対応します。最新の対応状況は公式の案内を参照してください。

同時実行の上限はありますか?

無制限の並行実行に対応しています。なお、各モデル提供元のレート制限や利用規約には従う必要があります。

既存コードからの移行は大変ですか?

エンドポイントと認証、モデル名の指定を差し替えるだけで動作するケースが多く、大規模な改修を避けられます。

データの取り扱いは安全ですか?

送信データの範囲やログ方針は自社ポリシーに沿って事前に確認し、必要に応じてマスキングや監査設定を行ってください。

商用利用は可能ですか?

AiHubMixの利用規約と、各モデル提供元の規約に従って利用します。プロジェクト要件に合わせて法務確認を推奨します。