AiHubMix

Abrir Site-

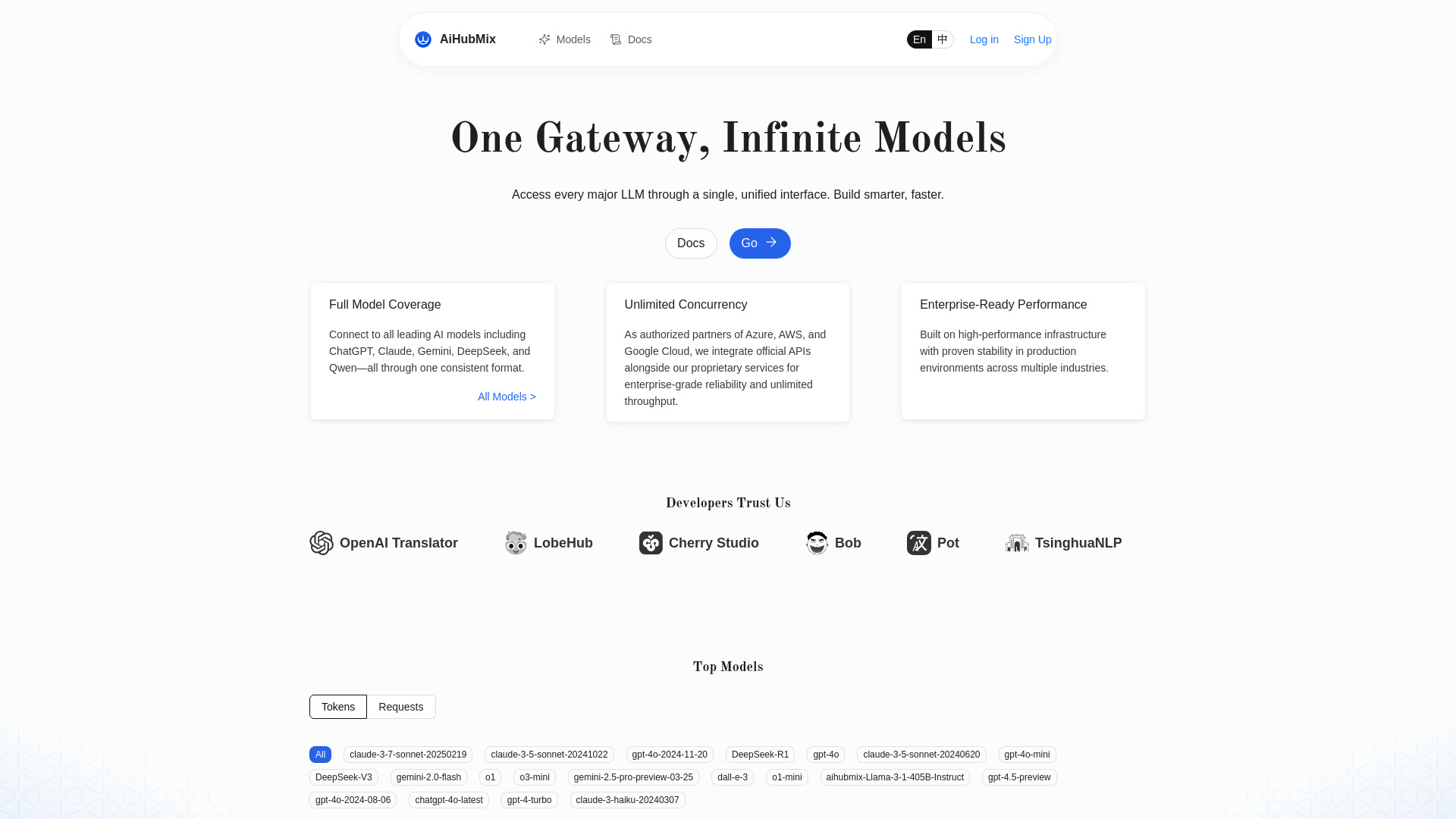

Ferramenta Introdução:Roteador de API estilo OpenAI para Gemini, Claude e Qwen; alta concorrência

-

Data de Inclusão:2025-11-02

-

Social Media e E-mail:

Informações da ferramenta

O que é AiHubMix

AiHubMix é um roteador de APIs para modelos de linguagem (LLM) e um proxy compatível com o padrão da OpenAI. Ele agrega provedores como OpenAI, Google Gemini, DeepSeek, Llama, Qwen (Alibaba), Claude, Moonshot e Cohere em uma única interface. Com um endpoint e um formato de chamada unificado, você alterna entre modelos e versões mais recentes sem refatorar seu código. O objetivo é simplificar a integração de IA, padronizar fluxos de desenvolvimento e permitir alta escalabilidade com concorrência ilimitada, acelerando testes A/B, migrações e a evolução de produtos baseados em IA.

Principais funcionalidades de AiHubMix

- Padrão OpenAI unificado: chamadas no formato da API da OpenAI para acessar diferentes modelos sem mudanças estruturais no código.

- Agregação multi-modelo: suporte a OpenAI, Google Gemini, DeepSeek, Llama, Qwen (Alibaba), Claude, Moonshot e Cohere em um só lugar.

- Suporte aos modelos mais recentes: facilidade para adotar novas versões de modelos conforme são lançadas.

- Concorrência ilimitada: execução em alta escala, ideal para picos de tráfego e cargas intensivas.

- Flexibilidade de escolha: selecione o modelo por caso de uso, idioma, custo ou qualidade, sem acoplamento a um único provedor.

- Compatibilidade com SDKs existentes: reaproveite clientes OpenAI já usados em produção.

- Simplificação operacional: reduz complexidade de integrações e manutenção de múltiplos endpoints.

Para quem é AiHubMix

Indicado para desenvolvedores, equipes de produto e plataformas que precisam integrar rapidamente LLMs de múltiplos provedores, realizar testes comparativos entre modelos, escalar aplicações conversacionais e evitar dependência de um único fornecedor. Útil para startups, scale-ups e empresas que desejam acelerar P&D em IA, além de consultorias e integradoras que gerenciam diferentes stacks de clientes.

Como usar AiHubMix

- Obtenha uma chave de API e credenciais conforme as instruções do serviço.

- Configure seu cliente usando o padrão da API OpenAI (por exemplo, endpoints de chat/completions).

- Escolha o model desejado (ex.: OpenAI, Gemini, DeepSeek, Llama, Qwen, Claude, Moonshot, Cohere) conforme o caso de uso.

- Envie a requisição com os parâmetros usuais (mensagens, temperatura, top_p, etc.) e o cabeçalho de autenticação.

- Receba a resposta no formato compatível e trate mensagens, tokens e metadados como faria com a API OpenAI.

- Itere e troque de modelo alterando apenas o identificador, sem refatorar o restante da aplicação.

Casos de uso de AiHubMix no setor

No varejo e e-commerce, alternar entre modelos para chatbots de atendimento e busca conversacional; em mídia e conteúdo, comparar qualidade de redação, resumo e tradução em diferentes LLMs; em edtech, personalizar tutores com modelos específicos de raciocínio; em SaaS B2B, padronizar integrações multi-fornecedor e garantir resiliência; em P&D, conduzir testes A/B rápidos para escolher o melhor custo-benefício por tarefa.

Vantagens e desvantagens de AiHubMix

Vantagens:

- API unificada compatível com OpenAI, reduzindo retrabalho.

- Acesso a diversos modelos líderes em um único ponto.

- Suporte a versões mais recentes sem mudanças profundas no código.

- Concorrência ilimitada para cargas de alto volume.

- Menos acoplamento a um único fornecedor de IA.

Desvantagens:

- Camada adicional pode introduzir latência em alguns cenários.

- Comportamentos e limites variam entre provedores e modelos.

- Recursos muito específicos de um provedor podem ter compatibilidade parcial.

- Dependência de um serviço intermediário para roteamento das chamadas.

Perguntas frequentes sobre AiHubMix

-

Quais provedores e modelos são suportados?

Conforme divulgado, há suporte a OpenAI, Google Gemini, DeepSeek, Llama, Qwen (Alibaba), Claude, Moonshot e Cohere.

-

Preciso reescrever meu código para mudar de modelo?

Em geral, não. O padrão da API OpenAI permite alternar o identificador de modelo mantendo a mesma estrutura de chamadas.

-

O serviço suporta alta escala e picos de tráfego?

Sim, o AiHubMix informa oferecer concorrência ilimitada, o que facilita operações em grande volume.

-

Como garantir compatibilidade com recursos específicos (funções, imagens, etc.)?

A compatibilidade depende do modelo escolhido. Verifique a documentação do provedor e teste o comportamento no endpoint unificado.

-

Posso usar meus SDKs OpenAI existentes?

Sim, a compatibilidade com o padrão da OpenAI permite reaproveitar SDKs e padrões já adotados.