- Trang chủ

- Kỹ Thuật Prompt

- Vellum

Vellum

Mở trang web-

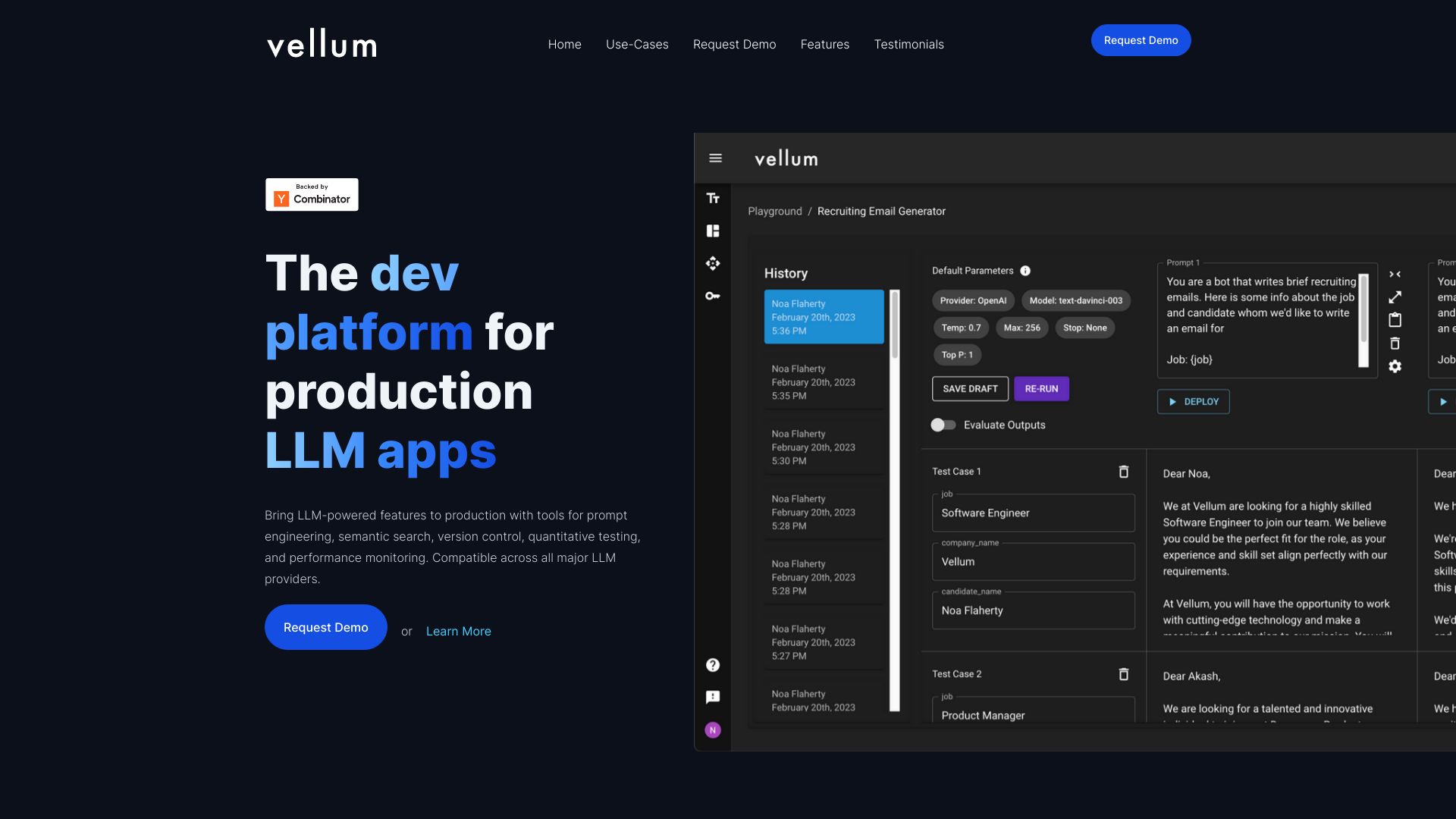

Giới thiệu công cụ:Thiết kế, thử nghiệm và triển khai AI: workflow trực quan, theo dõi.

-

Ngày thêm:2025-10-21

-

Mạng xã hội & Email:

Thông tin công cụ

Vellum AI là gì

Vellum AI là nền tảng LLMOps giúp đội ngũ xây dựng sản phẩm AI đưa ý tưởng từ thử nghiệm ban đầu tới tính năng đạt chuẩn sản xuất. Tất cả trong một: thử nghiệm và so sánh prompt, đánh giá chất lượng bằng bộ chỉ số, trình xây dựng quy trình trực quan, SDK để tích hợp, UI/API truy xuất (RAG), triển khai một nhấp chuột và quan sát/monitoring để theo dõi quyết định của mô hình. Vellum AI tập trung vào khả năng lặp nhanh, hợp tác đa nhóm, kiểm soát phiên bản và khả năng quan sát đầu–cuối, giúp rút ngắn thời gian ra mắt, nâng độ tin cậy và kiểm soát chi phí lẫn độ trễ trong môi trường thực.

Tính năng chính của Vellum AI

- Visual Workflow Builder: Kéo–thả để thiết kế luồng xử lý LLM, RAG và hậu xử lý, giảm sai sót cấu hình và tăng tốc triển khai.

- Bộ công cụ Prompt Engineering: Templating với biến, phiên bản hóa, ghi chú thay đổi, so sánh nhiều prompt/mô hình trong cùng ngữ cảnh.

- Đánh giá có hệ thống: Dataset kiểm thử, chỉ số định lượng (exact match, tương đồng ngữ nghĩa) và rubric LLM-as-judge để chấm điểm nhất quán.

- Thử nghiệm A/B và định tuyến: Chạy A/B test, tối ưu chọn mô hình hoặc tuyến logic theo chất lượng, chi phí và độ trễ.

- Retrieval UI & API (RAG): Xây dựng giao diện truy xuất và API cho tìm kiếm ngữ nghĩa/nhúng, gắn vào quy trình suy luận.

- SDK và API: Tích hợp nhanh vào ứng dụng qua SDK, quản lý môi trường, biến cấu hình và khóa nhà cung cấp mô hình.

- Triển khai một nhấp chuột: Đóng gói luồng thành endpoint chạy sản xuất để gọi từ backend, ứng dụng hoặc automation.

- Observability end-to-end: Log/trace từng lượt gọi, diff prompt/response, theo dõi chi phí, độ trễ, tỉ lệ lỗi và cảnh báo hồi quy.

- Hợp tác và quản trị: Chia sẻ dự án, nhận xét, kiểm soát truy cập, lịch sử phiên bản và quy trình phê duyệt thay đổi.

Vellum AI phù hợp với ai

Phù hợp với product manager, kỹ sư ML/ML Ops, data scientist, prompt engineer và các nhóm phát triển sản phẩm AI cần một nền tảng thống nhất để thử nghiệm, đánh giá, triển khai và giám sát mô hình. Cũng hữu ích cho doanh nghiệp tích hợp RAG vào tìm kiếm tri thức nội bộ, đội CS xây chatbot hỗ trợ khách hàng, và startup muốn rút ngắn thời gian đưa tính năng AI ra thị trường.

Cách sử dụng Vellum AI

- Tạo workspace/dự án và kết nối nhà cung cấp mô hình (ví dụ: cung cấp API key cần thiết).

- Thiết kế luồng trong visual workflow builder: truy xuất dữ liệu, gọi LLM, hậu xử lý và trả kết quả.

- Tạo prompt template, thêm biến động và quản lý phiên bản để dễ lặp và so sánh.

- Chuẩn bị dataset kiểm thử; định nghĩa tiêu chí và chỉ số đánh giá (exact match, tương đồng ngữ nghĩa, rubric).

- Chạy thí nghiệm/A-B test giữa nhiều prompt hoặc mô hình và phân tích kết quả.

- Thiết lập Retrieval UI/API nếu dùng RAG, gắn vào luồng suy luận.

- Triển khai one-click thành endpoint; tích hợp vào ứng dụng qua SDK hoặc API.

- Giám sát log, chi phí, độ trễ; đặt cảnh báo và tối ưu định tuyến khi cần.

- Hợp tác với nhóm: nhận xét, phê duyệt thay đổi, rollback khi chất lượng giảm.

Trường hợp sử dụng theo ngành

Thương mại điện tử: trợ lý mua sắm dùng RAG để trả lời chính xác về tồn kho, chính sách và đặc tả sản phẩm. Dịch vụ tài chính: tự động tóm tắt tài liệu và phân luồng yêu cầu, kèm đánh giá chất lượng và nhật ký phục vụ kiểm tra nội bộ. Hỗ trợ khách hàng: chatbot và tác nhân AI có A/B test liên tục để tối ưu CSAT, chi phí và độ trễ. Doanh nghiệp SaaS: tìm kiếm tri thức nội bộ (RAG) trên tài liệu kỹ thuật, giảm thời gian tra cứu của đội kỹ thuật và bán hàng.

Mô hình tính phí của Vellum AI

Vellum AI thường áp dụng mô hình đăng ký theo quy mô và tính năng, có thể kết hợp yếu tố mức sử dụng (số lượt gọi/endpoint, người dùng, môi trường). Doanh nghiệp thường liên hệ đội ngũ bán hàng để nhận báo giá phù hợp nhu cầu và khối lượng. Một số tính năng cao cấp như đánh giá nâng cao, observability mở rộng hoặc cộng tác ở quy mô lớn có thể nằm trong gói cao hơn; các điều khoản và bản dùng thử có thể thay đổi theo thời điểm.

Ưu điểm và nhược điểm của Vellum AI

Ưu điểm:

- Nền tảng LLMOps hợp nhất từ thử nghiệm, đánh giá đến triển khai và giám sát.

- Visual builder giảm công sức tích hợp, tăng tốc đưa tính năng AI vào sản xuất.

- Khả năng đánh giá sâu với dataset, metric định lượng và rubric LLM-as-judge.

- Observability chi tiết: log, trace, diff, chi phí và độ trễ theo thời gian.

- SDK/API linh hoạt, hỗ trợ lặp nhanh và kiểm soát phiên bản rõ ràng.

- Hợp tác và quản trị giúp quy trình phát triển minh bạch, có thể kiểm toán.

Nhược điểm:

- Chi phí có thể tăng theo quy mô lưu lượng và số tính năng theo dõi.

- Cần đầu tư công sức xây dataset và tiêu chí đánh giá chuẩn hóa ban đầu.

- Độ linh hoạt hạ tầng bị giới hạn so với tự dựng nếu yêu cầu tùy biến đặc thù.

- Phụ thuộc vào tích hợp nhà cung cấp mô hình và chính sách API của bên thứ ba.

Câu hỏi phổ biến về Vellum AI

-

Vellum AI khác gì so với công cụ MLOps truyền thống?

Vellum AI tập trung vào LLMOps: prompt engineering, đánh giá dựa trên ngôn ngữ, RAG, A/B test và quan sát đầu–cuối cho mô hình ngôn ngữ, thay vì chỉ CICD/hạ tầng như MLOps truyền thống.

-

Vellum AI có hỗ trợ nhiều nhà cung cấp LLM không?

Có. Nền tảng được thiết kế mô hình-agnostic, cho phép thử nghiệm và hoán đổi nhiều mô hình/nhà cung cấp trong cùng quy trình để tối ưu chi phí và chất lượng.

-

Làm thế nào để đánh giá chất lượng trên Vellum AI?

Bạn tạo dataset kiểm thử, định nghĩa metric (exact match, tương đồng ngữ nghĩa) và/hoặc rubric LLM-as-judge, sau đó chạy thí nghiệm để so sánh prompt/mô hình và xem báo cáo.

-

Vellum AI có hỗ trợ RAG không?

Có, với UI/API truy xuất để tích hợp tìm kiếm ngữ nghĩa/nhúng vào luồng suy luận, giúp nâng độ chính xác trên dữ liệu riêng của doanh nghiệp.

-

Có theo dõi chi phí và độ trễ theo thời gian thực không?

Có, hệ thống observability cung cấp log/trace, thống kê chi phí, độ trễ và cảnh báo để phát hiện hồi quy chất lượng hoặc vượt ngân sách.