- Inicio

- Ingeniería de Prompt

- Vellum

Vellum

Abrir sitio web-

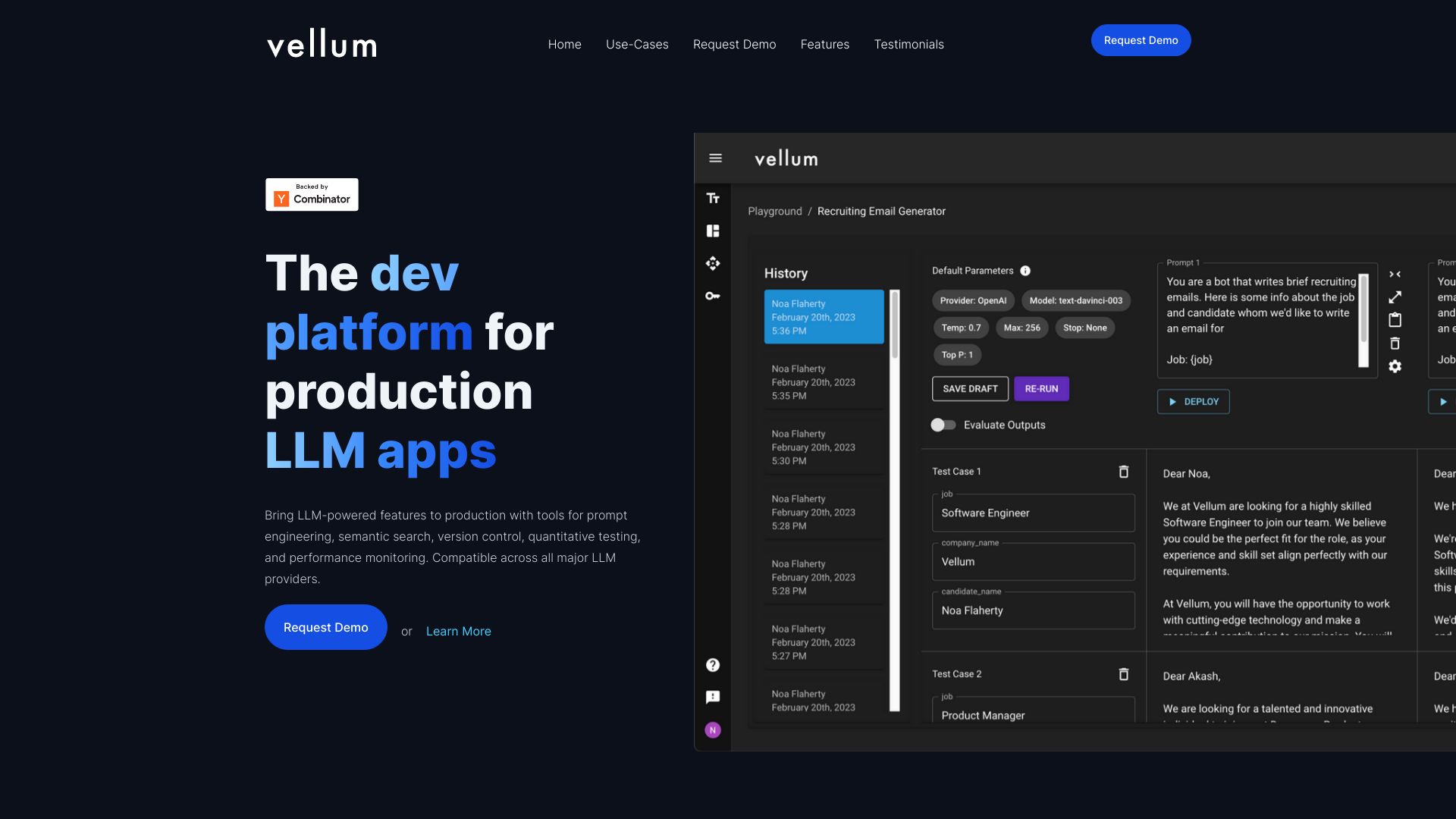

Introducción de la herramienta:Crea, evalúa y lanza funciones de IA con flujos visuales y métricas.

-

Fecha de inclusión:2025-10-21

-

Redes sociales y correo electrónico:

Información de la herramienta

¿Qué es Vellum AI?

Vellum AI es una plataforma diseñada para ayudar a desarrolladores de productos de IA a llevar sus ideas desde conceptos tempranos hasta funciones listas para producción. Centraliza la experimentación, la evaluación, el despliegue, el monitoreo y la colaboración en un solo lugar. Con un constructor visual de flujos, un SDK y herramientas de ingeniería de prompts, permite crear y optimizar pipelines de LLM y RAG, medir su rendimiento con métricas claras y desplegarlos con un clic, todo con observabilidad para rastrear decisiones.

Principales características de Vellum AI

- Constructor visual de flujos: orquesta pasos de retrieval, prompts, herramientas y lógica condicional para crear pipelines de IA sin fricción.

- SDK y APIs: integra la plataforma en aplicaciones existentes y automatiza experimentos y despliegues desde tu código.

- Ingeniería de prompts: versionado, plantillas y pruebas controladas para iterar con rapidez y consistencia.

- Evaluación y métricas: seguimiento de calidad, latencia y coste, con comparativas y A/B testing para elegir la mejor configuración.

- UIs y APIs de recuperación (RAG): construcción de experiencias de búsqueda contextual y context injection de forma reproducible.

- Despliegue con un clic: pasa de entorno de pruebas a producción y expone endpoints listos para consumir.

- Observabilidad de extremo a extremo: trazabilidad de llamadas, auditoría y monitoreo de decisiones del modelo.

- Colaboración: trabajo coordinado entre producto, datos e ingeniería con visibilidad compartida de flujos y resultados.

- Versionado y control de cambios: gestiona iteraciones de prompts y flujos para mantener reproducibilidad.

¿Para quién es Vellum AI?

Está orientada a desarrolladores de productos de IA, ingenieros de ML/LLMOps, product managers y equipos de datos que necesitan pasar de prototipos a producción de forma segura. Es útil para startups que experimentan con LLMs y para empresas que requieren evaluación rigurosa, observabilidad y despliegue confiable de asistentes, RAG, automatización de documentos o copilotos dentro de sus aplicaciones.

Cómo usar Vellum AI

- Regístrate e ingresa al panel para crear tu primer proyecto.

- Conecta tus modelos y fuentes de datos mediante el SDK o las APIs.

- Diseña el pipeline en el constructor visual añadiendo nodos de recuperación, prompts y herramientas.

- Configura variables, plantillas y criterios de evaluación que reflejen tus objetivos.

- Ejecuta experimentos y pruebas A/B con conjuntos de ejemplos representativos.

- Analiza métricas y trazas en los paneles de observabilidad y ajusta el flujo.

- Realiza el despliegue con un clic para obtener endpoints de producción.

- Monitorea el comportamiento en vivo, colabora con tu equipo e itera de forma continua.

Casos de uso de Vellum AI en la industria

En atención al cliente, permite crear asistentes con RAG que reducen tiempos de respuesta y se evalúan con métricas objetivas; en comercio electrónico, impulsa búsqueda semántica y respuestas contextualizadas con monitorización de calidad; en banca y seguros, automatiza la lectura y síntesis de documentos con trazabilidad de decisiones; en SaaS, acelera el desarrollo de copilotos y flujos de IA con pruebas A/B y despliegue controlado; en marketing y legal, estandariza generación y revisión de textos con evaluación reproducible.

Ventajas y desventajas de Vellum AI

Ventajas:

- Pasar de prototipo a producción en una plataforma unificada.

- Experimentación y evaluación con métricas para decisiones basadas en datos.

- Despliegue con un clic y endpoints listos para integrar.

- Observabilidad y trazabilidad para auditoría y mejora continua.

- Flujos versionables y colaboración entre equipos técnicos y de producto.

- SDK y APIs que facilitan la integración en sistemas existentes.

Desventajas:

- Curva de aprendizaje para equipos sin experiencia en LLMOps.

- Dependencia de un proveedor externo y posibles límites de personalización.

- El coste puede crecer con el volumen de llamadas y el nivel de monitoreo requerido.

- Integraciones con sistemas heredados pueden requerir trabajo adicional.

Preguntas frecuentes sobre Vellum AI

-

¿Qué diferencia a Vellum AI de un framework de código abierto?

Ofrece una suite integrada con UI, evaluación, despliegue y observabilidad, reduciendo el tiempo de integración y operación.

-

¿Puedo usar mis propios modelos o proveedores externos?

Sí. La plataforma permite conectar modelos y fuentes de datos mediante su SDK y APIs para integrarse en tu backend.

-

¿Cómo se evalúa la calidad de las respuestas?

Mediante métricas cuantitativas, comparativas y pruebas A/B sobre conjuntos de ejemplos que representan tus casos reales.

-

¿Incluye monitoreo en producción?

Sí. Dispone de observabilidad y trazas que permiten seguir decisiones, latencia y comportamiento del modelo en tiempo real.

-

¿Necesito escribir mucho código para empezar?

No necesariamente. Puedes prototipar con el constructor visual y profundizar con el SDK cuando requieras automatización e integración avanzada.