- Startseite

- Prompt Engineering

- Vellum

Vellum

Website öffnen-

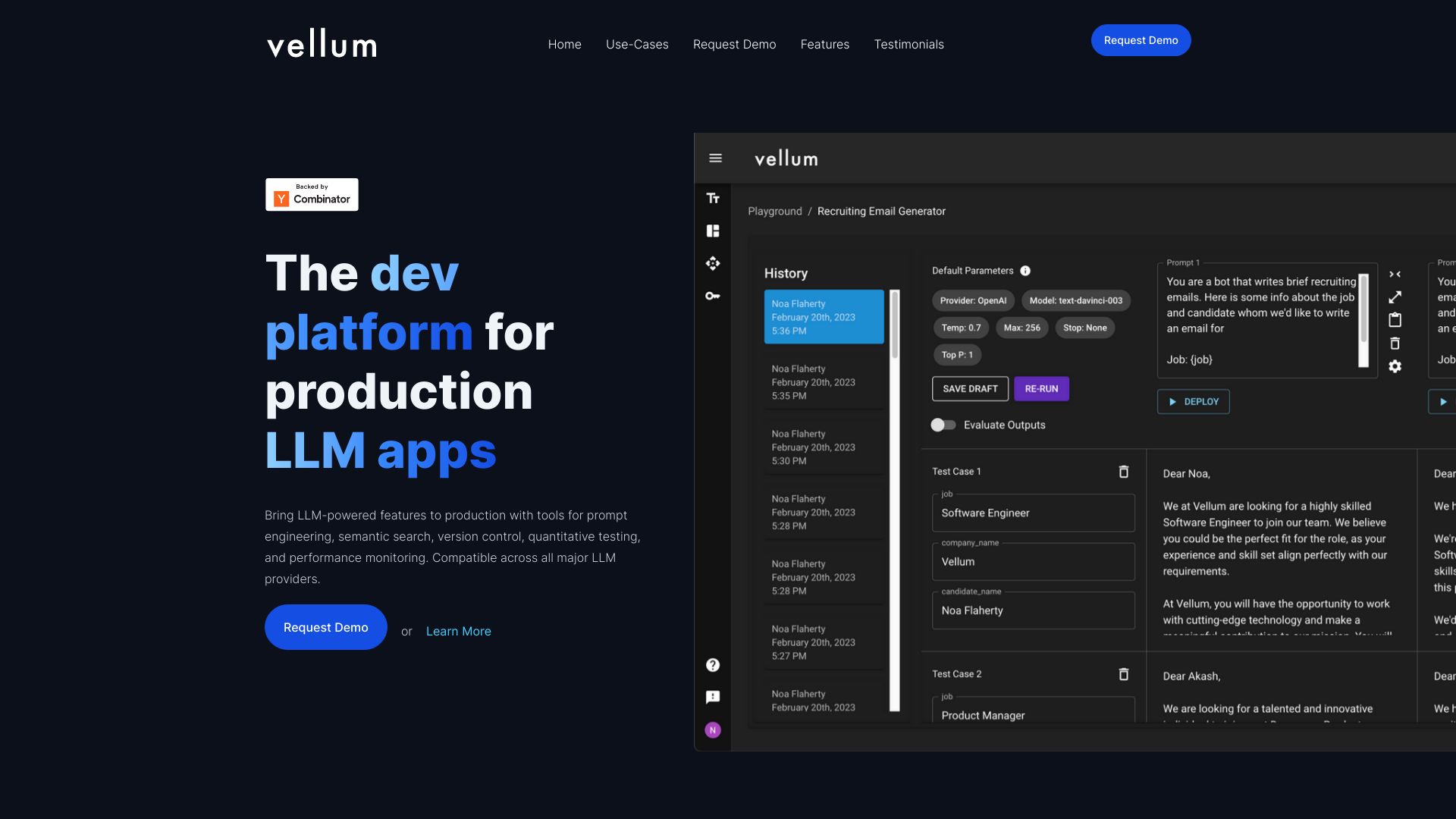

Tool-Einführung:KI-Features entwerfen, testen und ausrollen – mit Workflows und Monitoring.

-

Aufnahmedatum:2025-10-21

-

Soziale Medien & E-Mail:

Tool-Informationen

Was ist Vellum AI

Vellum AI ist eine Plattform, die Teams hilft, KI-Funktionen von der Idee bis zur Produktion zu entwickeln. In einer zentralen Umgebung bündelt Vellum Experimentieren, Evaluierung, Deployment, Monitoring und Kollaboration. Mit visuellem Workflow-Builder, SDK und API, Tools für Prompt‑Engineering, Metriken zur Qualitätsmessung sowie Retrieval‑UIs und -APIs beschleunigt die Lösung den gesamten LLMOps‑Lebenszyklus. One‑Click‑Deployment und umfassende Observability machen Modellentscheidungen nachvollziehbar und skalierbar.

Hauptfunktionen von Vellum AI

- Visueller Workflow‑Builder: Orchestrieren Sie LLMs, Retrieval und Logik per Drag‑and‑Drop für reproduzierbare Pipelines.

- Prompt‑Engineering: Versionierung, Tests und Vergleich von Prompts zur systematischen Qualitätssteigerung.

- Evaluierung & Metriken: Definieren Sie Kennzahlen, bewerten Sie Ausgaben und führen Sie A/B‑Tests auf Datensätzen durch.

- Retrieval‑UIs & APIs: Schnelle Umsetzung von RAG‑Szenarien mit anbindbaren Datenquellen.

- SDK & API: Integration in bestehende Anwendungen und CI/CD‑Prozesse über Programmierschnittstellen.

- One‑Click‑Deployment: Übergang von Prototypen zu produktiven Endpunkten ohne komplexe Infrastruktur.

- Observability & Monitoring: Tracing, Protokolle und Metriken für transparente Modellentscheidungen.

- Kollaboration: Gemeinsame Arbeitsbereiche, Reviews und geteilte Artefakte für Produkt‑ und Entwicklerteams.

Für wen ist Vellum AI geeignet

Vellum AI richtet sich an Produktteams, ML‑ und Software‑Entwickler, Data Scientists und Produktmanager, die LLM‑Features zuverlässig in Produktion bringen wollen. Ideal für Start-ups und Enterprise‑Teams, die Prototypen schnell iterieren, Evaluierungen standardisieren, RAG‑Workflows bauen und Modellentscheidungen überwachen möchten.

Wie man Vellum AI verwendet

- Projekt anlegen und gewünschte Modelle sowie Datenquellen verbinden.

- Mit dem Workflow‑Builder die Pipeline aus Prompt, Retrieval, Logik und Ausgaben aufbauen.

- Prompts entwerfen, versionieren und mit Testfällen anreichern.

- Evaluierung konfigurieren: Datensätze, Metriken und A/B‑Vergleiche definieren.

- Experimente ausführen, Ergebnisse analysieren und Prompts/Parameter optimieren.

- One‑Click‑Deployment auf produktive Endpunkte durchführen.

- Über Observability Laufzeit, Kosten und Qualität überwachen und iterativ verbessern.

- Mit Teammitgliedern Artefakte teilen und Freigaben koordinieren.

Branchenspezifische Anwendungsfälle von Vellum AI

E‑Commerce: Produktsuche, Beratung und personalisierte Empfehlungen mit RAG. Fintech: Zusammenfassungen, Dokumentenprüfung und regelkonforme Antworten. Kundenservice: Intelligente Assistants, Antwortvorschläge und Ticketklassifikation. SaaS: In‑App‑Copilots, Onboarding‑Hilfen und Wissensabfragen. Recht & Compliance: Strukturierte Extraktion und Analyse langer Dokumente. Bildung: Tutor‑Bots mit kuratierten Inhalten und Prüfungs‑Feedback.

Preismodell von Vellum AI

Die Preisgestaltung richtet sich nach Funktionsumfang und Teamanforderungen. Genaue Konditionen, Limits und Informationen zu möglichen Testphasen sind auf der offiziellen Website des Anbieters einsehbar.

Vorteile und Nachteile von Vellum AI

Vorteile:

- End‑to‑End‑Plattform für LLMOps von Experiment bis Produktion.

- Schnelle Iteration dank visuellem Workflow‑Builder und Prompt‑Versionierung.

- Fundierte Qualitätskontrolle durch Evaluierung, Metriken und A/B‑Tests.

- One‑Click‑Deployment und stabile API/SDK‑Integration.

- Transparenz durch Observability, Tracing und Monitoring.

- Effiziente Teamarbeit durch Kollaborationsfunktionen.

Nachteile:

- Lernkurve für Teams ohne Erfahrung mit LLMOps und Evaluierung.

- Zusätzliche Plattformabhängigkeit im Vergleich zu Eigenbau‑Stacks.

- Nicht jedes Edge‑Case ist so flexibel wie vollständig maßgeschneiderte Lösungen.

- Prüfbedarf zu Datenschutz und Governance je nach Branche und Datenlage.

Häufige Fragen zu Vellum AI

Unterstützt Vellum AI RAG‑Workflows?

Ja, über Retrieval‑UIs und -APIs lassen sich Wissensquellen anbinden und Abfragen strukturiert orchestrieren.

Benötige ich Programmierkenntnisse?

Für Integrationen über SDK/API sind sie hilfreich; der visuelle Workflow‑Builder ermöglicht jedoch viele Schritte ohne Code.

Wie wird Qualität bewertet?

Per definierten Metriken, Testdatensätzen und A/B‑Vergleichen, um Prompts und Parameter objektiv zu optimieren.

Kann ich bestehende Apps anbinden?

Ja, über das SDK und die API lässt sich Vellum in bestehende Anwendungen und Pipelines integrieren.

Wie behalte ich Modellentscheidungen im Blick?

Observability‑ und Monitoring‑Funktionen liefern Traces, Protokolle und Kennzahlen für nachvollziehbare Entscheidungen.