- Accueil

- Prompt Engineering

- Vellum

Vellum

Site web ouvert-

Présentation de l'outil:Concevez, évaluez et déployez des IA avec workflows visuels et suivi.

-

Date d'inclusion:2025-10-21

-

Réseaux sociaux et e-mails:

Informations sur l'outil

Qu’est-ce que Vellum AI

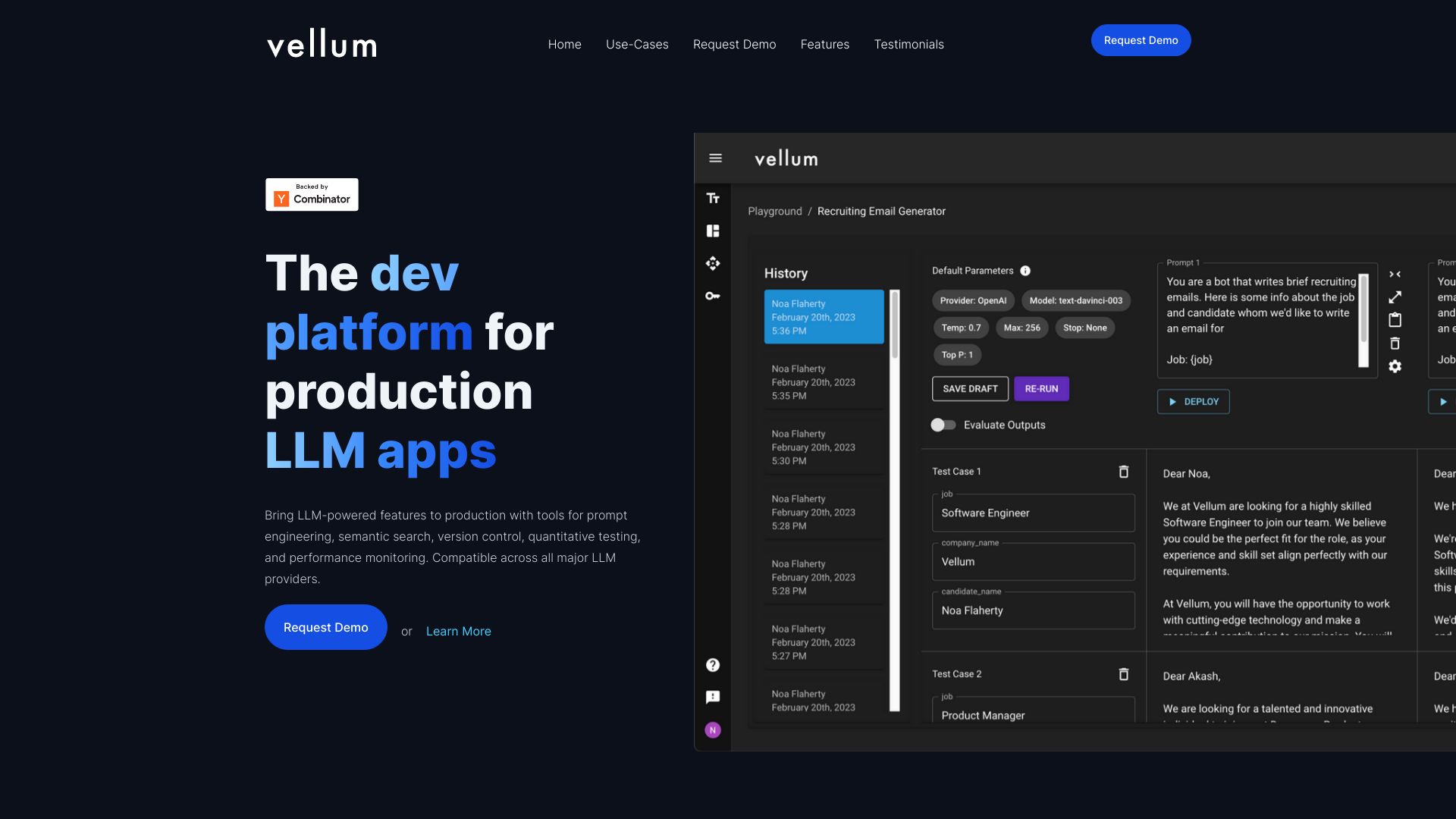

Vellum AI est une plateforme conçue pour aider les équipes à transformer des idées d’outils IA en fonctionnalités prêtes pour la production. Elle centralise l’expérimentation, l’évaluation, le déploiement, la surveillance et la collaboration au même endroit. Avec un constructeur visuel de flux, un SDK, des outils d’ingénierie de prompts, des métriques d’évaluation, des interfaces et API de récupération de contexte (RAG), le déploiement en un clic et l’observabilité, Vellum AI accélère le passage du prototype à la mise en production en assurant performance, traçabilité et itérations rapides.

Fonctionnalités principales de Vellum AI

- Constructeur visuel de flux : modélisez et orchestrez des pipelines IA avec des blocs réutilisables pour concevoir, tester et itérer sans friction.

- Ingénierie de prompts : versionnez, comparez et optimisez les prompts avec des jeux de tests, des notations et des benchmarks reproductibles.

- Métriques d’évaluation : mesurez qualité, exactitude et robustesse avec des indicateurs quantitatifs et qualitatifs pour guider les décisions.

- Récupération de contexte (RAG) : interfaces et API pour connecter vos sources et améliorer les réponses via la recherche de passages pertinents.

- SDK et API : intégrez facilement les flux dans vos applications, automatisez les tests et connectez vos services existants.

- Déploiement en un clic : passez du prototype à la production rapidement avec des environnements gérés et des versions verrouillées.

- Observabilité et monitoring : suivez les décisions des modèles, les coûts, la latence et les dérives pour diagnostiquer et améliorer en continu.

- Collaboration : partage de projets, commentaires et historique pour aligner équipes produit, data et ingénierie.

À qui s’adresse Vellum AI

Vellum AI s’adresse aux équipes produit IA, data scientists, ingénieurs machine learning, responsables techniques et concepteurs d’assistants conversationnels. Il convient aux startups comme aux organisations établies qui souhaitent industrialiser des fonctionnalités IA (RAG, chatbots, classification, extraction) tout en gardant une traçabilité et une qualité mesurables.

Comment utiliser Vellum AI

- Créer un espace de travail et définir votre objectif (cas d’usage, métriques, données de test).

- Construire le flux dans le constructeur visuel et/ou via le SDK selon vos besoins.

- Concevoir et versionner les prompts, puis préparer des scénarios d’évaluation.

- Brancher les sources pour la récupération de contexte (RAG) via les interfaces et API.

- Lancer des expériences, comparer les variantes et analyser les métriques.

- Déployer en un clic la version retenue et intégrer via API/SDK dans votre application.

- Surveiller les performances (coûts, latence, exactitude) et itérer en continu.

- Collaborer avec l’équipe en partageant résultats, commentaires et historiques.

Cas d’utilisation de Vellum AI

Exemples concrets : centre de support avec RAG pour répondre aux questions clients à partir de bases documentaires ; chatbots internes pour la recherche de politiques et procédures ; classification et routage de tickets ; assistance à la rédaction avec prompts versionnés et évalués ; extraction d’informations clés depuis des documents longs ; génération de résumés et réponses auditables avec observabilité et contrôle qualité.

Tarification de Vellum AI

Les détails de tarification ne sont pas précisés ici. Pour connaître les formules disponibles, les modalités d’accès et l’éventuelle existence d’une période d’essai, veuillez contacter l’éditeur ou demander une démonstration.

Avantages et inconvénients de Vellum AI

Avantages :

- Plateforme unifiée du prototype à la production, réduisant le temps de mise sur le marché.

- Observabilité et traçabilité fines pour comprendre et améliorer les décisions des modèles.

- Constructeur visuel + SDK/API pour couvrir à la fois les profils no-code/low-code et développeurs.

- Évaluation intégrée avec métriques et comparaisons pour des décisions fondées sur des données.

- Collaboration et versionnage pour des itérations rapides et contrôlées.

Inconvénients :

- Courbe d’apprentissage initiale pour tirer parti de l’ensemble des fonctionnalités.

- Dépendance à une plateforme tierce pour l’orchestration et le monitoring.

- Coûts potentiellement liés au volume et aux environnements de production.

- Intégrations et paramétrages initiaux nécessaires selon les systèmes existants.

Questions fréquentes sur Vellum AI

-

Quels types de cas d’usage puis-je prototyper et déployer avec Vellum AI ?

RAG, assistants conversationnels, classification, extraction d’informations, génération de textes et pipelines hybrides mêlant règles et modèles.

-

Comment Vellum AI aide-t-il à améliorer la qualité des sorties ?

Grâce à l’évaluation structurée, au versionnage de prompts, aux tests comparatifs et à l’observabilité en production pour détecter et corriger les écarts.

-

Puis-je intégrer Vellum AI à mes applications existantes ?

Oui, via le SDK et les API, ce qui facilite l’orchestration des flux et l’automatisation des tests et déploiements.

-

Vellum AI prend-il en charge la récupération de contexte (RAG) ?

Oui, la plateforme propose des interfaces et API dédiées pour connecter des sources et améliorer les réponses par récupération de passages pertinents.