- ホーム

- プロンプトエンジニアリング

- Vellum

Vellum

ウェブサイトを開く-

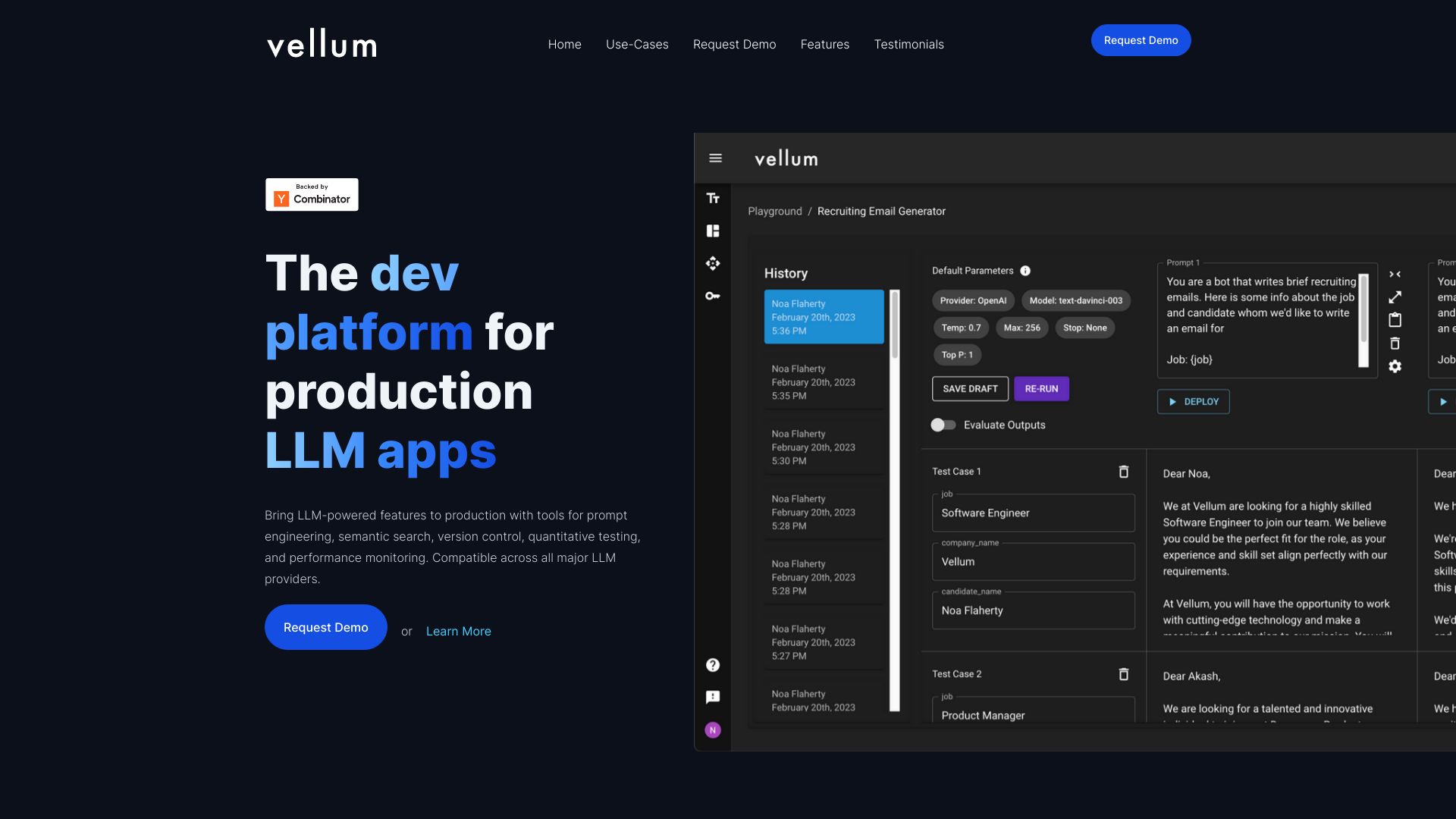

ツール紹介:AI機能を設計・評価・デプロイ。可視化フロー、プロンプト設計、SDK、評価指標、可観測性、監視、ワンクリック展開で本番運用。

-

登録日:2025-10-21

-

ソーシャルメディアとメール:

ツール情報

Vellum AIとは?

Vellum AIは、AIプロダクト開発者が早期のアイデアを本番運用レベルの機能へと磨き上げるための統合プラットフォームです。実験、評価、デプロイ、監視、コラボレーションを一元化し、LLMアプリケーション開発の反復を素早く、かつ再現性の高い形で進められるよう設計されています。主な要素には、ビジュアルなワークフロービルダー、SDK、プロンプトエンジニアリング支援、評価指標やA/Bテスト、RAG向けの取得UI・API、ワンクリックデプロイ、そしてAIの意思決定を追跡する可観測性(オブザーバビリティ)ツールが含まれます。これにより、チームは仮説検証から本番配備までをスムーズに繋ぎ、品質とスピードの両立、運用時のモニタリングと改善を継続的に実現できます。

Vellum AIの主な機能

- ビジュアルワークフロービルダー:ドラッグ&ドロップでLLMやツール呼び出し、RAGステップを接続し、複雑なパイプラインを可視化。

- プロンプトエンジニアリング:バージョニング、テンプレート化、パラメータ管理により再現性の高いプロンプト設計を支援。

- 評価・実験:評価指標、テストデータ、A/Bテストで出力品質を比較・検証し、最適な構成を選定。

- SDK・API:既存アプリに容易に統合できるクライアントSDKとエンドポイントを提供。

- RAGサポート:取得用UIとAPIで検索・埋め込み・コンテキスト付与の運用を簡素化。

- ワンクリックデプロイ:実験から本番エンドポイントへの移行を迅速化。

- 監視・可観測性:ログ、トレース、メトリクスでAIの意思決定を可視化し、品質劣化やドリフトを検知。

- コラボレーション:チームでのレビュー、共有、変更履歴管理により開発効率を向上。

Vellum AIの対象ユーザー

対象は、LLMを活用した機能を素早く検証し、運用まで持ち込みたいプロダクトチーム全般です。具体的には、プロダクトマネージャー、ML/ソフトウェアエンジニア、データサイエンティスト、プロンプトエンジニア、デザイン/リサーチ担当者、スタートアップからエンタープライズまでのプラットフォームチームに適しています。PoCからスケール段階へ移行するSaaS、カスタマーサポート自動化、ドキュメント要約・検索(RAG)、コンテンツ生成や審査フローの自動化など、多様な利用シーンで効果を発揮します。

Vellum AIの使い方

- アカウントを作成し、ワークスペース/プロジェクトを新規作成します。

- 利用するモデルや外部データソースとの接続設定を行います。

- ビジュアルワークフロービルダーでプロンプト、ツール呼び出し、RAGステップを組み立てます。

- テストデータと評価指標を用意し、バリアントを作成して実験を実行します。

- A/Bテストや評価メトリクスで結果を比較し、最適な構成を決定します。

- 選定した構成をワンクリックで本番エンドポイントとしてデプロイします。

- SDKまたはAPIで自社アプリケーションに統合します。

- ログ/トレース/メトリクスを監視し、ドリフトや品質劣化を検知したらプロンプトやワークフローを改善します。

Vellum AIの業界での活用事例

ECでは、商品QAや注文対応のチャットボットをA/Bテストで継続改善し、ピーク時も安定運用。SaaSでは、ドキュメント要約や返信文案のアシスト機能をワンクリックでエンドポイント化し、フロントエンドへ迅速に提供。カスタマーサクセスでは、RAGを活用したナレッジ検索で一次回答の品質を平準化。コンプライアンスが重要な業務では、評価基準とガードレールを設定し、出力の一貫性と監査可能性を確保するなど、開発から運用までのライフサイクル改善に寄与します。

Vellum AIの料金プラン

料金は、利用規模や機能範囲(実験・評価の実行量、デプロイされたエンドポイント数、ログ保持期間、席数など)に応じて変動する構成が想定されます。導入形態や必要なサポートレベルによっても条件が変わるため、最新のプランと見積もりは公式情報を確認するのが確実です。期間限定のトライアルや評価用の枠が提供される場合もあるため、導入前に最新の提供内容をチェックするとよいでしょう。

Vellum AIのメリットとデメリット

メリット:

- 実験・評価・デプロイ・監視を一気通貫で管理でき、開発スピードと再現性が向上。

- ビジュアルワークフローとプロンプトのバージョニングで品質管理が容易。

- 評価指標とA/Bテストにより、定量的な意思決定が可能。

- SDKとAPIで既存システムへの統合がスムーズ。

- 可観測性により本番運用での不具合検知と継続的改善が行いやすい。

デメリット:

- プラットフォームへの依存度が高まるため、アーキテクチャの自由度に制約が生じる可能性。

- 導入・運用に一定の学習コストが発生。

- 外部サービスとの連携設定や権限管理など、初期構築の負荷がかかる場合がある。

- 利用量に応じてコストが変動しやすく、モニタリングや予算管理が必要。

Vellum AIに関するよくある質問

質問:Vellum AIは何が得意ですか?

アイデア検証から本番運用まで、LLMアプリ開発のライフサイクルを一元化し、実験・評価・デプロイ・監視を素早く回す点が強みです。

質問:既存アプリにどう統合しますか?

提供されるSDKやAPIでエンドポイントを呼び出し、アプリ側のフローに組み込みます。ワークフローの更新は再デプロイで反映できます。

質問:RAGはサポートされていますか?

取得用のUIとAPIが用意されており、検索・コンテキスト付与をワークフローに組み込んで運用できます。

質問:品質はどのように評価しますか?

評価指標やテストデータ、A/Bテストを用いて、プロンプトやモデル構成の候補を比較・選定します。

質問:運用時の監視は可能ですか?

ログやトレース、メトリクスによる可観測性機能で、意思決定の可視化やエラー検知、継続的な改善が可能です。