LiteLLM

Mở trang web-

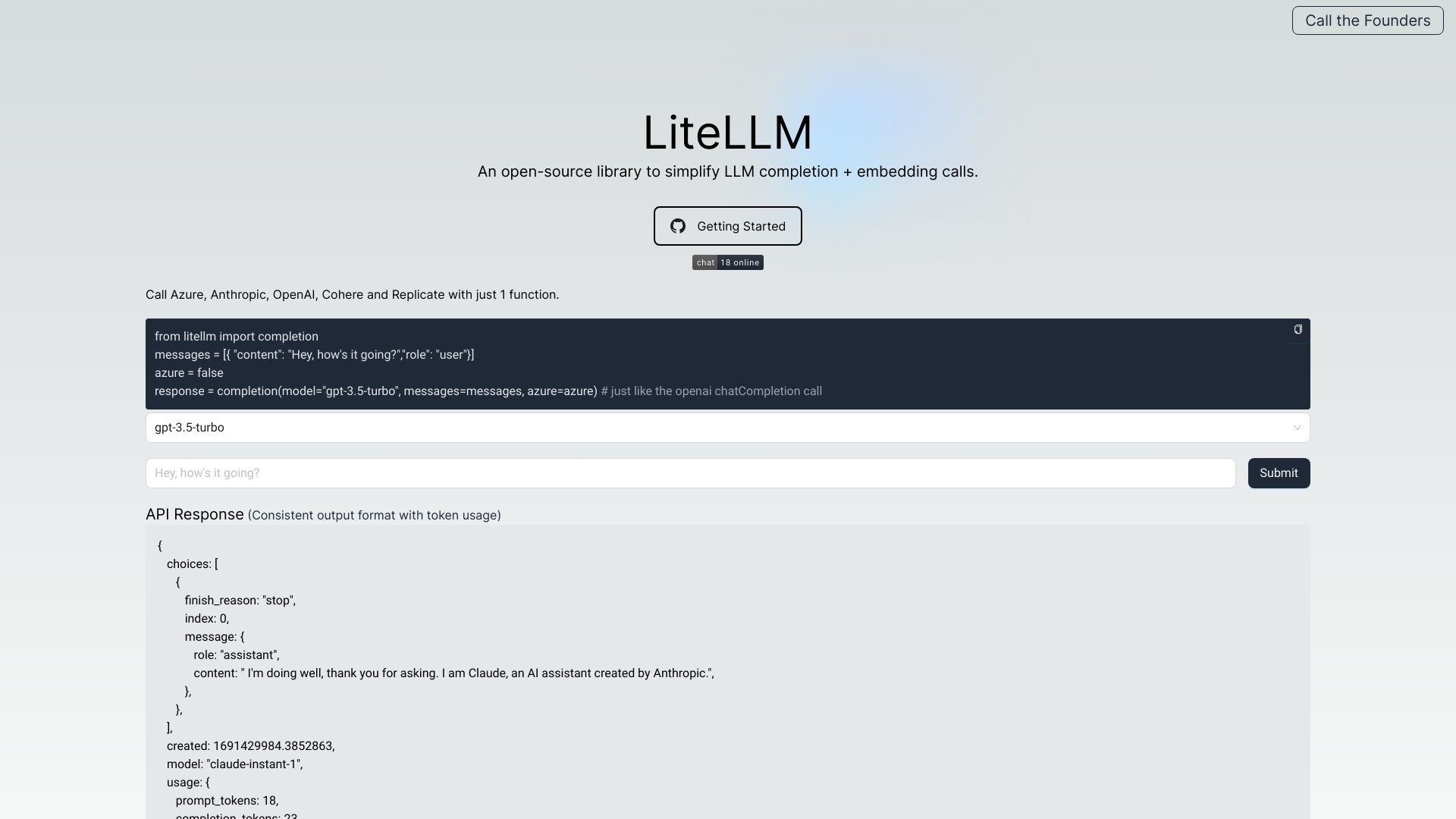

Giới thiệu công cụ:Cổng LLM tương thích OpenAI; hợp nhất 100+ mô hình, theo dõi chi phí và log.

-

Ngày thêm:2025-10-21

-

Mạng xã hội & Email:

Thông tin công cụ

LiteLLM AI là gì

LiteLLM AI là một LLM Gateway / OpenAI Proxy giúp hợp nhất việc gọi API tới hơn 100 mô hình ngôn ngữ lớn (LLM) từ các nhà cung cấp như OpenAI, Azure, Cohere, Anthropic, Google, Replicate… trong cùng một chuẩn OpenAI-compatible. Công cụ này tập trung vào xác thực, cân bằng tải, theo dõi chi tiêu, nhật ký và giám sát lỗi, đồng thời chuẩn hóa định dạng đầu ra và ngoại lệ giữa các API. Nhờ đó, nhóm kỹ thuật có thể chuyển đổi nhà cung cấp linh hoạt, kiểm soát ngân sách, áp dụng guardrails, hạn mức (rate limiting), quản lý prompt và quan sát hiệu năng LLM một cách nhất quán cho sản phẩm và dịch vụ.

Tính năng chính của LiteLLM AI

- Cổng chung chuẩn OpenAI: Gọi nhiều LLM khác nhau với cùng một schema và lỗi/ngoại lệ thống nhất.

- Cân bằng tải & chuyển hướng: Phân phối lưu lượng, tự động chuyển sang mô hình/nhà cung cấp khác khi lỗi hoặc quá tải.

- Theo dõi chi phí & ngân sách: Ghi nhận chi tiêu theo người dùng/dự án, đặt budget và cảnh báo vượt ngưỡng.

- Xác thực & kiểm soát truy cập: Quản lý khóa API, cấp quyền theo mô hình/nhóm, ẩn khóa nhà cung cấp khỏi phía client.

- Quan sát & ghi log: Nhật ký yêu cầu/đáp ứng, theo dõi lỗi, lưu trữ log (ví dụ S3) để phân tích và tuân thủ.

- Rate limiting & guardrails: Thiết lập hạn mức tần suất, kiểm soát nội dung/định dạng đầu ra.

- Batches API: Xử lý hàng loạt yêu cầu để tối ưu chi phí và thông lượng.

- Quản lý prompt: Phiên bản hóa, tái sử dụng và chuẩn hóa prompt trên nhiều mô hình.

- Pass-through endpoints: Linh hoạt chuyển tiếp tới nhà cung cấp gốc khi cần tính năng đặc thù.

LiteLLM AI phù hợp với ai

Phù hợp với đội ngũ nền tảng/infra, kỹ sư ML/AI, nhóm sản phẩm tích hợp nhiều LLM, doanh nghiệp muốn tránh phụ thuộc nhà cung cấp, quản lý chi phí và tuân thủ. Các kịch bản tiêu biểu: tích hợp chatbot/agent đa nhà cung cấp, tổng hợp tài liệu/hệ thống RAG, nội dung sinh/kiểm duyệt ở quy mô lớn, và các nền tảng SaaS cần tiêu chuẩn hóa API LLM cho khách hàng.

Cách sử dụng LiteLLM AI

- Chuẩn bị khóa API cho các nhà cung cấp LLM (OpenAI, Azure, Anthropic, Cohere, Google, Replicate…).

- Triển khai LiteLLM (tự host bằng container/mã nguồn mở hoặc dùng bản được quản lý nếu có).

- Cấu hình nguồn mô hình, định tuyến, cân bằng tải và quy tắc failover trong tệp cấu hình.

- Thiết lập xác thực (API keys), quyền truy cập theo người dùng/nhóm và giới hạn mô hình được phép gọi.

- Bật theo dõi chi phí, thiết lập ngân sách, rate limits và guardrails theo chính sách của tổ chức.

- Tích hợp ứng dụng của bạn qua các endpoint OpenAI-compatible để gọi chat/completions/embeddings.

- Kích hoạt logging (ví dụ lưu S3) và quan sát để theo dõi hiệu năng, lỗi và tối ưu chi tiêu.

- Kiểm thử với nhiều nhà cung cấp, tinh chỉnh tuyến đường, prompt và ngưỡng hạn mức trước khi đưa vào sản xuất.

Trường hợp ứng dụng LiteLLM AI trong ngành

Fintech: triển khai trợ lý khách hàng đa kênh với định tuyến động giữa OpenAI và Anthropic để tối ưu chi phí/độ an toàn, đồng thời đặt ngân sách theo sản phẩm. Edtech: hệ thống chấm/gợi ý bài tập dùng Google/Anthropic cho tác vụ phức tạp, Cohere cho nhiệm vụ rẻ/nhanh, được giám sát bởi rate limit và guardrails. SaaS B2B: nền tảng tạo nội dung tích hợp nhiều LLM qua một API duy nhất, ghi log lên S3 để kiểm toán. Doanh nghiệp nội bộ: cổng LLM chuẩn hóa cho RAG, theo dõi chi tiêu theo phòng ban và hạn mức cho từng dự án.

Mô hình giá của LiteLLM AI

LiteLLM là phần mềm mã nguồn mở có thể tự triển khai, do đó bản tự host thường không thu phí giấy phép; chi phí vận hành chủ yếu đến từ hạ tầng và phí sử dụng LLM của nhà cung cấp. Ngoài ra có thể có lựa chọn dịch vụ được quản lý/hosted kèm tính năng doanh nghiệp và hỗ trợ, phù hợp tổ chức muốn giảm công vận hành. Chi tiết giá phụ thuộc từng nhà cung cấp mô hình và gói dịch vụ bạn chọn.

Ưu điểm và nhược điểm của LiteLLM AI

Ưu điểm:

- Chuẩn hóa gọi API theo chuẩn OpenAI, giảm công tích hợp và chuyển đổi nhà cung cấp.

- Quan sát tốt: logging, theo dõi lỗi, chi phí và ngân sách theo dự án/nhóm.

- Quản trị tập trung: xác thực, phân quyền, rate limiting, guardrails.

- Cân bằng tải và failover giúp nâng cao độ tin cậy và hiệu năng.

- Linh hoạt với pass-through để tận dụng tính năng đặc thù của từng nhà cung cấp.

Nhược điểm:

- Thêm một lớp trung gian có thể tăng độ trễ nếu cấu hình chưa tối ưu.

- Cần thiết lập và vận hành (định tuyến, bảo mật, giám sát) nếu tự host.

- Một số tính năng rất đặc thù của nhà cung cấp có thể không được chuẩn hóa hoàn toàn.

Câu hỏi phổ biến về LiteLLM AI

-

LiteLLM có phải là một mô hình AI không?

Không. LiteLLM là LLM Gateway/OpenAI Proxy, cung cấp lớp kết nối và quản trị cho nhiều mô hình LLM khác nhau.

-

LiteLLM có tương thích chuẩn OpenAI không?

Có. LiteLLM duy trì định dạng OpenAI-compatible cho endpoints, đầu vào/đầu ra và ngoại lệ thống nhất giữa các nhà cung cấp.

-

Có thể tự triển khai on-premise không?

Có. Bạn có thể tự host để kiểm soát dữ liệu, bảo mật và chi phí; hoặc chọn dịch vụ được quản lý nếu muốn giảm vận hành.

-

Làm sao theo dõi và giới hạn chi phí?

Sử dụng tính năng theo dõi chi tiêu, đặt budget theo người dùng/dự án, cấu hình cảnh báo và rate limiting để bảo vệ ngân sách.

-

LiteLLM hỗ trợ những nhà cung cấp nào?

Hỗ trợ 100+ LLM, bao gồm OpenAI, Azure, Anthropic, Cohere, Google, Replicate… với định tuyến linh hoạt và pass-through khi cần.