LiteLLM

Site web ouvert-

Présentation de l'outil:Proxy OpenAI et passerelle LLM: 100+ modèles, coûts et logs maîtrisés.

-

Date d'inclusion:2025-10-21

-

Réseaux sociaux et e-mails:

Informations sur l'outil

Qu’est-ce que LiteLLM AI

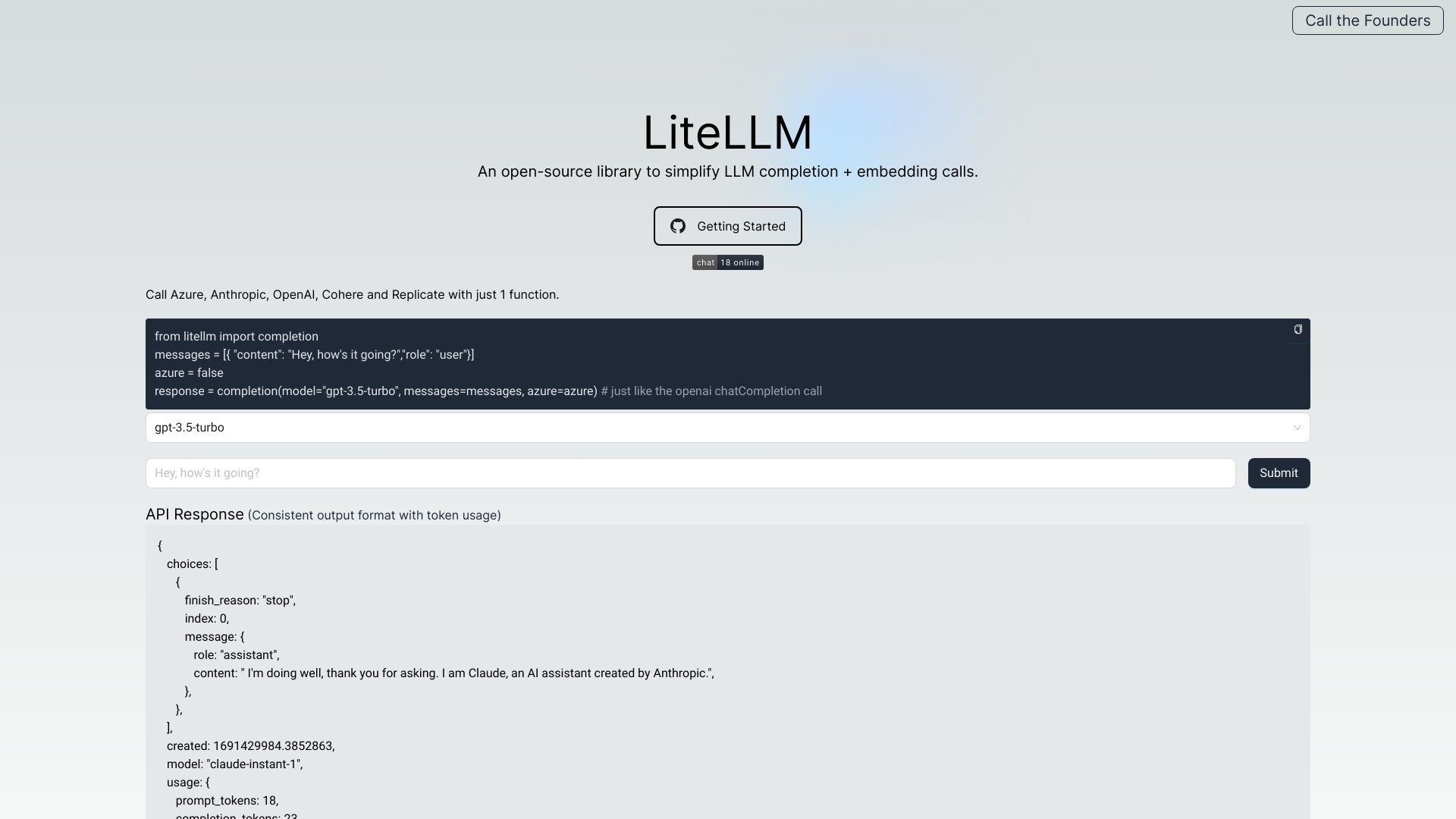

LiteLLM AI est une passerelle LLM agissant comme un proxy compatible avec le format OpenAI pour unifier l’accès aux modèles de langage de multiples fournisseurs. Elle centralise l’authentification, l’équilibrage de charge et le suivi des coûts à travers plus d’une centaine de modèles, tout en garantissant des sorties et des exceptions cohérentes. L’outil offre la journalisation, le suivi des erreurs, l’observabilité des LLM, la gestion des budgets, des garde-fous et des limites de débit, afin de simplifier l’intégration et l’exploitation des API de modèles.

Fonctionnalités principales de LiteLLM AI

- Compatibilité avec le format OpenAI pour une intégration rapide et homogène.

- Agrégation multi-fournisseurs (OpenAI, Azure, Cohere, Anthropic, Replicate, Google, etc.).

- Authentification centralisée et contrôle d’accès par modèles et équipes.

- Équilibrage de charge et routage intelligent entre fournisseurs et versions de modèles.

- Suivi des coûts, budgets et alertes de dépenses pour une maîtrise financière.

- Observabilité des LLM (métriques, journaux, erreurs) et traçabilité complète.

- Journalisation et export des événements, notamment vers Amazon S3.

- Gestion des consignes et des modèles d’invite pour standardiser les appels.

- Garde-fous et politiques de contenu pour renforcer la sécurité et la conformité.

- Limitation de débit, quotas et priorisation pour gérer la capacité.

- API de traitement par lots pour exécuter des requêtes à grande échelle.

- Points de terminaison à relais transparent pour préserver les comportements natifs.

À qui s’adresse LiteLLM AI

LiteLLM AI s’adresse aux développeurs, architectes logiciels et équipes produit qui intègrent des modèles de langage dans des applications. Il convient aussi aux équipes données et apprentissage automatique cherchant à tester plusieurs fournisseurs, aux responsables de la sécurité et de la conformité, ainsi qu’aux équipes chargées de l’optimisation des coûts souhaitant piloter budgets, quotas et observabilité dans un cadre unifié.

Comment utiliser LiteLLM AI

- Connecter les clés API des fournisseurs de modèles que vous utilisez.

- Définir les modèles autorisés, les règles d’accès, les budgets et les limites de débit.

- Configurer le routage: équilibrage de charge, préférences de modèles et bascule automatique.

- Activer la journalisation, l’observabilité et, si besoin, l’export vers Amazon S3.

- Appeler l’API via l’interface compatible avec le format OpenAI depuis vos services.

- Surveiller coûts, journaux et métriques, puis ajuster garde-fous et consignes.

- Utiliser l’API de traitement par lots pour les opérations à grande échelle.

Cas d’utilisation de LiteLLM AI

Dans une plateforme SaaS multirégion, LiteLLM AI permet d’orienter dynamiquement les requêtes vers le modèle le plus économique ou le plus performant. En service client, il assure la bascule automatique en cas d’incident chez un fournisseur pour maintenir la disponibilité. En R&D, il facilite les tests A/B entre modèles et la normalisation des sorties. En entreprise, il centralise la gouvernance des accès, les budgets par équipe, l’audit et la conformité des appels aux API de LLM.

Avantages et inconvénients de LiteLLM AI

Avantages :

- Interface unifiée et cohérence des réponses et des erreurs entre fournisseurs.

- Réduction de la complexité d’intégration et maintenance simplifiée.

- Suivi précis des coûts, budgets et quotas pour maîtriser les dépenses.

- Observabilité et traçabilité complètes pour le diagnostic et l’audit.

- Fonctions avancées: traitement par lots, garde-fous, gestion des consignes.

- Journalisation flexible, y compris vers Amazon S3, et relais transparent.

Inconvénients :

- Couche supplémentaire pouvant introduire une légère latence.

- Nécessite une configuration initiale du routage et des politiques d’accès.

- Certaines fonctions propres à un fournisseur peuvent ne pas être exposées à l’identique.

- Exige une gestion rigoureuse des clés d’API et des autorisations.

- Dépendance à la disponibilité et aux limites des API des fournisseurs.

Questions fréquentes sur LiteLLM AI

Question 1 : Quels fournisseurs de LLM sont compatibles ?

LiteLLM AI agrège des API de plusieurs acteurs, notamment OpenAI, Azure, Cohere, Anthropic, Replicate et Google, tout en offrant une interface et des comportements unifiés.

Question 2 : Comment LiteLLM AI aide-t-il à maîtriser les coûts ?

Il centralise le suivi des dépenses par modèle, clé ou équipe, applique des budgets et des quotas, et fournit des métriques pour optimiser le routage selon le coût et la performance.

Question 3 : Puis-je limiter le débit et définir des quotas d’usage ?

Oui, des règles de limitation de débit et de quotas permettent de contrôler la capacité, éviter les surcharges et répartir équitablement les ressources.

Question 4 : Les erreurs et journaux sont-ils unifiés ?

Oui, l’outil normalise les erreurs et centralise la journalisation, facilitant le diagnostic, l’audit et la résolution d’incidents.

Question 5 : Peut-on conserver les comportements natifs d’un fournisseur ?

Oui, via des points de terminaison à relais transparent, il est possible de passer des paramètres spécifiques tout en bénéficiant de la couche d’observabilité et de contrôle.