LiteLLM

Abrir sitio web-

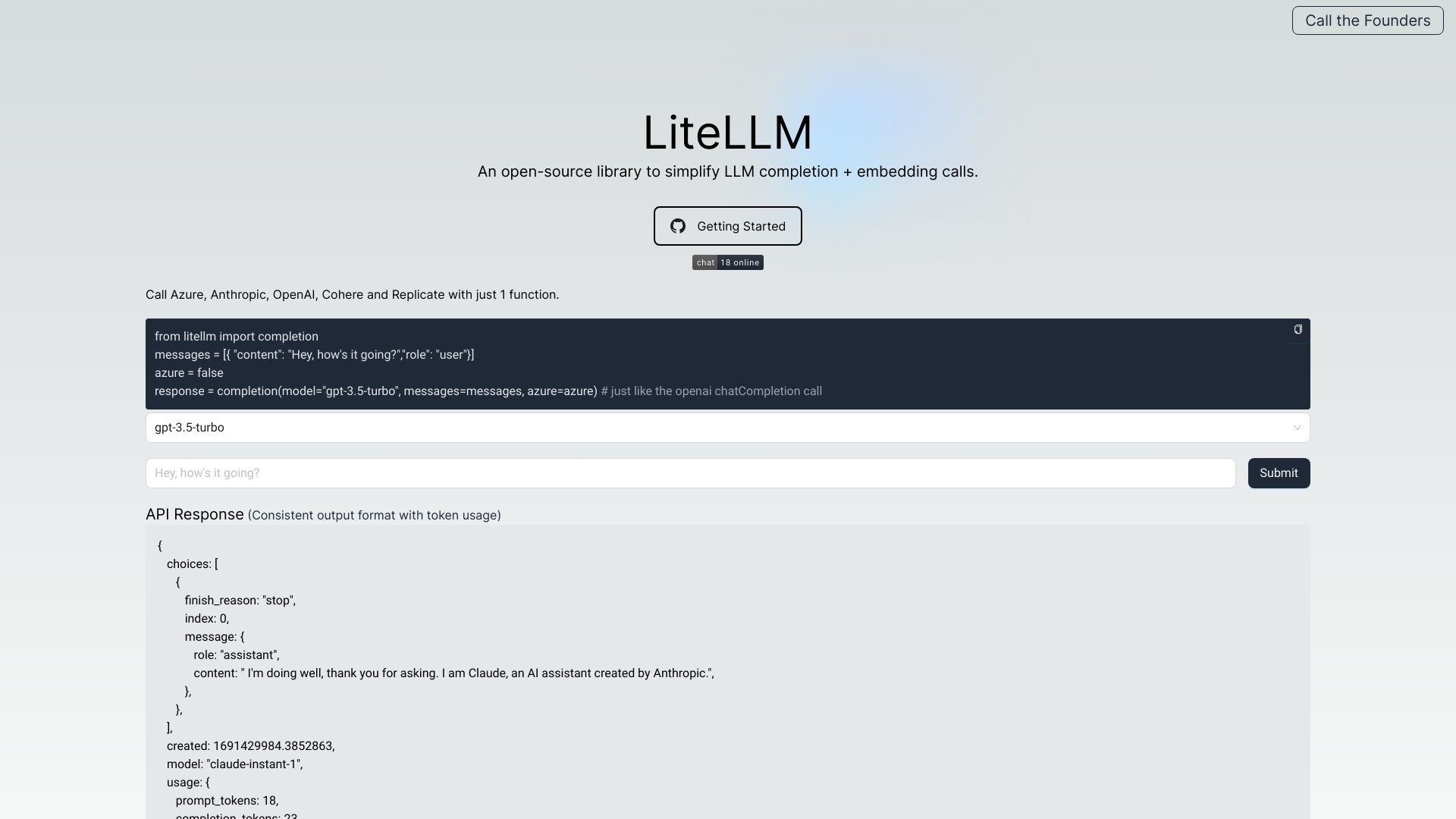

Introducción de la herramienta:Proxy OpenAI y gateway LLM para 100+ modelos: acceso, balanceo y costes.

-

Fecha de inclusión:2025-10-21

-

Redes sociales y correo electrónico:

Información de la herramienta

¿Qué es LiteLLM AI?

LiteLLM AI es una puerta de enlace para modelos de lenguaje (LLM) que funciona como proxy compatible con el formato de OpenAI. Centraliza la autenticación, el equilibrio de carga y el seguimiento del gasto a través de más de 100 LLMs de proveedores como OpenAI, Azure, Cohere, Anthropic, Replicate y Google. Simplifica el uso de APIs de IA al ofrecer salidas y excepciones consistentes, junto con registro y trazabilidad de errores. Incorpora control de costes, presupuestos, observabilidad de LLM, rate limiting y gestión de prompts para operar LLMs con mayor control y fiabilidad.

Principales características de LiteLLM AI

- Compatibilidad con formato OpenAI: interfaz unificada que mantiene la estructura de solicitudes y respuestas, facilitando la migración entre proveedores.

- Autenticación centralizada: gestiona claves y accesos a múltiples modelos y proveedores desde un solo punto.

- Equilibrio de carga y enrutamiento: distribuye tráfico entre diferentes LLMs para mejorar disponibilidad y rendimiento.

- Seguimiento de costes y presupuestos: control granular del gasto por modelo, equipo o aplicación.

- Observabilidad de LLM: métricas, logging y error tracking para auditoría y diagnóstico.

- Limitación de tasa (rate limiting): define cuotas y límites para evitar sobrecargas y mantener el SLO.

- Gestión de prompts: centraliza plantillas y versiones de prompts para mayor consistencia.

- Batches API: ejecución por lotes para reducir latencia total y optimizar costes.

- Guardrails y control de acceso a modelos: aplica reglas, restricciones y permisos por rol o caso de uso.

- Registro en S3: almacenamiento de interacciones y resultados en S3 para análisis y cumplimiento.

- Puntos de acceso pass-through: posibilidad de reenviar solicitudes directamente al proveedor cuando se requiera.

- Excepciones consistentes: manejo uniforme de errores entre APIs heterogéneas.

¿Para quién es LiteLLM AI?

Está orientado a desarrolladores, equipos de MLOps y plataformas de producto que integran varios LLMs y necesitan unificar APIs, controlar costes y asegurar la observabilidad. Resulta útil para empresas que requieren multi-proveedor por resiliencia o cumplimiento, startups que iteran rápido con diferentes modelos, y organizaciones que buscan presupuestos, rate limiting y guardrails sin reescribir integraciones.

Cómo usar LiteLLM AI

- Despliega el gateway/proxy: instala y ejecuta la puerta de enlace de LiteLLM en tu entorno o infraestructura preferida.

- Configura credenciales: añade las claves de API de OpenAI, Azure, Cohere, Anthropic, Replicate, Google u otros proveedores.

- Define políticas: establece enrutamiento, equilibrio de carga, límites de tasa, guardrails y reglas de acceso a modelos.

- Consume la API unificada: realiza peticiones con el formato de OpenAI y recibe respuestas consistentes entre LLMs.

- Activa el seguimiento de costes: configura presupuestos y monitorea gasto por proyecto o equipo.

- Habilita observabilidad: revisa métricas, registros y errores; usa logging en S3 si es necesario.

- Optimiza con batches y prompts: utiliza la Batches API y gestiona plantillas de prompts para mejorar eficiencia.

- Itera y escala: ajusta rutas y políticas según rendimiento y necesidades de producto.

Casos de uso de LiteLLM AI en la industria

En SaaS y plataformas, unifica el acceso a múltiples LLMs para ofrecer funciones de chat, resumen o clasificación con resiliencia multi-proveedor. En atención al cliente, aplica rate limiting, presupuestos y trazabilidad para controlar costes y calidad. En finanzas y cumplimiento, habilita guardrails, registro en S3 y auditoría. En analítica y procesamiento por lotes, la Batches API acelera flujos masivos y reduce el gasto.

Ventajas y desventajas de LiteLLM AI

Ventajas:

- Interfaz unificada con formato OpenAI para alternar entre proveedores sin reescribir código.

- Seguimiento de costes, presupuestos y observabilidad integrados.

- Equilibrio de carga, rate limiting y guardrails para fiabilidad y control.

- Logging y error tracking consistentes en todos los modelos.

- Soporte de más de 100 LLMs, incluidos OpenAI, Azure, Cohere, Anthropic, Replicate y Google.

Desventajas:

- Introduce una capa adicional que puede sumar latencia si no se configura adecuadamente.

- Requiere gestión de políticas, claves y monitoreo continuo.

- Al mantener un formato unificado, algunas funciones muy específicas de un proveedor podrían requerir configuración adicional mediante pass-through.

Preguntas frecuentes sobre LiteLLM AI

-

¿Mantiene el formato de OpenAI?

Sí. LiteLLM ofrece una API compatible con el formato de OpenAI para solicitudes y respuestas, facilitando la interoperabilidad.

-

¿Qué proveedores soporta?

Integra más de 100 LLMs, incluidos OpenAI, Azure, Cohere, Anthropic, Replicate y Google, entre otros.

-

¿Permite controlar costes y presupuestos?

Sí. Incluye seguimiento de costes, definición de presupuestos y métricas para optimizar el gasto por uso.

-

¿Ofrece observabilidad y registro de errores?

Sí. Proporciona logging, trazabilidad de errores y registro en S3 para auditoría y análisis.

-

¿Cómo gestiona la disponibilidad entre modelos?

Mediante equilibrio de carga y enrutamiento, puede distribuir tráfico y aplicar rate limiting para mantener el servicio estable.