LiteLLM

웹사이트 열기-

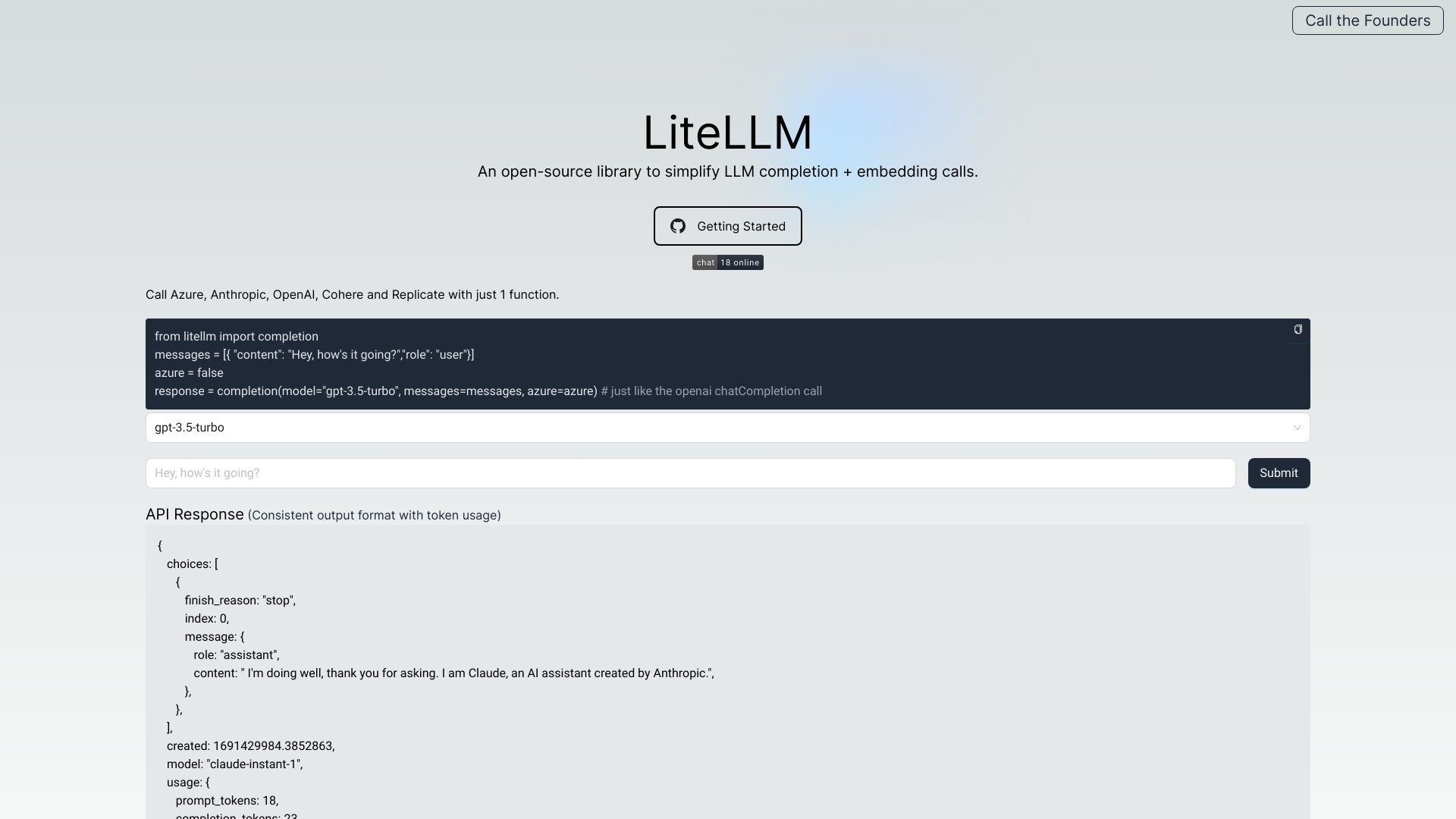

도구 소개:OpenAI 프록시·LLM 게이트웨이: 100+ 모델 통합, 비용 추적·로깅, 가드레일과 속도 제한 지원.

-

수집 시간:2025-10-21

-

소셜 미디어 & 이메일:

도구 정보

LiteLLM AI란 무엇인가

LiteLLM AI는 다양한 생성형 모델을 단일 OpenAI 포맷으로 연결하는 LLM 게이트웨이이자 OpenAI 프록시입니다. 조직은 이 도구를 통해 OpenAI, Azure, Cohere, Anthropic, Replicate, Google 등 100+ LLM을 하나의 API로 호출하고, 인증 관리, 로드 밸런싱, 스팬드(비용) 추적을 중앙에서 통제할 수 있습니다. 모든 모델에 대해 일관된 출력과 예외 처리를 제공하므로 공급자 교체나 멀티 벤더 전략을 단순화합니다. 또한 요청·응답 로깅과 에러 추적, 비용 대시보드, 예산과 가드레일, 레이트 리미팅, 프롬프트 관리, S3 로깅, 패스스루 엔드포인트, Batches API까지 포함해 운영과 거버넌스를 강화합니다. 결과적으로 팀은 모델 성능과 비용을 가시화하고, 장애 대응과 확장성을 확보하며, 제품 코드 변경 없이 신속히 모델을 실험·전환할 수 있습니다. 아울러 LLM 옵저버빌리티 기능으로 지연, 성공률, 토큰 사용량을 추적해 신뢰도 높은 프로덕션 운영을 돕습니다.

LiteLLM AI 주요 기능

- OpenAI 포맷 호환 LLM 게이트웨이: 단일 API로 OpenAI, Azure, Cohere, Anthropic, Replicate, Google 등과 연동하며 출력·예외를 일관화합니다.

- 인증·접근 제어: API 키 중앙 관리와 모델별 접근 권한 제어로 보안과 거버넌스를 강화합니다.

- 로드 밸런싱·페일오버: 다수 공급자/모델 간 트래픽을 분산하고 장애 시 자동 전환합니다.

- 비용 추적·예산: 사용량/비용 로그를 집계하고 예산 한도 및 알림을 설정합니다.

- 로깅·에러 추적: 요청/응답 로깅, S3 로깅, 오류 모니터링으로 감사 가능성을 확보합니다.

- 레이트 리미팅: 요청 속도와 쿼터를 제어해 안정적인 운영을 보장합니다.

- 프롬프트 관리·가드레일: 프롬프트 버전 관리와 정책 기반 필터로 품질·위험을 통제합니다.

- Batches API: 대량 요청 처리와 큐잉으로 비용·성능을 최적화합니다.

- 패스스루 엔드포인트: 공급자 고유 매개변수를 그대로 전달해 통합성과 유연성을 병행합니다.

- LLM 옵저버빌리티: 지연, 성공률, 비용 등 핵심 메트릭을 수집·분석합니다.

LiteLLM AI 적합한 사용자

여러 LLM 제공자를 병행 사용하거나 공급자 종속을 최소화하려는 제품팀·플랫폼팀, 데이터/ML 엔지니어, 보안·거버넌스 담당자에게 적합합니다. 빠르게 모델을 시험하고 전환해야 하는 스타트업, 비용·성능을 체계적으로 관리하려는 엔터프라이즈, 규정 준수와 감사를 요구받는 산업 환경에서 특히 유용합니다.

LiteLLM AI 사용 단계

- 게이트웨이 배치: 사내 런타임 또는 컨테이너/클라우드 환경에 배포합니다.

- 프로바이더 연결: OpenAI, Azure, Cohere, Anthropic, Replicate, Google 등의 자격 증명을 등록합니다.

- 모델 라우팅 설정: 우선순위, 로드 밸런싱, 페일오버 규칙을 구성합니다.

- 보안·접근 제어: API 키 발급, 모델별 권한, 레이트 리미팅 정책을 적용합니다.

- 로깅·관측 구성: S3 로깅, 에러 추적, 지연/성공률/비용 메트릭 수집을 활성화합니다.

- 비용 관리: 비용 추적과 예산 한도를 설정하고 알림을 연동합니다.

- 프롬프트·가드레일: 템플릿 버전 관리와 정책 기반 필터를 적용합니다.

- 테스트·모니터링: 샘플 호출로 일관성·성능을 검증하고 대시보드를 관찰합니다.

LiteLLM AI 산업 사례

예시 1) 고객지원 챗봇에서 OpenAI 지연이 커지면 Anthropic으로 자동 페일오버해 응답 품질을 유지합니다. 예시 2) 금융사 내부 PoC에서 Azure와 OpenAI를 병행 라우팅하고 예산 한도로 월간 비용을 통제합니다. 예시 3) 전자상거래 검색에서 Cohere 임베딩과 OpenAI 생성 모델을 혼합, Batches API로 대량 카탈로그 설명을 생성합니다. 예시 4) 게임사의 UGC 검수에 가드레일을 적용해 정책 위반 콘텐츠를 차단하고, S3 로깅으로 감사 추적을 보장합니다.

LiteLLM AI 장단점

장점:

- 단일 OpenAI 포맷으로 멀티 LLM 통합, 클라이언트 코드 재사용

- 로드 밸런싱·페일오버로 가용성과 안정성 향상

- 비용 추적·예산 기능으로 지출 관리 강화

- 로깅, 에러 추적, S3 로깅, 옵저버빌리티로 운영 투명성 확보

- 레이트 리미팅, 접근 제어, 가드레일 등 거버넌스 지원

- 패스스루 엔드포인트로 공급자 고유 기능 활용 가능

단점:

- 게이트웨이 계층 추가로 지연이 소폭 증가할 수 있음

- 공급자 고유 기능의 완전한 추상화에는 한계 존재

- 보안·권한·모니터링 설정 등 초기 구성 노력이 필요

- 운영 규모가 커질수록 배포·확장 관리 복잡도가 상승

- S3 등 외부 스토리지/네트워크 구성에 대한 의존성

LiteLLM AI 인기 질문

-

어떤 LLM을 지원하나요?

OpenAI, Azure OpenAI, Cohere, Anthropic, Replicate, Google 등 100+ LLM과 통합됩니다.

-

OpenAI 포맷 호환이란 무엇인가요?

요청·응답 스키마와 예외 처리를 OpenAI API 스타일로 통일해 클라이언트 코드를 거의 수정 없이 재사용할 수 있습니다.

-

비용은 어떻게 추적하나요?

요청 단위 사용량과 비용을 기록해 대시보드로 집계하고, 예산 한도 및 초과 알림을 설정할 수 있습니다.

-

장애 시 서비스 연속성은 어떻게 보장되나요?

로드 밸런싱과 페일오버 규칙으로 특정 공급자 장애 시 다른 모델로 자동 라우팅합니다.

-

패스스루 엔드포인트는 무엇인가요?

공급자 고유 매개변수와 기능을 그대로 전달해 통합 레이어를 유지하면서도 세부 기능을 활용할 수 있습니다.

-

로그와 보안 관리는 지원하나요?

S3 로깅, 에러 추적, 레이트 리미팅, 모델 접근 제어 등을 제공해 감사와 남용 방지를 지원합니다.