LiteLLM

打开网站-

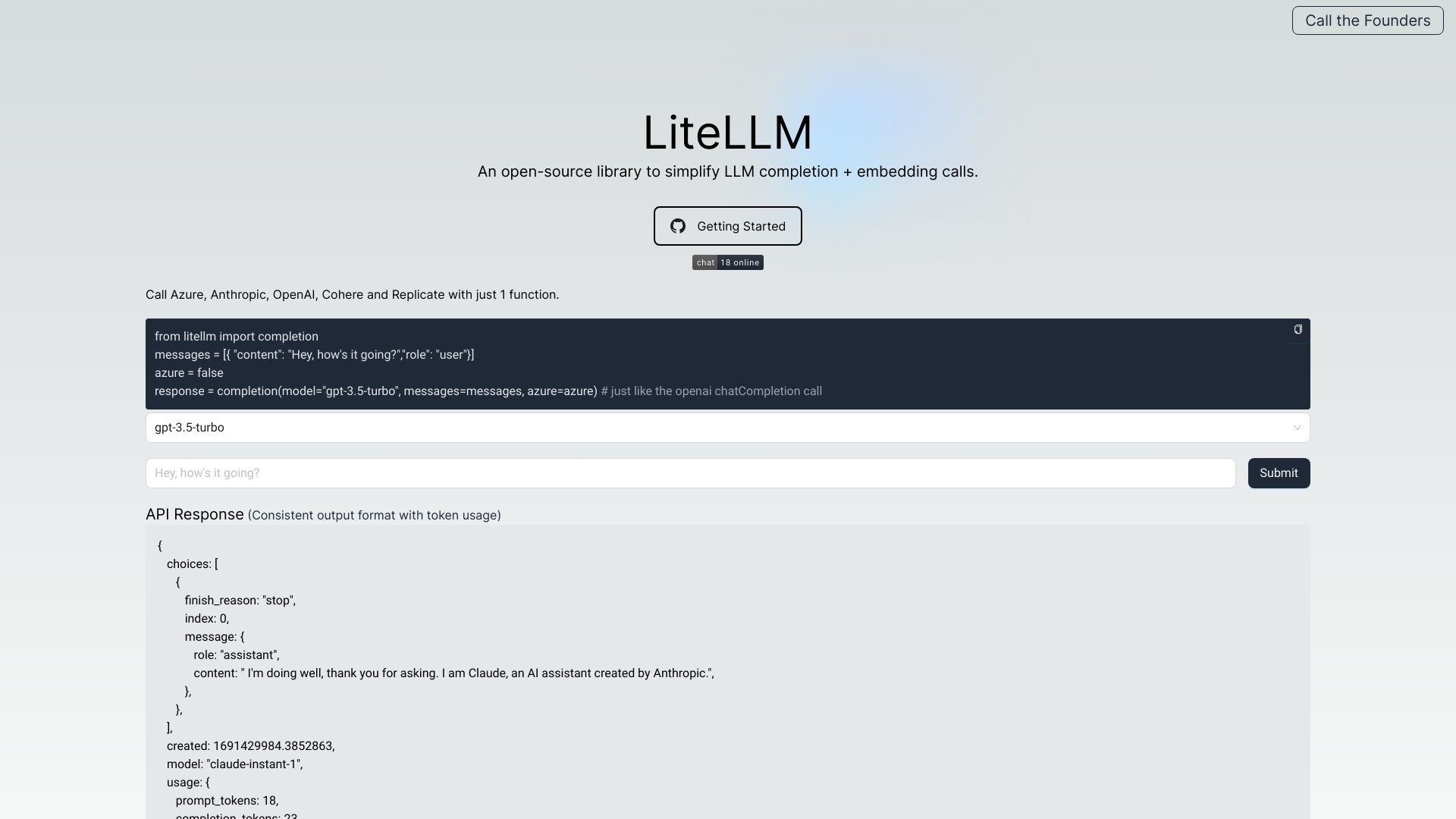

工具介绍:OpenAI格式兼容的LLM网关,统一接入100+模型,内置成本追踪、日志监控、错误跟踪、负载均衡、预算与限流。

-

收录时间:2025-10-21

-

社交媒体&邮箱:

工具信息

什么是 LiteLLM AI

LiteLLM AI 是面向大语言模型的网关与代理服务,定位为“统一接入层”。它将不同模型供应商的对话与补全接口进行标准化封装,在不改变既有调用方式的前提下,集中处理鉴权、负载均衡、用量与成本追踪、异常与重试、以及日志与告警等通用能力。通过一致的返回结构与错误类型,LiteLLM AI 显著降低多模型接入与维护成本;同时提供安全护栏、访问控制、预算与配额、速率限制、提示模板管理、对象存储日志归档、批量任务与直通端点等功能,满足从研发测试到生产环境的可观测性与合规需求。借助多模型路由与回退策略,团队可在稳定性、性能与费用之间灵活权衡,获得更高的可用性与弹性。

LiteLLM AI主要功能

统一接口与兼容格式:将多家模型供应商的能力抽象为一致的请求与响应结构,减少适配与迁移成本。

多模型路由与负载均衡:按权重、延迟、成功率或费用进行智能路由,支持失败自动回退与重试,提升可用性。

成本与用量追踪:按项目、密钥与模型维度统计用量与费用,支持预算、配额与超额告警,便于成本控制。

访问控制与权限管理:内置密钥管理、角色与权限、模型白名单,细粒度控制调用范围与上限。

速率限制与配额:按密钥或项目设置限流与配额策略,保护上游资源,平滑流量峰值。

安全护栏:支持敏感词与正则规则、输出长度限制、拒答策略等,降低合规与内容风险。

提示管理:提供提示模板、变量与版本管理,支持回滚与分环境配置,提升协作效率。

日志与可观测性:请求与响应统一记录,支持脱敏、错误追踪、可视化报表,并可将日志归档至对象存储。

批量调用与任务队列:高效处理成批请求,适配大规模生成与数据处理场景。

直通端点:在需要时将请求原样转发至上游,兼顾统一管理与灵活调用。

LiteLLM AI适用人群

适合需要统一管理多家大语言模型的团队与组织,包括企业研发部门、数据与平台团队、智能客服与内容生产平台、教育与游戏应用、对合规与审计有要求的金融与政企单位,以及希望低成本评估多模型表现的个人开发者与初创团队。

LiteLLM AI使用步骤

部署服务:通过包管理器安装或拉取容器镜像,启动网关服务,开放内网或受控外网访问。

配置供应商与模型:在配置文件或管理台添加各模型供应商的密钥、默认模型、路由权重与回退策略。

设置安全与权限:创建项目与密钥,配置角色、权限与模型白名单;开启敏感词与输出限制等安全护栏。

启用观测与成本:打开用量与费用统计,设置预算与告警阈值;将请求日志脱敏并归档至对象存储。

对接应用:把应用侧的调用地址改为网关统一端点,保持原有请求结构不变;按需开启流式、批量与直通转发。

运行优化:在监控面板查看成功率、延迟与花费,根据报表调整路由、限流与提示模板,持续优化稳定性与成本。

LiteLLM AI行业案例

智能客服平台以网关聚合多家模型,按费用与延迟进行动态路由,并设置预算上限与速率限制,保障高峰期稳定与成本可控;内容生成平台通过批量调用批处理商品描述与营销文案,借助对象存储日志实现问题追踪与审计;金融与政企场景启用安全护栏与细粒度权限,严格控制模型与数据的访问范围;教育与考试解析应用采用多模型比对与回退,提高答案一致性,并以日志与报表支撑质量评估与迭代。

LiteLLM AI收费模式

通常提供可自部署的开源使用方式,适合内部私有化与本地化场景;亦可选择托管与面向企业的增强能力(如多租户、团队权限、审计与服务保障等),常见做法是按调用量、功能套餐或成员数量计费,并可能提供限时试用或入门额度。具体以官方发布的方案为准。

LiteLLM AI优点和缺点

优点:

统一接口与异常模型,显著降低多家模型接入与维护成本。

多模型路由、负载均衡与回退机制,提高可用性与稳定性。

用量与费用可视化、预算与告警,避免成本失控。

内置访问控制与安全护栏,满足合规与审计需求。

日志与可观测能力完善,便于定位问题与持续优化。

批量调用与直通端点,兼顾灵活性与高吞吐。

降低对单一供应商的绑定风险,便于平滑迁移与替换。

缺点:

引入一层网关组件,带来一定的系统与运维复杂度。

请求多一跳可能带来少量时延,需要权衡与优化。

部分供应商的特性能力难以完全在统一接口中抽象,需要按需直通。

高并发与大规模批量任务对容量规划与限流策略要求较高。

LiteLLM AI热门问题

问题 1:

是否需要改动现有调用方式才能接入?通常无需改动业务请求与解析逻辑,直接把调用地址指向网关统一端点即可。

问题 2:

如何实现多模型路由与回退?可根据延迟、成功率与费用设置权重或规则,失败时自动重试并切换到回退模型。

问题 3:

如何进行成本追踪与预算控制?内置用量与费用统计,按项目与模型聚合,支持预算阈值、超额告警与报表导出。

问题 4:

能否私有化部署?支持在内网或自有云环境部署,并结合对象存储做日志归档与审计。

问题 5:

限流与配额如何配置?可按密钥、项目或端点设置每秒与每分钟的请求上限,并提供排队或拒绝策略。

问题 6:

提示模板如何管理?支持模板变量、版本管理与分环境配置,便于协作与灰度发布。