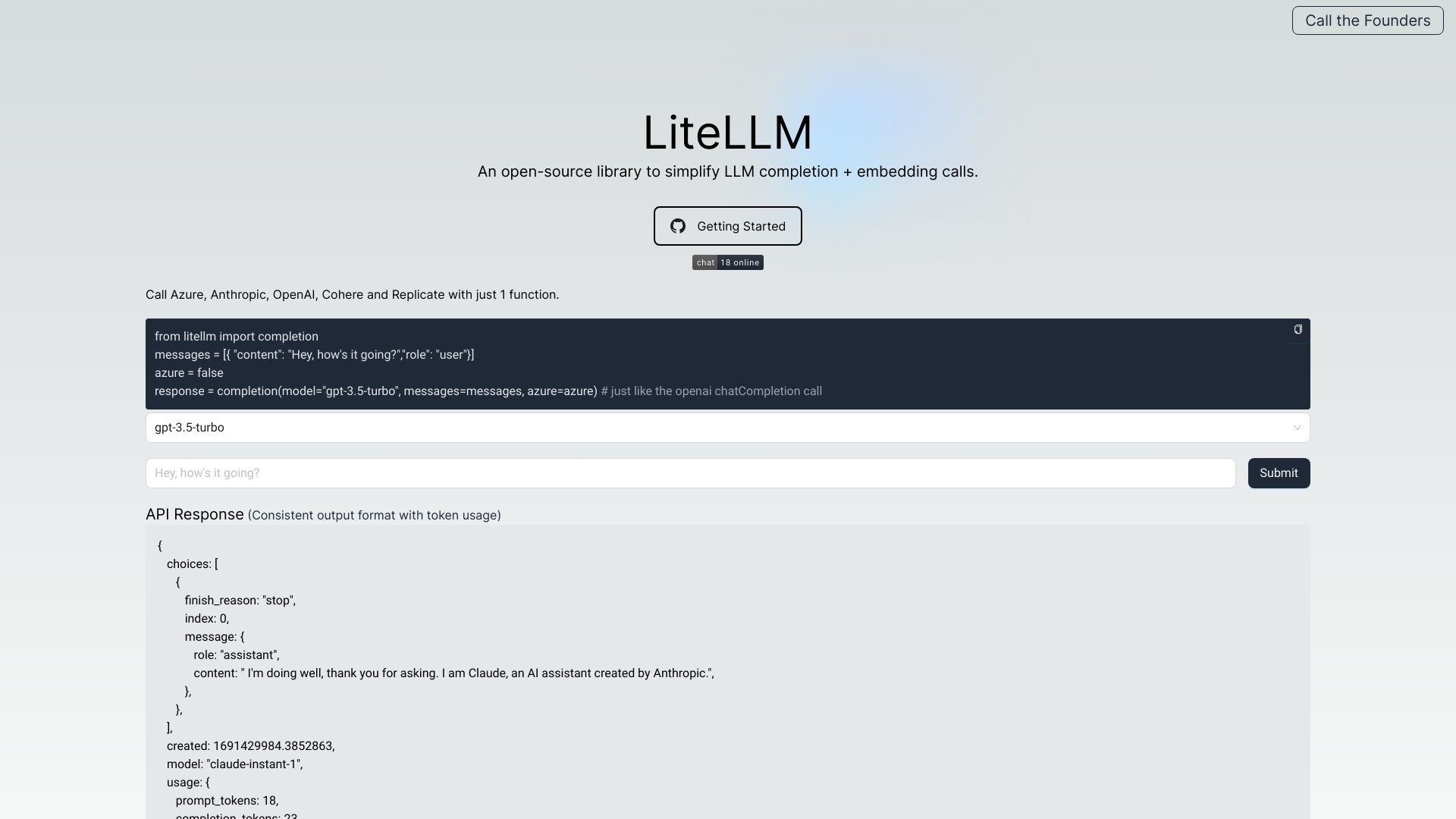

LiteLLM

打開網站-

工具介紹:OpenAI格式相容的LLM閘道,整合100+模型,內建成本追蹤、日誌監控、錯誤追蹤、負載平衡、預算與限流、一致API。

-

收錄時間:2025-10-21

-

社群媒體&信箱:

工具資訊

什麼是 LiteLLM AI

LiteLLM AI 是一個面向多家大型語言模型供應商的 LLM Gateway / OpenAI Proxy,以維持與 OpenAI API 兼容的請求與回應格式為核心,統一管理鑰匙驗證、負載平衡、成本與用量追蹤、錯誤與日誌監控,並在單一介面下接入超過百款模型與推理服務(如 OpenAI、Azure、Anthropic、Cohere、Google、Replicate 等)。透過一致的輸出與例外處理,開發者不必為不同供應商各自撰寫適配器,大幅降低維運複雜度。它還提供批次 API、guardrails、模型存取控制、預算與配額、LLM observability、速率限制、提示管理、S3 日誌、以及 passthrough 端點等功能,幫助團隊在可靠、可控且可觀測的基礎上構建與擴展各類 AI 應用。

LiteLLM AI 主要功能

- OpenAI 格式相容:以 OpenAI 風格的 API 與回傳結構整合多家 LLM,減少切換與適配成本。

- 多供應商聚合與負載平衡:在 OpenAI、Azure、Anthropic、Cohere、Google、Replicate 等之間路由,支援自動故障轉移與流量分配。

- 成本與用量追蹤:內建費用計量、模型/專案/團隊層級的預算控管與報表,協助精準掌握花費。

- 一致的錯誤與例外處理:將不同廠商的錯誤格式標準化,便於監控、重試與除錯。

- 批次 API:支援大批量請求處理與併發管理,提升資料處理與標註等場景效率。

- Guardrails 與合規:提供輸入/輸出檢查、內容過濾與策略控制,降低風險並符合政策要求。

- 模型存取與權限管理:針對團隊、服務與環境設定可見性與可用模型清單。

- 速率限制與配額:依 API Key、使用者或服務設定流量上限,穩定服務並避免突發成本。

- 觀測與日誌:集中式請求日誌、錯誤追蹤、S3 匯出與可視化指標,便於 SRE/資料團隊分析。

- 提示管理與版本化:集中管理 Prompt 與模板,支援版本控管與審核流程。

- Pass-through 端點:保留供應商特定參數的透傳能力,在統一層上仍可使用進階功能。

LiteLLM AI 適用人群

適合需要同時使用多家 LLM 供應商、追求成本可視化與風險控管的團隊與企業,包括:建置聊天助理與內容生產的產品團隊、需要多雲備援與延遲優化的平台工程團隊、重視資料合規與稽核的企業 IT/法遵部門、進行大規模批次推論的資料科學與資料標註團隊,以及希望快速替換模型與做 A/B 測試的研發與 MLOps 團隊。

LiteLLM AI 使用步驟

- 安裝與部署:透過套件管理或容器部署 LiteLLM Proxy,準備執行環境與網路設定。

- 設定金鑰與供應商:在環境變數或設定檔中加入 OpenAI、Azure、Anthropic、Cohere、Google 等 API Key。

- 定義模型路由:為不同業務場景設定模型映射、偏好順序、區域與備援策略,必要時啟用負載平衡。

- 啟用治理策略:設定速率限制、配額、預算與存取控制;為關鍵端點加上 guardrails 與內容政策。

- 接入應用程式:以 OpenAI 相容的 API 調用 LiteLLM 端點,逐步替換現有直連供應商的程式碼。

- 監控與日誌:串接日誌管線與 S3 匯出,建立告警與儀表板以追蹤錯誤率、延遲與花費。

- 批次與自動化:使用 Batches API 處理大規模任務,並以提示管理功能維護 Prompt 版本。

- 持續優化:依成本、效能與品質指標調整模型選擇、配額與策略規則。

LiteLLM AI 行業案例

在 SaaS 平台中,產品團隊以 LiteLLM 聚合多雲模型,依地區與可用性自動切換供應商,確保低延遲與高可用;企業內部助理將人資、財務與 IT 工單的查詢導向最合適的模型,並以 guardrails 落實內容政策與存取控制;資料營運團隊用 Batches API 執行大規模標註與內容分類,藉由成本追蹤與速率限制控制花費;在金融與法遵領域,團隊以統一的日誌與觀測性完成審計,將請求記錄至 S3 以利合規留存;教育與媒體則透過提示管理與版本化快速做 A/B 測試,持續優化產出品質與成本結構。

LiteLLM AI 收費模式

LiteLLM 通常提供可自行部署的開源版本,適合希望完整掌控基礎設施與成本的團隊;亦可能提供雲端託管或企業級功能(如進階治理、SLA 與整合支援),常見做法為按用量或方案分級計費。是否有免費額度或試用,與各方案細節與限制,建議以官方頁面與最新文件為準,以取得最準確的費用與授權資訊。

LiteLLM AI 優點和缺點

優點:

- 單一 API 介面整合多家 LLM,降低供應商鎖定風險並縮短開發時間。

- 強化治理能力:速率限制、配額、預算、權限與 guardrails 一應俱全。

- 一致的錯誤與日誌結構,利於觀測、告警與合規稽核。

- 支援批次處理與負載平衡,適合大規模生產場景。

- 保留 passthrough 能力,能使用供應商特定功能與參數。

缺點:

- 引入中介層可能帶來額外延遲與維運複雜度。

- 不同供應商之間功能差異仍存在,部分能力需透過特定參數或客製化才能發揮。

- 成本估算受供應商定價與模型更新影響,需要持續校準。

LiteLLM AI 熱門問題

-

問題 1: LiteLLM 與直接呼叫供應商 API 有何差異?

LiteLLM 提供統一的 OpenAI 相容介面、負載平衡、成本追蹤與治理能力,減少多供應商整合的程式與維運負擔。

-

問題 2: 會影響請求延遲嗎?

作為中介層會有少量額外延遲,但可藉快取、併發設定與就近路由等策略將影響降到最低。

-

問題 3: 如何控管成本與配額?

透過預算、速率限制與用量規則,可在專案或使用者層級設限,並以報表與告警監控花費。

-

問題 4: 能否保留供應商的進階參數?

可使用 passthrough 端點與供應商特定欄位,兼顧統一介面與彈性配置。

-

問題 5: 適合哪些部署模式?

可自架於私有雲/內網以符合合規要求,亦可使用雲端託管以降低維運成本,視安全與資料政策選擇。