LiteLLM

Abrir Site-

Ferramenta Introdução:Proxy OpenAI e gateway LLM para 100+ modelos; custos sob controle.

-

Data de Inclusão:2025-10-21

-

Social Media e E-mail:

Informações da ferramenta

O que é LiteLLM AI

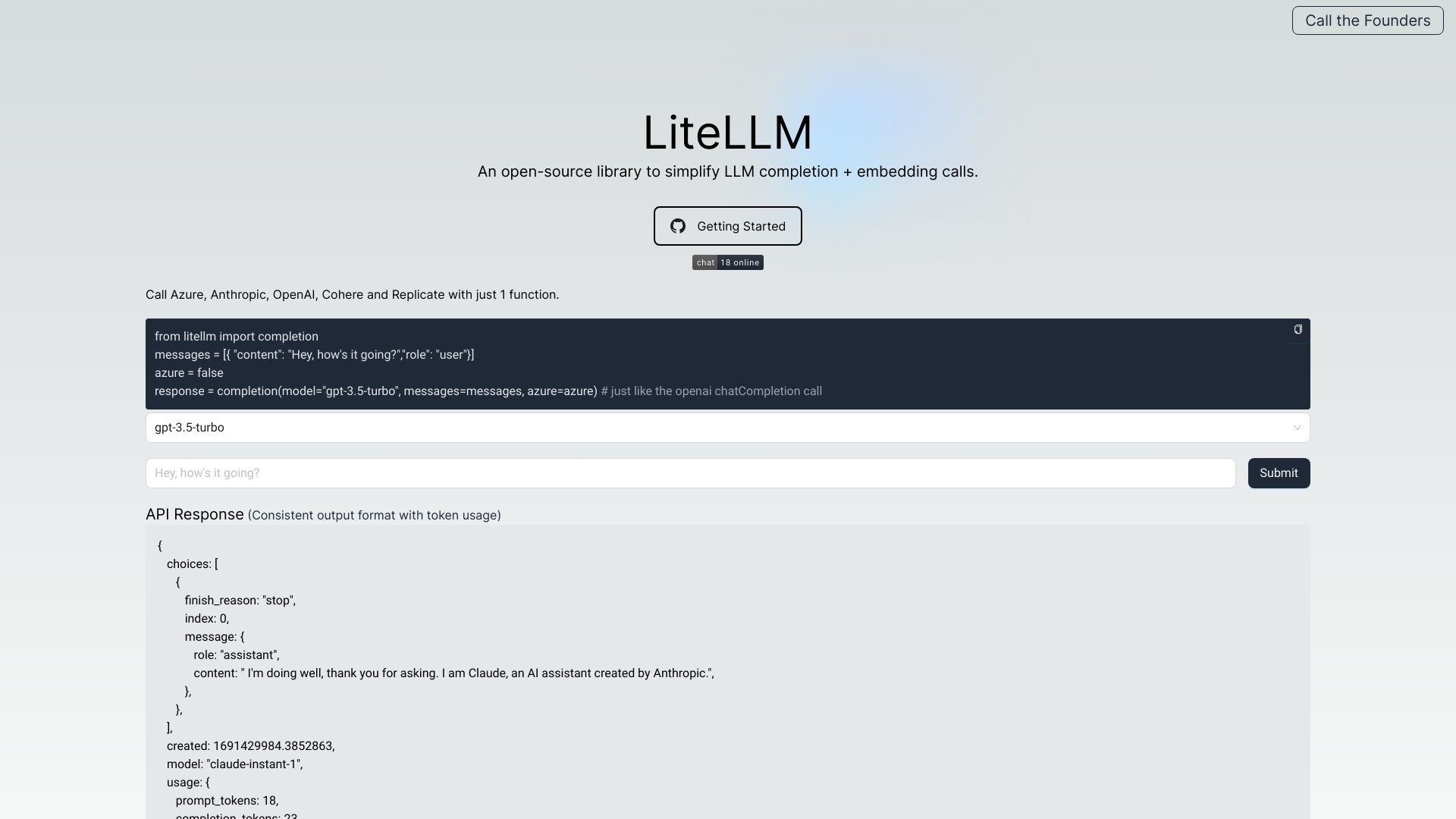

LiteLLM AI é um gateway de LLM, um OpenAI Proxy compatível com o formato da OpenAI, projetado para unificar o acesso e a gestão de modelos de linguagem de diversos provedores. Ele centraliza autenticação, balanceamento de carga e rastreamento de gastos em mais de 100 LLMs, oferecendo saídas e exceções consistentes entre APIs. A solução adiciona observabilidade, registro de logs e acompanhamento de erros para todos os modelos, além de recursos como limites de taxa, gestão de prompts, guardrails, orçamentos e endpoints pass-through para maior flexibilidade operacional.

Principais funcionalidades de LiteLLM AI

- Gateway unificado para LLMs: padroniza chamadas em um formato compatível com OpenAI, facilitando a troca entre provedores.

- Integração com múltiplos provedores: suporte a OpenAI, Azure, Cohere, Anthropic, Replicate, Google e outros.

- Autenticação centralizada: gerencia chaves e permissões de acesso por equipe, projeto ou serviço.

- Balanceamento de carga: distribui tráfego entre modelos e provedores para resiliência e desempenho.

- Rastreamento de custos e orçamentos: monitora gasto por modelo, usuário e projeto, com controles de budget.

- Consistência de respostas e erros: normaliza exceções e formatos de saída entre APIs distintas.

- Logging e observabilidade de LLM: registros detalhados, métricas e error tracking para diagnóstico.

- Rate limiting: políticas de limitação de taxa para proteger serviços e controlar consumo.

- Batches API: envio em lote para otimizar throughput e custos.

- Guardrails e controle de acesso: políticas de segurança, filtros e regras de uso por modelo.

- Gestão de prompts: versionamento e governança de prompts em escala.

- Logging em S3: opção de armazenar logs e auditorias em S3.

- Pass-through endpoints: flexibilidade para encaminhar solicitações diretamente aos provedores quando necessário.

Para quem é LiteLLM AI

Ideal para desenvolvedores, equipes de produto e MLOps que precisam orquestrar vários LLMs em produção; empresas que desejam controlar custos, aplicar políticas e ter observabilidade centralizada; times de segurança e compliance que exigem governança de modelos; plataformas SaaS que padronizam o acesso via API compatível com OpenAI; e iniciativas de FinOps focadas em orçamentos e alocação de gastos por projeto.

Como usar LiteLLM AI

- Configurar provedores: cadastre chaves de API e credenciais dos serviços (OpenAI, Azure, Cohere, Anthropic, etc.).

- Definir políticas: estabeleça regras de rate limiting, guardrails, orçamentos e acesso por equipe ou ambiente.

- Padronizar modelos: mapeie nomes de modelos e versões para um catálogo interno consistente.

- Integrar via API: conecte suas aplicações usando o formato de chamadas compatível com OpenAI e endpoints pass-through quando necessário.

- Observar e otimizar: habilite logging, métricas e S3 para auditoria; ajuste balanceamento de carga e políticas.

- Gerir custos: acompanhe gasto por requisição, projeto e usuário e refine budgets conforme o uso.

Casos de uso de LiteLLM AI no setor

Em produtos SaaS, padroniza chamadas a LLMs de diferentes provedores, garantindo continuidade mesmo com mudanças de modelo; em contact centers, aplica guardrails e rate limiting para bots de atendimento de alto volume; em data platforms, centraliza observabilidade e rastreamento de custos por time/projeto; em P&D, facilita experimentos com batches API e troca rápida de modelos; em ambientes regulados, aplica políticas de acesso, logging e auditoria em S3.

Vantagens e desvantagens de LiteLLM AI

Vantagens:

- API unificada e compatível com o formato da OpenAI.

- Integração com diversos provedores e modelos.

- Controle de custos, budgets e visibilidade do consumo.

- Observabilidade, logging e error tracking centralizados.

- Balanceamento de carga e políticas de rate limiting.

- Guardrails e gestão de prompts em escala.

- Flexibilidade com endpoints pass-through e logging em S3.

Desvantagens:

- Introduz uma camada adicional na arquitetura, podendo acrescentar latência.

- Nem todos os recursos proprietários de cada provedor podem estar totalmente padronizados.

- Exige governança de chaves e configuração inicial cuidadosa.

Perguntas frequentes sobre LiteLLM AI

-

LiteLLM AI é compatível com o formato da OpenAI?

Sim. As chamadas seguem o formato da OpenAI, mantendo saídas e exceções consistentes entre provedores.

-

Quais provedores são suportados?

Inclui OpenAI, Azure, Cohere, Anthropic, Replicate, Google e outros, cobrindo mais de 100 LLMs.

-

É possível rastrear custos e definir orçamentos?

Sim. Há rastreamento de gastos, definição de budgets e relatórios por usuário, projeto ou modelo.

-

O serviço oferece observabilidade e logs?

Sim. Fornece logging, error tracking, métricas e opção de logging em S3 para auditoria.

-

Como o balanceamento de carga funciona?

As requisições podem ser distribuídas entre modelos e provedores para melhorar disponibilidade, custo e desempenho, conforme políticas definidas.

-

Há suporte a batches API e endpoints pass-through?

Sim. É possível enviar solicitações em lote e usar pass-through endpoints para flexibilidade de integração.