- Startseite

- AI APIs

- LiteLLM

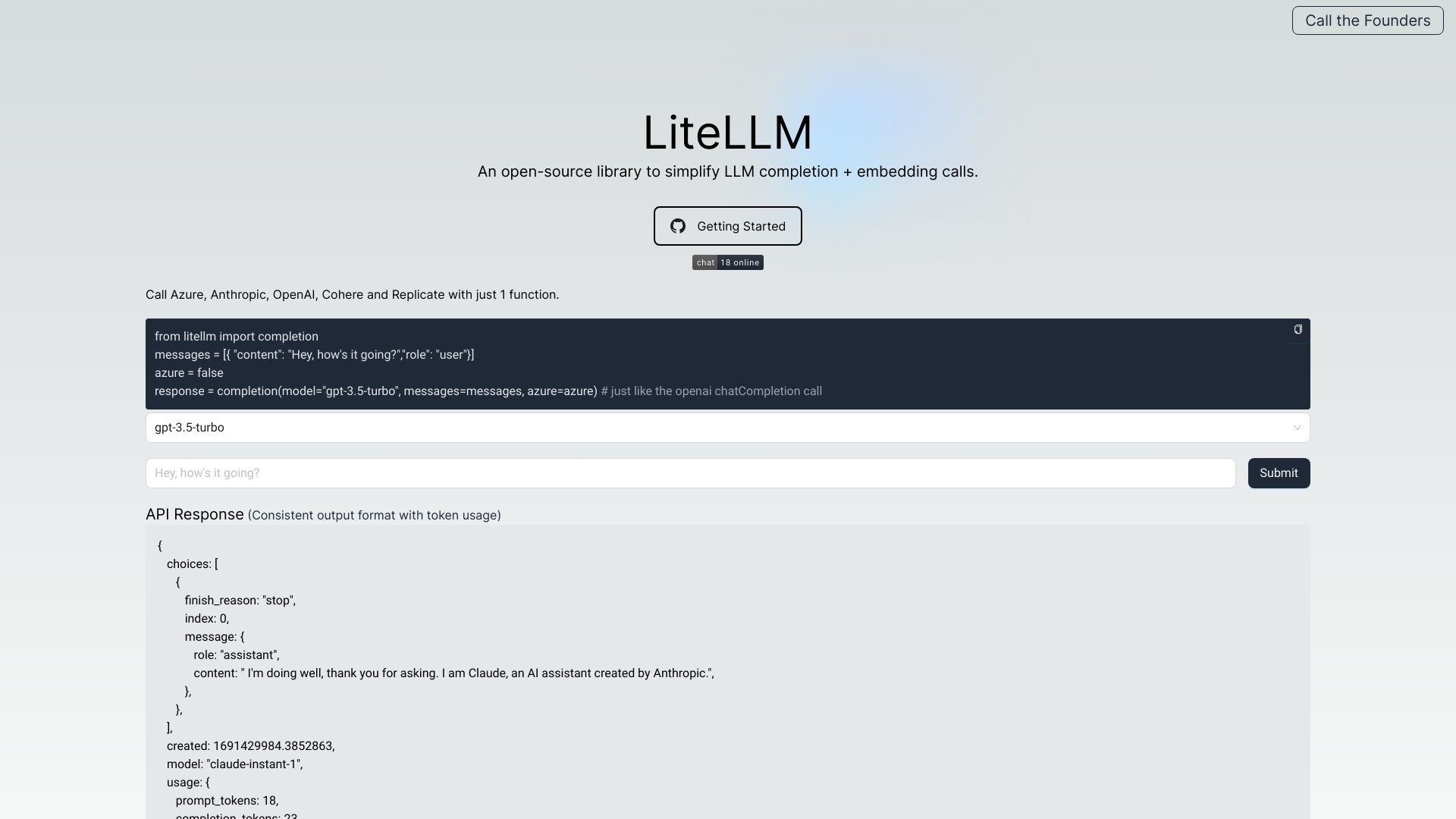

LiteLLM

Website öffnen-

Tool-Einführung:OpenAI-Proxy und LLM-Gateway für 100+ Modelle, Kosten im Blick.

-

Aufnahmedatum:2025-10-21

-

Soziale Medien & E-Mail:

Tool-Informationen

Was ist LiteLLM AI

LiteLLM AI ist ein LLM-Gateway und OpenAI-Proxy, das die Nutzung von Sprachmodellen über viele Anbieter hinweg vereinheitlicht. Es verwaltet Authentifizierung, Load Balancing und Kosten-Tracking für 100+ LLMs – bei durchgehendem OpenAI-Format. So erhalten Teams konsistente Antworten, Exceptions und Metriken, unabhängig davon, ob sie Modelle von OpenAI, Azure, Anthropic, Cohere, Google oder Replicate einsetzen. Zusätzlich bietet LiteLLM AI Logging, Fehlerverfolgung, Rate Limiting, Budgets, Guardrails, Prompt-Management, Batches API, S3-Logging und Pass-through-Endpunkte.

Hauptfunktionen von LiteLLM AI

- Einheitliche API im OpenAI-Format: Ein konsistentes Interface für unterschiedliche LLM-Anbieter reduziert Integrationsaufwand.

- Multi-Provider-Routing & Load Balancing: Verteilung von Anfragen auf mehrere Modelle/Regionen für Stabilität und Performance.

- Kosten- & Budget-Tracking: Ausgabenüberwachung pro Modell, Team oder Projekt mit transparenten Metriken.

- Batches API: Effiziente Verarbeitung großer Anfragevolumina und Hintergrundjobs.

- Guardrails & Richtlinien: Steuerung von Ausgaben, Inhalten und Zugriffen für Governance und Compliance.

- Model Access & Quotas: Feingranulare Zugriffssteuerung für Teams, Services und Umgebungen.

- LLM Observability: Logging, Tracing und Error Tracking inklusive optionalem S3-Logging.

- Rate Limiting: Schutz vor Überlastung und planbare Kapazitäten.

- Prompt-Management: Verwaltung, Versionierung und Wiederverwendung wichtiger Prompts.

- Pass-through-Endpunkte: Direkter Durchfluss zu Anbieter-APIs bei Bedarf, ohne das Format zu brechen.

- Konsistente Fehlerbehandlung: Einheitliche Exceptions und Retries über alle LLM-APIs hinweg.

Für wen ist LiteLLM AI geeignet

LiteLLM AI richtet sich an Engineering- und Plattformteams, die mehrere LLM-Anbieter flexibel nutzen möchten. Ideal für Unternehmen mit Multi-Cloud- oder Vendor-Strategie, MLOps- und Data-Engineering-Teams, die Observability, Kostenkontrolle und Governance benötigen. Ebenso geeignet für Produktteams, die LLM-Funktionen in SaaS-Apps integrieren, sowie für Start-ups, die Modelle evaluieren und schnell zwischen Anbietern wechseln wollen.

Wie man LiteLLM AI verwendet

- Anwendungsfall definieren: Zielmetriken, Modelle und Anbieter (z. B. OpenAI, Azure, Anthropic, Cohere, Google, Replicate) bestimmen.

- Authentifizierung einrichten: Provider-Schlüssel sicher hinterlegen und Zugriffsrechte konfigurieren.

- Routing & Policies konfigurieren: Modelle mappen, Load Balancing, Rate Limits, Budgets und Guardrails festlegen.

- Gateway anbinden: Ihre Anwendung so konfigurieren, dass Anfragen im OpenAI-Format an das Gateway gesendet werden.

- Betrieb & Monitoring: Logging, Fehlerverfolgung und Kosten-Metriken überwachen; bei Bedarf S3-Logging aktivieren.

- Optimieren & Skalieren: Batches API nutzen, Routing anpassen, Prompts verwalten und Quotas feinjustieren.

Branchenspezifische Anwendungsfälle von LiteLLM AI

Im E-Commerce steuert LiteLLM AI Produkttexte, Chatbots und Übersetzungen mit Kosten- und Rate Limiting-Kontrolle. In der Finanzbranche unterstützt es Berichtsautomatisierung und KYC-Assistenzen mit strikten Guardrails und Budgets. Im Gesundheitswesen hilft es bei Triage-Dialogen und dokumentationsbezogenem Logging. In der Bildung ermöglichen Tutor-Bots konsistente Antworten über verschiedene Modelle. In der Softwareentwicklung sorgt Provider-Routing für stabile Code-Assistenz und geringere Ausfallzeiten.

Preismodell von LiteLLM AI

Preisinformationen, etwa zu Stufen, Abrechnung nach Nutzung oder möglichen Testzeiträumen, werden vom Anbieter bereitgestellt und können je nach Einsatzszenario variieren. Prüfen Sie die offizielle Produktdokumentation für aktuelle Details zu Tarifen, kostenlosen Optionen oder Testphasen.

Vorteile und Nachteile von LiteLLM AI

Vorteile:

- Einheitliche API im OpenAI-Format für viele Provider.

- Schnelles Wechseln und Load Balancing zwischen Modellen und Anbietern.

- Transparentes Kosten-Tracking und Budgets pro Team/Projekt.

- Umfassende Observability mit Logging, Tracing und Fehleranalyse.

- Governance durch Guardrails, Rate Limits und Quotas.

- Effizienz bei Massentransaktionen via Batches API.

- Konsistente Exceptions und vereinheitlichte Fehlerbehandlung.

Nachteile:

- Zusätzliche Komplexität durch eine weitere Gateway-Schicht.

- Möglicher Latenz-Overhead im Vergleich zur Direktanbindung.

- Funktionsparität kann je nach Modell/Provider variieren.

- Einrichtung und Policy-Design erfordern initialen Aufwand.

Häufige Fragen zu LiteLLM AI

-

Frage 1: Welche Anbieter werden unterstützt?

LiteLLM AI vereinfacht den Zugriff auf LLMs mehrerer Provider wie OpenAI, Azure, Anthropic, Cohere, Google und Replicate sowie weitere, abhängig von der Konfiguration.

-

Frage 2: Muss ich meinen Code stark anpassen?

In der Regel nicht. Dank des OpenAI-kompatiblen Formats sind nur minimale Änderungen notwendig, um bestehende Integrationen weiterzuverwenden.

-

Frage 3: Wie hilft LiteLLM AI bei der Kostenkontrolle?

Über Kosten-Tracking, Budgets und Metriken lassen sich Ausgaben pro Modell, Team oder Projekt nachvollziehen und steuern.

-

Frage 4: Was bedeutet LLM Observability in diesem Kontext?

Es umfasst Logging, Tracing und Fehlerverfolgung für alle Modelle; optional können Ereignisse per S3-Logging archiviert werden.

-

Frage 5: Wozu dienen Pass-through-Endpunkte?

Sie leiten Anfragen bei Bedarf direkt an den Ziel-Provider durch, behalten aber das einheitliche Request-/Response-Format bei.