- Startseite

- KI Bildgenerator

- Modal

Modal

Website öffnen-

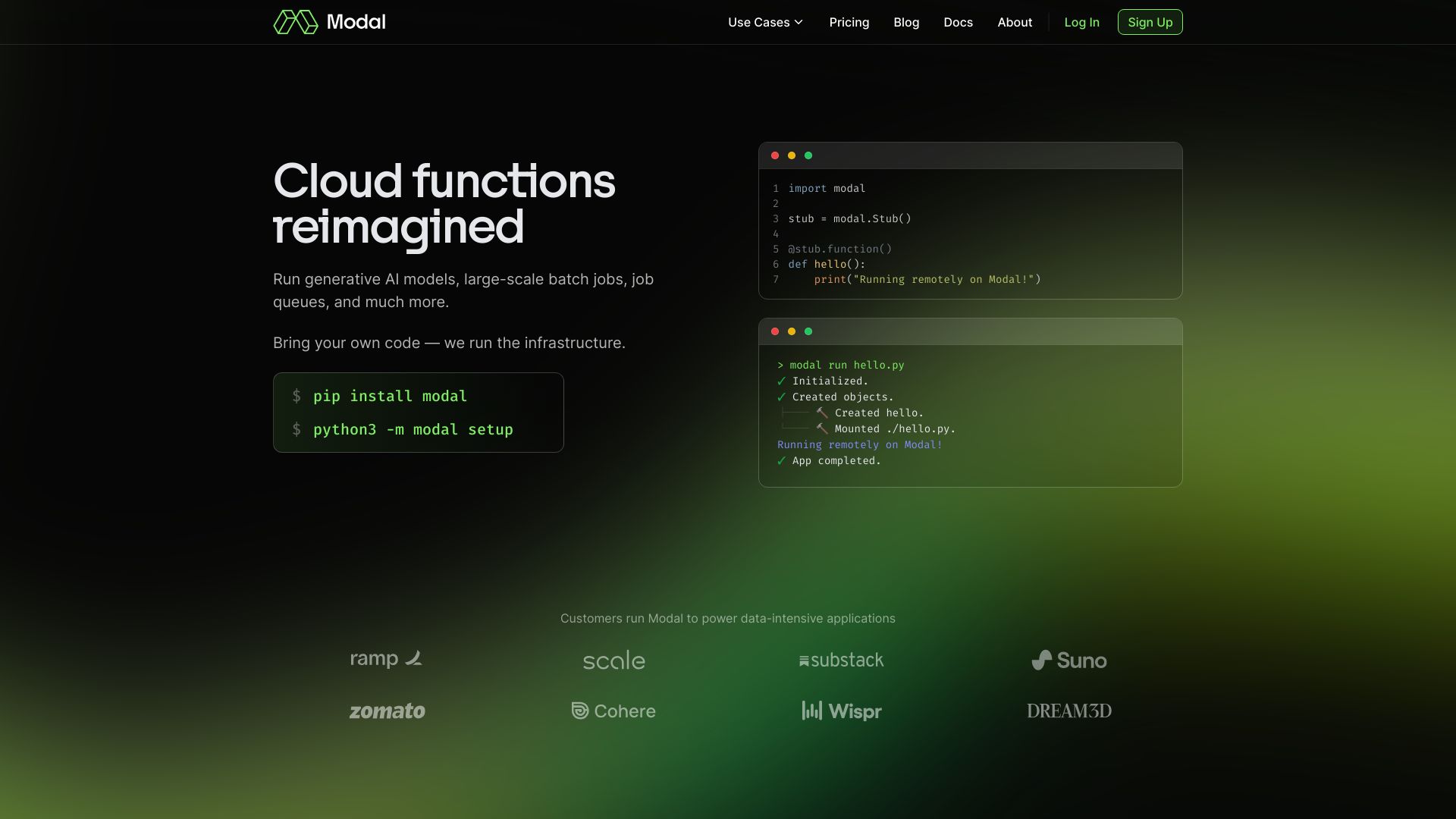

Tool-Einführung:Serverlose KI-Infrastruktur: eigener Code auf GPU/CPU sofortiges Autoscaling

-

Aufnahmedatum:2025-10-21

-

Soziale Medien & E-Mail:

Tool-Informationen

Was ist Modal AI

Modal AI ist eine serverlose Plattform für KI- und Datenteams, die hochperformante KI-Infrastruktur on demand bereitstellt. Sie bringt Ihren eigenen Code in produktionsreife CPU- und GPU-Workloads und führt ML-Inferenz, Datenjobs und andere rechenintensive Aufgaben in großem Maßstab aus. Dank sofortigem Autoscaling, Container-Starts in unter einer Sekunde und dem Betrieb ohne Konfigurationsdateien reduziert Modal AI den DevOps-Aufwand. Teams liefern schneller aus, skalieren kosteneffizient und halten Latenzen niedrig – vom Prototyp bis zur Produktion.

Hauptfunktionen von Modal AI

- Serverlose KI-Infrastruktur: Rechenressourcen werden bedarfsgerecht bereitgestellt, Verwaltung und Provisionierung entfallen.

- CPU- und GPU-Compute: Führen Sie GPU-intensive Modelle und CPU-basierte Datenverarbeitung mit derselben Plattform aus.

- Instant Autoscaling: Automatisches Hoch- und Herunterskalieren für ML-Inferenz und Datenjobs je nach Last.

- Schnelle Container-Starts: Startzeiten von Containern in unter einer Sekunde minimieren Kaltstart-Latenzen.

- Bring your own code: Eigenen Code in Containern ausführen – ohne separate Konfigurationsdateien.

- Skalierung und Parallelisierung: Rechenintensive Workloads effizient parallel ausführen.

- Niedrige Betriebslast: Weniger Infrastrukturarbeit, mehr Fokus auf Modelle, Daten und Produkt.

Für wen ist Modal AI geeignet

Modal AI richtet sich an Data Scientists, ML Engineers, MLOps-Teams und Softwareentwickler, die ML-Inferenz, Batch-Verarbeitung oder andere rechenintensive Prozesse zuverlässig skalieren möchten. Ideal für Start-ups und Unternehmen, die ohne eigene Cluster-Infrastruktur GPU-Compute nutzen wollen, sowie für Teams, die schnelle Iteration, niedrige Latenz und automatische Skalierung benötigen.

Wie man Modal AI verwendet

- Registrieren und ein Projekt anlegen.

- Eigenen Code und Abhängigkeiten als Container-Image oder Laufzeitumgebung definieren.

- Ressourcen festlegen (z. B. CPU, GPU, RAM) und den Entry-Point bestimmen.

- Workload deployen und Endpunkte für Inferenz oder Datenjobs bereitstellen.

- Jobs per API aufrufen oder automatisiert auslösen; Modal AI skaliert sofort mit der Last.

- Ergebnisse abrufen, Latenzen beobachten und Ressourcen bei Bedarf anpassen.

Branchenspezifische Anwendungsfälle von Modal AI

E-Commerce: Echtzeit-Produktempfehlungen und Ranking via GPU-gestützter Inferenz. Medien & Unterhaltung: Bild-/Videobearbeitung, Transkodierung, Captioning. FinTech: Betrugserkennung und Batch-Scoring datenintensiver Modelle. Gesundheitswesen: Verarbeitung medizinischer Bilddaten und Modellinferenz mit niedriger Latenz. Industrie: Qualitätsprüfung per Computer Vision und skalierbare Sensordatenanalyse.

Preismodell von Modal AI

Die Abrechnung erfolgt typischerweise nutzungsbasiert, orientiert an verbrauchter Rechenleistung (z. B. CPU-/GPU-Zeit) und Laufzeit. Für aktuelle Tarife, Limits und mögliche kostenlose Kontingente oder Testphasen konsultieren Sie bitte die offizielle Preisseite des Anbieters.

Vorteile und Nachteile von Modal AI

Vorteile:

- Sehr geringe Startlatenz durch Container-Starts in unter einer Sekunde.

- Autoscaling passt Ressourcen dynamisch an Lastspitzen an.

- Keine Konfigurationsdateien – schneller von Code zu Produktion.

- CPU- und GPU-Compute auf einer einheitlichen Plattform.

- Weniger Betriebsaufwand, Fokus auf Modelle und Daten.

Nachteile:

- Abhängigkeit von einem externen Plattformanbieter (Vendor-Lock-in-Risiko).

- Feinsteuerung der Infrastruktur ist begrenzt im Vergleich zu eigenen Clustern.

- Kosten können bei dauerhaft hoher Auslastung steigen.

- Netzwerk- und Datenübertragungen können Latenz und Kosten beeinflussen.

Häufige Fragen zu Modal AI

Unterstützt Modal AI sowohl CPU- als auch GPU-Workloads?

Ja. Die Plattform ist für CPU- und GPU-intensive Aufgaben wie ML-Inferenz und Datenjobs ausgelegt.

Wie schnell starten Workloads auf Modal AI?

Container können mit Startzeiten unter einer Sekunde hochfahren, was Kaltstart-Latenzen deutlich reduziert.

Muss ich meine Anwendung umschreiben?

Nein. Sie können Ihren eigenen Code mitbringen und als Container ausführen, ohne separate Konfigurationsdateien.

Skaliert Modal AI automatisch mit der Nachfrage?

Ja. Instant Autoscaling passt die verfügbaren Ressourcen dynamisch an Last und Durchsatz an.

Eignet sich Modal AI für Batch-Datenjobs und Echtzeit-Inferenz?

Beides. Die Plattform deckt hochparallele Datenverarbeitung ebenso ab wie latenzkritische Echtzeit-Inferenz.