- ホーム

- AI画像ジェネレーター

- Modal

Modal

ウェブサイトを開く-

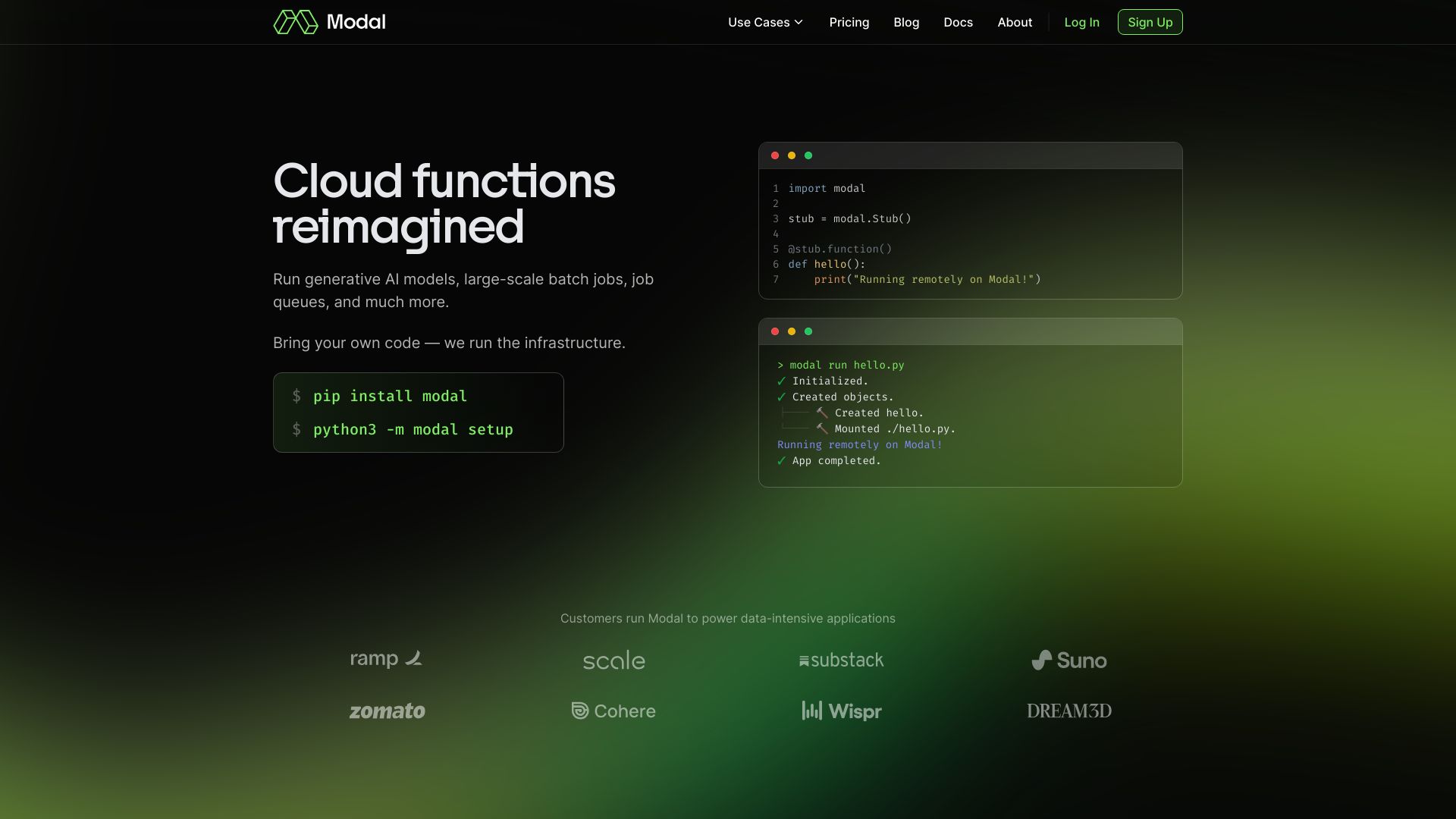

ツール紹介:AI/データ向けサーバーレス基盤。自分のコードをGPU/CPUで即時スケール、コンテナ起動サブ秒・設定不要。推論/データ処理に最適

-

登録日:2025-10-21

-

ソーシャルメディアとメール:

ツール情報

Modal AIとは?

Modal AIは、AIとデータチーム向けのサーバーレス計算プラットフォームです。高性能なAIインフラを提供し、ユーザーは手元のコードをそのまま持ち込んで、CPUやGPUを用いた推論、データ処理、計算集約ジョブを大規模に実行できます。コンテナはサブセカンドで起動し、需要に応じて即時にオートスケール。設定ファイルに依存しないコードファーストの運用により、依存関係のビルドからデプロイ、監視までを一貫して扱えます。ML推論APIの公開、バッチ処理パイプラインの構築、スケジュール実行や分散マップ処理など多様なワークロードに対応。ログやメトリクス、シークレット管理、永続ストレージといった運用機能も備え、インフラ管理の負担を抑えながら、開発から本番運用までのリードタイム短縮に寄与します。

Modal AIの主な機能

- サーバーレス実行基盤:需要に応じたインスタントなオートスケーリングと細かな従量課金。

- サブセカンドのコンテナ起動:コールドスタートの影響を最小化し、低レイテンシ推論を実現。

- CPU/GPUのオンデマンド割り当て:推論・学習・データ処理に合わせてリソースを柔軟に選択。

- コードファースト運用:設定ファイル不要で、依存関係の宣言とイメージビルドをコードから実行。

- Webエンドポイント:モデル推論をREST APIとして公開し、外部サービスと容易に連携。

- バッチ処理・データパイプライン:スケジューラ、ワークフロー、分散マップで大規模データを効率処理。

- 永続ストレージ:ボリュームや外部ストレージ連携でステートフルなワークロードにも対応。

- シークレット管理:APIキーや認証情報を安全に取り扱い。

- 可観測性:リアルタイムログ、メトリクス、トレースで運用を可視化。

- 実行制御:同時実行数、タイムアウト、リトライ、キューイングなどの挙動を細かく設定。

- CLI/SDK:ローカル開発からクラウド実行までを一体化し、CI/CDにも組み込みやすい。

- バージョニングとロールバック:安全なリリースと迅速な切り戻しをサポート。

Modal AIの対象ユーザー

大規模なAI推論やデータ処理を素早く本番化したい機械学習エンジニア、データエンジニア、バックエンドエンジニアに適しています。スタートアップのMVPからエンタープライズの本番運用まで、GPUを必要とするモデル提供、ETLや特徴量生成、定期バッチ、イベント駆動処理、RAGなど生成AIパイプラインの運用に向いています。インフラのプロビジョニングやスケーリングを最小限にし、コード中心で高速に反復したいチームに有効です。

Modal AIの使い方

- アカウントを作成し、CLI/SDKをインストールします。

- プロジェクトを用意し、関数・ジョブ・ワークフローを定義(依存関係とコンテナイメージのビルド手順をコードで宣言)します。

- 必要なリソース(CPU/GPU、メモリ、タイムアウト、同時実行数)を指定します。

- シークレットや環境変数、永続ボリューム・外部ストレージ連携を設定します。

- ローカルで挙動を確認し、ログやメトリクスを用いてテストを行います。

- Webエンドポイントとして公開するか、スケジュール/イベントでのトリガーを設定します。

- デプロイを実行し、バージョンを固定して安定運用に移行します。

- 運用中はログ・メトリクスを監視し、スケール設定やリソース配分を最適化します。

- 必要に応じてロールバックやパイプラインの改良を行います。

Modal AIの業界での活用事例

ECではレコメンドやパーソナライズ推論APIの提供、メディアでは画像・動画のバッチ推論とトランスコーディング、金融ではモンテカルロによるリスク計測や不正検知の特徴量生成、製造では欠陥検知モデルのオンライン推論とバックフィル処理、医療・ライフサイエンスでは大規模データの前処理パイプライン構築、マーケティングではETLとオーディエンス作成、生成AI分野ではRAGの埋め込み生成やインデキシング、チャット推論エンドポイントのスケール運用などに活用されています。

Modal AIの料金プラン

料金は一般にリソース使用量に基づく従量課金が中心で、CPU/GPUの実行時間、ストレージ、データ転送などに応じて課金されます。常時稼働サーバーを前提とせず、アイドル時のコストを抑えられる点が特徴です。チーム/組織向け機能やサポート、SLA等は契約内容により異なる場合があります。具体的な単価や構成は変動するため、最新情報は公式サイトでの確認を推奨します。

Modal AIのメリットとデメリット

メリット:

- インフラ管理不要で、開発から本番までのリードタイムを短縮。

- サブセカンドの起動とオートスケールにより、低レイテンシかつ弾力的に運用可能。

- GPUを含む計算リソースをオンデマンドで確保でき、ピークにも対応。

- コードファーストでCI/CDに組み込みやすく、再現性の高いデプロイが可能。

- ログ・メトリクス・シークレット・スケジューラが統合され、運用が簡素化。

- 従量課金により、疎なトラフィックやバースト型のワークロードでコスト効率が高い。

デメリット:

- 特殊なネットワーキングやハードウェア要件がある場合、構成に制約が生じることがある。

- 一部のワークロードではコールドスタートの影響を完全に回避できない場合がある。

- 実行モデルやSDKに依存するため、ベンダーロックインの懸念がある。

- 常時稼働の長時間ジョブは、IaaSに比べて割高になる可能性がある。

- 特定のエコシステムに最適化が偏るケースでは、他言語/ランタイムでの最適化に工夫が必要。

Modal AIに関するよくある質問

-

質問:既存のコードをそのまま持ち込めますか?

回答:依存関係を宣言し、コンテナイメージをビルドすることで移行できます。コードファーストの定義により、既存リポジトリとCI/CDに組み込みやすい設計です。

-

質問:コールドスタートはどの程度影響しますか?

回答:コンテナのサブセカンド起動により影響は抑制されています。トラフィックに合わせたスケーリングとウォームアップ戦略の併用で、待ち時間をさらに低減できます。

-

質問:GPUリソースは必要なときだけ使えますか?

回答:オンデマンドで割り当て・スケールでき、推論やバッチ処理の負荷に応じて柔軟に利用可能です。

-

質問:ステートフルな処理は可能ですか?

回答:永続ストレージや外部データベースと連携することで、前処理キャッシュや中間成果物の保存などステートフルなワークロードにも対応できます。

-

質問:監視やトラブルシューティングはどう行いますか?

回答:リアルタイムログ、メトリクス、トレースを用いてボトルネックを可視化し、実行制御(リトライ、タイムアウト、同時実行数)と組み合わせて安定運用を図れます。

-

質問:APIの認証やアクセス制御はどう実装しますか?

回答:Webエンドポイントに認証・認可を組み込み、必要に応じて外部のAPIゲートウェイやIDプロバイダと連携する構成が一般的です。