Modal

打開網站-

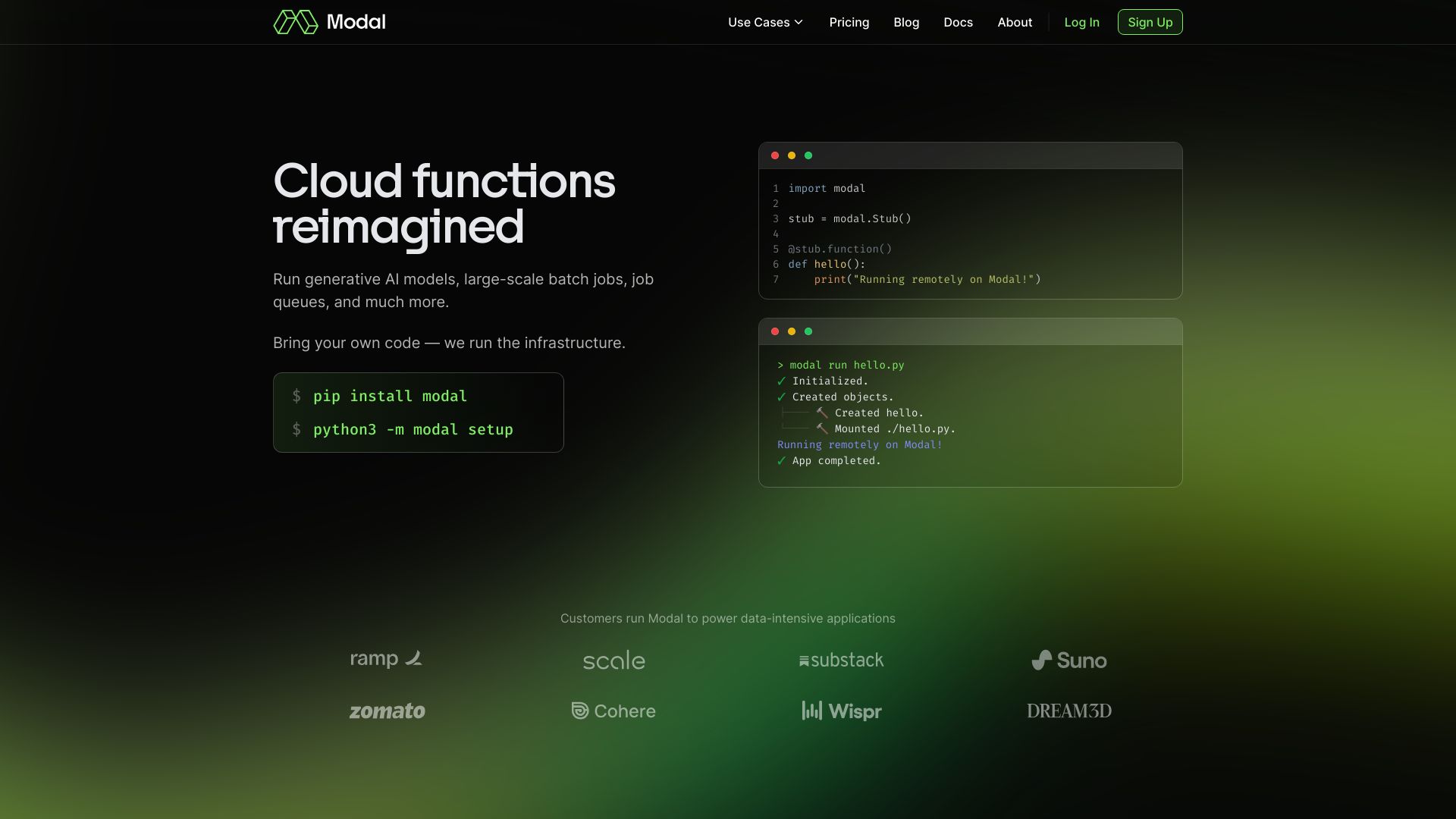

工具介紹:面向AI與資料團隊的無伺服器平台,帶上程式碼即可於GPU/CPU彈性運行,容器亞秒啟動,免設定,支援推論與資料作業

-

收錄時間:2025-10-21

-

社群媒體&信箱:

工具資訊

什麼是 Modal AI

Modal AI 是一個面向 AI 與資料團隊的無伺服器運算平台,提供高效能的 AI 基礎設施,讓使用者以熟悉的程式碼直接啟動 CPU、GPU 與資料密集型工作負載,免去自行管理叢集與節點。它主打亞秒級容器啟動、即時自動擴縮與零配置檔,能快速把原型轉為可觀測、可擴展的生產服務,涵蓋機器學習推論、批次資料作業、特徵工程與工作流程排程等情境。透過一致的容器化執行環境與快取建置機制,開發者可重現依賴、縮短部署時間,並以細緻的資源設定控制成本與延遲。平台提供以 Python 為核心的開發體驗與 CLI/SDK,支援 Bring Your Own Code 的彈性,讓團隊在不更動架構的前提下,將現有模型、函式與管線直接搬上雲端。其核心價值在於把基礎設施複雜度抽象化,讓團隊專注於模型品質與資料價值,同時在高流量與尖峰負載下維持穩定、可預測的效能。此外,Modal AI 針對延遲敏感的推論場景提供並發控制與熱容器池,對批次與資料管線則提供依賴圖與重試策略,兼顧可用性與吞吐量。藉由可觀測性與成本洞察,團隊能持續調整資源型號與併發策略,以取得更優的性價比。

Modal AI 主要功能

- 無伺服器推論 API:一鍵部署模型推論端點,亞秒級冷啟動與自動擴縮,應對突發流量而不需預先配置叢集。

- 批次與資料作業:執行 ETL、特徵工程、資料清洗與離線推論,支援分散式並行與工作重試。

- GPU/CPU 資源配置:為每個任務指定 GPU 型號、記憶體與並行度,在延遲與成本之間取得平衡。

- 容器化與映像建置:自動建置映像與依賴快取,零配置檔即可上線,確保可重現與一致性。

- 工作流程與排程:定義任務依賴、定時排程、檢查點與重試策略,輕鬆串接端到端管線。

- 觀測與監控:提供日誌、指標與追蹤,並具成本與資源使用洞察,便於調優。

- 安全與隔離:內建祕密管理、環境變數與網路隔離,降低憑證與資料外洩風險。

- 開發者體驗:以 Python SDK 與 CLI 為核心,支援 Bring Your Own Code,可在本機模擬與預覽。

- 即時自動擴縮:依需求動態擴張或收斂計算資源,以用量付費,提升資源使用效率。

Modal AI 適用人群

適合需快速上線與擴展 AI 工作負載的團隊,包括機器學習工程師、資料工程師、資料科學家、MLOps 團隊與產品工程團隊。典型場景涵蓋延遲敏感的模型推論 API、具尖峰流量的應用後端、批次資料處理與特徵生成管線、向量嵌入與索引建置、媒體轉碼與任務排程,及需要以最少基礎設施管理成本達成高可用與高擴展的初創與企業團隊。

Modal AI 使用步驟

- 建立帳戶並設定專案,視需要連結物件儲存或資料來源。

- 安裝 SDK 與 CLI,初始化專案骨架,撰寫函式、任務或服務端點。

- 定義執行環境與依賴(基底映像、套件)、以及所需資源(CPU/GPU、記憶體、並行度)。

- 在本機進行單元測試與小規模試跑,確認 I/O、延遲與資源配置。

- 建置容器映像並部署至雲端,為推論服務或批次作業設定入口(API、排程或工作流程)。

- 啟用自動擴縮與重試策略,設定並發上限與逾時,確保穩定性。

- 透過日誌與指標監控效能與成本,持續調整資源型號、快取與批量大小。

Modal AI 行業案例

在電商領域,團隊可將重排序與推薦模型部署為推論 API,於促銷尖峰自動擴容,降低延遲並保障轉換率;媒體與娛樂可運行影像轉碼、內容標註與字幕生成的批次作業,利用 GPU 並行縮短處理時間;金融服務可批量執行風險評分與詐欺偵測,藉由工作流程排程確保日結任務準時完成;企業內部的知識檢索與 RAG 管線可在平台上完成向量嵌入計算、索引建置與週期性更新;遊戲與社群應用則能以低延遲方式提供毒性偵測或配對推論服務,隨流量自動擴縮以維持體驗。

Modal AI 收費模式

一般採用按用量計費模式,依實際消耗的計算資源(CPU/GPU 執行時間)、儲存與網路傳輸等項目收費;團隊與企業可選擇更進階的容量或合約方案,以取得配額、SLA 與進階支援。具體價格、免費額度或試用安排可能隨時間調整,建議以官方定價頁與合約條款為準。

Modal AI 優點和缺點

優點:

- 亞秒級容器啟動與即時自動擴縮,適合延遲敏感與突發流量場景。

- 無伺服器模型簡化部署與維運,降低叢集與節點管理成本。

- 以程式碼驅動的工作流與 Bring Your Own Code,遷移既有專案更容易。

- 細緻的 CPU/GPU 資源控制與觀測性,便於在效能與成本間取捨。

- 容器化與依賴快取確保可重現性,縮短從開發到上線的時間。

缺點:

- 對特定硬體型號或區域的可用性受平台供應限制。

- 仍存在冷啟動邊界情況,大型映像或首次拉取可能增加延遲。

- 長時間有狀態工作需重構為無狀態或切分為可重試的任務。

- 開發體驗以 Python 為主,其他語言在整合度與工具鏈上可能受限。

- 雲端相依度較高,需評估與既有基礎設施的整合與合規要求。

Modal AI 熱門問題

-

問題 1: Modal AI 與自行管理的 Kubernetes 相比有何差異?

Modal AI 以無伺服器方式抽象叢集管理、節點排程與自動擴縮,提供亞秒級啟動與按需付費;Kubernetes 能高度自訂但需自建與維運,成本與複雜度更高。

-

問題 2: 支援哪些開發語言與框架?

以 Python SDK 與 CLI 為核心體驗,常見 ML/資料科學框架皆可透過容器依賴安裝與運行;亦可攜帶既有程式碼與可執行檔上線。

-

問題 3: 冷啟動會影響延遲嗎?

平台設計為亞秒級容器啟動,並可透過並發控制與熱容器池減緩冷啟動影響;首次拉取大型映像或安裝依賴時延遲可能上升。

-

問題 4: 如何管理機密與金鑰?

可使用內建祕密管理與環境變數,在執行時安全注入,不需將憑證寫入程式碼或映像。

-

問題 5: 能否同時處理推論服務與批次資料管線?

可以。Modal AI 同時支援長駐端點、工作流程與排程,適合將線上推論與離線批次整合於同一平台,並共享觀測與資源策略。