- Startseite

- AI APIs

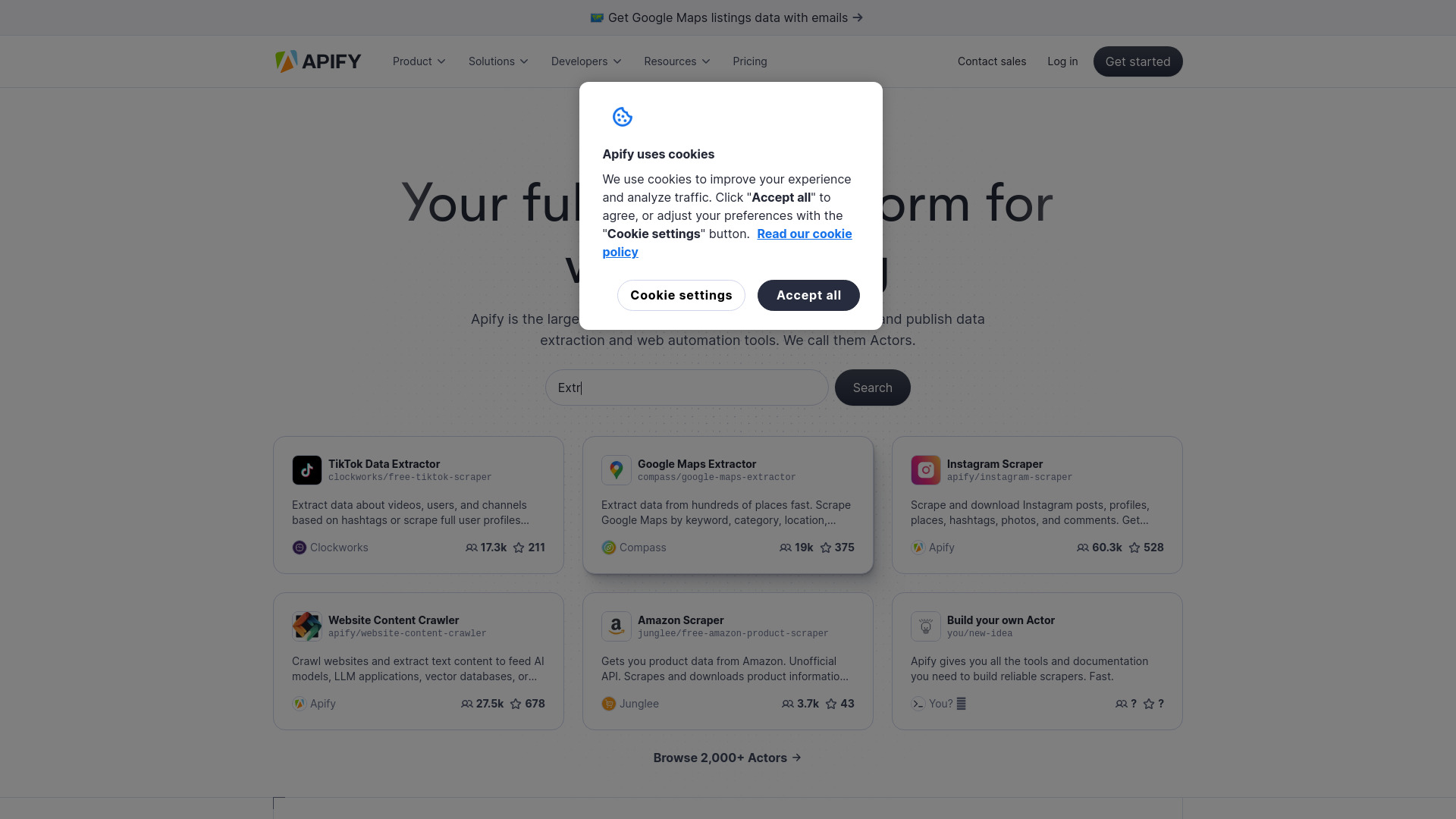

- Apify

Apify

Website öffnen-

Tool-Einführung:Apify AI: Web-Scraping, KI-Agenten und Automation mit Proxies.

-

Aufnahmedatum:2025-10-21

-

Soziale Medien & E-Mail:

Tool-Informationen

Was ist Apify AI

Apify AI ist ein umfassendes Full-Stack-Ökosystem für Web Scraping, Datenextraktion und Automatisierung. Entwickler und Teams können damit Web‑Scraper, KI‑Agenten und Automations‑Workflows bauen, deployen und veröffentlichen. Die Plattform stellt fertige Tools, Code‑Vorlagen und maßgeschneiderte Lösungen bereit, unterstützt Open‑Source‑Projekte wie Crawlee und bietet Anti‑Blocking‑ sowie Proxy‑Optionen. So lassen sich skalierbare Datapipelines samt Scheduling, Monitoring und API‑Zugriff zuverlässig betreiben – von einmaligen Extraktionen bis zu kontinuierlichen Crawls in Produktionsqualität.

Hauptfunktionen von Apify AI

- Vorgefertigte Scraper & Tools: Bibliothek mit sofort einsatzbereiten Web-Scraping-Jobs und Automationen für gängige Websites und Anwendungsfälle.

- Code‑Vorlagen & SDK-Unterstützung: Starten Sie eigene Projekte mit Templates und dem Open‑Source‑Framework Crawlee für robuste Crawler.

- Deployment & Scheduling: Workflows in der Cloud ausführen, planen, wiederholen und zuverlässig skalieren.

- Anti‑Blocking & Proxies: Integrierte Proxy-Optionen und Anti‑Blocking‑Mechanismen für höhere Erfolgsraten.

- API & Webhooks: Ergebnisse per API abrufen, Webhooks nutzen und Daten nahtlos in bestehende Systeme integrieren.

- Datenexport: Ausgaben in gängigen Formaten (z. B. JSON, CSV) für Analytics, BI und Data Pipelines.

- Monitoring & Logs: Laufzeit‑Metriken, Protokolle und Fehlermanagement für stabile Datenextraktion.

- Teamfunktionen: Projekte teilen, Berechtigungen steuern und Versionen nachvollziehen.

Für wen ist Apify AI geeignet

Apify AI passt zu Dateningenieuren, Entwicklern, Growth- und Marketing-Teams, E‑Commerce und Operations, die skalierbares Web Scraping und Automatisierung benötigen. Auch Research, Medien und Beratungen profitieren, wenn regelmäßig strukturierte Webdaten, Markt- und Wettbewerbsinformationen oder wiederkehrende Browser-Aufgaben automatisiert werden sollen.

Wie man Apify AI verwendet

- Konto erstellen und Projekt anlegen.

- Ein Template oder ein vorgefertigtes Tool wählen – oder eigenen Crawler mit Crawlee erstellen.

- Quellen, Selektoren und Parameter konfigurieren; optional Proxy-Einstellungen und Limits setzen.

- Job starten, Fortschritt im Monitoring verfolgen und Logs prüfen.

- Ergebnisse in JSON/CSV exportieren oder per API/Webhook abrufen.

- Automatische Schedules einrichten und bei Bedarf skalieren.

Branchenspezifische Anwendungsfälle von Apify AI

Im E‑Commerce für Preis- und Sortimentsmonitoring, Katalog-Updates und Verfügbarkeiten. In Marketing & SEO für Wettbewerbsbeobachtung, Content‑Audits und Trendanalysen. In der Marktforschung zum Sammeln öffentlich zugänglicher Daten aus Verzeichnissen, Job‑ und Immobilienportalen. In den Medien für News‑Aggregation und Quellenbeobachtung. In Operations zur Automatisierung wiederkehrender Web‑Workflows und Formularprozesse.

Preismodell von Apify AI

Die Konditionen können je nach Nutzung und Funktionsumfang variieren. Aktuelle Informationen zu Plänen, inkludierten Ressourcen und möglichen Testoptionen finden Sie auf der offiziellen Website von Apify. Prüfen Sie dort Details zu Limits, Abrechnung und gegebenenfalls verfügbaren kostenlosen Kontingenten.

Vorteile und Nachteile von Apify AI

Vorteile:

- End‑to‑End‑Plattform: Von Entwicklung über Deployment bis Datenexport alles an einem Ort.

- Skalierbarkeit: Zuverlässige Ausführung, Scheduling und Warteschlangen für große Datenmengen.

- Reiches Ökosystem: Vorlagen, fertige Tools und Open‑Source‑Support (Crawlee).

- Anti‑Blocking & Proxies: Höhere Erfolgsquoten bei anspruchsvollen Zielen.

- Starke Integrationen: API, Webhooks und flexible Datenformate.

- Transparentes Monitoring: Logs, Metriken und Fehlermanagement.

Nachteile:

- Wartungsaufwand: Webseiten ändern sich häufig; Selektoren und Flows müssen angepasst werden.

- Lernkurve: Komplexe Extraktionen erfordern Wissen zu Crawler‑Design, Rate‑Limits und Datenqualität.

- Compliance: Rechtliche Vorgaben, AGB und Robots‑Regeln sind je Anwendungsfall zu prüfen.

- Kosten bei Volumen: Hohe Crawl‑Frequenzen und Proxy‑Nutzung können das Budget belasten.

Häufige Fragen zu Apify AI

-

Was ist der Unterschied zwischen Templates und eigenen Scrapers?

Templates und fertige Tools ermöglichen einen schnellen Start ohne viel Code. Eigene Scraper bieten maximale Kontrolle mit Crawlee und individuellen Workflows.

-

Welche Datenformate unterstützt Apify AI beim Export?

Typisch sind gängige Formate wie JSON und CSV, die sich leicht in Analytics‑ und BI‑Pipelines integrieren lassen.

-

Benötige ich Programmierkenntnisse?

Nicht zwingend: Viele Anwendungsfälle lassen sich mit vorgefertigten Tools konfigurieren. Für komplexe Projekte sind Coding‑Kenntnisse hilfreich.

-

Wie geht Apify AI mit Blockaden um?

Es stehen Proxy-Optionen und Anti‑Blocking‑Mechanismen bereit. Nutzen Sie diese verantwortungsvoll und im Einklang mit rechtlichen Vorgaben.

-

Ist die Nutzung legal?

Die Verantwortung liegt beim Anwender. Beachten Sie Gesetze, AGB, robots.txt und Datenschutzanforderungen und extrahieren Sie nur zulässige, öffentlich zugängliche Inhalte.