Apify

ウェブサイトを開く-

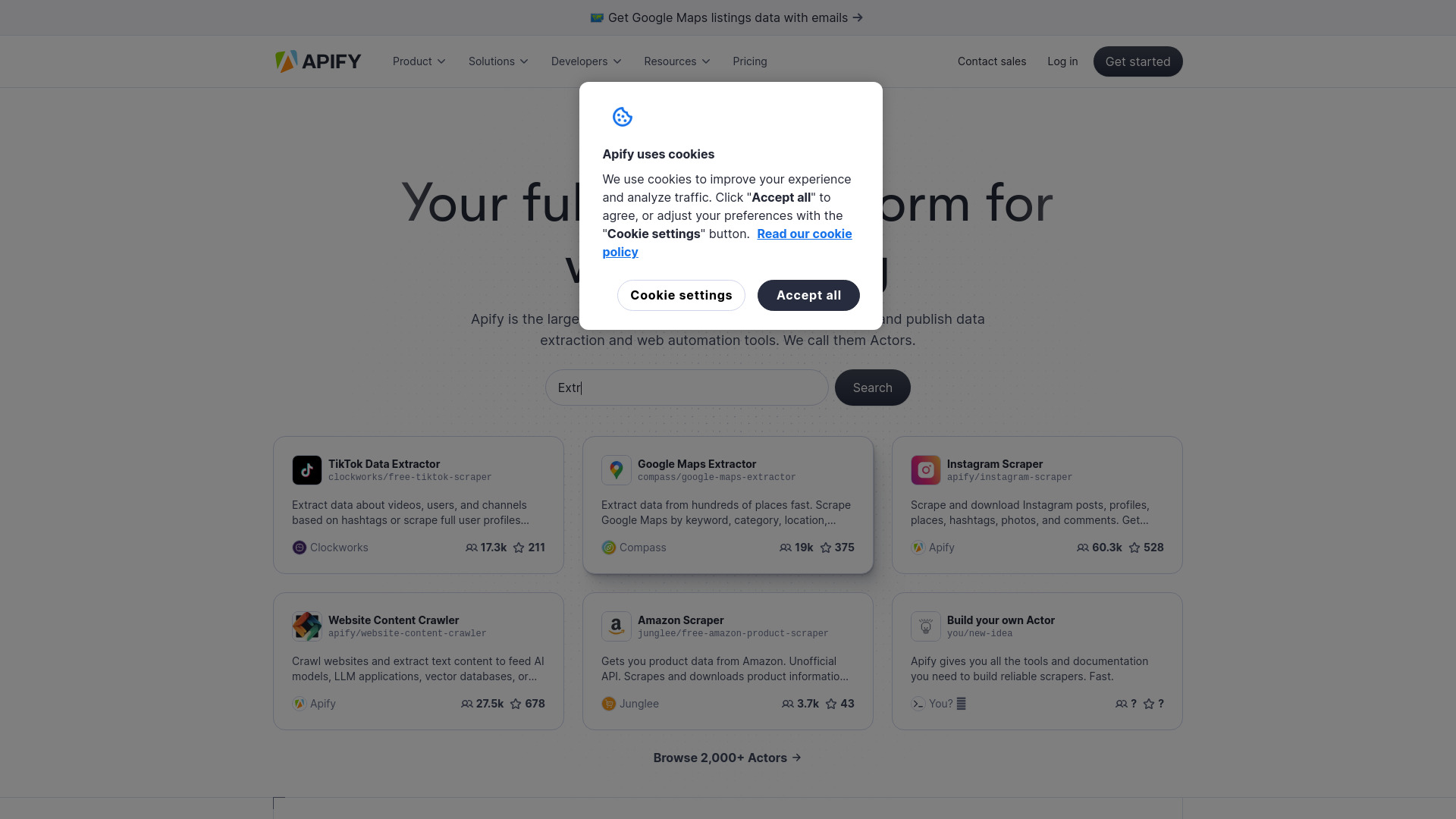

ツール紹介:Apify AI:WebスクレイピングとAIエージェント、自動化。プロキシやアンチブロック、テンプレートも充実

-

登録日:2025-10-21

-

ソーシャルメディアとメール:

ツール情報

Apify AIとは?

Apify AIは、Web上の情報収集と業務自動化を効率化するためのフルスタック基盤です。開発者はスクレイパーやAIエージェントを素早く構築・デプロイ・運用でき、マーケットプレイスで公開された既製ツールやコードテンプレートも活用可能。高度なデータ抽出、クローリング、ワークフロー自動化を一つの環境で完結できるのが特長です。オープンソースのCrawleeと連携しやすく、アンチブロッキングやプロキシなどの対策も用意。取得したデータはAPIやWebhookで外部システムへ連携でき、CSVやJSONとしてエクスポートも容易です。Apifyのエコシステムでは、公開アクターを選んで設定を変えるだけで一般的なタスクをすぐに実行でき、独自要件にはカスタムソリューションも柔軟に対応。スケジューラやキュー、データセット、キーバリューストアといった実務的な機能が揃い、運用負荷を抑えながら信頼性の高いクローリング基盤を構築できます。Webスクレイピング、データ抽出、AIエージェントによる自動化を一貫して進めたい企業・開発者にとって、開発から本番運用までの時間短縮とスケール面で大きな価値を提供します。

Apify AIの主な機能

- Webスクレイピング/クローリング基盤:堅牢な実行環境とジョブ管理で安定運用をサポート

- AIエージェントと自動化:サイト巡回、抽出、変換、通知までの一連のフローを自律的に実行

- テンプレート/マーケットプレイス:用途別の既製アクターを選んで即利用、カスタム化も容易

- Crawlee対応:オープンソースSDKと親和性が高く、コードベースの拡張がしやすい

- アンチブロッキング/プロキシ:ブロック回避やトラフィック分散のための実務的な対策を提供

- データセット管理とエクスポート:構造化データをCSV/JSONなどで取得し、分析基盤へ連携

- API・Webhook・スケジューラ:外部システム統合、イベント駆動、定期実行に対応

- 監視/ログ/再試行:実行状況の可視化とエラーハンドリングで信頼性を確保

- チームコラボレーション:共同編集や権限管理により、組織での運用を効率化

- カスタムソリューション:要件に合わせた拡張や専用開発にも対応

Apify AIの対象ユーザー

データエンジニア、フルスタック開発者、データアナリスト、リサーチャー、グロース/マーケティング担当、競合調査や価格モニタリングを行うオペレーションチームに適しています。プロダクトマネージャーやスタートアップが市場調査やPoCを素早く回す用途にも有効で、社内RPAの代替や補完としてWeb業務の自動化を図りたいケースにも向いています。コードで細かく制御したい開発者から、テンプレートを使って短時間で成果を出したい担当者まで、幅広いスキルレベルで利用できます。

Apify AIの使い方

- アカウントを作成し、ワークスペースやプロジェクトを準備します。

- 目的に合ったアクター/テンプレートをマーケットプレイスから選ぶか、Crawleeで新規に作成します。

- 対象URL、セレクタ、ログイン情報、出力形式などの入力パラメータを設定します。

- 必要に応じてプロキシやアンチブロッキング設定を有効化し、レート制御を調整します。

- テスト実行してログとサンプル出力を確認し、セレクタや待機時間を微調整します。

- スケジューラで定期実行を設定し、キューを使って大規模クロールを段階的に処理します。

- データセットに蓄積された結果をCSV/JSONでダウンロードするか、API/Webhookで外部に配信します。

- 通知、再試行ポリシー、失敗時アラートを設定し、運用時の安定性を高めます。

- チームメンバーと共有し、必要に応じてワークフロー全体をアクターとして公開・再利用します。

Apify AIの業界での活用事例

EC領域では商品価格や在庫のモニタリング、レビュー収集、カタログ作成を自動化。人材・不動産では求人や物件情報の集約と重複排除、通知フローの構築に活用されます。メディア/調査ではニュースサイトや公的データの抽出、トレンド監視、リスクインテリジェンスのデータ基盤として機能。マーケティングでは検索結果やSERPのチェック、競合サイトの更新検知、コンテンツリサーチを効率化します。さらに、生成AIの学習用データ整備や社内ダッシュボードへの継続連携まで、スクレイピングから配信までの一連の処理を自動化できます。

Apify AIの料金プラン

利用用途や規模に応じたプランが案内されています。実行量や機能要件に合わせて選択できるため、評価から本番運用まで段階的に導入しやすい設計です。最新の内容は公式情報をご確認ください。

Apify AIのメリットとデメリット

メリット:

- フルスタックなスクレイピング/自動化環境で開発から運用まで一貫管理

- マーケットプレイスの既製アクターとテンプレートで導入が迅速

- Crawlee対応によりコード拡張が容易で、柔軟なカスタマイズが可能

- プロキシやアンチブロッキングを含む実務的な運用機能が充実

- API/Webhook、スケジューラ、データセット連携でワークフロー自動化が進む

- 監視・ログ・再試行により信頼性と保守性を確保しやすい

デメリット:

- 対象サイトの構造変更に伴うセレクタ調整や保守が不可避

- 動的レンダリングや厳格な対策があるサイトでは安定取得が難しい場合がある

- 高頻度・大規模実行ではコスト最適化やレート設計が必要

- 法的・倫理面の配慮(利用規約・robots.txt・個人情報保護)が常に求められる

- 高度な要件では開発・運用の学習コストが発生

Apify AIに関するよくある質問

-

質問:コードを書かずに使えますか?

はい。用途別のアクターやテンプレートを選び、入力項目を設定するだけで多くのタスクを実行できます。必要に応じてCrawleeを用いたコード拡張も可能です。

-

質問:ブロックされにくくするにはどうすればよいですか?

プロキシの活用、リクエストヘッダやレート制御の調整、待機時間の挿入、セッション管理などのベストプラクティスが有効です。完全な回避は保証されないため、安定運用のための監視と再試行設定が重要です。

-

質問:取得データはどの形式で出力できますか?

構造化データとしてデータセットに保存され、一般的にCSVやJSONなどでダウンロードや外部連携が行えます。APIやWebhookを利用したシステム連携も可能です。

-

質問:法的・倫理面で注意すべき点は?

対象サイトの利用規約やrobots.txtの指針に配慮し、個人情報や機密情報の取り扱いを適切に管理してください。取得目的の正当性とアクセス負荷の最小化も重要です。

-

質問:大規模クロールはスケールできますか?

スケジューラやキューを組み合わせ、並列度やレートを調整することで段階的にスケールできます。監視とアラートを設定して失敗時の再試行を自動化すると安定します。

-

質問:社内ツールやBIと連携できますか?

APIやWebhookでデータをパイプラインに流し込み、ETLやダッシュボードへ接続できます。スケジュール実行と合わせて定期同期の運用がしやすくなります。