- Startseite

- AI APIs

- LlamaIndex

LlamaIndex

Website öffnen-

Tool-Einführung:GenAI für alle: ohne Login suchen, sofort loslegen, Legacy-Zugang.

-

Aufnahmedatum:2025-10-21

-

Soziale Medien & E-Mail:

Tool-Informationen

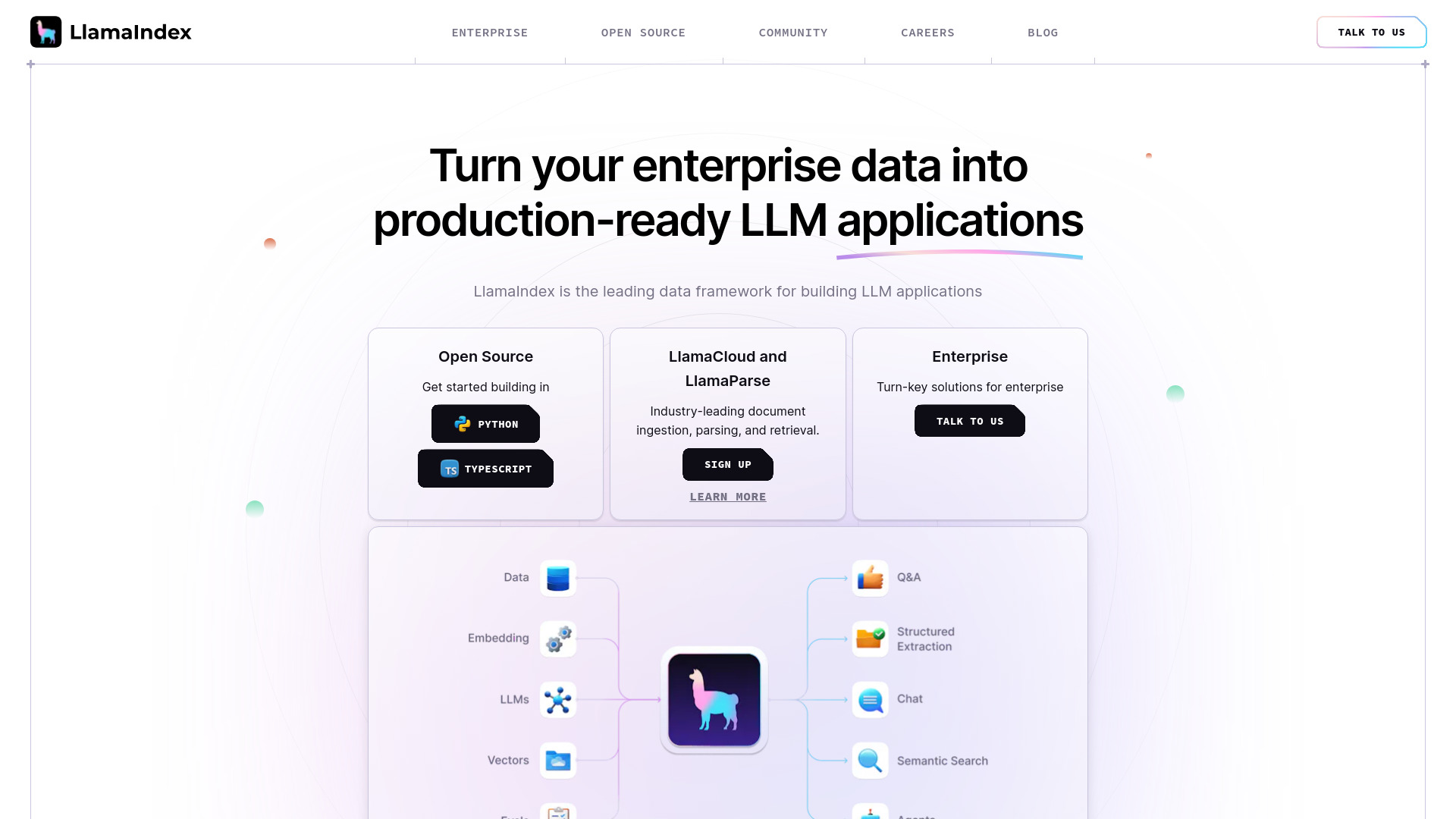

Was ist LlamaIndex

LlamaIndex ist ein flexibles Framework zum Aufbau von Wissensassistenten auf Basis von LLMs, die direkt mit Ihren Enterprise-Daten verbunden sind. Es vereint Dokumenten-Parsing, Datenextraktion, Indexierung und Retrieval, um komplexe Informationsbestände durchsuchbar zu machen. Mit einem modularen Agenten-Framework lassen sich produktionsreife Assistenten entwickeln, die Informationen finden, Erkenntnisse synthetisieren, Berichte generieren und auf Datenebene Aktionen ausführen. LlamaIndex unterstützt RAG-Workflows (Retrieval-Augmented Generation) und integriert sich in gängige Vektorspeicher und Datenquellen.

Hauptfunktionen von LlamaIndex

- Datenanbindung & Ingestion: Verbinden von Dateisystemen, Cloud-Speichern und APIs; strukturiertes Einlesen großer Dokumentenmengen.

- Dokumenten-Parsing & Chunking: Extraktion von Text und Metadaten, sinnvolles Aufteilen in semantische Abschnitte für präzises Retrieval.

- Indexierung & Vektor-Indexe: Aufbau von Indizes für schnelle Suche; Unterstützung von Vektorspeichern für semantische Ähnlichkeitssuche.

- Retrieval & Query Engine (RAG): Kontextbezogene Abfragen, Zusammenführen relevanter Passagen und halluzinationsärmere Antworten.

- Strukturierte Datenextraktion: Extrahieren von Tabellen, Entitäten und Feldern zur weiteren Verarbeitung und Analyse.

- Wissensmanagement: Anreicherung mit Metadaten, optionale Graph-Ansätze für Beziehungen zwischen Inhalten.

- Agenten-Framework: Orchestrierung von Tools und Aktionen, um Workflows zu automatisieren (z. B. Suchen, Zusammenfassen, Berichte erstellen).

- Evaluation & Beobachtbarkeit: Instrumente zum Testen, Messen und Verbessern der Antwortqualität in Produktion.

- Skalierbarkeit: Verarbeitung großer, heterogener Datenbestände für unternehmensweite Wissensanwendungen.

Für wen ist LlamaIndex geeignet

LlamaIndex richtet sich an Data-Science- und ML-Teams, Softwareentwickler, Wissensmanager sowie Fachbereiche, die RAG-gestützte Knowledge Assistants auf ihre Unternehmensdaten aufsetzen möchten. Typische Szenarien sind interne Suchassistenten, Entscheidungsunterstützung, automatisierte Berichtserstellung, Research und das Zusammenführen verteilter Wissensquellen in einem konsistenten Assistenzsystem.

Wie man LlamaIndex verwendet

- Datenquellen festlegen: Relevante Speicherorte und Formate bestimmen (Dokumente, Datenbanken, APIs).

- Ingestion konfigurieren: Dokumente laden, Parsing und Chunking definieren, Metadaten anreichern.

- Index aufbauen: Einen passenden Vektor-Index oder hybriden Index erstellen und persistieren.

- Retriever & Query-Engine einstellen: Retrieval-Strategien, Filter und Prompt-Vorlagen konfigurieren.

- LLM anbinden: Modellzugang (API/Endpoint) wählen und Parameter wie Temperatur oder Kontextlänge festlegen.

- Agenten definieren: Tools und Aktionen registrieren, um mehrstufige Aufgaben automatisiert auszuführen.

- Testen & evaluieren: Antworten prüfen, Metriken erfassen und den Workflow iterativ verbessern.

- Deployment: Den Assistenten in Anwendungen, Chat-UI oder interne Services integrieren.

Branchenspezifische Anwendungsfälle von LlamaIndex

- Finanzwesen: Research-Assistent für Marktanalysen, Verdichten von Reports, Erstellen von Investment-Summaries.

- Recht & Compliance: Durchsuchbare Wissensdatenbank für Richtlinien, Extraktion zentraler Klauseln aus Vertragsbeständen.

- Kundenservice: Wissensassistent für FAQs, Lösungsvorschläge aus Handbüchern und Tickets, Antwortentwürfe für Agenten.

- Industrie & Technik: Technische Dokumentation durchsuchen, Wartungsanweisungen zusammenfassen, Änderungen nachvollziehen.

- Beratung & Vertrieb: Angebots- und Projektdokumente zusammenführen, Executive Summaries und Statusberichte generieren.

Preismodell von LlamaIndex

LlamaIndex ist als Open-Source-Framework verfügbar. Zusätzlich existieren verwaltete Dienste und Funktionen für den Produktiveinsatz (z. B. gehostete Ingestion, Indexierung oder Beobachtbarkeit), die in der Regel über gestaffelte, nutzungsbasierte Pläne angeboten werden. Konkrete Konditionen können je nach Produktumfang variieren und sind auf der offiziellen Anbieterseite einsehbar.

Vorteile und Nachteile von LlamaIndex

Vorteile:

- Umfassendes RAG-Toolkit von Ingestion bis Retrieval für produktionsreife Wissensassistenten.

- Modular und erweiterbar: passt sich an bestehende Datenquellen und Vektorspeicher an.

- Agenten-Framework für mehrschrittige Aufgaben und automatisierte Workflows.

- Verbesserte Antwortqualität durch präzises Dokumenten-Parsing und semantische Suche.

- Geeignet für große, heterogene Enterprise-Daten und komplexe Wissensdomänen.

Nachteile:

- Einrichtungs- und Tuning-Aufwand, insbesondere bei großen Datenlandschaften.

- Abhängigkeit von LLM- und Vektorstore-Kosten im Betrieb.

- Qualität und Aktualität der Antworten hängen stark von Datenbasis und Metadatenpflege ab.

- Erfordert Monitoring und Evaluation, um Drift und Halluzinationen dauerhaft zu minimieren.

Häufige Fragen zu LlamaIndex

-

Was unterscheidet LlamaIndex von reinen LLM-Prompts?

LlamaIndex verbindet LLMs mit Ihren Daten über Indexierung und Retrieval, sodass Antworten auf verifizierbaren Kontext statt nur auf Modellwissen beruhen.

-

Benötige ich zwingend einen Vektorspeicher?

Nicht zwingend. LlamaIndex kann in unterschiedlichen Modi arbeiten, lässt sich aber für semantische Suche optimal mit Vektor-Indizes nutzen.

-

Kann ich damit Agenten und Actions bauen?

Ja. Das Agenten-Framework orchestriert Tools und Schritte, um Informationen zu finden, zu verdichten und anschließend Aktionen auszuführen.

-

Welche Modelle werden unterstützt?

LlamaIndex ist modellagnostisch und kann mit verschiedenen LLMs über übliche API-Schnittstellen betrieben werden.

-

Eignet sich LlamaIndex für sensible Unternehmensdaten?

Es ist dafür ausgelegt, mit Unternehmensdaten zu arbeiten. Die konkrete Datenhandhabung und Sicherheitsmaßnahmen hängen jedoch von Ihrer Infrastruktur und den gewählten Diensten ab.