- Home

- Gerador de Prompt AI

- Msty

Msty

Abrir Site-

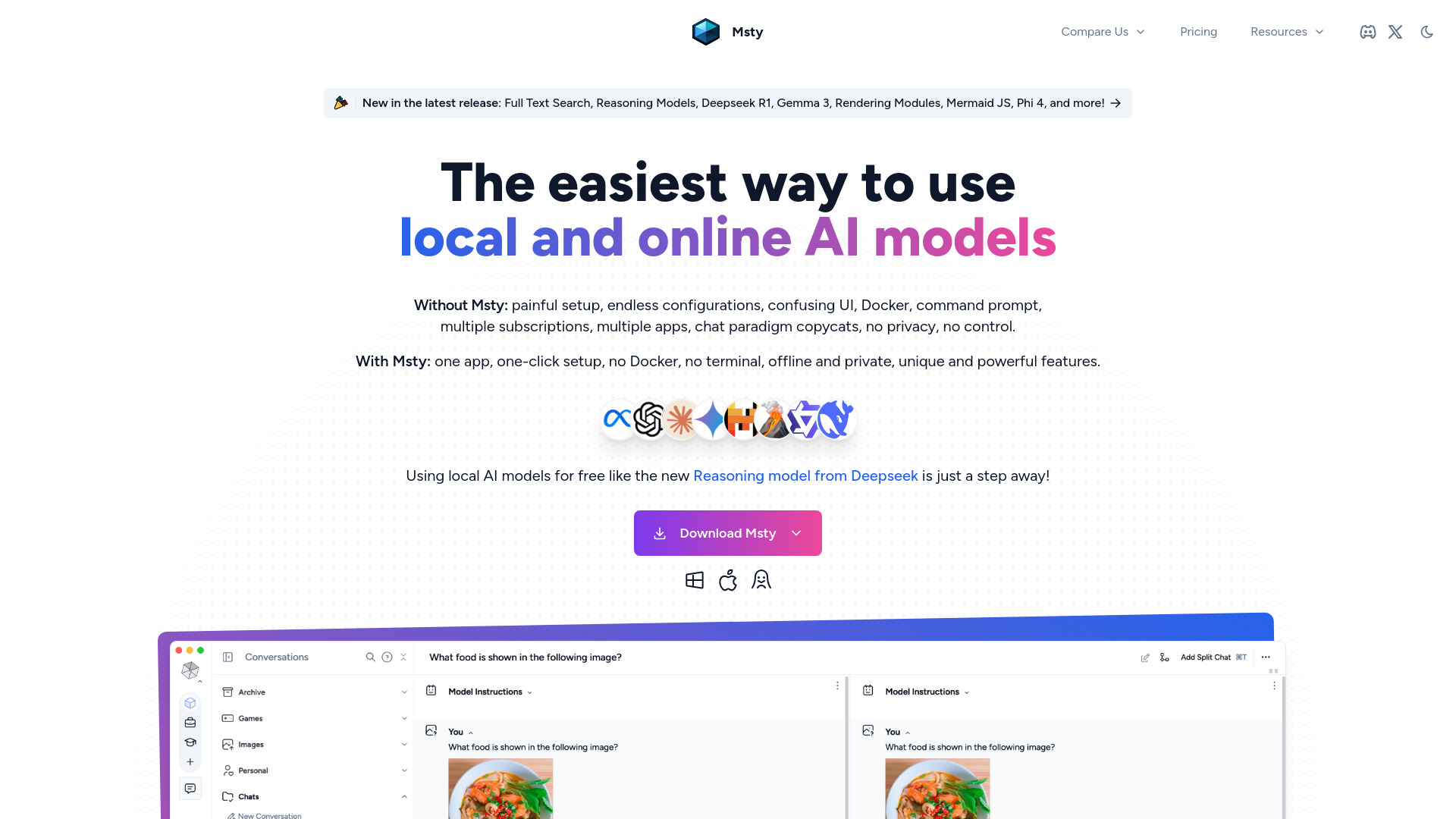

Ferramenta Introdução:App de IA multimodelo, privada e offline; chats ramificados, busca web e RAG

-

Data de Inclusão:2025-11-08

-

Social Media e E-mail:

Informações da ferramenta

O que é Msty AI

Msty AI é um aplicativo de IA criado para simplificar o uso de modelos de linguagem em uma única interface. Ele centraliza o acesso a provedores como OpenAI, DeepSeek e Claude, e integra modelos locais via Ollama e Hugging Face. Com foco em privacidade e operação offline quando desejado, oferece recursos como chats divididos, ramificações, conversas concorrentes, pesquisa na web, RAG e biblioteca de prompts. A proposta é ser uma alternativa prática a Perplexity, Jan AI e LM Studio, reunindo produtividade e controle em um só lugar.

Principais funcionalidades de Msty AI

- Interface unificada multímodulos: gerencie e troque entre modelos de OpenAI, DeepSeek e Claude, além de modelos locais via Ollama e Hugging Face, em um só ambiente.

- Privacidade e modo offline: possibilidade de operar localmente com modelos hospedados no seu dispositivo, reduzindo exposição de dados.

- Split chats: divida conversas para comparar abordagens sem perder o contexto inicial.

- Branching (ramificações): explore diferentes caminhos de resposta a partir de um mesmo ponto de conversa.

- Conversas concorrentes: conduza múltiplos chats ao mesmo tempo para acelerar testes e análises.

- Pesquisa na web: complemente respostas com informações atualizadas quando a conexão estiver habilitada.

- RAG (Retrieval-Augmented Generation): conecte suas próprias fontes para fundamentar respostas com documentos e bases internas.

- Biblioteca de prompts: organize, reutilize e padronize prompts para fluxos de trabalho consistentes.

- Produtividade e controle: combine exploração criativa com gestão de contexto e modelos, reduzindo o atrito no uso diário.

Para quem é Msty AI

Ideal para profissionais e equipes que trabalham com LLMs no dia a dia: criadores de conteúdo, pesquisadores, desenvolvedores, analistas e times de suporte que precisam alternar entre modelos, comparar respostas, executar chats paralelos e integrar dados próprios via RAG. Também atende quem busca uma alternativa ao Perplexity, Jan AI e LM Studio com opção de operação offline e foco em privacidade.

Como usar Msty AI

- Abra o Msty AI no seu dispositivo e acesse a interface principal.

- Conecte provedores em nuvem adicionando, quando necessário, suas chaves de API (por exemplo, OpenAI, DeepSeek, Claude).

- Opcional: habilite modelos locais via Ollama ou importe modelos do Hugging Face para uso offline.

- Crie um novo chat e selecione o modelo desejado.

- Use split chats e branching para comparar diferentes direções de resposta a partir do mesmo prompt.

- Ative a pesquisa na web quando precisar de informações atualizadas.

- Configure RAG conectando suas fontes de conhecimento e ajuste as preferências de contexto.

- Salve prompts frequentes na biblioteca de prompts e gerencie conversas concorrentes conforme o fluxo de trabalho.

Casos de uso de Msty AI no setor

No marketing, centraliza ideação, rascunhos e pesquisa com apoio de pesquisa na web e RAG em materiais internos. Em suporte e sucesso do cliente, acelera respostas a partir de bases de conhecimento privadas. Em engenharia de software, facilita explicações de código e prototipagem de prompts comparando modelos via split chats. Em educação e pesquisa, resume artigos, cria trilhas de estudo e valida fontes combinando modelos em nuvem e locais.

Vantagens e desvantagens de Msty AI

Vantagens:

- Flexibilidade de modelos: suporte a provedores populares e modelos locais em uma só interface.

- Privacidade e offline: possibilidade de operar sem enviar dados para a nuvem quando usar modelos locais.

- Produtividade: split chats, branching e conversas concorrentes agilizam comparações e testes.

- RAG e pesquisa na web: respostas mais contextuais e atualizadas quando habilitado.

- Reuso de prompts: biblioteca integrada para padronizar fluxos.

Desvantagens:

- Configuração inicial: requer conectar chaves de API e/ou modelos locais, o que pode demandar tempo.

- Recursos do dispositivo: uso de modelos locais pode exigir hardware adequado.

- Dependências externas: ao usar modelos em nuvem, a disponibilidade e custos ficam sujeitos a terceiros.

- Curva de aprendizado: explorar split chats, branching e RAG pode exigir familiarização.

Perguntas frequentes sobre Msty AI

O Msty AI funciona offline?

Sim, quando utilizado com modelos locais (por exemplo, via Ollama ou modelos do Hugging Face), é possível operar de forma privada e offline.

Quais modelos o Msty AI suporta?

Ele permite o uso de modelos de provedores como OpenAI, DeepSeek e Claude, além de integrar modelos locais por meio de Ollama e Hugging Face.

O que são split chats e branching?

Split chats permitem dividir uma conversa para testar diferentes abordagens; branching cria ramificações a partir de um ponto específico, facilitando comparações lado a lado.

Posso usar minhas próprias fontes com RAG?

Sim. É possível conectar fontes e documentos para que o modelo recupere informações e gere respostas mais contextualizadas.

Preciso de chaves de API?

Somente ao usar provedores em nuvem. Para uso local com modelos via Ollama/Hugging Face, não é necessário enviar dados a serviços externos.