Zeabur

Site web ouvert-

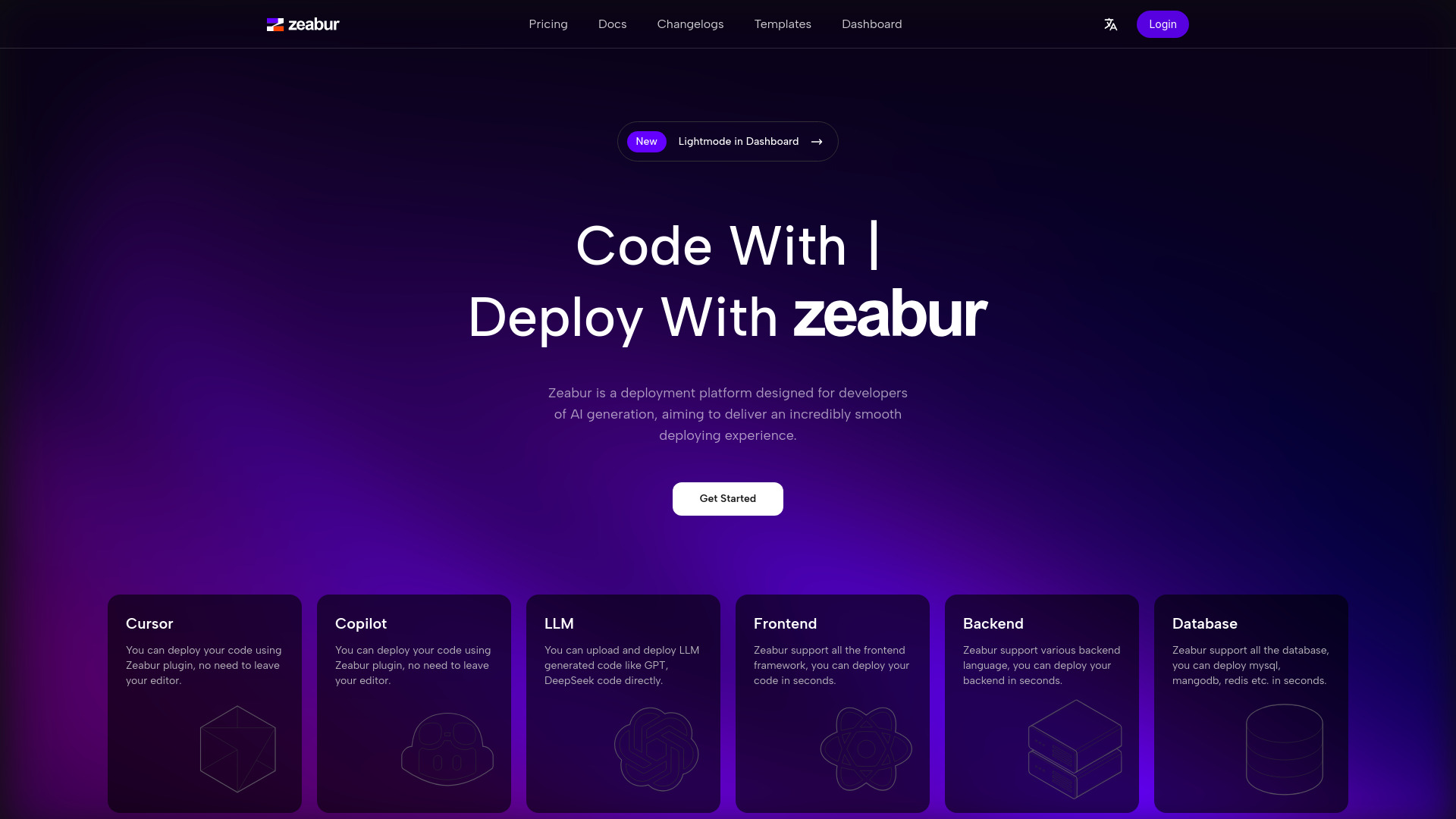

Présentation de l'outil:Zeabur AI déploie des apps IA en secondes: multistack, autoscale, CI/CD

-

Date d'inclusion:2025-10-28

-

Réseaux sociaux et e-mails:

Informations sur l'outil

Qu’est-ce que Zeabur AI

Zeabur AI est une plateforme de déploiement cloud pensée pour l’ère de l’intelligence artificielle. Elle simplifie la mise en production d’applications, d’API et de bases de données en quelques secondes, que le code provienne de votre équipe ou soit généré par un LLM. Compatible avec de nombreux langages backend, frameworks frontend et systèmes de bases de données, elle automatise l’analyse du code, l’agrégation de services et l’orchestration. Avec CI/CD, auto-scaling, gestion des variables, domaines, fichiers et stockage objet, elle réduit la friction DevOps et accélère le passage du code au service.

Fonctionnalités principales de Zeabur AI

- Déploiement ultra-rapide de code, y compris code généré par LLM, frontends, backends et bases de données.

- Large compatibilité avec divers langages backend, frameworks frontend et moteurs de base de données.

- Analyse automatique du code pour détecter le runtime, les dépendances et la configuration requise.

- CI/CD intégré depuis le dépôt jusqu’à la production, avec builds et déploiements automatisés.

- Auto-scaling et ressources élastiques pour absorber les pics de charge sans intervention manuelle.

- Agrégation de services et mise en réseau facilitée entre API, frontends et bases de données.

- Stockage objet et gestion des fichiers pour les actifs applicatifs et contenus statiques.

- Gestion des variables d’environnement et secrets centralisée et sécurisée.

- Gestion de domaines pour lier et administrer vos noms de domaine.

- Marketplace de modèles pour démarrer à partir de templates prêts à l’emploi.

- Clusters partagés, liaison serveur et hébergement VPS pour s’adapter à différents besoins d’isolation et de contrôle.

- Tarification à l’usage avec visibilité sur la consommation et les coûts.

À qui s’adresse Zeabur AI

Zeabur AI s’adresse aux développeurs web et backend, équipes IA/ML, startups et PME qui veulent accélérer la mise en production sans lourde charge DevOps. Il convient également aux agences et freelances gérant plusieurs projets clients, aux indie hackers lançant des MVP, ainsi qu’aux équipes data qui déploient des API d’inférence, services ETL ou dashboards. Les organisations orientées microservices et les équipes produit en itération rapide y trouveront un cadre fiable et flexible.

Comment utiliser Zeabur AI

- Créer un compte et ouvrir un projet ou un espace d’environnement.

- Connecter un dépôt Git ou démarrer depuis un modèle du marketplace.

- Laisser l’analyse de code proposer le runtime, les commandes et la configuration.

- Configurer les variables d’environnement, secrets et liaisons (base de données, stockage objet, autres services).

- Choisir le mode d’hébergement : cluster partagé, VPS ou liaison serveur.

- Définir les domaines et les règles réseau nécessaires à l’exposition des services.

- Lancer le déploiement : la CI/CD construit et publie automatiquement les services.

- Surveiller les métriques et logs, ajuster les ressources et activer l’auto-scaling si besoin.

Cas d’utilisation de Zeabur AI

Déploiement d’API d’inférence et d’applications propulsées par LLM, hébergement d’applications web full‑stack, backends d’app mobiles, sites marketing et frontends modernes, services de traitement de données et ETL, tableaux de bord analytiques, prototypes et MVP lors de hackathons, migration progressive de monolithes vers microservices avec agrégation de services et réseaux internes.

Tarification de Zeabur AI

Zeabur AI propose une tarification à l’usage, avec des coûts liés aux ressources consommées (calcul, stockage, transfert, etc.). Selon les besoins, vous pouvez opter pour des clusters partagés ou des VPS afin d’ajuster l’isolation et le contrôle. Les détails précis des tarifs et options dépendent de la consommation et de la configuration choisies.

Avantages et inconvénients de Zeabur AI

Avantages :

- Mise en production très rapide et réduction des tâches DevOps.

- Compatibilité multi‑langages, multi‑frameworks et multi‑bases.

- Automatisation poussée : analyse de code, CI/CD, auto‑scaling.

- Gestion centralisée des variables, domaines, fichiers et stockage objet.

- Flexibilité d’hébergement : cluster partagé, liaison serveur, VPS.

- Paiement à l’usage pour mieux maîtriser les coûts au démarrage.

Inconvénients :

- Courbe d’apprentissage pour les architectures complexes ou distribuées.

- Coûts variables parfois moins prévisibles lors de fortes charges.

- Dépendance à l’écosystème de la plateforme (risque de verrouillage).

- Certains cas avancés peuvent exiger une configuration fine de l’infrastructure.

Questions fréquentes sur Zeabur AI

Zeabur AI peut‑il déployer du code généré par un LLM ?

Oui, la plateforme permet de déployer du code classique comme du code généré par LLM, pour des frontends, backends et services d’API.

Puis‑je connecter mes propres bases de données ?

Oui, Zeabur AI prend en charge différentes bases de données et facilite la liaison entre services et stockage.

Quelle est la différence entre cluster partagé et VPS ?

Le cluster partagé mutualise les ressources pour un démarrage rapide et économique, tandis que le VPS offre un environnement plus isolé et configurable.

La plateforme gère‑t‑elle l’auto‑scaling ?

Oui, Zeabur AI prend en charge l’auto‑scaling pour adapter automatiquement les ressources à la charge.

Comment fonctionnent les déploiements CI/CD ?

En connectant votre dépôt, la plateforme détecte le projet, construit l’application et déclenche les déploiements à chaque mise à jour.

La gestion de domaines et le stockage objet sont‑ils inclus ?

Oui, la gestion des domaines et le stockage objet font partie des fonctionnalités proposées pour faciliter l’hébergement complet des services.