- Startseite

- AI APIs

- AI/ML API

AI/ML API

Website öffnen-

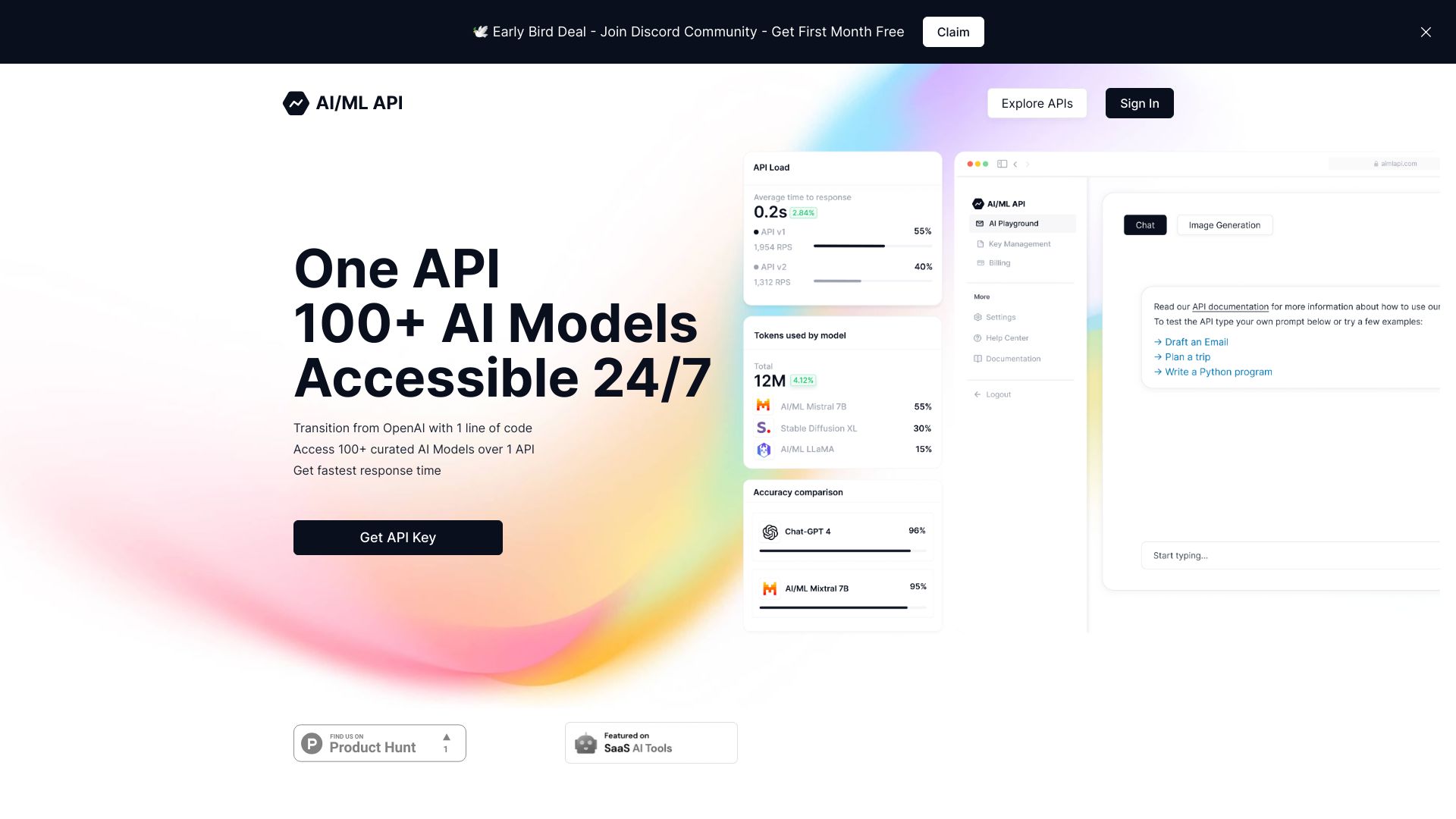

Tool-Einführung:Eine API für 100+ Modelle: GPT-4-Niveau 80% günstiger, OpenAI-kompatibel.

-

Aufnahmedatum:2025-10-21

-

Soziale Medien & E-Mail:

Tool-Informationen

Was ist AI/ML API

AI/ML API ist eine OpenAI-kompatible KI-API, die Entwicklerinnen und Entwicklern über eine einzige Schnittstelle Zugriff auf mehr als 100 Modelle bietet. Sie vereint führende LLMs hinter einem einheitlichen Endpoint, vereinfacht Integration und Migration und beschleunigt so Prototyping wie auch den stabilen Produktiveinsatz. Mit GPT‑4‑Niveau bei bis zu 80 % geringeren Kosten optimiert die Plattform Budget und Leistung. Die AI/ML API Tokens ermöglichen eine präzise Ressourcenallokation, sodass Workloads flexibel skaliert und Kosten transparent gesteuert werden können – für kontinuierliche Innovation rund um die Uhr.

Hauptfunktionen von AI/ML API

- Einheitliche Schnittstelle: Zugriff auf 100+ KI-Modelle über eine einzige API, ohne mehrere Integrationen verwalten zu müssen.

- OpenAI-Kompatibilität: Nahtloser Umstieg dank kompatibler Endpunkte und Parameter – bestehender Code lässt sich mit minimalen Anpassungen übernehmen.

- Leistung zum Sparpreis: GPT‑4‑Level bei bis zu 80 % geringeren Kosten für eine bessere Kosten‑Performance.

- Token-basierte Steuerung: AI/ML API Tokens erlauben die präzise Zuteilung von Ressourcen und die Optimierung von Durchsatz und Kosten.

- Schnelle Integration: Reduzierte Time-to-Value durch einheitliche Authentifizierung, konsistente Requests und klare Response-Strukturen.

- Flexible Skalierung: Workloads lassen sich bedarfsgerecht hoch- oder herunterskalieren, ohne Anbieterbindung.

Für wen ist AI/ML API geeignet

AI/ML API ist ideal für Entwickler, Produktteams und Start-ups, die KI-Funktionen schnell integrieren möchten, ebenso für Unternehmen und Data-Science-Teams, die mehrere Modelle testen, vergleichen und kosteneffizient in Produktion bringen wollen. Geeignet für Migrationen von bestehenden OpenAI-Integrationen, Proof-of-Concepts mit kurzer Time-to-Market und skalierbare Anwendungen mit klarer Kostenkontrolle.

Wie man AI/ML API verwendet

- API-Zugang einrichten: Konto erstellen und API-Schlüssel generieren.

- Modell auswählen: Ein passendes Modell aus dem verfügbaren Katalog bestimmen oder bestehende Modellaufrufe übernehmen.

- Anfrage konfigurieren: Prompt/Parameter definieren und OpenAI-kompatible Endpunkte verwenden.

- Request senden: API-Call aus Ihrer Anwendung absetzen und die Antwort verarbeiten.

- Ressourcen steuern: Mit AI/ML API Tokens Ressourcen präzise zuordnen und den Verbrauch optimieren.

Branchenspezifische Anwendungsfälle von AI/ML API

Im E‑Commerce für Chatbots, semantische Suche und personalisierte Empfehlungen; im Kundensupport für Antwortvorschläge und Automatisierung; in SaaS-Produkten für Textgenerierung, Zusammenfassungen und Klassifikation; im Marketing für Content-Erstellung und A/B-Varianten; in der Bildung für Tutor-Systeme und Wissensassistenten; im Enterprise-Umfeld zur schnellen Prototypisierung und kosteneffizienten Skalierung von LLM-basierten Workflows.

Preismodell von AI/ML API

AI/ML API setzt auf ein token-basiertes Modell: AI/ML API Tokens ermöglichen die präzise Zuteilung von Rechenressourcen und eine feingranulare Kostenkontrolle. Laut Anbieter bietet die Plattform GPT‑4‑Niveau bei bis zu 80 % niedrigeren Kosten. Informationen zu kostenlosen Plänen oder Testphasen sind nicht angegeben.

Vorteile und Nachteile von AI/ML API

Vorteile:

- Ein einziger API‑Zugriff auf 100+ Modelle statt vieler Einzelintegrationen.

- OpenAI-kompatibel: unkomplizierte Migration und geringer Umstellungsaufwand.

- Hohe Kosteneffizienz mit GPT‑4‑Level bei bis zu 80 % geringeren Kosten.

- Token-basierte Ressourcenallokation für planbare Budgets und Performance.

- Beschleunigte Entwicklung durch konsistente Endpunkte und vereinfachte Wartung.

Nachteile:

- Abhängigkeit von einem Plattformanbieter für Zugang und Routing zu Modellen.

- Modellverhalten kann je nach Auswahl variieren; zusätzlicher Evaluationsaufwand.

- Begrenzte Transparenz über Trainingsdaten einzelner Modelle je nach Anbieter.

- Mögliche Latenzunterschiede je nach Last und Modellbereitstellung.

Häufige Fragen zu AI/ML API

-

Ist AI/ML API mit bestehenden OpenAI-Integrationen kompatibel?

Ja. Die API ist OpenAI-kompatibel, sodass bestehender Code mit minimalen Anpassungen weiterverwendet werden kann.

-

Wie helfen AI/ML API Tokens bei der Kostensteuerung?

Tokens ermöglichen die gezielte Zuteilung von Rechenressourcen pro Use Case oder Team, wodurch Leistung und Kosten präzise gesteuert werden können.

-

Wie viele Modelle sind verfügbar?

Über eine einzige API erhalten Sie Zugriff auf mehr als 100 KI-Modelle, ohne separate Integrationen pflegen zu müssen.

-

Gibt es eine kostenlose Version oder Testphase?

Dazu liegen keine bestätigten Informationen vor. Für Details zum Einstieg und möglichen Testkonditionen sollten Sie den Anbieter direkt kontaktieren.