AI/ML API

Abrir sitio web-

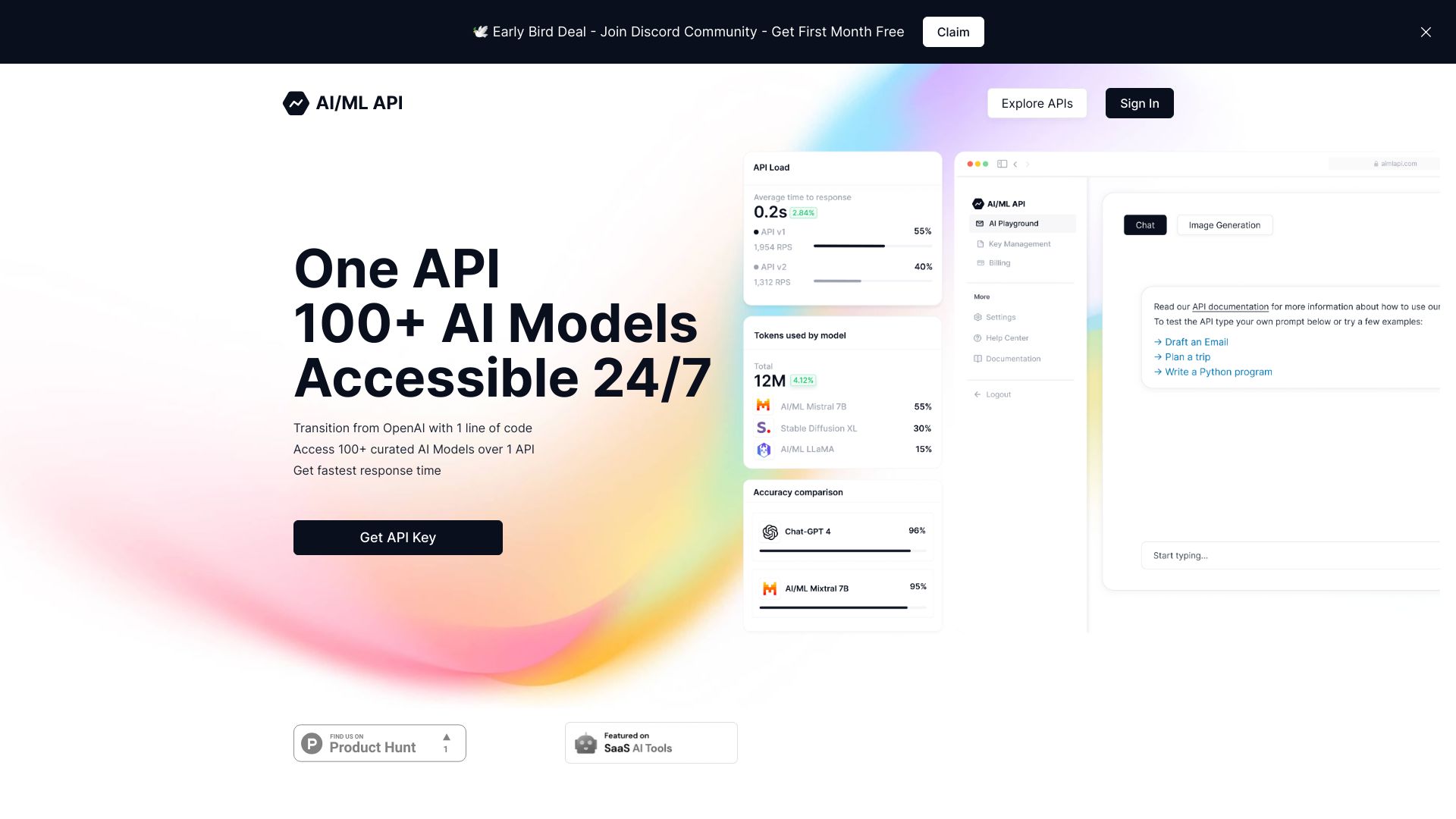

Introducción de la herramienta:Una sola API para 100+ modelos; rendimiento tipo GPT-4 80% más barato.

-

Fecha de inclusión:2025-10-21

-

Redes sociales y correo electrónico:

Información de la herramienta

¿Qué es AI/ML API?

AI/ML API es una plataforma para desarrolladores que centraliza el acceso a más de 100 modelos de inteligencia artificial a través de una sola API. Con compatibilidad con OpenAI, permite transiciones sencillas y acelera la integración en productos existentes. Ofrece rendimiento de nivel GPT‑4 con costes hasta un 80% inferiores, haciendo viable escalar chatbots, generación de texto, visión y embeddings de forma eficiente. Sus Tokens permiten asignar recursos con precisión para equilibrar rendimiento y gasto, impulsando la innovación de manera continua 24/7.

Principales características de AI/ML API

- Una sola API, más de 100 modelos: acceso unificado a múltiples proveedores y arquitecturas de IA sin cambiar de SDK.

- Compatibilidad con OpenAI: endpoints y formatos de petición familiares que simplifican la migración y reducen el retrabajo.

- Rendimiento tipo GPT‑4 con menor coste: inferencia avanzada con ahorros de hasta el 80% en comparación con alternativas equivalentes.

- Tokens para asignación precisa: control granular de recursos para optimizar coste, latencia y calidad según cada caso de uso.

- Disponibilidad 24/7: infraestructura preparada para cargas continuas y picos de demanda.

- Soporte multicapacidad: chat, generación de texto, embeddings, clasificación, moderación y visión.

- Escalabilidad y eficiencia: integración rápida en pipelines y productos con menor complejidad operativa.

- Transición ágil: cambia de modelo manteniendo la misma interfaz para experimentar y mejorar resultados.

¿Para quién es AI/ML API?

Ideal para desarrolladores backend, data scientists y equipos de producto que requieren integrar modelos de IA de forma ágil y rentable. Es especialmente útil para startups que buscan escalar sin costos excesivos, empresas que desean migrar desde OpenAI manteniendo compatibilidad, plataformas SaaS que necesitan multimodel en producción y organizaciones que optimizan embeddings, chatbots o análisis de contenido con control fino del gasto.

Cómo usar AI/ML API

- Regístrate y genera tu clave de API para autenticar solicitudes.

- Elige el modelo adecuado (chat, texto, visión, embeddings) según tu tarea.

- Configura las peticiones siguiendo el formato compatible con OpenAI (prompt, temperatura, top‑p, etc.).

- Asigna AI/ML API Tokens para definir límites y prioridades de recursos por proyecto.

- Envía solicitudes desde tu servidor o app y evalúa latencia, coste y calidad de las respuestas.

- Itera cambiando de modelo sin modificar la integración para optimizar rendimiento y gasto.

- Monitorea el consumo de tokens y ajusta la asignación según la demanda.

Casos de uso de AI/ML API en la industria

En comercio electrónico, impulsa asistentes de compra y búsqueda semántica con embeddings. En atención al cliente, habilita chatbots y resúmenes automáticos de tickets con costes controlados. En medios y marketing, genera copys, guiones y clasificación de contenido. En fintech, ayuda con análisis de texto y detección de señales en comunicaciones. En educación, personaliza tutorías y crea evaluaciones automatizadas. En operaciones, soporta extracción de información y visión para revisión de documentos e imágenes.

Modelo de precios de AI/ML API

AI/ML API utiliza un esquema basado en Tokens que permite asignar recursos con precisión por proyecto o caso de uso. Este enfoque favorece el pago por uso y la optimización del presupuesto, ofreciendo rendimiento de nivel GPT‑4 con hasta un 80% de reducción de costes frente a alternativas comparables. La facturación se ajusta al consumo efectivo y a la configuración de recursos que establezcas mediante tokens.

Ventajas y desventajas de AI/ML API

Ventajas:

- Acceso unificado a más de 100 modelos desde una sola API.

- Compatibilidad con OpenAI para migraciones rápidas y sin fricción.

- Rendimiento tipo GPT‑4 con ahorro de costes significativo.

- Tokens que brindan control granular de recursos y gasto.

- Disponibilidad 24/7 y escalabilidad para producción.

- Facilidad para experimentar y alternar modelos sin reescribir código.

Desventajas:

- Dependencia de terceros modelos puede implicar variabilidad en latencia o calidad.

- Requiere ajustar prompts y parámetros por modelo para resultados óptimos.

- Gestión de tokens y presupuestos añade una capa de configuración adicional.

Preguntas frecuentes sobre AI/ML API

-

¿Puedo migrar desde OpenAI sin reescribir mi integración?

Sí. La compatibilidad con OpenAI permite reutilizar estructuras de petición y respuestas, reduciendo cambios en el código existente.

-

¿Cómo ayudan los Tokens a controlar el coste?

Los AI/ML API Tokens permiten asignar recursos por proyecto o flujo, limitando consumo y priorizando tareas críticas para equilibrar coste y rendimiento.

-

¿Qué tipos de modelos están disponibles?

La API ofrece acceso a más de 100 modelos para chat, generación de texto, visión y embeddings, entre otras capacidades comunes en IA.

-

¿Está pensada para uso en producción 24/7?

Sí. La plataforma está orientada a cargas continuas, con flexibilidad para escalar y alternar modelos según la demanda.

-

¿Puedo cambiar de modelo sin modificar mi código?

En la mayoría de los casos basta con actualizar el identificador del modelo y los parámetros, manteniendo la misma interfaz de la API.